library("tidymodels") # Train- und Test-Sample aufteilen

library("tidyverse") # data wrangling

library("conflicted") # Name clashes finden

library("easystats") # stats made easyflights-delay

1 Hintergrund und Forschungsfrage

Wir untersuchen die Forschungsfrage Was sind Prädiktoren von Flugverspätungen. Dazu nutzen wir lineare Modelle als Modellierungsmethoden.

Dieser Post knüpft an den Post zur explorativen Datenanalyse der Flugverspätungen an (es gibt auch hier, Teil 1 und hier, Teil 2 ein Video zu diesem EDA-Post).

2 Setup

2.1 Pakete laden

Wirklich wichtig sind nur tidymodels und tidyverse. Die restlichen Pakete werden nur am Rande benötigt. Man sollte auch nur die Pakete laden, die man für die Analyse benötigt.

2.2 Daten laden: Flights 2023

Aus Gründen der Datenökonomie nutzen wir eine kleinere Version des Datensatz flights. Wir nutzen nicht mehr die Daten aus dem 2013, sondern die neueren Daten aus dem Jahr 2023.

library(nycflights23)

data(flights)

set.seed(42) # Reproduzierbarkeit

flights <-

flights |>

sample_n(size = 3e4)Achtung: flights ist recht groß; die Regressionsmodelle können leicht ein paar Hundert Megabyte groß werden. Das bringt u.U. auch einen modernen Computer irgendwann ins Straucheln.

3 flights2: Nicht benötigte Variablen entfernen und ID hinzufügen

flights2 <-

flights %>%

select(-c(year, arr_delay)) %>%

drop_na(dep_delay) %>%

mutate(id = row_number()) %>%

select(id, everything()) # id nach vorne ziehen4 Aufteilung in Train- und Testsample

Der Hintergrund zur Idee der Aufteilung in Train- und Test-Stichprobe kann z.b. hier oder hier, Kapitel 15, nachgelesen werden.

flights_split <- initial_split(flights2,

strata = dep_delay)5 flights_train2, flights_test2

set.seed(42) # Reproduzierbarkeit

flights_train2 <- training(flights_split)

flights_test2 <- testing(flights_split)Die “wirkliche Welt” (was immer das ist) besorgt die Aufteilung von Train- und Test-Sampel für Sie automatisch. Sagen wir, Sie arbeiten für die Flughafen-Aufsicht von New York. Dann haben Sie einen Erfahrungsschatz an Flügen aus der Vergangenheit in Ihrer Datenbank (Train-Sample). Einige Tages kommt Ihr Chef zu Ihnen und sagt: “Rechnen Sie mir mal die zu erwartende Verspätung der Flüge im nächsten Monat aus!”. Da heute nicht klar ist, wie die Verspätung der Flüge in der Zukunft (nächsten Monat) sein wird, stellen die Flüge des nächsten Monats das Test-Sample dar.

Übrigens: In der Prüfung besorgt das Aufteilen von Train- und Test-Sample netterweise Ihr Dozent…

6 lm0: Nullmodell

Eigentlich nicht nötig, das Nullmodell, primär aus didaktischen Gründen berechnet, um zu zeigen, dass in diesem Fall \(R^2\) wirklich gleich Null ist.

lm0 <- lm(dep_delay ~ 1, data = flights_train2)

model_parameters(lm0) # model_parameters zeit die (geschätzten) Regressionsgewichte (Betas)| Parameter | Coefficient | SE | CI | CI_low | CI_high | t | df_error | p |

|---|---|---|---|---|---|---|---|---|

| (Intercept) | 13.89315 | 0.3737019 | 0.95 | 13.16067 | 14.62563 | 37.17709 | 21918 | 0 |

Wir könnten anstatt model_parameters auch parameters nutzen; das ist der gleiche Befehl.

Allerdings gibt es den Befehl parameters in zwei Paketen, es käme also zu einem “Name Clash”. Das umgehen wir, indem wir model_parameter nutzen, und nicht parameters.

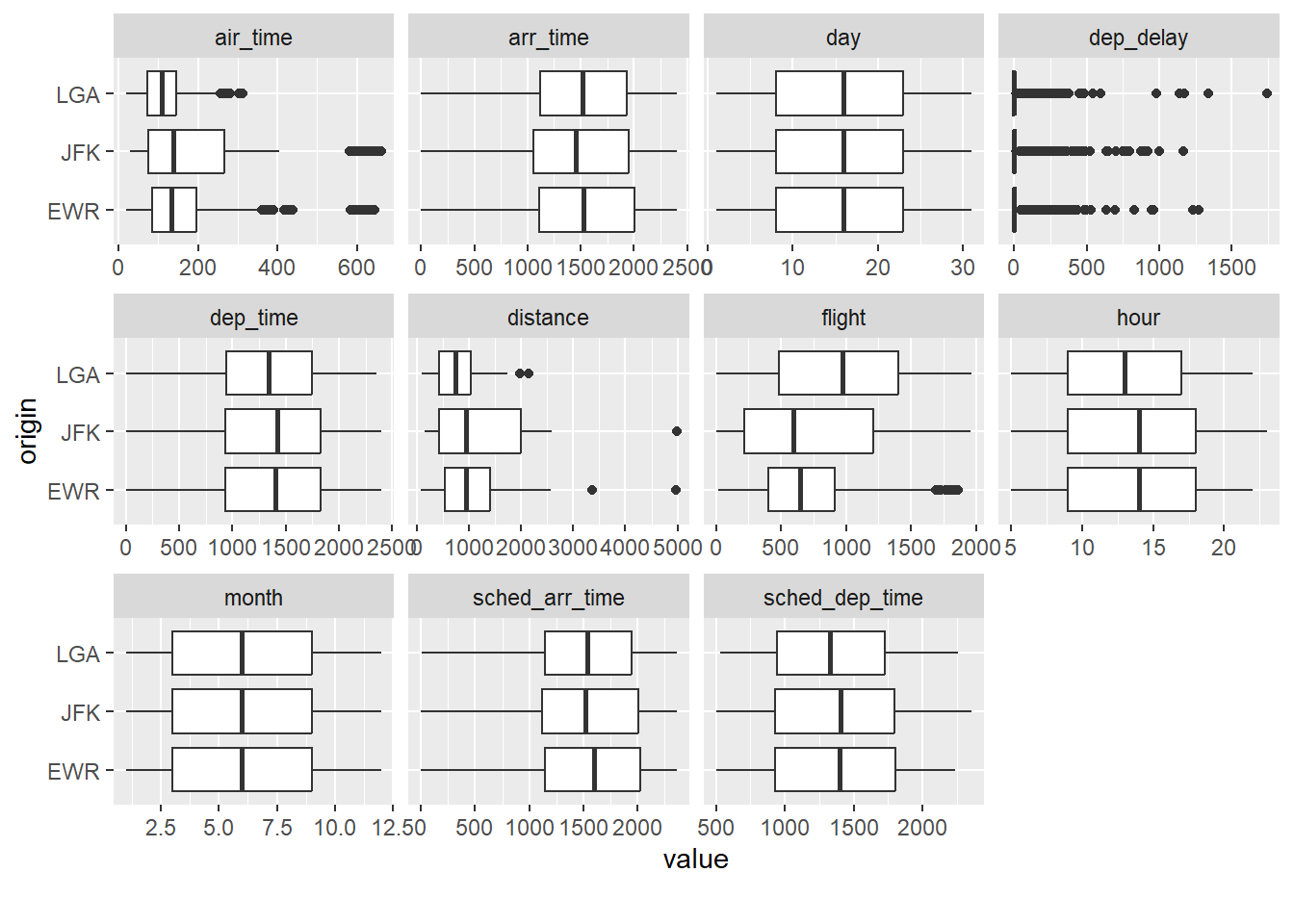

7 lm1: origin

lm1 <- lm(dep_delay ~ origin, data = flights_train2)

model_parameters(lm1) | Parameter | Coefficient | SE | CI | CI_low | CI_high | t | df_error | p |

|---|---|---|---|---|---|---|---|---|

| (Intercept) | 15.106693 | 0.6574882 | 0.95 | 13.8179688 | 16.395417 | 22.976372 | 21916 | 0.0000000 |

| originJFK | 1.370627 | 0.9408249 | 0.95 | -0.4734579 | 3.214711 | 1.456835 | 21916 | 0.1451762 |

| originLGA | -4.422138 | 0.8995398 | 0.95 | -6.1853014 | -2.658975 | -4.916001 | 21916 | 0.0000009 |

Man vergleiche:

flights_train2 %>%

drop_na(dep_delay) %>%

group_by(origin) %>%

summarise(delay_avg = mean(dep_delay)) %>%

mutate(delay_delta = delay_avg - delay_avg[1])| origin | delay_avg | delay_delta |

|---|---|---|

| EWR | 15.10669 | 0.000000 |

| JFK | 16.47732 | 1.370627 |

| LGA | 10.68455 | -4.422138 |

Der Mittelwertsvergleich und das Modell lm1 sind faktisch informationsgleich.

Aber leider ist es um die Modellgüte nicht so gut bestellt (eigentlich eher “grottenschlecht”):

r2(lm1)# R2 for Linear Regression

R2: 0.002

adj. R2: 0.002lm1 ist so schlecht, wir löschen es gleich wieder…

rm(lm1)8 lm2: All in

# NICHT AUSFÜHREN

#lm2_all_in <- lm(dep_delay ~ ., data = flights_train2)Modell lm2_all_in ist hier keine gute Idee, da nominale Prädiktoren in Indikatorvariablen umgewandelt werden. Hat ein nominaler Prädiktor sehr viele Stufen (wie hier), so resultieren sehr viele Indikatorvariablen, was dem Regressionsmodell Probleme bereiten kann (bei mir hängt sich R auf). Besser ist es in dem Fall, die Anzahl der Stufen von nominalskalierten Variablen vorab zu begrenzen.

Bei kleineren Datensätzen (weniger Variablen, weniger Fälle) lohnt es sich aber oft, das “All-in-Modell” auszuprobieren, als Referenzmaßstab für andere Modelle.

9 flights_train3: Textvariablen in Faktorvariablen umwandeln

Begrenzen wir zunächst die Anzahl der Stufen der nominal skalierten Variablen:

flights_train3 <-

flights_train2 %>%

mutate(across(

.cols = where(is.character),

.fns = as.factor))Wem das across zu kompliziert ist, der kann auch alternativ (synonym) jede Variable einzeln in einen Faktor umwandeln und zwar so:

flights_train3a <-

flights_train2 %>%

mutate(tailnum = as.factor(tailnum),

origin = as.factor(origin),

dest = as.factor(dest),

carrier = as.factor(carrier)

)Das ist einfacher als mit across, aber dafür mehr Tipperei.

Wir müssen die Transformationen, die wir auf das Train-Sample anwenden, auch auf das Test-Sample anwenden:

10 flights_test3

flights_test3 <-

flights_test2 %>%

mutate(across(

.cols = where(is.character),

.fns = as.factor))flights_train3 %>%

select(where(is.factor)) %>%

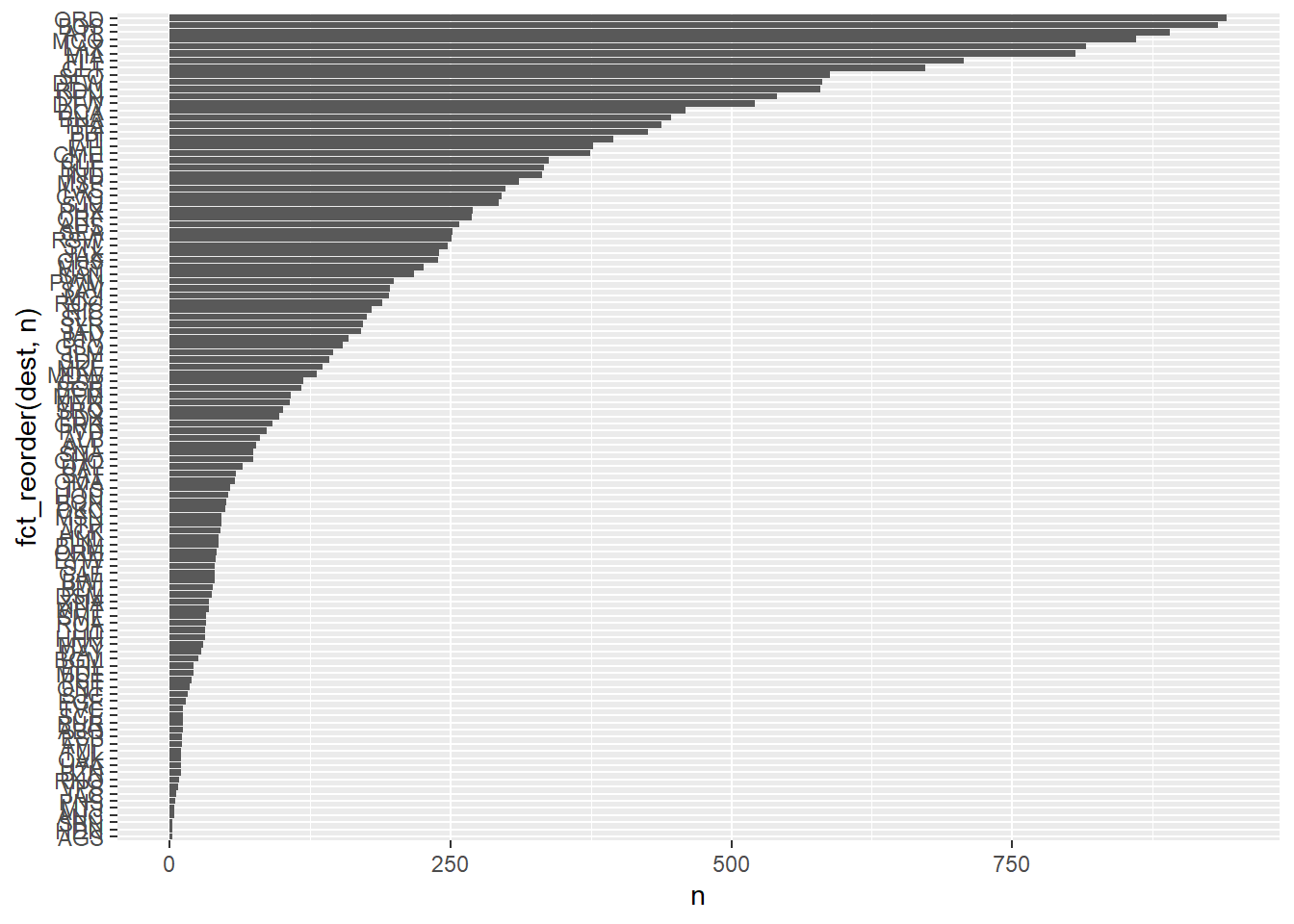

names()[1] "carrier" "tailnum" "origin" "dest" Z.B. dest hat viele Stufen:

flights_train3 %>%

count(dest, sort = TRUE)| dest | n |

|---|---|

| ORD | 941 |

| BOS | 933 |

| ATL | 890 |

| MCO | 860 |

| LAX | 816 |

| MIA | 806 |

| FLL | 707 |

| CLT | 673 |

| SFO | 588 |

| DFW | 581 |

| RDU | 579 |

| DEN | 541 |

| DTW | 521 |

| DCA | 459 |

| BNA | 446 |

| TPA | 438 |

| PBI | 426 |

| PIT | 395 |

| IAH | 377 |

| CMH | 374 |

| CLE | 337 |

| BUF | 333 |

| IND | 331 |

| MSP | 311 |

| LAS | 299 |

| CVG | 295 |

| SJU | 293 |

| PHX | 270 |

| ORF | 269 |

| AUS | 258 |

| SEA | 252 |

| RSW | 251 |

| STL | 247 |

| JAX | 240 |

| CHS | 239 |

| MSY | 226 |

| SAN | 217 |

| PWM | 199 |

| SAV | 196 |

| MCI | 195 |

| ROC | 189 |

| RIC | 180 |

| SLC | 175 |

| SYR | 172 |

| IAD | 170 |

| BTV | 159 |

| GSO | 154 |

| ILM | 145 |

| SDF | 142 |

| MKE | 136 |

| MDW | 131 |

| GSP | 119 |

| BGR | 117 |

| MEM | 108 |

| MYR | 107 |

| SRQ | 101 |

| PDX | 97 |

| GRR | 91 |

| PVD | 86 |

| ALB | 80 |

| AVL | 77 |

| CHO | 74 |

| SNA | 74 |

| DAL | 65 |

| SAT | 59 |

| OMA | 58 |

| TYS | 54 |

| HOU | 52 |

| BQN | 50 |

| OKC | 49 |

| ITH | 46 |

| MSN | 46 |

| ACK | 45 |

| BHM | 43 |

| HNL | 43 |

| ORH | 42 |

| EYW | 41 |

| BWI | 40 |

| CAE | 40 |

| STT | 40 |

| BDL | 38 |

| DSM | 37 |

| MHT | 35 |

| XNA | 35 |

| ROA | 32 |

| SMF | 32 |

| HHH | 31 |

| LIT | 31 |

| MVY | 30 |

| DAY | 28 |

| BGM | 25 |

| MDT | 21 |

| PHL | 21 |

| PSE | 19 |

| ONT | 18 |

| SJC | 16 |

| EGE | 14 |

| ABQ | 12 |

| BUR | 12 |

| SCE | 12 |

| TVC | 12 |

| AVP | 11 |

| PSP | 11 |

| BZN | 10 |

| HYA | 10 |

| OAK | 10 |

| TUL | 10 |

| RNO | 8 |

| VPS | 7 |

| JAC | 6 |

| PNS | 5 |

| ANC | 4 |

| MTJ | 4 |

| AGS | 2 |

| HDN | 2 |

| SBN | 2 |

flights_train3 %>%

count(dest) %>%

ggplot() +

aes(y = fct_reorder(dest, n), x = n) +

geom_col()

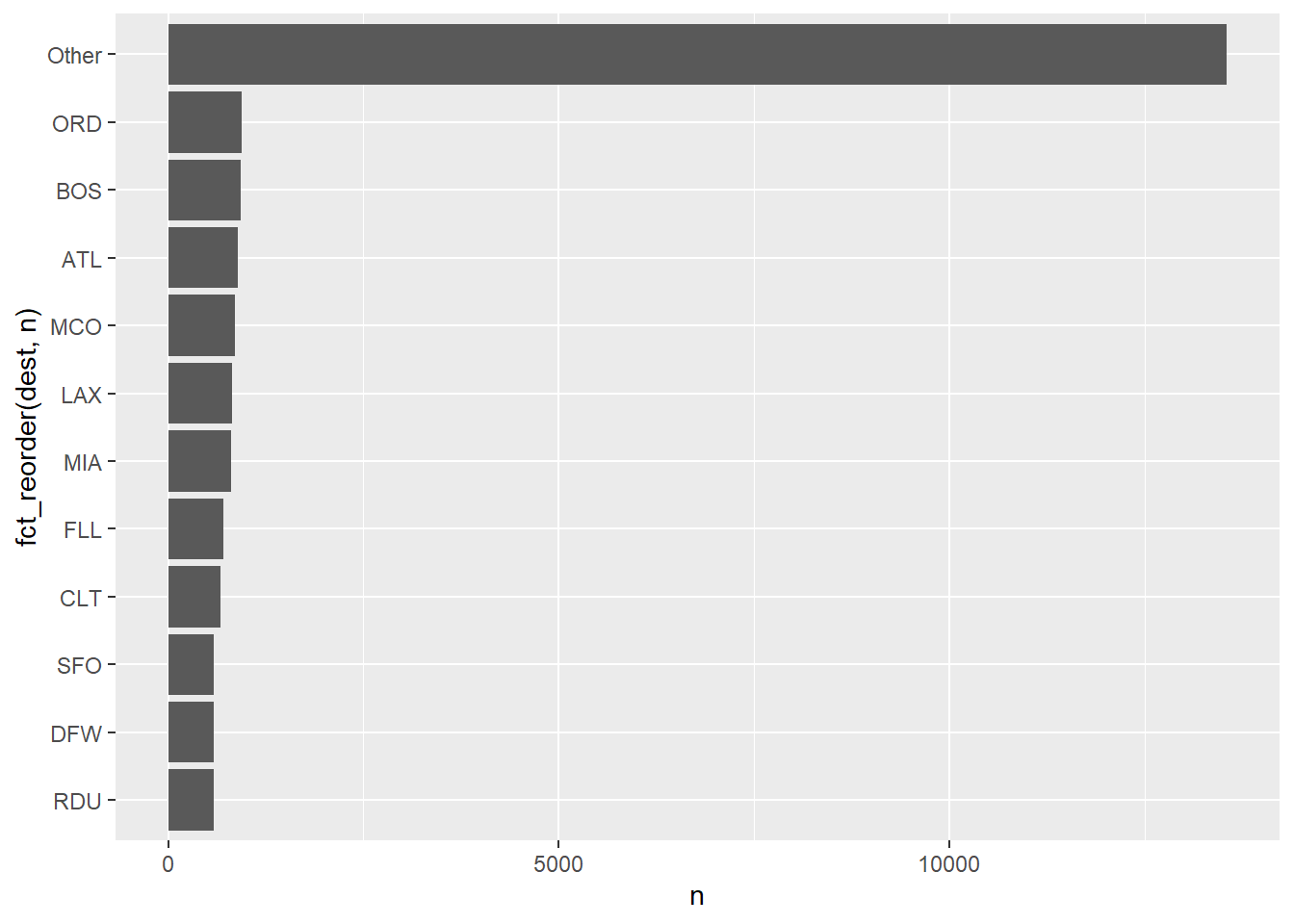

11 flights_train4: Faktorstufen zusammenfassen

flights_train4 <-

flights_train3 %>%

mutate(across(

.cols = where(is.factor),

.fns = fct_lump_prop, prop = .025

))12 Variante mit fact_lump_n

Sinngemäß bedeutet das:

“Fasse die Faktorstufen von dest zu 8 Gruppen plus einer ‘Lumpensammler-Kategorie’ zusammen.”

flights_train3 %>%

mutate(dest_lump9 = fct_lump_n(dest, n = 8)

)| id | month | day | dep_time | sched_dep_time | dep_delay | arr_time | sched_arr_time | carrier | flight | tailnum | origin | dest | air_time | distance | hour | minute | time_hour | dest_lump9 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 11 | 2 | 22 | 622 | 630 | -8 | 1034 | 1020 | AA | 32 | N115NN | JFK | SFO | 404 | 2586 | 6 | 30 | 2023-02-22 06:00:00 | Other |

| 26 | 9 | 27 | 1137 | 1147 | -10 | 1255 | 1317 | YX | 1066 | N726YX | EWR | PIT | 56 | 319 | 11 | 47 | 2023-09-27 11:00:00 | Other |

| 28 | 10 | 8 | 1751 | 1759 | -8 | 2106 | 2110 | B6 | 944 | N935JB | JFK | LAX | 316 | 2475 | 17 | 59 | 2023-10-08 17:00:00 | LAX |

| 37 | 3 | 30 | 807 | 815 | -8 | 917 | 930 | B6 | 112 | N198JB | LGA | BOS | 43 | 184 | 8 | 15 | 2023-03-30 08:00:00 | BOS |

| 39 | 6 | 14 | 1019 | 1025 | -6 | 1127 | 1151 | 9E | 1757 | N695CA | JFK | ROC | 47 | 264 | 10 | 25 | 2023-06-14 10:00:00 | Other |

| 47 | 9 | 26 | 1045 | 1051 | -6 | 1345 | 1357 | DL | 373 | N318DU | LGA | TPA | 149 | 1010 | 10 | 51 | 2023-09-26 10:00:00 | Other |

| 52 | 5 | 9 | 749 | 759 | -10 | 1009 | 1014 | YX | 1358 | N122HQ | LGA | CVG | 105 | 585 | 7 | 59 | 2023-05-09 07:00:00 | Other |

| 55 | 2 | 10 | 914 | 920 | -6 | 1044 | 1115 | 9E | 1289 | N480PX | LGA | PIT | 63 | 335 | 9 | 20 | 2023-02-10 09:00:00 | Other |

| 59 | 12 | 30 | 1402 | 1411 | -9 | 1715 | 1724 | UA | 473 | N65832 | EWR | FLL | 158 | 1065 | 14 | 11 | 2023-12-30 14:00:00 | FLL |

| 61 | 11 | 10 | 1434 | 1440 | -6 | 1623 | 1641 | YX | 1292 | N419YX | LGA | ILM | 85 | 500 | 14 | 40 | 2023-11-10 14:00:00 | Other |

| 62 | 2 | 15 | 951 | 959 | -8 | 1156 | 1238 | B6 | 848 | N184JB | LGA | CHS | 99 | 641 | 9 | 59 | 2023-02-15 09:00:00 | Other |

| 66 | 2 | 13 | 819 | 830 | -11 | 933 | 1020 | B6 | 399 | N354JB | JFK | BNA | 111 | 765 | 8 | 30 | 2023-02-13 08:00:00 | Other |

| 69 | 10 | 9 | 740 | 750 | -10 | 845 | 927 | 9E | 1484 | N604LR | LGA | ROC | 45 | 254 | 7 | 50 | 2023-10-09 07:00:00 | Other |

| 72 | 10 | 8 | 1452 | 1500 | -8 | 1610 | 1634 | 9E | 1544 | N309PQ | LGA | CHO | 52 | 305 | 15 | 0 | 2023-10-08 15:00:00 | Other |

| 79 | 7 | 23 | 1622 | 1629 | -7 | 1822 | 1908 | 9E | 1104 | N337PQ | JFK | CLT | 89 | 541 | 16 | 29 | 2023-07-23 16:00:00 | CLT |

| 92 | 9 | 26 | 938 | 948 | -10 | 1117 | 1124 | UA | 441 | N76532 | EWR | BNA | 106 | 748 | 9 | 48 | 2023-09-26 09:00:00 | Other |

| 94 | 6 | 19 | 1653 | 1659 | -6 | 1908 | 1933 | UA | 885 | N15712 | EWR | LAS | 293 | 2227 | 16 | 59 | 2023-06-19 16:00:00 | Other |

| 96 | 4 | 25 | 2038 | 2050 | -12 | 2153 | 2227 | YX | 1517 | N212JQ | LGA | RIC | 57 | 292 | 20 | 50 | 2023-04-25 20:00:00 | Other |

| 97 | 2 | 25 | 1815 | 1830 | -15 | 2024 | 2033 | YX | 1033 | N736YX | EWR | CMH | 91 | 463 | 18 | 30 | 2023-02-25 18:00:00 | Other |

| 99 | 3 | 18 | 1553 | 1600 | -7 | 1900 | 1921 | AA | 98 | N109NN | JFK | LAX | 335 | 2475 | 16 | 0 | 2023-03-18 16:00:00 | LAX |

| 103 | 6 | 17 | 1524 | 1530 | -6 | 1719 | 1716 | YX | 1101 | N862RW | EWR | CLE | 64 | 404 | 15 | 30 | 2023-06-17 15:00:00 | Other |

| 107 | 11 | 11 | 1719 | 1729 | -10 | 1954 | 2020 | UA | 830 | N37556 | EWR | LAS | 308 | 2227 | 17 | 29 | 2023-11-11 17:00:00 | Other |

| 108 | 12 | 24 | 1507 | 1515 | -8 | 1720 | 1756 | UA | 598 | N854UA | LGA | DEN | 228 | 1620 | 15 | 15 | 2023-12-24 15:00:00 | Other |

| 113 | 9 | 16 | 1751 | 1800 | -9 | 1909 | 1937 | AA | 192 | N744P | LGA | ORD | 107 | 733 | 18 | 0 | 2023-09-16 18:00:00 | ORD |

| 119 | 11 | 24 | 1429 | 1440 | -11 | 1607 | 1641 | YX | 1292 | N115HQ | LGA | ILM | 79 | 500 | 14 | 40 | 2023-11-24 14:00:00 | Other |

| 121 | 5 | 25 | 2124 | 2130 | -6 | 2247 | 2250 | YX | 1696 | N214JQ | LGA | PWM | 49 | 269 | 21 | 30 | 2023-05-25 21:00:00 | Other |

| 128 | 2 | 21 | 931 | 940 | -9 | 1432 | 1444 | UA | 583 | N68801 | EWR | SJU | 194 | 1608 | 9 | 40 | 2023-02-21 09:00:00 | Other |

| 131 | 4 | 16 | 1713 | 1720 | -7 | 1831 | 1849 | YX | 1520 | N824MD | LGA | ROC | 45 | 254 | 17 | 20 | 2023-04-16 17:00:00 | Other |

| 133 | 9 | 27 | 1841 | 1851 | -10 | 2016 | 2016 | UA | 584 | N76503 | EWR | ORF | 54 | 284 | 18 | 51 | 2023-09-27 18:00:00 | Other |

| 135 | 8 | 19 | 1146 | 1152 | -6 | 1257 | 1309 | UA | 237 | N37516 | EWR | BOS | 46 | 200 | 11 | 52 | 2023-08-19 11:00:00 | BOS |

| 141 | 3 | 13 | 1056 | 1105 | -9 | 1230 | 1258 | AA | 928 | N751UW | LGA | STL | 133 | 888 | 11 | 5 | 2023-03-13 11:00:00 | Other |

| 146 | 4 | 12 | 2050 | 2059 | -9 | 2304 | 2334 | YX | 1158 | N128HQ | LGA | ATL | 103 | 762 | 20 | 59 | 2023-04-12 20:00:00 | ATL |

| 147 | 2 | 2 | 1150 | 1200 | -10 | 1422 | 1431 | YX | 1226 | N132HQ | LGA | MEM | 186 | 963 | 12 | 0 | 2023-02-02 12:00:00 | Other |

| 150 | 3 | 21 | 840 | 849 | -9 | 1036 | 1045 | YX | 1364 | N128HQ | LGA | ILM | 81 | 500 | 8 | 49 | 2023-03-21 08:00:00 | Other |

| 156 | 5 | 4 | 1142 | 1155 | -13 | 1322 | 1415 | G4 | 164 | 278NV | EWR | DSM | 137 | 1017 | 11 | 55 | 2023-05-04 11:00:00 | Other |

| 163 | 4 | 21 | 2149 | 2159 | -10 | 2249 | 2308 | DL | 445 | N144DU | LGA | SYR | 40 | 198 | 21 | 59 | 2023-04-21 21:00:00 | Other |

| 164 | 1 | 30 | 1746 | 1755 | -9 | 1957 | 2007 | DL | 626 | N338NB | EWR | MSP | 166 | 1008 | 17 | 55 | 2023-01-30 17:00:00 | Other |

| 174 | 9 | 16 | 946 | 959 | -13 | 1111 | 1158 | YX | 1181 | N736YX | EWR | GSO | 65 | 445 | 9 | 59 | 2023-09-16 09:00:00 | Other |

| 179 | 12 | 22 | 1905 | 1912 | -7 | 2052 | 2123 | AA | 618 | N712US | LGA | CLT | 81 | 544 | 19 | 12 | 2023-12-22 19:00:00 | CLT |

| 187 | 4 | 7 | 1414 | 1420 | -6 | 1634 | 1637 | 9E | 1410 | N279PQ | LGA | CHS | 99 | 641 | 14 | 20 | 2023-04-07 14:00:00 | Other |

| 189 | 3 | 17 | 950 | 959 | -9 | 1131 | 1218 | 9E | 1440 | N932XJ | LGA | MYR | 80 | 563 | 9 | 59 | 2023-03-17 09:00:00 | Other |

| 193 | 6 | 13 | 1223 | 1229 | -6 | 1514 | 1517 | UA | 438 | N493UA | LGA | IAH | 214 | 1416 | 12 | 29 | 2023-06-13 12:00:00 | Other |

| 196 | 6 | 1 | 1937 | 1945 | -8 | 2230 | 2304 | DL | 815 | N365NB | JFK | PBI | 130 | 1028 | 19 | 45 | 2023-06-01 19:00:00 | Other |

| 199 | 8 | 29 | 1656 | 1703 | -7 | 1835 | 1913 | 9E | 1203 | N135EV | JFK | RDU | 69 | 427 | 17 | 3 | 2023-08-29 17:00:00 | Other |

| 200 | 6 | 4 | 1129 | 1135 | -6 | 1256 | 1311 | UA | 705 | N57286 | EWR | CLE | 64 | 404 | 11 | 35 | 2023-06-04 11:00:00 | Other |

| 232 | 2 | 22 | 1916 | 1925 | -9 | 2136 | 2125 | AA | 142 | N767UW | LGA | RDU | 76 | 431 | 19 | 25 | 2023-02-22 19:00:00 | Other |

| 234 | 5 | 27 | 1154 | 1200 | -6 | 1257 | 1321 | AA | 772 | N763US | LGA | DCA | 43 | 214 | 12 | 0 | 2023-05-27 12:00:00 | Other |

| 235 | 12 | 6 | 942 | 950 | -8 | 1141 | 1213 | 9E | 1498 | N335PQ | LGA | CVG | 87 | 585 | 9 | 50 | 2023-12-06 09:00:00 | Other |

| 238 | 8 | 9 | 652 | 659 | -7 | 836 | 857 | YX | 999 | N446YX | LGA | DTW | 78 | 502 | 6 | 59 | 2023-08-09 06:00:00 | Other |

| 241 | 1 | 13 | 1241 | 1250 | -9 | 1537 | 1559 | B6 | 42 | N559JB | JFK | TPA | 155 | 1005 | 12 | 50 | 2023-01-13 12:00:00 | Other |

| 244 | 12 | 5 | 708 | 715 | -7 | 1027 | 1023 | B6 | 214 | N2044J | JFK | FLL | 163 | 1069 | 7 | 15 | 2023-12-05 07:00:00 | FLL |

| 251 | 9 | 27 | 2044 | 2059 | -15 | 2311 | 2331 | YX | 1147 | N743YX | EWR | SDF | 108 | 642 | 20 | 59 | 2023-09-27 20:00:00 | Other |

| 256 | 8 | 22 | 1951 | 1959 | -8 | 2254 | 2258 | NK | 145 | N687NK | LGA | MCO | 117 | 950 | 19 | 59 | 2023-08-22 19:00:00 | MCO |

| 262 | 6 | 28 | 2152 | 2200 | -8 | 2318 | 2321 | YX | 1365 | N126HQ | JFK | BOS | 42 | 187 | 22 | 0 | 2023-06-28 22:00:00 | BOS |

| 266 | 9 | 13 | 2039 | 2050 | -11 | 2156 | 2227 | YX | 1965 | N882RW | LGA | MSN | 113 | 812 | 20 | 50 | 2023-09-13 20:00:00 | Other |

| 282 | 3 | 2 | 552 | 600 | -8 | 748 | 801 | AA | 243 | N907AN | LGA | CLT | 98 | 544 | 6 | 0 | 2023-03-02 06:00:00 | CLT |

| 286 | 5 | 9 | 1840 | 1853 | -13 | 2127 | 2100 | UA | 539 | N37277 | EWR | CHS | 90 | 628 | 18 | 53 | 2023-05-09 18:00:00 | Other |

| 289 | 8 | 25 | 1753 | 1759 | -6 | 2001 | 2008 | YX | 1035 | N441YX | LGA | MCI | 153 | 1107 | 17 | 59 | 2023-08-25 17:00:00 | Other |

| 294 | 11 | 30 | 1353 | 1400 | -7 | 1635 | 1658 | UA | 639 | N14115 | EWR | MCO | 142 | 937 | 14 | 0 | 2023-11-30 14:00:00 | MCO |

| 297 | 5 | 11 | 1232 | 1241 | -9 | 1614 | 1637 | AA | 230 | N12028 | JFK | STT | 196 | 1623 | 12 | 41 | 2023-05-11 12:00:00 | Other |

| 302 | 7 | 11 | 1135 | 1142 | -7 | 1302 | 1326 | YX | 1075 | N427YX | LGA | ROA | 64 | 405 | 11 | 42 | 2023-07-11 11:00:00 | Other |

| 304 | 7 | 19 | 1814 | 1820 | -6 | 2105 | 2109 | YX | 1357 | N233JQ | JFK | SAV | 107 | 718 | 18 | 20 | 2023-07-19 18:00:00 | Other |

| 308 | 12 | 29 | 524 | 530 | -6 | 801 | 912 | NK | 347 | N645NK | EWR | PHX | 260 | 2133 | 5 | 30 | 2023-12-29 05:00:00 | Other |

| 311 | 2 | 17 | 1143 | 1155 | -12 | 1404 | 1420 | G4 | 924 | 316NV | EWR | SAV | 127 | 708 | 11 | 55 | 2023-02-17 11:00:00 | Other |

| 312 | 5 | 17 | 1646 | 1653 | -7 | 1836 | 1901 | YX | 1012 | N747YX | EWR | GSP | 91 | 594 | 16 | 53 | 2023-05-17 16:00:00 | Other |

| 316 | 10 | 12 | 1150 | 1159 | -9 | 1301 | 1317 | UA | 419 | N414UA | EWR | PWM | 50 | 284 | 11 | 59 | 2023-10-12 11:00:00 | Other |

| 323 | 3 | 7 | 820 | 835 | -15 | 1015 | 1035 | 9E | 1410 | N920XJ | LGA | RDU | 71 | 431 | 8 | 35 | 2023-03-07 08:00:00 | Other |

| 325 | 6 | 4 | 553 | 601 | -8 | 750 | 759 | AA | 987 | N123NN | EWR | CLT | 82 | 529 | 6 | 1 | 2023-06-04 06:00:00 | CLT |

| 326 | 2 | 22 | 1028 | 1039 | -11 | 1136 | 1154 | B6 | 56 | N198JB | EWR | BOS | 38 | 200 | 10 | 39 | 2023-02-22 10:00:00 | BOS |

| 328 | 10 | 5 | 757 | 805 | -8 | 1106 | 1135 | AA | 49 | N103NN | JFK | SFO | 339 | 2586 | 8 | 5 | 2023-10-05 08:00:00 | Other |

| 342 | 10 | 2 | 1653 | 1700 | -7 | 1816 | 1831 | YX | 1334 | N416YX | LGA | RIC | 52 | 292 | 17 | 0 | 2023-10-02 17:00:00 | Other |

| 343 | 5 | 16 | 553 | 600 | -7 | 704 | 712 | B6 | 795 | N317JB | EWR | BOS | 38 | 200 | 6 | 0 | 2023-05-16 06:00:00 | BOS |

| 344 | 6 | 12 | 623 | 630 | -7 | 1014 | 1023 | B6 | 618 | N957JB | JFK | SJU | 200 | 1598 | 6 | 30 | 2023-06-12 06:00:00 | Other |

| 345 | 6 | 7 | 1051 | 1100 | -9 | 1339 | 1415 | B6 | 298 | N564JB | JFK | SAT | 207 | 1587 | 11 | 0 | 2023-06-07 11:00:00 | Other |

| 346 | 2 | 25 | 1124 | 1130 | -6 | 1318 | 1351 | AA | 107 | N855NN | LGA | CLT | 93 | 544 | 11 | 30 | 2023-02-25 11:00:00 | CLT |

| 348 | 3 | 15 | 1521 | 1529 | -8 | 1712 | 1733 | YX | 1395 | N430YX | JFK | CLE | 78 | 425 | 15 | 29 | 2023-03-15 15:00:00 | Other |

| 353 | 1 | 9 | 2106 | 2112 | -6 | 2304 | 2323 | UA | 938 | N412UA | EWR | MSP | 148 | 1008 | 21 | 12 | 2023-01-09 21:00:00 | Other |

| 354 | 10 | 17 | 1753 | 1800 | -7 | 2001 | 2022 | YX | 1289 | N419YX | LGA | IND | 98 | 660 | 18 | 0 | 2023-10-17 18:00:00 | Other |

| 360 | 5 | 23 | 805 | 811 | -6 | 1012 | 1026 | YX | 1094 | N641RW | EWR | DTW | 78 | 488 | 8 | 11 | 2023-05-23 08:00:00 | Other |

| 364 | 8 | 22 | 1721 | 1729 | -8 | 1914 | 1951 | YX | 857 | N744YX | EWR | IND | 94 | 645 | 17 | 29 | 2023-08-22 17:00:00 | Other |

| 369 | 5 | 27 | 801 | 810 | -9 | 922 | 955 | DL | 552 | N139DU | LGA | ORD | 106 | 733 | 8 | 10 | 2023-05-27 08:00:00 | ORD |

| 392 | 5 | 29 | 1021 | 1030 | -9 | 1115 | 1140 | B6 | 930 | N339JB | JFK | BOS | 35 | 187 | 10 | 30 | 2023-05-29 10:00:00 | BOS |

| 398 | 5 | 9 | 934 | 940 | -6 | 1244 | 1257 | B6 | 108 | N984JB | JFK | LAX | 340 | 2475 | 9 | 40 | 2023-05-09 09:00:00 | LAX |

| 399 | 2 | 10 | 2017 | 2030 | -13 | 2158 | 2210 | YX | 1538 | N214JQ | LGA | PIT | 68 | 335 | 20 | 30 | 2023-02-10 20:00:00 | Other |

| 400 | 5 | 19 | 2153 | 2200 | -7 | 2317 | 2347 | 9E | 1447 | N297PQ | JFK | ROC | 47 | 264 | 22 | 0 | 2023-05-19 22:00:00 | Other |

| 401 | 2 | 14 | 1420 | 1430 | -10 | 1555 | 1616 | YX | 1270 | N441YX | JFK | PIT | 72 | 340 | 14 | 30 | 2023-02-14 14:00:00 | Other |

| 402 | 2 | 7 | 2057 | 2108 | -11 | 2244 | 2319 | YX | 1289 | N413YX | LGA | GSO | 84 | 461 | 21 | 8 | 2023-02-07 21:00:00 | Other |

| 404 | 3 | 6 | 1921 | 1930 | -9 | 2055 | 2129 | YX | 1396 | N428YX | JFK | DCA | 58 | 213 | 19 | 30 | 2023-03-06 19:00:00 | Other |

| 413 | 10 | 11 | 926 | 933 | -7 | 1140 | 1158 | NK | 1186 | N645NK | EWR | PHX | 282 | 2133 | 9 | 33 | 2023-10-11 09:00:00 | Other |

| 417 | 2 | 17 | 1054 | 1100 | -6 | 1245 | 1247 | YX | 1031 | N725YX | EWR | RDU | 81 | 416 | 11 | 0 | 2023-02-17 11:00:00 | Other |

| 419 | 4 | 20 | 1550 | 1559 | -9 | 1747 | 1814 | 9E | 1327 | N337PQ | LGA | CLT | 79 | 544 | 15 | 59 | 2023-04-20 15:00:00 | CLT |

| 420 | 4 | 18 | 559 | 610 | -11 | 731 | 750 | DL | 389 | N127DU | LGA | ORD | 113 | 733 | 6 | 10 | 2023-04-18 06:00:00 | ORD |

| 425 | 10 | 9 | 554 | 600 | -6 | 843 | 854 | UA | 227 | N77559 | EWR | AUS | 201 | 1504 | 6 | 0 | 2023-10-09 06:00:00 | Other |

| 429 | 12 | 11 | 842 | 848 | -6 | 1053 | 1110 | 9E | 1398 | N926XJ | LGA | CLT | 95 | 544 | 8 | 48 | 2023-12-11 08:00:00 | CLT |

| 434 | 1 | 6 | 1921 | 1929 | -8 | 2106 | 2137 | AA | 819 | N949AN | JFK | CLT | 87 | 541 | 19 | 29 | 2023-01-06 19:00:00 | CLT |

| 435 | 10 | 17 | 1309 | 1315 | -6 | 1412 | 1431 | B6 | 252 | N267JB | LGA | BOS | 35 | 184 | 13 | 15 | 2023-10-17 13:00:00 | BOS |

| 439 | 2 | 15 | 1519 | 1529 | -10 | 1710 | 1733 | YX | 1150 | N742YX | EWR | CMH | 85 | 463 | 15 | 29 | 2023-02-15 15:00:00 | Other |

| 444 | 4 | 19 | 1749 | 1800 | -11 | 1933 | 2025 | 9E | 1375 | N490PX | LGA | TYS | 88 | 647 | 18 | 0 | 2023-04-19 18:00:00 | Other |

| 446 | 11 | 26 | 845 | 900 | -15 | 1131 | 1136 | 9E | 1458 | N302PQ | LGA | SAV | 125 | 722 | 9 | 0 | 2023-11-26 09:00:00 | Other |

| 452 | 9 | 2 | 553 | 600 | -7 | 758 | 820 | UA | 413 | N14735 | EWR | ATL | 101 | 746 | 6 | 0 | 2023-09-02 06:00:00 | ATL |

| 457 | 1 | 5 | 2207 | 2216 | -9 | 142 | 149 | B6 | 1011 | N987JT | JFK | SFO | 353 | 2586 | 22 | 16 | 2023-01-05 22:00:00 | Other |

| 468 | 1 | 27 | 550 | 600 | -10 | 712 | 723 | YX | 1853 | N234JQ | EWR | BOS | 41 | 200 | 6 | 0 | 2023-01-27 06:00:00 | BOS |

| 469 | 6 | 9 | 1522 | 1529 | -7 | 1644 | 1651 | UA | 490 | N417UA | EWR | BNA | 109 | 748 | 15 | 29 | 2023-06-09 15:00:00 | Other |

| 470 | 7 | 12 | 1656 | 1704 | -8 | 1904 | 1929 | YX | 1066 | N410YX | JFK | CVG | 97 | 589 | 17 | 4 | 2023-07-12 17:00:00 | Other |

| 474 | 8 | 17 | 1039 | 1050 | -11 | 1345 | 1408 | DL | 347 | N108DQ | LGA | RSW | 162 | 1080 | 10 | 50 | 2023-08-17 10:00:00 | Other |

| 485 | 3 | 18 | 1948 | 1959 | -11 | 2222 | 2235 | DL | 805 | N353NB | LGA | MSY | 193 | 1183 | 19 | 59 | 2023-03-18 19:00:00 | Other |

| 488 | 11 | 24 | 723 | 730 | -7 | 1038 | 1049 | AA | 966 | N9010R | JFK | AUS | 223 | 1521 | 7 | 30 | 2023-11-24 07:00:00 | Other |

| 491 | 1 | 9 | 834 | 843 | -9 | 1001 | 1023 | YX | 1176 | N729YX | EWR | MKE | 111 | 725 | 8 | 43 | 2023-01-09 08:00:00 | Other |

| 492 | 10 | 11 | 1209 | 1215 | -6 | 1512 | 1519 | YX | 1245 | N422YX | LGA | OKC | 214 | 1341 | 12 | 15 | 2023-10-11 12:00:00 | Other |

| 501 | 11 | 18 | 1020 | 1030 | -10 | 1322 | 1356 | B6 | 945 | N591JB | JFK | AUS | 216 | 1521 | 10 | 30 | 2023-11-18 10:00:00 | Other |

| 509 | 3 | 30 | 1352 | 1400 | -8 | 1550 | 1548 | OO | 1568 | N128SY | LGA | ORD | 136 | 733 | 14 | 0 | 2023-03-30 14:00:00 | ORD |

| 517 | 4 | 14 | 2208 | 2214 | -6 | 2323 | 2359 | 9E | 1322 | N320PQ | JFK | BUF | 50 | 301 | 22 | 14 | 2023-04-14 22:00:00 | Other |

| 524 | 12 | 6 | 1302 | 1311 | -9 | 1431 | 1447 | UA | 193 | N13750 | EWR | ORD | 119 | 719 | 13 | 11 | 2023-12-06 13:00:00 | ORD |

| 526 | 7 | 12 | 1540 | 1550 | -10 | 1717 | 1816 | 9E | 1119 | N133EV | LGA | CLT | 73 | 544 | 15 | 50 | 2023-07-12 15:00:00 | CLT |

| 531 | 3 | 15 | 652 | 659 | -7 | 841 | 846 | YX | 1074 | N863RW | EWR | CLE | 65 | 404 | 6 | 59 | 2023-03-15 06:00:00 | Other |

| 536 | 9 | 2 | 704 | 710 | -6 | 941 | 1003 | UA | 665 | N27290 | EWR | PDX | 312 | 2434 | 7 | 10 | 2023-09-02 07:00:00 | Other |

| 537 | 1 | 17 | 659 | 705 | -6 | 933 | 1008 | DL | 425 | N362NB | LGA | PBI | 137 | 1035 | 7 | 5 | 2023-01-17 07:00:00 | Other |

| 539 | 10 | 5 | 1412 | 1421 | -9 | 1703 | 1717 | UA | 270 | N842UA | EWR | AUS | 212 | 1504 | 14 | 21 | 2023-10-05 14:00:00 | Other |

| 542 | 11 | 27 | 2151 | 2159 | -8 | 2324 | 2321 | UA | 451 | N896UA | EWR | BUF | 53 | 282 | 21 | 59 | 2023-11-27 21:00:00 | Other |

| 547 | 5 | 4 | 1916 | 1925 | -9 | 2022 | 2053 | YX | 1331 | N435YX | JFK | BOS | 38 | 187 | 19 | 25 | 2023-05-04 19:00:00 | BOS |

| 554 | 3 | 23 | 1154 | 1202 | -8 | 1349 | 1408 | YX | 1688 | N205JQ | JFK | CLT | 85 | 541 | 12 | 2 | 2023-03-23 12:00:00 | CLT |

| 564 | 1 | 27 | 1623 | 1630 | -7 | 1815 | 1820 | DL | 932 | N110DU | LGA | BNA | 129 | 764 | 16 | 30 | 2023-01-27 16:00:00 | Other |

| 568 | 5 | 9 | 1943 | 1950 | -7 | 2232 | 2240 | B6 | 47 | N2043J | JFK | PHX | 293 | 2153 | 19 | 50 | 2023-05-09 19:00:00 | Other |

| 570 | 4 | 27 | 1651 | 1700 | -9 | 1927 | 1925 | YX | 1280 | N867RW | LGA | IND | 110 | 660 | 17 | 0 | 2023-04-27 17:00:00 | Other |

| 572 | 12 | 27 | 1722 | 1729 | -7 | 1950 | 2047 | UA | 588 | N37319 | EWR | SAN | 307 | 2425 | 17 | 29 | 2023-12-27 17:00:00 | Other |

| 574 | 1 | 30 | 1929 | 1935 | -6 | 2352 | 30 | B6 | 536 | N598JB | EWR | SJU | 180 | 1608 | 19 | 35 | 2023-01-30 19:00:00 | Other |

| 575 | 6 | 9 | 1124 | 1135 | -11 | 1330 | 1341 | AA | 779 | N924NN | LGA | CLT | 92 | 544 | 11 | 35 | 2023-06-09 11:00:00 | CLT |

| 577 | 4 | 20 | 822 | 829 | -7 | 1014 | 1032 | YX | 1129 | N869RW | LGA | DAY | 90 | 549 | 8 | 29 | 2023-04-20 08:00:00 | Other |

| 580 | 2 | 7 | 1621 | 1630 | -9 | 1823 | 1840 | B6 | 386 | N249JB | JFK | DTW | 94 | 509 | 16 | 30 | 2023-02-07 16:00:00 | Other |

| 583 | 1 | 18 | 949 | 958 | -9 | 1109 | 1146 | 9E | 1665 | N293PQ | LGA | CHO | 53 | 305 | 9 | 58 | 2023-01-18 09:00:00 | Other |

| 584 | 5 | 11 | 1438 | 1444 | -6 | 1721 | 1740 | DL | 556 | N352NB | LGA | TPA | 135 | 1010 | 14 | 44 | 2023-05-11 14:00:00 | Other |

| 590 | 10 | 8 | 954 | 1000 | -6 | 1151 | 1219 | 9E | 1571 | N326PQ | LGA | CVG | 93 | 585 | 10 | 0 | 2023-10-08 10:00:00 | Other |

| 591 | 7 | 30 | 1050 | 1059 | -9 | 1238 | 1255 | NK | 522 | N905NK | LGA | DTW | 85 | 502 | 10 | 59 | 2023-07-30 10:00:00 | Other |

| 592 | 9 | 18 | 604 | 610 | -6 | 759 | 811 | DL | 430 | N369NW | LGA | MSP | 141 | 1020 | 6 | 10 | 2023-09-18 06:00:00 | Other |

| 596 | 5 | 18 | 1559 | 1605 | -6 | 1727 | 1746 | YX | 1576 | N244JQ | LGA | BNA | 116 | 764 | 16 | 5 | 2023-05-18 16:00:00 | Other |

| 602 | 1 | 2 | 1603 | 1611 | -8 | 1808 | 1827 | YX | 1339 | N114HQ | LGA | DTW | 96 | 502 | 16 | 11 | 2023-01-02 16:00:00 | Other |

| 603 | 1 | 15 | 1055 | 1106 | -11 | 1208 | 1242 | UA | 850 | N443UA | EWR | BNA | 103 | 748 | 11 | 6 | 2023-01-15 11:00:00 | Other |

| 612 | 5 | 17 | 721 | 727 | -6 | 925 | 951 | YX | 1007 | N751YX | EWR | SDF | 104 | 642 | 7 | 27 | 2023-05-17 07:00:00 | Other |

| 621 | 12 | 31 | 1916 | 1930 | -14 | 2214 | 2239 | B6 | 203 | N760JB | LGA | FLL | 162 | 1076 | 19 | 30 | 2023-12-31 19:00:00 | FLL |

| 626 | 12 | 10 | 1254 | 1300 | -6 | 1607 | 1626 | DL | 243 | N904DN | JFK | SLC | 282 | 1990 | 13 | 0 | 2023-12-10 13:00:00 | Other |

| 634 | 11 | 4 | 1601 | 1609 | -8 | 1810 | 1842 | 9E | 1613 | N691CA | JFK | SAV | 107 | 718 | 16 | 9 | 2023-11-04 16:00:00 | Other |

| 637 | 4 | 17 | 1559 | 1605 | -6 | 1855 | 1933 | B6 | 302 | N983JT | JFK | LAX | 334 | 2475 | 16 | 5 | 2023-04-17 16:00:00 | LAX |

| 641 | 6 | 7 | 550 | 600 | -10 | 828 | 849 | B6 | 610 | N621JB | JFK | TPA | 138 | 1005 | 6 | 0 | 2023-06-07 06:00:00 | Other |

| 649 | 9 | 14 | 2035 | 2045 | -10 | 2312 | 2248 | 9E | 1466 | N228PQ | LGA | MYR | 87 | 563 | 20 | 45 | 2023-09-14 20:00:00 | Other |

| 650 | 6 | 19 | 954 | 1000 | -6 | 1105 | 1134 | YX | 1916 | N245JQ | LGA | BOS | 34 | 184 | 10 | 0 | 2023-06-19 10:00:00 | BOS |

| 652 | 1 | 2 | 1439 | 1445 | -6 | 1556 | 1615 | YX | 1318 | N420YX | JFK | ORF | 52 | 290 | 14 | 45 | 2023-01-02 14:00:00 | Other |

| 654 | 2 | 7 | 547 | 600 | -13 | 731 | 740 | AA | 948 | N813NN | LGA | ORD | 134 | 733 | 6 | 0 | 2023-02-07 06:00:00 | ORD |

| 661 | 11 | 20 | 948 | 959 | -11 | 1153 | 1220 | 9E | 1523 | N131EV | JFK | IND | 102 | 665 | 9 | 59 | 2023-11-20 09:00:00 | Other |

| 666 | 12 | 5 | 2049 | 2059 | -10 | 2215 | 2240 | 9E | 1353 | N910XJ | LGA | ORF | 53 | 296 | 20 | 59 | 2023-12-05 20:00:00 | Other |

| 677 | 11 | 7 | 823 | 830 | -7 | 1421 | 1438 | UA | 119 | N76055 | EWR | HNL | 628 | 4962 | 8 | 30 | 2023-11-07 08:00:00 | Other |

| 689 | 5 | 9 | 1512 | 1519 | -7 | 1806 | 1842 | DL | 633 | N325DN | JFK | FLL | 148 | 1069 | 15 | 19 | 2023-05-09 15:00:00 | FLL |

| 693 | 4 | 12 | 922 | 929 | -7 | 1054 | 1120 | YX | 1164 | N413YX | LGA | CLE | 68 | 419 | 9 | 29 | 2023-04-12 09:00:00 | Other |

| 695 | 10 | 13 | 1026 | 1035 | -9 | 1212 | 1233 | UA | 473 | N27722 | EWR | CLT | 85 | 529 | 10 | 35 | 2023-10-13 10:00:00 | CLT |

| 700 | 9 | 17 | 1521 | 1529 | -8 | 1651 | 1713 | YX | 1413 | N416YX | LGA | STL | 125 | 888 | 15 | 29 | 2023-09-17 15:00:00 | Other |

| 701 | 3 | 1 | 1849 | 1855 | -6 | 2050 | 2045 | WN | 638 | N963WN | LGA | BNA | 125 | 764 | 18 | 55 | 2023-03-01 18:00:00 | Other |

| 713 | 3 | 6 | 1653 | 1659 | -6 | 1915 | 1931 | UA | 600 | N829UA | EWR | ATL | 113 | 746 | 16 | 59 | 2023-03-06 16:00:00 | ATL |

| 719 | 3 | 12 | 2143 | 2150 | -7 | 2318 | 2313 | 9E | 1409 | N294PQ | LGA | BGR | 58 | 378 | 21 | 50 | 2023-03-12 21:00:00 | Other |

| 726 | 12 | 2 | 1739 | 1750 | -11 | 1831 | 1900 | 9E | 1569 | N482PX | LGA | PVD | 27 | 143 | 17 | 50 | 2023-12-02 17:00:00 | Other |

| 744 | 3 | 25 | 748 | 755 | -7 | 941 | 958 | AA | 608 | N951NN | EWR | CLT | 88 | 529 | 7 | 55 | 2023-03-25 07:00:00 | CLT |

| 746 | 9 | 22 | 1652 | 1700 | -8 | 1823 | 1831 | YX | 1384 | N122HQ | LGA | RIC | 59 | 292 | 17 | 0 | 2023-09-22 17:00:00 | Other |

| 747 | 4 | 8 | 1252 | 1300 | -8 | 1611 | 1640 | AS | 4 | N971AK | JFK | SFO | 352 | 2586 | 13 | 0 | 2023-04-08 13:00:00 | Other |

| 764 | 4 | 26 | 1223 | 1230 | -7 | 1403 | 1409 | AA | 880 | N354PT | LGA | ORD | 120 | 733 | 12 | 30 | 2023-04-26 12:00:00 | ORD |

| 765 | 11 | 29 | 2120 | 2129 | -9 | 2251 | 2325 | YX | 1068 | N745YX | EWR | ILM | 71 | 488 | 21 | 29 | 2023-11-29 21:00:00 | Other |

| 772 | 9 | 19 | 1819 | 1829 | -10 | 2003 | 2053 | 9E | 1551 | N485PX | LGA | TYS | 86 | 647 | 18 | 29 | 2023-09-19 18:00:00 | Other |

| 773 | 9 | 7 | 854 | 900 | -6 | 1008 | 1026 | YX | 1404 | N871RW | LGA | BUF | 49 | 292 | 9 | 0 | 2023-09-07 09:00:00 | Other |

| 774 | 10 | 29 | 1009 | 1015 | -6 | 1159 | 1154 | UA | 672 | N417UA | LGA | ORD | 134 | 733 | 10 | 15 | 2023-10-29 10:00:00 | ORD |

| 778 | 12 | 1 | 754 | 800 | -6 | 944 | 1008 | DL | 506 | N373DX | LGA | DTW | 84 | 502 | 8 | 0 | 2023-12-01 08:00:00 | Other |

| 782 | 8 | 25 | 1752 | 1800 | -8 | 2010 | 2027 | YX | 990 | N417YX | LGA | TUL | 167 | 1231 | 18 | 0 | 2023-08-25 18:00:00 | Other |

| 791 | 8 | 7 | 1052 | 1100 | -8 | 1236 | 1254 | YX | 980 | N438YX | JFK | CLE | 75 | 425 | 11 | 0 | 2023-08-07 11:00:00 | Other |

| 794 | 1 | 15 | 1838 | 1845 | -7 | 2132 | 2147 | UA | 983 | N16009 | EWR | LAX | 311 | 2454 | 18 | 45 | 2023-01-15 18:00:00 | LAX |

| 800 | 5 | 5 | 624 | 630 | -6 | 805 | 819 | YX | 1575 | N203JQ | LGA | CMH | 76 | 479 | 6 | 30 | 2023-05-05 06:00:00 | Other |

| 803 | 1 | 29 | 1502 | 1510 | -8 | 1719 | 1733 | YX | 1369 | N408YX | JFK | CVG | 114 | 589 | 15 | 10 | 2023-01-29 15:00:00 | Other |

| 809 | 9 | 13 | 2056 | 2110 | -14 | 2254 | 2309 | YX | 1322 | N104HQ | LGA | MEM | 149 | 963 | 21 | 10 | 2023-09-13 21:00:00 | Other |

| 811 | 9 | 15 | 1546 | 1559 | -13 | 1719 | 1737 | YX | 1827 | N815MD | LGA | BGR | 67 | 378 | 15 | 59 | 2023-09-15 15:00:00 | Other |

| 813 | 6 | 6 | 1824 | 1833 | -9 | 2159 | 2116 | YX | 1329 | N409YX | LGA | OKC | 190 | 1341 | 18 | 33 | 2023-06-06 18:00:00 | Other |

| 814 | 12 | 18 | 1721 | 1730 | -9 | 1941 | 2015 | YX | 1321 | N432YX | LGA | SDF | 103 | 659 | 17 | 30 | 2023-12-18 17:00:00 | Other |

| 820 | 9 | 10 | 1955 | 2005 | -10 | 2159 | 2212 | 9E | 1576 | N538CA | LGA | DAY | 96 | 549 | 20 | 5 | 2023-09-10 20:00:00 | Other |

| 828 | 6 | 12 | 1953 | 2000 | -7 | 2108 | 2139 | OO | 1266 | N244SY | LGA | MKE | 107 | 738 | 20 | 0 | 2023-06-12 20:00:00 | Other |

| 835 | 5 | 23 | 1951 | 2000 | -9 | 2152 | 2254 | B6 | 35 | N635JB | JFK | DEN | 204 | 1626 | 20 | 0 | 2023-05-23 20:00:00 | Other |

| 842 | 11 | 6 | 654 | 700 | -6 | 939 | 1020 | DL | 314 | N377DA | JFK | RSW | 146 | 1074 | 7 | 0 | 2023-11-06 07:00:00 | Other |

| 845 | 6 | 7 | 723 | 730 | -7 | 940 | 1005 | 9E | 1526 | N306PQ | LGA | JAX | 114 | 833 | 7 | 30 | 2023-06-07 07:00:00 | Other |

| 847 | 3 | 9 | 955 | 1005 | -10 | 1254 | 1319 | NK | 31 | N682NK | EWR | MIA | 150 | 1085 | 10 | 5 | 2023-03-09 10:00:00 | MIA |

| 855 | 3 | 19 | 1108 | 1115 | -7 | 1320 | 1344 | YX | 1316 | N445YX | JFK | IND | 109 | 665 | 11 | 15 | 2023-03-19 11:00:00 | Other |

| 858 | 8 | 31 | 2004 | 2011 | -7 | 2131 | 2151 | YX | 1038 | N102HQ | LGA | PIT | 59 | 335 | 20 | 11 | 2023-08-31 20:00:00 | Other |

| 860 | 9 | 15 | 1059 | 1110 | -11 | 1229 | 1243 | YX | 1311 | N110HQ | LGA | PIT | 58 | 335 | 11 | 10 | 2023-09-15 11:00:00 | Other |

| 862 | 7 | 6 | 840 | 850 | -10 | 956 | 1010 | YX | 1344 | N878RW | EWR | BOS | 43 | 200 | 8 | 50 | 2023-07-06 08:00:00 | BOS |

| 863 | 12 | 12 | 648 | 655 | -7 | 928 | 950 | B6 | 177 | N988JT | JFK | LAS | 319 | 2248 | 6 | 55 | 2023-12-12 06:00:00 | Other |

| 864 | 11 | 18 | 927 | 934 | -7 | 1153 | 1200 | B6 | 983 | N318JB | JFK | CHS | 107 | 636 | 9 | 34 | 2023-11-18 09:00:00 | Other |

| 866 | 10 | 25 | 652 | 700 | -8 | 956 | 1009 | B6 | 248 | N961JT | JFK | LAX | 336 | 2475 | 7 | 0 | 2023-10-25 07:00:00 | LAX |

| 868 | 4 | 7 | 1004 | 1010 | -6 | 1313 | 1318 | DL | 893 | N126DN | LGA | MCO | 143 | 950 | 10 | 10 | 2023-04-07 10:00:00 | MCO |

| 876 | 5 | 22 | 747 | 759 | -12 | 901 | 928 | UA | 225 | N484UA | EWR | BOS | 39 | 200 | 7 | 59 | 2023-05-22 07:00:00 | BOS |

| 878 | 2 | 9 | 1223 | 1230 | -7 | 1358 | 1438 | AA | 451 | N952NN | LGA | ORD | 125 | 733 | 12 | 30 | 2023-02-09 12:00:00 | ORD |

| 879 | 6 | 14 | 454 | 500 | -6 | 732 | 812 | NK | 299 | N951NK | EWR | OAK | 315 | 2555 | 5 | 0 | 2023-06-14 05:00:00 | Other |

| 881 | 9 | 18 | 1119 | 1129 | -10 | 1339 | 1333 | YX | 1334 | N112HQ | LGA | AVL | 99 | 599 | 11 | 29 | 2023-09-18 11:00:00 | Other |

| 892 | 2 | 19 | 1052 | 1100 | -8 | 1352 | 1418 | B6 | 890 | N821JB | JFK | MIA | 150 | 1089 | 11 | 0 | 2023-02-19 11:00:00 | MIA |

| 896 | 1 | 29 | 1252 | 1300 | -8 | 1448 | 1507 | AA | 935 | N874NN | JFK | CLT | 88 | 541 | 13 | 0 | 2023-01-29 13:00:00 | CLT |

| 900 | 12 | 13 | 1720 | 1730 | -10 | 1937 | 1959 | 9E | 1630 | N491PX | LGA | CVG | 103 | 585 | 17 | 30 | 2023-12-13 17:00:00 | Other |

| 903 | 10 | 4 | 1717 | 1725 | -8 | 1915 | 1934 | NK | 246 | N664NK | EWR | IND | 94 | 645 | 17 | 25 | 2023-10-04 17:00:00 | Other |

| 909 | 11 | 14 | 553 | 600 | -7 | 710 | 719 | UA | 420 | N27255 | EWR | IAD | 47 | 212 | 6 | 0 | 2023-11-14 06:00:00 | Other |

| 922 | 2 | 7 | 1446 | 1455 | -9 | 1624 | 1630 | 9E | 1440 | N272PQ | JFK | RIC | 61 | 288 | 14 | 55 | 2023-02-07 14:00:00 | Other |

| 927 | 1 | 2 | 1542 | 1550 | -8 | 1632 | 1659 | 9E | 1551 | N606LR | LGA | ALB | 30 | 136 | 15 | 50 | 2023-01-02 15:00:00 | Other |

| 929 | 9 | 5 | 2157 | 2210 | -13 | 24 | 33 | NK | 253 | N954NK | EWR | LAS | 295 | 2227 | 22 | 10 | 2023-09-05 22:00:00 | Other |

| 930 | 11 | 9 | 651 | 700 | -9 | 1035 | 1024 | AS | 12 | N928AK | JFK | SFO | 360 | 2586 | 7 | 0 | 2023-11-09 07:00:00 | Other |

| 934 | 10 | 30 | 930 | 941 | -11 | 1125 | 1136 | DL | 936 | N927AT | EWR | DTW | 95 | 488 | 9 | 41 | 2023-10-30 09:00:00 | Other |

| 940 | 3 | 20 | 953 | 959 | -6 | 1230 | 1221 | 9E | 1481 | N187GJ | JFK | SAV | 126 | 718 | 9 | 59 | 2023-03-20 09:00:00 | Other |

| 941 | 6 | 7 | 751 | 800 | -9 | 954 | 1018 | B6 | 332 | N307JB | JFK | SAV | 106 | 718 | 8 | 0 | 2023-06-07 08:00:00 | Other |

| 944 | 9 | 26 | 1125 | 1131 | -6 | 1310 | 1332 | AA | 942 | N971AN | JFK | CLT | 85 | 541 | 11 | 31 | 2023-09-26 11:00:00 | CLT |

| 945 | 6 | 20 | 918 | 926 | -8 | 1050 | 1055 | YX | 1161 | N865RW | EWR | PWM | 56 | 284 | 9 | 26 | 2023-06-20 09:00:00 | Other |

| 952 | 6 | 23 | 622 | 630 | -8 | 917 | 940 | B6 | 5 | N992JB | JFK | SFO | 338 | 2586 | 6 | 30 | 2023-06-23 06:00:00 | Other |

| 954 | 10 | 14 | 1247 | 1255 | -8 | 1438 | 1432 | 9E | 1595 | N319PQ | LGA | BNA | 127 | 764 | 12 | 55 | 2023-10-14 12:00:00 | Other |

| 958 | 11 | 25 | 1723 | 1730 | -7 | 2120 | 2109 | DL | 292 | N704X | JFK | SFO | 348 | 2586 | 17 | 30 | 2023-11-25 17:00:00 | Other |

| 973 | 4 | 23 | 1619 | 1629 | -10 | 1740 | 1804 | YX | 1161 | N872RW | LGA | CHO | 55 | 305 | 16 | 29 | 2023-04-23 16:00:00 | Other |

| 977 | 6 | 1 | 643 | 650 | -7 | 923 | 955 | AA | 951 | N867NN | LGA | MIA | 141 | 1096 | 6 | 50 | 2023-06-01 06:00:00 | MIA |

| 982 | 9 | 16 | 721 | 730 | -9 | 925 | 955 | DL | 188 | N3738B | LGA | DEN | 212 | 1620 | 7 | 30 | 2023-09-16 07:00:00 | Other |

| 985 | 4 | 9 | 849 | 900 | -11 | 1007 | 1038 | B6 | 701 | N274JB | LGA | BNA | 115 | 764 | 9 | 0 | 2023-04-09 09:00:00 | Other |

| 992 | 9 | 2 | 1449 | 1459 | -10 | 1701 | 1717 | 9E | 1541 | N309PQ | JFK | CVG | 87 | 589 | 14 | 59 | 2023-09-02 14:00:00 | Other |

| 996 | 10 | 17 | 702 | 710 | -8 | 1005 | 1008 | UA | 782 | N47512 | EWR | PBI | 146 | 1023 | 7 | 10 | 2023-10-17 07:00:00 | Other |

| 1002 | 1 | 4 | 847 | 855 | -8 | 1128 | 1143 | YX | 1797 | N212JQ | JFK | JAX | 125 | 828 | 8 | 55 | 2023-01-04 08:00:00 | Other |

| 1003 | 11 | 6 | 1220 | 1230 | -10 | 1358 | 1403 | YX | 1785 | N239JQ | LGA | MKE | 130 | 738 | 12 | 30 | 2023-11-06 12:00:00 | Other |

| 1011 | 4 | 25 | 2124 | 2130 | -6 | 2300 | 2309 | 9E | 1199 | N181PQ | JFK | RIC | 57 | 288 | 21 | 30 | 2023-04-25 21:00:00 | Other |

| 1012 | 11 | 11 | 753 | 800 | -7 | 849 | 922 | 9E | 1552 | N330PQ | JFK | BWI | 36 | 184 | 8 | 0 | 2023-11-11 08:00:00 | Other |

| 1016 | 12 | 30 | 1152 | 1200 | -8 | 1251 | 1325 | YX | 1857 | N245JQ | LGA | BOS | 39 | 184 | 12 | 0 | 2023-12-30 12:00:00 | BOS |

| 1030 | 5 | 3 | 1153 | 1159 | -6 | 1446 | 1510 | UA | 161 | N405UA | EWR | FLL | 155 | 1065 | 11 | 59 | 2023-05-03 11:00:00 | FLL |

| 1032 | 3 | 25 | 1820 | 1830 | -10 | 2005 | 2003 | YX | 1325 | N439YX | JFK | ORF | 66 | 290 | 18 | 30 | 2023-03-25 18:00:00 | Other |

| 1037 | 1 | 1 | 1547 | 1559 | -12 | 1847 | 1913 | B6 | 868 | N998JE | JFK | PBI | 149 | 1028 | 15 | 59 | 2023-01-01 15:00:00 | Other |

| 1038 | 12 | 2 | 719 | 730 | -11 | 927 | 947 | DL | 736 | N328NB | LGA | CHS | 104 | 641 | 7 | 30 | 2023-12-02 07:00:00 | Other |

| 1039 | 10 | 4 | 554 | 600 | -6 | 724 | 751 | DL | 368 | N105DX | LGA | DTW | 74 | 502 | 6 | 0 | 2023-10-04 06:00:00 | Other |

| 1049 | 8 | 25 | 1122 | 1130 | -8 | 1406 | 1435 | AA | 94 | N109NN | JFK | LAX | 310 | 2475 | 11 | 30 | 2023-08-25 11:00:00 | LAX |

| 1054 | 2 | 5 | 909 | 915 | -6 | 1020 | 1024 | B6 | 858 | N266JB | LGA | BOS | 50 | 184 | 9 | 15 | 2023-02-05 09:00:00 | BOS |

| 1058 | 12 | 7 | 1321 | 1333 | -12 | 1429 | 1445 | UA | 383 | N493UA | EWR | BOS | 42 | 200 | 13 | 33 | 2023-12-07 13:00:00 | BOS |

| 1062 | 4 | 7 | 1404 | 1410 | -6 | 1647 | 1656 | UA | 372 | N37277 | EWR | MCO | 138 | 937 | 14 | 10 | 2023-04-07 14:00:00 | MCO |

| 1064 | 9 | 27 | 554 | 600 | -6 | 752 | 751 | DL | 392 | N372DN | LGA | DTW | 79 | 502 | 6 | 0 | 2023-09-27 06:00:00 | Other |

| 1069 | 1 | 21 | 1055 | 1106 | -11 | 1217 | 1242 | UA | 850 | N444UA | EWR | BNA | 126 | 748 | 11 | 6 | 2023-01-21 11:00:00 | Other |

| 1075 | 6 | 30 | 724 | 730 | -6 | 857 | 925 | 9E | 1497 | N920XJ | LGA | GSO | 70 | 461 | 7 | 30 | 2023-06-30 07:00:00 | Other |

| 1080 | 11 | 22 | 1940 | 1950 | -10 | 2227 | 2216 | 9E | 1623 | N905XJ | LGA | CHS | 93 | 641 | 19 | 50 | 2023-11-22 19:00:00 | Other |

| 1081 | 9 | 3 | 1014 | 1030 | -16 | 1107 | 1139 | B6 | 972 | N318JB | LGA | HYA | 35 | 197 | 10 | 30 | 2023-09-03 10:00:00 | Other |

| 1090 | 7 | 31 | 1323 | 1330 | -7 | 1547 | 1543 | YX | 1091 | N871RW | LGA | IND | 120 | 660 | 13 | 30 | 2023-07-31 13:00:00 | Other |

| 1098 | 5 | 6 | 1538 | 1546 | -8 | 1725 | 1729 | YX | 1252 | N132HQ | JFK | DCA | 53 | 213 | 15 | 46 | 2023-05-06 15:00:00 | Other |

| 1103 | 10 | 4 | 722 | 729 | -7 | 946 | 1024 | UA | 922 | N17752 | LGA | IAH | 179 | 1416 | 7 | 29 | 2023-10-04 07:00:00 | Other |

| 1106 | 8 | 9 | 1649 | 1655 | -6 | 2014 | 2026 | AA | 46 | N103NN | JFK | SFO | 349 | 2586 | 16 | 55 | 2023-08-09 16:00:00 | Other |

| 1107 | 2 | 21 | 1704 | 1712 | -8 | 1903 | 1908 | YX | 984 | N644RW | EWR | GSO | 71 | 445 | 17 | 12 | 2023-02-21 17:00:00 | Other |

| 1130 | 11 | 1 | 1507 | 1517 | -10 | 1813 | 1830 | NK | 588 | N673NK | LGA | FLL | 153 | 1076 | 15 | 17 | 2023-11-01 15:00:00 | FLL |

| 1133 | 6 | 16 | 913 | 920 | -7 | 1107 | 1119 | 9E | 1666 | N136EV | LGA | ILM | 71 | 500 | 9 | 20 | 2023-06-16 09:00:00 | Other |

| 1134 | 8 | 19 | 833 | 840 | -7 | 1137 | 1140 | DL | 290 | N529DT | JFK | SAN | 301 | 2446 | 8 | 40 | 2023-08-19 08:00:00 | Other |

| 1139 | 12 | 11 | 1650 | 1659 | -9 | 1754 | 1821 | YX | 1138 | N746YX | EWR | BTV | 44 | 266 | 16 | 59 | 2023-12-11 16:00:00 | Other |

| 1145 | 6 | 16 | 755 | 803 | -8 | 1040 | 1046 | B6 | 355 | N591JB | EWR | MCO | 130 | 937 | 8 | 3 | 2023-06-16 08:00:00 | MCO |

| 1147 | 11 | 15 | 2153 | 2159 | -6 | 127 | 139 | B6 | 923 | N962JT | JFK | SFO | 372 | 2586 | 21 | 59 | 2023-11-15 21:00:00 | Other |

| 1148 | 11 | 1 | 2050 | 2059 | -9 | 2300 | 2255 | YX | 1244 | N447YX | JFK | RDU | 76 | 427 | 20 | 59 | 2023-11-01 20:00:00 | Other |

| 1152 | 10 | 15 | 1153 | 1159 | -6 | 1308 | 1317 | UA | 419 | N495UA | EWR | PWM | 57 | 284 | 11 | 59 | 2023-10-15 11:00:00 | Other |

| 1156 | 11 | 26 | 1022 | 1030 | -8 | 1234 | 1253 | YX | 1326 | N413YX | LGA | GSP | 105 | 610 | 10 | 30 | 2023-11-26 10:00:00 | Other |

| 1157 | 7 | 24 | 752 | 759 | -7 | 1001 | 1013 | YX | 866 | N724YX | EWR | GRR | 94 | 605 | 7 | 59 | 2023-07-24 07:00:00 | Other |

| 1164 | 12 | 22 | 1124 | 1130 | -6 | 1232 | 1256 | YX | 1038 | N761YX | EWR | ROC | 45 | 246 | 11 | 30 | 2023-12-22 11:00:00 | Other |

| 1166 | 9 | 15 | 836 | 845 | -9 | 1132 | 1151 | YX | 1308 | N411YX | LGA | IAH | 209 | 1416 | 8 | 45 | 2023-09-15 08:00:00 | Other |

| 1167 | 3 | 21 | 1109 | 1115 | -6 | 1216 | 1229 | B6 | 245 | N281JB | LGA | BOS | 44 | 184 | 11 | 15 | 2023-03-21 11:00:00 | BOS |

| 1186 | 1 | 10 | 1119 | 1130 | -11 | 1311 | 1352 | AA | 108 | N354PT | LGA | CLT | 85 | 544 | 11 | 30 | 2023-01-10 11:00:00 | CLT |

| 1187 | 7 | 6 | 1508 | 1515 | -7 | 1635 | 1636 | YX | 1367 | N880RW | LGA | ACK | 44 | 202 | 15 | 15 | 2023-07-06 15:00:00 | Other |

| 1194 | 7 | 6 | 958 | 1005 | -7 | 1311 | 1305 | DL | 236 | N177DN | JFK | LAX | 331 | 2475 | 10 | 5 | 2023-07-06 10:00:00 | LAX |

| 1203 | 2 | 1 | 1518 | 1530 | -12 | 1701 | 1712 | B6 | 282 | N3118J | JFK | MKE | 145 | 745 | 15 | 30 | 2023-02-01 15:00:00 | Other |

| 1205 | 1 | 29 | 954 | 1000 | -6 | 1616 | 1605 | HA | 22 | N391HA | JFK | HNL | 650 | 4983 | 10 | 0 | 2023-01-29 10:00:00 | Other |

| 1211 | 8 | 28 | 2112 | 2120 | -8 | 2222 | 2246 | YX | 1389 | N244JQ | LGA | BUF | 49 | 292 | 21 | 20 | 2023-08-28 21:00:00 | Other |

| 1215 | 1 | 26 | 950 | 1000 | -10 | 1311 | 1316 | UA | 779 | N474UA | LGA | IAH | 234 | 1416 | 10 | 0 | 2023-01-26 10:00:00 | Other |

| 1216 | 6 | 3 | 712 | 720 | -8 | 907 | 934 | UA | 249 | N12238 | LGA | DEN | 207 | 1620 | 7 | 20 | 2023-06-03 07:00:00 | Other |

| 1220 | 6 | 9 | 1729 | 1735 | -6 | 1930 | 1938 | YX | 1824 | N240JQ | LGA | CMH | 70 | 479 | 17 | 35 | 2023-06-09 17:00:00 | Other |

| 1221 | 8 | 29 | 833 | 846 | -13 | 1041 | 1050 | UA | 319 | N38467 | EWR | MYR | 84 | 550 | 8 | 46 | 2023-08-29 08:00:00 | Other |

| 1223 | 2 | 12 | 1718 | 1729 | -11 | 1939 | 2020 | UA | 820 | N67134 | EWR | LAS | 283 | 2227 | 17 | 29 | 2023-02-12 17:00:00 | Other |

| 1226 | 5 | 28 | 1108 | 1115 | -7 | 1359 | 1423 | DL | 532 | N117DX | JFK | FLL | 143 | 1069 | 11 | 15 | 2023-05-28 11:00:00 | FLL |

| 1227 | 4 | 28 | 752 | 800 | -8 | 907 | 919 | AA | 683 | N768US | LGA | DCA | 47 | 214 | 8 | 0 | 2023-04-28 08:00:00 | Other |

| 1230 | 3 | 2 | 1245 | 1254 | -9 | 1417 | 1423 | YX | 1068 | N731YX | EWR | PIT | 74 | 319 | 12 | 54 | 2023-03-02 12:00:00 | Other |

| 1235 | 7 | 21 | 658 | 705 | -7 | 1004 | 1007 | DL | 310 | N330NB | LGA | PBI | 140 | 1035 | 7 | 5 | 2023-07-21 07:00:00 | Other |

| 1237 | 12 | 29 | 1722 | 1730 | -8 | 1845 | 1916 | 9E | 1552 | N298PQ | LGA | MKE | 101 | 738 | 17 | 30 | 2023-12-29 17:00:00 | Other |

| 1239 | 2 | 26 | 554 | 600 | -6 | 817 | 838 | UA | 429 | N68817 | EWR | DEN | 246 | 1605 | 6 | 0 | 2023-02-26 06:00:00 | Other |

| 1240 | 2 | 10 | 1533 | 1543 | -10 | 1738 | 1754 | NK | 501 | N522NK | LGA | CLT | 96 | 544 | 15 | 43 | 2023-02-10 15:00:00 | CLT |

| 1244 | 11 | 26 | 1142 | 1150 | -8 | 1428 | 1444 | DL | 351 | N517DN | JFK | LAS | 314 | 2248 | 11 | 50 | 2023-11-26 11:00:00 | Other |

| 1245 | 1 | 31 | 1519 | 1530 | -11 | 1841 | 1850 | B6 | 604 | N564JB | EWR | MIA | 158 | 1085 | 15 | 30 | 2023-01-31 15:00:00 | MIA |

| 1246 | 6 | 17 | 1054 | 1100 | -6 | 1246 | 1253 | YX | 1292 | N101HQ | JFK | CLE | 79 | 425 | 11 | 0 | 2023-06-17 11:00:00 | Other |

| 1250 | 5 | 6 | 952 | 959 | -7 | 1138 | 1203 | AA | 744 | N850NN | LGA | CLT | 78 | 544 | 9 | 59 | 2023-05-06 09:00:00 | CLT |

| 1252 | 1 | 12 | 758 | 805 | -7 | 1019 | 1040 | DL | 1002 | N392DA | EWR | ATL | 114 | 746 | 8 | 5 | 2023-01-12 08:00:00 | ATL |

| 1254 | 7 | 14 | 953 | 1000 | -7 | 1143 | 1155 | YX | 936 | N647RW | EWR | GSO | 90 | 445 | 10 | 0 | 2023-07-14 10:00:00 | Other |

| 1257 | 9 | 15 | 2049 | 2059 | -10 | 2307 | 2323 | B6 | 919 | N594JB | LGA | MSY | 150 | 1183 | 20 | 59 | 2023-09-15 20:00:00 | Other |

| 1264 | 8 | 10 | 959 | 1005 | -6 | 1107 | 1142 | UA | 561 | N408UA | LGA | ORD | 105 | 733 | 10 | 5 | 2023-08-10 10:00:00 | ORD |

| 1269 | 5 | 26 | 1245 | 1259 | -14 | 1419 | 1446 | DL | 460 | N135DQ | LGA | ORD | 103 | 733 | 12 | 59 | 2023-05-26 12:00:00 | ORD |

| 1271 | 10 | 13 | 1048 | 1056 | -8 | 1354 | 1404 | DL | 983 | N102DU | LGA | SRQ | 151 | 1047 | 10 | 56 | 2023-10-13 10:00:00 | Other |

| 1273 | 10 | 27 | 909 | 915 | -6 | 1200 | 1228 | AA | 790 | N303RG | LGA | MIA | 141 | 1096 | 9 | 15 | 2023-10-27 09:00:00 | MIA |

| 1286 | 9 | 1 | 820 | 826 | -6 | 952 | 1008 | YX | 1365 | N435YX | LGA | CLE | 66 | 419 | 8 | 26 | 2023-09-01 08:00:00 | Other |

| 1289 | 8 | 10 | 552 | 600 | -8 | 842 | 909 | AA | 635 | N328RR | JFK | MIA | 143 | 1089 | 6 | 0 | 2023-08-10 06:00:00 | MIA |

| 1291 | 4 | 24 | 1206 | 1212 | -6 | 1327 | 1335 | 9E | 1192 | N299PQ | LGA | SYR | 40 | 198 | 12 | 12 | 2023-04-24 12:00:00 | Other |

| 1297 | 2 | 11 | 618 | 629 | -11 | 747 | 805 | UA | 606 | N881UA | LGA | ORD | 119 | 733 | 6 | 29 | 2023-02-11 06:00:00 | ORD |

| 1302 | 6 | 21 | 1041 | 1050 | -9 | 1154 | 1202 | YX | 1826 | N824MD | JFK | ACK | 36 | 199 | 10 | 50 | 2023-06-21 10:00:00 | Other |

| 1309 | 1 | 25 | 720 | 730 | -10 | 955 | 1008 | B6 | 528 | N273JB | JFK | JAX | 130 | 828 | 7 | 30 | 2023-01-25 07:00:00 | Other |

| 1317 | 3 | 13 | 952 | 1000 | -8 | 1205 | 1221 | UA | 508 | N873UA | EWR | SAV | 115 | 708 | 10 | 0 | 2023-03-13 10:00:00 | Other |

| 1320 | 10 | 13 | 652 | 700 | -8 | 943 | 952 | UA | 391 | N875UA | EWR | SRQ | 150 | 1034 | 7 | 0 | 2023-10-13 07:00:00 | Other |

| 1322 | 2 | 8 | 1221 | 1230 | -9 | 1405 | 1417 | YX | 1568 | N242JQ | LGA | BNA | 121 | 764 | 12 | 30 | 2023-02-08 12:00:00 | Other |

| 1327 | 7 | 20 | 938 | 945 | -7 | 1057 | 1115 | 9E | 1197 | N600LR | JFK | DCA | 50 | 213 | 9 | 45 | 2023-07-20 09:00:00 | Other |

| 1341 | 5 | 8 | 2020 | 2029 | -9 | 2331 | 2345 | AA | 749 | N865NN | LGA | MIA | 151 | 1096 | 20 | 29 | 2023-05-08 20:00:00 | MIA |

| 1342 | 10 | 23 | 1034 | 1040 | -6 | 1238 | 1313 | YX | 1828 | N218JQ | LGA | IND | 94 | 660 | 10 | 40 | 2023-10-23 10:00:00 | Other |

| 1343 | 4 | 23 | 1011 | 1020 | -9 | 1154 | 1221 | YX | 1205 | N414YX | JFK | RDU | 73 | 427 | 10 | 20 | 2023-04-23 10:00:00 | Other |

| 1349 | 7 | 7 | 552 | 600 | -8 | 707 | 732 | UA | 323 | N37456 | EWR | ORD | 112 | 719 | 6 | 0 | 2023-07-07 06:00:00 | ORD |

| 1357 | 3 | 20 | 759 | 810 | -11 | 1005 | 1028 | YX | 1397 | N129HQ | LGA | CVG | 100 | 585 | 8 | 10 | 2023-03-20 08:00:00 | Other |

| 1359 | 7 | 5 | 639 | 645 | -6 | 935 | 953 | UA | 244 | N431UA | EWR | FLL | 150 | 1065 | 6 | 45 | 2023-07-05 06:00:00 | FLL |

| 1368 | 3 | 17 | 1652 | 1659 | -7 | 1854 | 1850 | YX | 1367 | N117HQ | LGA | GSO | 86 | 461 | 16 | 59 | 2023-03-17 16:00:00 | Other |

| 1374 | 9 | 15 | 1352 | 1400 | -8 | 1534 | 1527 | YX | 1177 | N638RW | EWR | MKE | 101 | 725 | 14 | 0 | 2023-09-15 14:00:00 | Other |

| 1386 | 1 | 6 | 1210 | 1217 | -7 | 1312 | 1339 | YX | 1171 | N723YX | EWR | PWM | 47 | 284 | 12 | 17 | 2023-01-06 12:00:00 | Other |

| 1387 | 4 | 27 | 551 | 600 | -9 | 751 | 755 | DL | 346 | N313DN | LGA | DTW | 86 | 502 | 6 | 0 | 2023-04-27 06:00:00 | Other |

| 1403 | 9 | 7 | 1345 | 1354 | -9 | 1618 | 1612 | 9E | 1636 | N307PQ | LGA | TYS | 111 | 647 | 13 | 54 | 2023-09-07 13:00:00 | Other |

| 1405 | 7 | 24 | 1340 | 1347 | -7 | 1449 | 1453 | YX | 923 | N724YX | EWR | PVD | 35 | 160 | 13 | 47 | 2023-07-24 13:00:00 | Other |

| 1406 | 4 | 3 | 852 | 900 | -8 | 1008 | 1030 | 9E | 1357 | N138EV | LGA | PWM | 45 | 269 | 9 | 0 | 2023-04-03 09:00:00 | Other |

| 1408 | 6 | 12 | 738 | 745 | -7 | 858 | 917 | YX | 1404 | N409YX | LGA | ORF | 55 | 296 | 7 | 45 | 2023-06-12 07:00:00 | Other |

| 1409 | 11 | 29 | 1222 | 1230 | -8 | 1340 | 1400 | YX | 1077 | N757YX | EWR | PIT | 62 | 319 | 12 | 30 | 2023-11-29 12:00:00 | Other |

| 1414 | 1 | 6 | 622 | 630 | -8 | 836 | 907 | B6 | 806 | N649JB | JFK | ATL | 112 | 760 | 6 | 30 | 2023-01-06 06:00:00 | ATL |

| 1416 | 3 | 19 | 1434 | 1445 | -11 | 1626 | 1646 | YX | 1388 | N114HQ | JFK | CMH | 81 | 483 | 14 | 45 | 2023-03-19 14:00:00 | Other |

| 1419 | 9 | 26 | 1750 | 1800 | -10 | 2049 | 2100 | AA | 196 | N895NN | LGA | DFW | 187 | 1389 | 18 | 0 | 2023-09-26 18:00:00 | Other |

| 1427 | 4 | 16 | 749 | 800 | -11 | 848 | 920 | DL | 823 | N121DU | LGA | BOS | 34 | 184 | 8 | 0 | 2023-04-16 08:00:00 | BOS |

| 1428 | 2 | 14 | 1123 | 1130 | -7 | 1251 | 1308 | UA | 562 | N14228 | EWR | ORD | 119 | 719 | 11 | 30 | 2023-02-14 11:00:00 | ORD |

| 1433 | 3 | 4 | 2055 | 2105 | -10 | 10 | 2355 | NK | 275 | N956NK | EWR | LAS | 353 | 2227 | 21 | 5 | 2023-03-04 21:00:00 | Other |

| 1434 | 10 | 6 | 2024 | 2033 | -9 | 2222 | 2247 | 9E | 1637 | N915XJ | LGA | CAE | 88 | 617 | 20 | 33 | 2023-10-06 20:00:00 | Other |

| 1449 | 2 | 21 | 1124 | 1130 | -6 | 1322 | 1331 | YX | 1567 | N213JQ | LGA | CMH | 90 | 479 | 11 | 30 | 2023-02-21 11:00:00 | Other |

| 1454 | 5 | 26 | 558 | 604 | -6 | 803 | 812 | B6 | 31 | N715JB | JFK | MSY | 158 | 1182 | 6 | 4 | 2023-05-26 06:00:00 | Other |

| 1457 | 12 | 27 | 1244 | 1250 | -6 | 1427 | 1453 | YX | 1017 | N741YX | EWR | CMH | 79 | 463 | 12 | 50 | 2023-12-27 12:00:00 | Other |

| 1462 | 7 | 29 | 1623 | 1629 | -6 | 1854 | 1936 | AA | 91 | N103NN | JFK | LAX | 313 | 2475 | 16 | 29 | 2023-07-29 16:00:00 | LAX |

| 1470 | 5 | 1 | 854 | 900 | -6 | 1140 | 1202 | B6 | 338 | N258JB | JFK | PBI | 150 | 1028 | 9 | 0 | 2023-05-01 09:00:00 | Other |

| 1473 | 6 | 16 | 726 | 733 | -7 | 916 | 926 | UA | 498 | N27276 | EWR | CLT | 75 | 529 | 7 | 33 | 2023-06-16 07:00:00 | CLT |

| 1475 | 8 | 19 | 1552 | 1600 | -8 | 1715 | 1802 | 9E | 1141 | N319PQ | LGA | STL | 117 | 888 | 16 | 0 | 2023-08-19 16:00:00 | Other |

| 1481 | 11 | 11 | 1514 | 1525 | -11 | 1722 | 1741 | YX | 1140 | N752YX | EWR | GSP | 99 | 594 | 15 | 25 | 2023-11-11 15:00:00 | Other |

| 1490 | 12 | 24 | 2119 | 2129 | -10 | 2335 | 2357 | YX | 1022 | N752YX | EWR | GRR | 94 | 605 | 21 | 29 | 2023-12-24 21:00:00 | Other |

| 1497 | 4 | 14 | 1101 | 1115 | -14 | 1245 | 1305 | YX | 1218 | N821MD | LGA | ROA | 65 | 405 | 11 | 15 | 2023-04-14 11:00:00 | Other |

| 1499 | 1 | 27 | 734 | 740 | -6 | 1047 | 1122 | B6 | 6 | N988JT | JFK | SFO | 350 | 2586 | 7 | 40 | 2023-01-27 07:00:00 | Other |

| 1501 | 5 | 15 | 2122 | 2130 | -8 | 2333 | 13 | DL | 451 | N898DN | JFK | ATL | 104 | 760 | 21 | 30 | 2023-05-15 21:00:00 | ATL |

| 1503 | 10 | 17 | 1223 | 1229 | -6 | 1432 | 1443 | 9E | 1409 | N325PQ | LGA | CLT | 85 | 544 | 12 | 29 | 2023-10-17 12:00:00 | CLT |

| 1506 | 2 | 16 | 922 | 929 | -7 | 1020 | 1044 | YX | 1043 | N726YX | EWR | PVD | 36 | 160 | 9 | 29 | 2023-02-16 09:00:00 | Other |

| 1512 | 3 | 22 | 1202 | 1210 | -8 | 1347 | 1349 | YX | 1276 | N446YX | LGA | BNA | 127 | 764 | 12 | 10 | 2023-03-22 12:00:00 | Other |

| 1515 | 12 | 6 | 1547 | 1555 | -8 | 1834 | 1905 | B6 | 735 | N964JT | EWR | LAX | 323 | 2454 | 15 | 55 | 2023-12-06 15:00:00 | LAX |

| 1516 | 2 | 1 | 716 | 725 | -9 | 952 | 924 | AA | 270 | N987NN | LGA | ORD | 124 | 733 | 7 | 25 | 2023-02-01 07:00:00 | ORD |

| 1517 | 9 | 14 | 1050 | 1059 | -9 | 1243 | 1255 | YX | 1185 | N763YX | EWR | MEM | 149 | 946 | 10 | 59 | 2023-09-14 10:00:00 | Other |

| 1519 | 7 | 26 | 1050 | 1100 | -10 | 1300 | 1321 | YX | 1017 | N418YX | LGA | XNA | 149 | 1147 | 11 | 0 | 2023-07-26 11:00:00 | Other |

| 1528 | 8 | 31 | 2121 | 2129 | -8 | 2234 | 2254 | YX | 988 | N119HQ | LGA | RIC | 52 | 292 | 21 | 29 | 2023-08-31 21:00:00 | Other |

| 1530 | 8 | 2 | 1022 | 1030 | -8 | 1147 | 1215 | AA | 668 | N177XF | LGA | STL | 124 | 888 | 10 | 30 | 2023-08-02 10:00:00 | Other |

| 1537 | 11 | 1 | 1443 | 1453 | -10 | 1635 | 1653 | YX | 1398 | N430YX | JFK | CMH | 80 | 483 | 14 | 53 | 2023-11-01 14:00:00 | Other |

| 1539 | 5 | 31 | 1815 | 1825 | -10 | 1944 | 2025 | 9E | 1453 | N921XJ | LGA | MEM | 125 | 963 | 18 | 25 | 2023-05-31 18:00:00 | Other |

| 1545 | 1 | 24 | 1900 | 1915 | -15 | 2037 | 2105 | YX | 1881 | N244JQ | JFK | PIT | 69 | 340 | 19 | 15 | 2023-01-24 19:00:00 | Other |

| 1546 | 3 | 1 | 1653 | 1659 | -6 | 1850 | 1855 | YX | 1037 | N641RW | EWR | GSO | 80 | 445 | 16 | 59 | 2023-03-01 16:00:00 | Other |

| 1549 | 11 | 26 | 2154 | 2200 | -6 | 32 | 2318 | YX | 1255 | N104HQ | JFK | BOS | 59 | 187 | 22 | 0 | 2023-11-26 22:00:00 | BOS |

| 1560 | 12 | 16 | 920 | 930 | -10 | 1255 | 1256 | AS | 6 | N528AS | JFK | SEA | 342 | 2422 | 9 | 30 | 2023-12-16 09:00:00 | Other |

| 1564 | 9 | 21 | 620 | 630 | -10 | 733 | 801 | YX | 1329 | N418YX | LGA | ORF | 47 | 296 | 6 | 30 | 2023-09-21 06:00:00 | Other |

| 1565 | 5 | 27 | 1620 | 1629 | -9 | 1822 | 1851 | YX | 1261 | N411YX | JFK | CVG | 83 | 589 | 16 | 29 | 2023-05-27 16:00:00 | Other |

| 1567 | 12 | 11 | 1552 | 1559 | -7 | 1824 | 1848 | YX | 1221 | N127HQ | LGA | LIT | 171 | 1085 | 15 | 59 | 2023-12-11 15:00:00 | Other |

| 1568 | 10 | 31 | 1323 | 1329 | -6 | 1632 | 1634 | DL | 360 | N378DA | LGA | IAH | 224 | 1416 | 13 | 29 | 2023-10-31 13:00:00 | Other |

| 1569 | 11 | 17 | 1552 | 1559 | -7 | 1728 | 1750 | AA | 131 | N922NN | LGA | ORD | 115 | 733 | 15 | 59 | 2023-11-17 15:00:00 | ORD |

| 1573 | 2 | 2 | 1320 | 1329 | -9 | 1501 | 1503 | YX | 1574 | N217JQ | LGA | IAD | 50 | 229 | 13 | 29 | 2023-02-02 13:00:00 | Other |

| 1575 | 5 | 30 | 1152 | 1159 | -7 | 1431 | 1455 | UA | 821 | N76288 | EWR | TPA | 133 | 997 | 11 | 59 | 2023-05-30 11:00:00 | Other |

| 1580 | 2 | 8 | 1254 | 1300 | -6 | 1541 | 1619 | B6 | 964 | N806JB | JFK | MIA | 147 | 1089 | 13 | 0 | 2023-02-08 13:00:00 | MIA |

| 1581 | 5 | 31 | 1451 | 1500 | -9 | 1813 | 1807 | NK | 626 | N676NK | LGA | FLL | 175 | 1076 | 15 | 0 | 2023-05-31 15:00:00 | FLL |

| 1589 | 8 | 16 | 2150 | 2159 | -9 | 2237 | 2304 | 9E | 1190 | N324PQ | LGA | BDL | 20 | 101 | 21 | 59 | 2023-08-16 21:00:00 | Other |

| 1591 | 2 | 8 | 1020 | 1029 | -9 | 1227 | 1254 | YX | 1527 | N879RW | LGA | CLT | 92 | 544 | 10 | 29 | 2023-02-08 10:00:00 | CLT |

| 1594 | 9 | 27 | 1158 | 1210 | -12 | 1345 | 1359 | AA | 845 | N821AW | LGA | STL | 125 | 888 | 12 | 10 | 2023-09-27 12:00:00 | Other |

| 1602 | 8 | 5 | 2240 | 2250 | -10 | 6 | 37 | 9E | 1232 | N292PQ | JFK | ROC | 51 | 264 | 22 | 50 | 2023-08-05 22:00:00 | Other |

| 1612 | 5 | 28 | 2121 | 2127 | -6 | 2221 | 2240 | 9E | 1283 | N905XJ | LGA | SCE | 35 | 208 | 21 | 27 | 2023-05-28 21:00:00 | Other |

| 1613 | 2 | 18 | 749 | 755 | -6 | 1037 | 1104 | B6 | 180 | N566JB | LGA | PBI | 139 | 1035 | 7 | 55 | 2023-02-18 07:00:00 | Other |

| 1615 | 8 | 14 | 723 | 729 | -6 | 1025 | 1028 | AA | 3 | N107NN | JFK | LAX | 331 | 2475 | 7 | 29 | 2023-08-14 07:00:00 | LAX |

| 1622 | 8 | 2 | 849 | 855 | -6 | 1046 | 1049 | YX | 1044 | N127HQ | LGA | GSO | 71 | 461 | 8 | 55 | 2023-08-02 08:00:00 | Other |

| 1625 | 9 | 25 | 1004 | 1011 | -7 | 1235 | 1215 | UA | 507 | N16701 | EWR | CLT | 78 | 529 | 10 | 11 | 2023-09-25 10:00:00 | CLT |

| 1628 | 2 | 8 | 1108 | 1115 | -7 | 1322 | 1344 | YX | 1269 | N104HQ | JFK | IND | 114 | 665 | 11 | 15 | 2023-02-08 11:00:00 | Other |

| 1630 | 3 | 23 | 1857 | 1905 | -8 | 2107 | 2124 | 9E | 1569 | N325PQ | LGA | CHS | 92 | 641 | 19 | 5 | 2023-03-23 19:00:00 | Other |

| 1631 | 3 | 29 | 723 | 730 | -7 | 1104 | 1125 | B6 | 621 | N913JB | JFK | SJU | 196 | 1598 | 7 | 30 | 2023-03-29 07:00:00 | Other |

| 1633 | 1 | 26 | 1440 | 1449 | -9 | 1752 | 1750 | B6 | 656 | N907JB | EWR | MCO | 160 | 937 | 14 | 49 | 2023-01-26 14:00:00 | MCO |

| 1650 | 9 | 14 | 1613 | 1620 | -7 | 1717 | 1744 | YX | 1064 | N723YX | EWR | ROC | 43 | 246 | 16 | 20 | 2023-09-14 16:00:00 | Other |

| 1659 | 8 | 23 | 922 | 930 | -8 | 1144 | 1223 | AS | 15 | N948AK | JFK | SAN | 299 | 2446 | 9 | 30 | 2023-08-23 09:00:00 | Other |

| 1676 | 3 | 8 | 2052 | 2100 | -8 | 2232 | 2311 | YX | 1241 | N450YX | JFK | CMH | 81 | 483 | 21 | 0 | 2023-03-08 21:00:00 | Other |

| 1680 | 6 | 30 | 1103 | 1110 | -7 | 1223 | 1240 | YX | 1403 | N116HQ | JFK | ORF | 55 | 290 | 11 | 10 | 2023-06-30 11:00:00 | Other |

| 1685 | 12 | 2 | 2006 | 2012 | -6 | 2319 | 2320 | NK | 156 | N685NK | LGA | MCO | 141 | 950 | 20 | 12 | 2023-12-02 20:00:00 | MCO |

| 1686 | 12 | 14 | 1825 | 1835 | -10 | 1950 | 2014 | YX | 1140 | N756YX | EWR | PIT | 54 | 319 | 18 | 35 | 2023-12-14 18:00:00 | Other |

| 1687 | 11 | 12 | 653 | 659 | -6 | 951 | 1021 | AA | 536 | N849NN | LGA | MIA | 158 | 1096 | 6 | 59 | 2023-11-12 06:00:00 | MIA |

| 1708 | 4 | 13 | 1211 | 1221 | -10 | 1334 | 1358 | YX | 1258 | N138HQ | LGA | PIT | 57 | 335 | 12 | 21 | 2023-04-13 12:00:00 | Other |

| 1712 | 8 | 23 | 1254 | 1300 | -6 | 1552 | 1601 | UA | 87 | N439UA | EWR | RSW | 142 | 1068 | 13 | 0 | 2023-08-23 13:00:00 | Other |

| 1715 | 2 | 20 | 717 | 729 | -12 | 841 | 856 | YX | 1152 | N863RW | EWR | BUF | 58 | 282 | 7 | 29 | 2023-02-20 07:00:00 | Other |

| 1717 | 10 | 22 | 1138 | 1145 | -7 | 1217 | 1247 | YX | 1162 | N758YX | EWR | PHL | 19 | 80 | 11 | 45 | 2023-10-22 11:00:00 | Other |

| 1719 | 11 | 10 | 1650 | 1659 | -9 | 1926 | 1949 | B6 | 922 | N516JB | LGA | ATL | 119 | 762 | 16 | 59 | 2023-11-10 16:00:00 | ATL |

| 1720 | 5 | 10 | 1311 | 1319 | -8 | 1416 | 1434 | YX | 1093 | N862RW | EWR | MHT | 46 | 209 | 13 | 19 | 2023-05-10 13:00:00 | Other |

| 1722 | 11 | 9 | 1320 | 1328 | -8 | 1512 | 1543 | YX | 1906 | N238JQ | LGA | CLT | 89 | 544 | 13 | 28 | 2023-11-09 13:00:00 | CLT |

| 1729 | 12 | 17 | 757 | 803 | -6 | 1140 | 1113 | UA | 665 | N27520 | EWR | FLL | 190 | 1065 | 8 | 3 | 2023-12-17 08:00:00 | FLL |

| 1731 | 5 | 12 | 713 | 720 | -7 | 849 | 914 | YX | 1595 | N818MD | LGA | GSO | 68 | 461 | 7 | 20 | 2023-05-12 07:00:00 | Other |

| 1733 | 7 | 27 | 624 | 630 | -6 | 813 | 815 | 9E | 1288 | N917XJ | LGA | CLE | 74 | 419 | 6 | 30 | 2023-07-27 06:00:00 | Other |

| 1752 | 5 | 25 | 1051 | 1059 | -8 | 1239 | 1301 | NK | 629 | N678NK | LGA | DTW | 83 | 502 | 10 | 59 | 2023-05-25 10:00:00 | Other |

| 1753 | 6 | 14 | 1653 | 1659 | -6 | 2016 | 2030 | AA | 53 | N108NN | JFK | SFO | 342 | 2586 | 16 | 59 | 2023-06-14 16:00:00 | Other |

| 1757 | 9 | 16 | 1417 | 1425 | -8 | 1700 | 1723 | UA | 587 | N27277 | EWR | IAH | 190 | 1400 | 14 | 25 | 2023-09-16 14:00:00 | Other |

| 1762 | 9 | 1 | 949 | 959 | -10 | 1144 | 1154 | YX | 1847 | N810MD | JFK | CMH | 72 | 483 | 9 | 59 | 2023-09-01 09:00:00 | Other |

| 1764 | 12 | 8 | 756 | 805 | -9 | 915 | 928 | AA | 893 | N801AW | LGA | DCA | 51 | 214 | 8 | 5 | 2023-12-08 08:00:00 | Other |

| 1776 | 11 | 18 | 1550 | 1600 | -10 | 1807 | 1841 | YX | 1375 | N121HQ | LGA | SDF | 96 | 659 | 16 | 0 | 2023-11-18 16:00:00 | Other |

| 1779 | 10 | 10 | 550 | 600 | -10 | 841 | 902 | B6 | 462 | N665JB | LGA | FLL | 142 | 1076 | 6 | 0 | 2023-10-10 06:00:00 | FLL |

| 1783 | 3 | 22 | 1053 | 1059 | -6 | 1241 | 1303 | YX | 1036 | N979RP | EWR | CMH | 81 | 463 | 10 | 59 | 2023-03-22 10:00:00 | Other |

| 1789 | 4 | 21 | 1252 | 1259 | -7 | 1407 | 1433 | 9E | 1351 | N923XJ | JFK | BUF | 50 | 301 | 12 | 59 | 2023-04-21 12:00:00 | Other |

| 1795 | 11 | 5 | 1819 | 1825 | -6 | 2042 | 2105 | YX | 1798 | N233JQ | LGA | SDF | 101 | 659 | 18 | 25 | 2023-11-05 18:00:00 | Other |

| 1797 | 8 | 21 | 2002 | 2011 | -9 | 2126 | 2151 | YX | 1038 | N402YX | LGA | PIT | 51 | 335 | 20 | 11 | 2023-08-21 20:00:00 | Other |

| 1801 | 8 | 3 | 1453 | 1500 | -7 | 1655 | 1707 | B6 | 302 | N348JB | JFK | DTW | 87 | 509 | 15 | 0 | 2023-08-03 15:00:00 | Other |

| 1803 | 3 | 15 | 752 | 800 | -8 | 1129 | 1159 | B6 | 193 | N2044J | JFK | SJU | 198 | 1598 | 8 | 0 | 2023-03-15 08:00:00 | Other |

| 1812 | 9 | 4 | 804 | 810 | -6 | 951 | 951 | 9E | 1568 | N296PQ | JFK | RIC | 60 | 288 | 8 | 10 | 2023-09-04 08:00:00 | Other |

| 1815 | 11 | 27 | 1749 | 1759 | -10 | 2109 | 2115 | AA | 649 | N896NN | LGA | DFW | 222 | 1389 | 17 | 59 | 2023-11-27 17:00:00 | Other |

| 1816 | 12 | 16 | 1051 | 1059 | -8 | 1239 | 1322 | 9E | 1349 | N912XJ | LGA | DSM | 147 | 1031 | 10 | 59 | 2023-12-16 10:00:00 | Other |

| 1819 | 10 | 25 | 1730 | 1740 | -10 | 1917 | 1940 | 9E | 1458 | N146PQ | LGA | MEM | 139 | 963 | 17 | 40 | 2023-10-25 17:00:00 | Other |

| 1823 | 12 | 3 | 553 | 600 | -7 | 831 | 833 | UA | 371 | N17279 | EWR | ATL | 129 | 746 | 6 | 0 | 2023-12-03 06:00:00 | ATL |

| 1831 | 11 | 25 | 917 | 927 | -10 | 1049 | 1123 | 9E | 1756 | N917XJ | LGA | BHM | 130 | 866 | 9 | 27 | 2023-11-25 09:00:00 | Other |

| 1853 | 5 | 5 | 554 | 600 | -6 | 652 | 715 | YX | 1622 | N231JQ | LGA | BOS | 35 | 184 | 6 | 0 | 2023-05-05 06:00:00 | BOS |

| 1855 | 5 | 18 | 1151 | 1200 | -9 | 1243 | 1320 | YX | 1301 | N421YX | JFK | ORH | 31 | 150 | 12 | 0 | 2023-05-18 12:00:00 | Other |

| 1858 | 3 | 28 | 1135 | 1145 | -10 | 1502 | 1504 | DL | 654 | N128DU | LGA | IAH | 227 | 1416 | 11 | 45 | 2023-03-28 11:00:00 | Other |

| 1860 | 6 | 26 | 1120 | 1130 | -10 | 1323 | 1239 | YX | 1375 | N113HQ | JFK | ORH | 31 | 150 | 11 | 30 | 2023-06-26 11:00:00 | Other |

| 1861 | 11 | 2 | 802 | 810 | -8 | 1034 | 1049 | B6 | 188 | N564JB | JFK | ATL | 116 | 760 | 8 | 10 | 2023-11-02 08:00:00 | ATL |

| 1862 | 1 | 10 | 1443 | 1455 | -12 | 1631 | 1710 | AA | 756 | N546UW | LGA | CLT | 84 | 544 | 14 | 55 | 2023-01-10 14:00:00 | CLT |

| 1864 | 9 | 15 | 1648 | 1655 | -7 | 1944 | 2008 | B6 | 298 | N961JT | JFK | LAX | 321 | 2475 | 16 | 55 | 2023-09-15 16:00:00 | LAX |

| 1869 | 6 | 21 | 1206 | 1215 | -9 | 1405 | 1419 | YX | 1382 | N433YX | LGA | DTW | 84 | 502 | 12 | 15 | 2023-06-21 12:00:00 | Other |

| 1871 | 12 | 23 | 953 | 959 | -6 | 1140 | 1207 | 9E | 1455 | N325PQ | JFK | CLE | 73 | 425 | 9 | 59 | 2023-12-23 09:00:00 | Other |

| 1872 | 4 | 24 | 1614 | 1620 | -6 | 1912 | 1911 | UA | 123 | N19130 | EWR | MCO | 155 | 937 | 16 | 20 | 2023-04-24 16:00:00 | MCO |

| 1879 | 11 | 2 | 1124 | 1133 | -9 | 1224 | 1244 | YX | 1373 | N131HQ | JFK | ORH | 32 | 150 | 11 | 33 | 2023-11-02 11:00:00 | Other |

| 1880 | 1 | 1 | 1519 | 1526 | -7 | 1728 | 1722 | YX | 1436 | N431YX | JFK | RDU | 80 | 427 | 15 | 26 | 2023-01-01 15:00:00 | Other |

| 1882 | 1 | 13 | 1144 | 1150 | -6 | 1234 | 1303 | YX | 1749 | N229JQ | LGA | BDL | 26 | 101 | 11 | 50 | 2023-01-13 11:00:00 | Other |

| 1887 | 2 | 6 | 1520 | 1529 | -9 | 1742 | 1800 | YX | 1222 | N413YX | JFK | IND | 101 | 665 | 15 | 29 | 2023-02-06 15:00:00 | Other |

| 1888 | 9 | 28 | 1919 | 1929 | -10 | 2113 | 2126 | YX | 1390 | N869RW | LGA | CMH | 80 | 479 | 19 | 29 | 2023-09-28 19:00:00 | Other |

| 1894 | 3 | 19 | 739 | 746 | -7 | 1006 | 1009 | YX | 1124 | N857RW | EWR | IND | 114 | 645 | 7 | 46 | 2023-03-19 07:00:00 | Other |

| 1897 | 7 | 15 | 924 | 930 | -6 | 1220 | 1243 | B6 | 72 | N640JB | LGA | FLL | 147 | 1076 | 9 | 30 | 2023-07-15 09:00:00 | FLL |

| 1898 | 8 | 16 | 1915 | 1929 | -14 | 2109 | 2142 | YX | 1043 | N418YX | LGA | CVG | 92 | 585 | 19 | 29 | 2023-08-16 19:00:00 | Other |

| 1899 | 8 | 31 | 1649 | 1657 | -8 | 1837 | 1922 | YX | 826 | N761YX | EWR | SDF | 89 | 642 | 16 | 57 | 2023-08-31 16:00:00 | Other |

| 1901 | 5 | 9 | 1706 | 1712 | -6 | 1827 | 1852 | UA | 771 | N14107 | EWR | ORD | 109 | 719 | 17 | 12 | 2023-05-09 17:00:00 | ORD |

| 1902 | 11 | 5 | 1153 | 1200 | -7 | 1348 | 1355 | 9E | 1441 | N491PX | LGA | CLE | 68 | 419 | 12 | 0 | 2023-11-05 12:00:00 | Other |

| 1910 | 10 | 25 | 2117 | 2129 | -12 | 2244 | 2256 | YX | 1265 | N102HQ | LGA | RIC | 55 | 292 | 21 | 29 | 2023-10-25 21:00:00 | Other |

| 1925 | 8 | 12 | 605 | 615 | -10 | 1005 | 809 | UA | 382 | N414UA | EWR | MSP | NA | 1008 | 6 | 15 | 2023-08-12 06:00:00 | Other |

| 1938 | 8 | 30 | 1031 | 1038 | -7 | 1227 | 1225 | B6 | 71 | N807JB | JFK | RDU | 71 | 427 | 10 | 38 | 2023-08-30 10:00:00 | Other |

| 1946 | 9 | 27 | 808 | 815 | -7 | 1121 | 1138 | UA | 666 | N13113 | EWR | SEA | 328 | 2402 | 8 | 15 | 2023-09-27 08:00:00 | Other |

| 1947 | 4 | 24 | 814 | 820 | -6 | 1017 | 1038 | YX | 1024 | N746YX | EWR | CVG | 96 | 569 | 8 | 20 | 2023-04-24 08:00:00 | Other |

| 1948 | 1 | 22 | 1948 | 2000 | -12 | 2151 | 2214 | B6 | 609 | N247JB | JFK | DTW | 96 | 509 | 20 | 0 | 2023-01-22 20:00:00 | Other |

| 1958 | 8 | 31 | 1952 | 1958 | -6 | 2130 | 2129 | OO | 949 | N306SY | LGA | MKE | 117 | 738 | 19 | 58 | 2023-08-31 19:00:00 | Other |

| 1960 | 10 | 25 | 851 | 900 | -9 | 1205 | 1202 | AS | 13 | N956AK | JFK | SAN | 346 | 2446 | 9 | 0 | 2023-10-25 09:00:00 | Other |

| 1964 | 8 | 29 | 2058 | 2110 | -12 | 2234 | 2303 | YX | 989 | N442YX | LGA | GSO | 74 | 461 | 21 | 10 | 2023-08-29 21:00:00 | Other |

| 1982 | 8 | 20 | 621 | 630 | -9 | 738 | 757 | YX | 972 | N438YX | JFK | ORF | 47 | 290 | 6 | 30 | 2023-08-20 06:00:00 | Other |

| 1986 | 8 | 23 | 1408 | 1418 | -10 | 1546 | 1610 | B6 | 223 | N216JB | JFK | RDU | 65 | 427 | 14 | 18 | 2023-08-23 14:00:00 | Other |

| 1990 | 8 | 28 | 1122 | 1130 | -8 | 1216 | 1242 | B6 | 625 | N355JB | JFK | ACK | 34 | 199 | 11 | 30 | 2023-08-28 11:00:00 | Other |

| 1991 | 11 | 11 | 651 | 659 | -8 | 906 | 915 | UA | 449 | N12754 | EWR | CHS | 106 | 628 | 6 | 59 | 2023-11-11 06:00:00 | Other |

| 1993 | 1 | 9 | 1615 | 1629 | -14 | 1806 | 1841 | YX | 1442 | N423YX | LGA | GSO | 73 | 461 | 16 | 29 | 2023-01-09 16:00:00 | Other |

| 1996 | 11 | 29 | 1953 | 1959 | -6 | 2310 | 2325 | DL | 598 | N313DU | LGA | IAH | 211 | 1416 | 19 | 59 | 2023-11-29 19:00:00 | Other |

| 1999 | 11 | 2 | 2107 | 2115 | -8 | 2303 | 2314 | YX | 1260 | N106HQ | LGA | MEM | 149 | 963 | 21 | 15 | 2023-11-02 21:00:00 | Other |

| 2001 | 10 | 2 | 1548 | 1554 | -6 | 1910 | 1924 | B6 | 208 | N945JT | JFK | SFO | 338 | 2586 | 15 | 54 | 2023-10-02 15:00:00 | Other |

| 2006 | 2 | 1 | 1608 | 1615 | -7 | 1705 | 1734 | B6 | 389 | N239JB | LGA | BOS | 34 | 184 | 16 | 15 | 2023-02-01 16:00:00 | BOS |

| 2008 | 8 | 23 | 1351 | 1359 | -8 | 1613 | 1558 | YX | 825 | N726YX | EWR | DTW | 104 | 488 | 13 | 59 | 2023-08-23 13:00:00 | Other |

| 2011 | 12 | 21 | 1223 | 1230 | -7 | 1509 | 1532 | B6 | 37 | N3145J | JFK | TPA | 138 | 1005 | 12 | 30 | 2023-12-21 12:00:00 | Other |

| 2025 | 4 | 13 | 1139 | 1145 | -6 | 1411 | 1443 | DL | 189 | N919DU | JFK | LAS | 287 | 2248 | 11 | 45 | 2023-04-13 11:00:00 | Other |

| 2026 | 4 | 19 | 1417 | 1425 | -8 | 1621 | 1633 | YX | 944 | N745YX | EWR | GRR | 101 | 605 | 14 | 25 | 2023-04-19 14:00:00 | Other |

| 2034 | 2 | 14 | 1133 | 1145 | -12 | 1326 | 1345 | YX | 1285 | N102HQ | JFK | CLE | 83 | 425 | 11 | 45 | 2023-02-14 11:00:00 | Other |

| 2035 | 6 | 21 | 617 | 625 | -8 | 758 | 809 | 9E | 1632 | N349PQ | LGA | RDU | 75 | 431 | 6 | 25 | 2023-06-21 06:00:00 | Other |

| 2043 | 8 | 11 | 720 | 729 | -9 | 955 | 1015 | UA | 159 | N14249 | LGA | IAH | 190 | 1416 | 7 | 29 | 2023-08-11 07:00:00 | Other |

| 2044 | 1 | 18 | 2150 | 2158 | -8 | 2304 | 2327 | UA | 891 | N76515 | EWR | ORF | 55 | 284 | 21 | 58 | 2023-01-18 21:00:00 | Other |

| 2045 | 5 | 11 | 1206 | 1215 | -9 | 1306 | 1332 | B6 | 199 | N249JB | LGA | BOS | 39 | 184 | 12 | 15 | 2023-05-11 12:00:00 | BOS |

| 2047 | 4 | 28 | 1411 | 1419 | -8 | 1618 | 1637 | 9E | 1410 | N479PX | LGA | CHS | 98 | 641 | 14 | 19 | 2023-04-28 14:00:00 | Other |

| 2048 | 5 | 21 | 810 | 817 | -7 | 1008 | 1030 | YX | 1094 | N863RW | EWR | DTW | 78 | 488 | 8 | 17 | 2023-05-21 08:00:00 | Other |

| 2052 | 8 | 26 | 805 | 815 | -10 | 1025 | 1029 | YX | 830 | N638RW | EWR | GRR | 105 | 605 | 8 | 15 | 2023-08-26 08:00:00 | Other |

| 2068 | 3 | 12 | 614 | 625 | -11 | 852 | 925 | B6 | 1011 | N324JB | JFK | PBI | 140 | 1028 | 6 | 25 | 2023-03-12 06:00:00 | Other |

| 2075 | 10 | 15 | 1848 | 1856 | -8 | 2138 | 2155 | DL | 571 | N316DN | LGA | MCO | 144 | 950 | 18 | 56 | 2023-10-15 18:00:00 | MCO |

| 2080 | 9 | 22 | 752 | 800 | -8 | 903 | 911 | B6 | 39 | N203JB | JFK | BOS | 38 | 187 | 8 | 0 | 2023-09-22 08:00:00 | BOS |

| 2082 | 12 | 2 | 815 | 830 | -15 | 1041 | 1049 | 9E | 1500 | N341PQ | JFK | CVG | 99 | 589 | 8 | 30 | 2023-12-02 08:00:00 | Other |

| 2095 | 5 | 11 | 1413 | 1420 | -7 | 1533 | 1545 | WN | 74 | N8564Z | LGA | MDW | 107 | 725 | 14 | 20 | 2023-05-11 14:00:00 | Other |

| 2096 | 4 | 18 | 724 | 730 | -6 | 845 | 857 | YX | 1467 | N824MD | LGA | ORF | 56 | 296 | 7 | 30 | 2023-04-18 07:00:00 | Other |

| 2097 | 10 | 4 | 1148 | 1159 | -11 | 1255 | 1317 | UA | 419 | N426UA | EWR | PWM | 48 | 284 | 11 | 59 | 2023-10-04 11:00:00 | Other |

| 2098 | 9 | 23 | 1953 | 2000 | -7 | 2233 | 2303 | NK | 162 | N680NK | LGA | MCO | 138 | 950 | 20 | 0 | 2023-09-23 20:00:00 | MCO |

| 2099 | 10 | 3 | 901 | 912 | -11 | 1031 | 1059 | YX | 1326 | N131HQ | LGA | GSO | 66 | 461 | 9 | 12 | 2023-10-03 09:00:00 | Other |

| 2104 | 6 | 4 | 852 | 900 | -8 | 1112 | 1117 | YX | 1232 | N653RW | EWR | HHH | 105 | 687 | 9 | 0 | 2023-06-04 09:00:00 | Other |

| 2105 | 3 | 10 | 557 | 605 | -8 | 743 | 818 | DL | 887 | N337NW | LGA | MSP | 146 | 1020 | 6 | 5 | 2023-03-10 06:00:00 | Other |

| 2118 | 10 | 2 | 1522 | 1531 | -9 | 1617 | 1643 | YX | 1083 | N728YX | EWR | ALB | 31 | 143 | 15 | 31 | 2023-10-02 15:00:00 | Other |

| 2124 | 1 | 13 | 1217 | 1230 | -13 | 1510 | 1544 | UA | 531 | N27267 | EWR | RSW | 160 | 1068 | 12 | 30 | 2023-01-13 12:00:00 | Other |

| 2131 | 2 | 10 | 1624 | 1630 | -6 | 1738 | 1756 | YX | 1597 | N222JQ | LGA | ROC | 50 | 254 | 16 | 30 | 2023-02-10 16:00:00 | Other |

| 2132 | 4 | 14 | 754 | 805 | -11 | 958 | 1010 | B6 | 439 | N328JB | JFK | CHS | 106 | 636 | 8 | 5 | 2023-04-14 08:00:00 | Other |

| 2140 | 12 | 15 | 1343 | 1350 | -7 | 1533 | 1559 | 9E | 1668 | N326PQ | LGA | CAE | 88 | 617 | 13 | 50 | 2023-12-15 13:00:00 | Other |

| 2143 | 5 | 7 | 1750 | 1759 | -9 | 2123 | 2106 | F9 | 951 | N364FR | LGA | MIA | 162 | 1096 | 17 | 59 | 2023-05-07 17:00:00 | MIA |

| 2144 | 2 | 11 | 810 | 817 | -7 | 1302 | 1311 | UA | 764 | N77066 | EWR | SJU | 200 | 1608 | 8 | 17 | 2023-02-11 08:00:00 | Other |

| 2147 | 2 | 19 | 1654 | 1701 | -7 | 1834 | 1904 | DL | 868 | N932AT | EWR | DTW | 84 | 488 | 17 | 1 | 2023-02-19 17:00:00 | Other |

| 2148 | 10 | 7 | 920 | 929 | -9 | 1223 | 1125 | YX | 1260 | N405YX | JFK | CMH | 80 | 483 | 9 | 29 | 2023-10-07 09:00:00 | Other |

| 2151 | 9 | 17 | 1353 | 1359 | -6 | 1639 | 1658 | AA | 991 | N306PB | LGA | DFW | 192 | 1389 | 13 | 59 | 2023-09-17 13:00:00 | Other |

| 2158 | 1 | 29 | 1835 | 1844 | -9 | 2131 | 2120 | UA | 431 | N12109 | EWR | DEN | 265 | 1605 | 18 | 44 | 2023-01-29 18:00:00 | Other |

| 2163 | 10 | 18 | 623 | 635 | -12 | 905 | 946 | AA | 557 | N803NN | LGA | DFW | 189 | 1389 | 6 | 35 | 2023-10-18 06:00:00 | Other |

| 2164 | 4 | 12 | 1153 | 1159 | -6 | 1415 | 1455 | UA | 670 | N27267 | EWR | IAH | 176 | 1400 | 11 | 59 | 2023-04-12 11:00:00 | Other |

| 2167 | 9 | 23 | 753 | 800 | -7 | 1051 | 1037 | B6 | 138 | N980JT | JFK | LAS | 309 | 2248 | 8 | 0 | 2023-09-23 08:00:00 | Other |

| 2172 | 4 | 28 | 1339 | 1345 | -6 | 1547 | 1602 | YX | 943 | N742YX | EWR | SDF | 103 | 642 | 13 | 45 | 2023-04-28 13:00:00 | Other |

| 2180 | 1 | 18 | 1915 | 1929 | -14 | 2152 | 2212 | YX | 1291 | N106HQ | LGA | LIT | 176 | 1085 | 19 | 29 | 2023-01-18 19:00:00 | Other |

| 2184 | 1 | 10 | 1150 | 1200 | -10 | 1523 | 1530 | UA | 873 | N14118 | EWR | SFO | 365 | 2565 | 12 | 0 | 2023-01-10 12:00:00 | Other |

| 2186 | 7 | 28 | 1948 | 1959 | -11 | 2204 | 2208 | YX | 998 | N110HQ | JFK | PIT | 64 | 340 | 19 | 59 | 2023-07-28 19:00:00 | Other |

| 2187 | 12 | 11 | 1124 | 1130 | -6 | 1452 | 1445 | DL | 590 | N392DA | LGA | MIA | 162 | 1096 | 11 | 30 | 2023-12-11 11:00:00 | MIA |

| 2188 | 6 | 2 | 1550 | 1600 | -10 | 1712 | 1732 | YX | 1336 | N871RW | LGA | CHO | 54 | 305 | 16 | 0 | 2023-06-02 16:00:00 | Other |

| 2191 | 12 | 24 | 1823 | 1829 | -6 | 2008 | 2017 | UA | 423 | N37531 | EWR | ORD | 108 | 719 | 18 | 29 | 2023-12-24 18:00:00 | ORD |

| 2194 | 5 | 5 | 1608 | 1615 | -7 | 1703 | 1735 | B6 | 362 | N267JB | LGA | BOS | 36 | 184 | 16 | 15 | 2023-05-05 16:00:00 | BOS |

| 2196 | 2 | 25 | 2120 | 2130 | -10 | 2343 | 2333 | UA | 146 | N76516 | EWR | CHS | 93 | 628 | 21 | 30 | 2023-02-25 21:00:00 | Other |

| 2201 | 9 | 2 | 1611 | 1617 | -6 | 1808 | 1839 | 9E | 1452 | N916XJ | LGA | CVG | 86 | 585 | 16 | 17 | 2023-09-02 16:00:00 | Other |

| 2202 | 3 | 21 | 1140 | 1150 | -10 | 1249 | 1319 | YX | 1649 | N815MD | LGA | PWM | 48 | 269 | 11 | 50 | 2023-03-21 11:00:00 | Other |

| 2218 | 9 | 18 | 1526 | 1535 | -9 | 1636 | 1704 | 9E | 1526 | N176PQ | LGA | ROC | 44 | 254 | 15 | 35 | 2023-09-18 15:00:00 | Other |

| 2219 | 10 | 17 | 1653 | 1700 | -7 | 1801 | 1826 | YX | 1716 | N216JQ | LGA | BOS | 36 | 184 | 17 | 0 | 2023-10-17 17:00:00 | BOS |

| 2223 | 6 | 8 | 655 | 705 | -10 | 1029 | 1007 | B6 | 884 | N627JB | EWR | MIA | 167 | 1085 | 7 | 5 | 2023-06-08 07:00:00 | MIA |

| 2224 | 8 | 24 | 1423 | 1430 | -7 | 1625 | 1640 | WN | 264 | N8535S | LGA | MSY | 146 | 1183 | 14 | 30 | 2023-08-24 14:00:00 | Other |

| 2226 | 6 | 9 | 2048 | 2055 | -7 | 2214 | 2258 | YX | 1862 | N210JQ | JFK | PIT | 60 | 340 | 20 | 55 | 2023-06-09 20:00:00 | Other |

| 2228 | 12 | 7 | 1502 | 1510 | -8 | 1642 | 1719 | YX | 1241 | N404YX | JFK | CMH | 79 | 483 | 15 | 10 | 2023-12-07 15:00:00 | Other |

| 2230 | 4 | 7 | 949 | 955 | -6 | 1233 | 1227 | AA | 714 | N418AN | EWR | PHX | 302 | 2133 | 9 | 55 | 2023-04-07 09:00:00 | Other |

| 2251 | 7 | 11 | 1949 | 1955 | -6 | 2149 | 2249 | DL | 153 | N868DN | JFK | DEN | 213 | 1626 | 19 | 55 | 2023-07-11 19:00:00 | Other |

| 2253 | 9 | 6 | 651 | 659 | -8 | 809 | 829 | YX | 1378 | N117HQ | LGA | PIT | 54 | 335 | 6 | 59 | 2023-09-06 06:00:00 | Other |

| 2254 | 5 | 5 | 720 | 730 | -10 | 1031 | 1055 | AS | 15 | N464AS | JFK | SFO | 342 | 2586 | 7 | 30 | 2023-05-05 07:00:00 | Other |

| 2259 | 12 | 23 | 1504 | 1510 | -6 | 1741 | 1845 | DL | 151 | N509DT | JFK | SEA | 316 | 2422 | 15 | 10 | 2023-12-23 15:00:00 | Other |

| 2261 | 10 | 13 | 2115 | 2124 | -9 | 2301 | 2325 | NK | 253 | N621NK | LGA | DTW | 87 | 502 | 21 | 24 | 2023-10-13 21:00:00 | Other |

| 2262 | 10 | 20 | 1447 | 1453 | -6 | 1752 | 1800 | NK | 837 | N620NK | EWR | FLL | 163 | 1065 | 14 | 53 | 2023-10-20 14:00:00 | FLL |

| 2277 | 10 | 31 | 952 | 1000 | -8 | 1116 | 1128 | YX | 1146 | N657RW | EWR | DCA | 49 | 199 | 10 | 0 | 2023-10-31 10:00:00 | Other |

| 2280 | 3 | 7 | 1728 | 1735 | -7 | 1929 | 1907 | YX | 1682 | N220JQ | LGA | DCA | 55 | 214 | 17 | 35 | 2023-03-07 17:00:00 | Other |

| 2281 | 3 | 24 | 1748 | 1755 | -7 | 1914 | 1925 | YX | 1666 | N210JQ | JFK | DCA | 52 | 213 | 17 | 55 | 2023-03-24 17:00:00 | Other |

| 2283 | 12 | 21 | 1242 | 1250 | -8 | 1420 | 1453 | YX | 1017 | N740YX | EWR | CMH | 71 | 463 | 12 | 50 | 2023-12-21 12:00:00 | Other |

| 2288 | 1 | 19 | 652 | 700 | -8 | 953 | 1018 | UA | 916 | N27263 | EWR | RSW | 155 | 1068 | 7 | 0 | 2023-01-19 07:00:00 | Other |

| 2291 | 12 | 1 | 1651 | 1659 | -8 | 1806 | 1821 | YX | 1138 | N725YX | EWR | BTV | 51 | 266 | 16 | 59 | 2023-12-01 16:00:00 | Other |

| 2301 | 7 | 14 | 721 | 729 | -8 | 1055 | 1015 | UA | 173 | N33203 | LGA | IAH | 195 | 1416 | 7 | 29 | 2023-07-14 07:00:00 | Other |