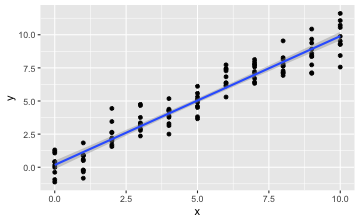

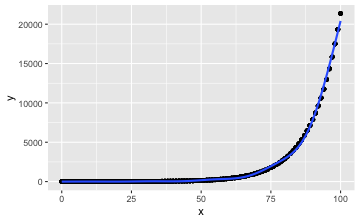

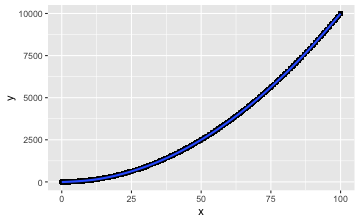

class: center, middle, inverse, title-slide # Logarithmus und Exponenten ## <br/>🤔 Was haben die in einer Regression verloren? ### Sebastian Sauer ### Hochschule Ansbach ### 2021-06-10 --- <style> .center2 { margin: 0; position: absolute; top: 50%; left: 50%; -ms-transform: translate(-50%, -50%); transform: translate(-50%, -50%); } </style> # URL zum Quellcode [https://sebastiansauer.github.io/2021-sose/QuantMeth1/Vertiefung/Log-Log-Regression.html#1](https://sebastiansauer.github.io/2021-sose/QuantMeth1/Vertiefung/Log-Log-Regression.html#1) .center[] .footnote[Lizenz: [CC-BY](https://creativecommons.org/licenses/by/4.0/)] --- # Gliederung .center2[.large[ 1. [Standard-Regression](#standard-regression) 2. [LogY-Regression](#log-regression) 3. [LogY-LogX-Regression](#log-log-regression) 4. [Fazit](#fazit) ]] --- name: standard-regression class: center, middle, inverse # Standard-Regression --- # Regression in Standardform 🥱 ## Additiver Zusammenhang `$$y= b0 + b_1x$$` bzw. `$$y = b0 + b_1x_1 + b_2 x_2 + \ldots + b_k x_k + \epsilon$$` .content-box-blue[Additiv!] Der gemeinsame Effekt der Prädiktoren auf Y ist die Summe der einzelnen Effekte --- # Wir definieren einen einfachen Datensatz ```r d <- tibble( x = rep(0:10, 10), y_hat = x, e = rnorm(n = (10+1)*10) %>% round(2), y = y_hat + e ) ``` - `\(x\)`: Prädiktor - `\(\hat{y}\)`: vorhergesagter Y-Wert - `\(e\)`: Fehler - `\(y\)`: beobachteter Y-Wert --- # `d`: Ein Datensatz für additives Wachstum <div id="htmlwidget-0ce1041adc9732dc6d31" style="width:100%;height:auto;" class="datatables html-widget"></div> <script type="application/json" data-for="htmlwidget-0ce1041adc9732dc6d31">{"x":{"filter":"none","data":[["1","2","3","4","5","6","7","8","9","10","11","12","13","14","15","16","17","18","19","20","21","22","23","24","25","26","27","28","29","30","31","32","33","34","35","36","37","38","39","40","41","42","43","44","45","46","47","48","49","50","51","52","53","54","55","56","57","58","59","60","61","62","63","64","65","66","67","68","69","70","71","72","73","74","75","76","77","78","79","80","81","82","83","84","85","86","87","88","89","90","91","92","93","94","95","96","97","98","99","100","101","102","103","104","105","106","107","108","109","110"],[0,1,2,3,4,5,6,7,8,9,10,0,1,2,3,4,5,6,7,8,9,10,0,1,2,3,4,5,6,7,8,9,10,0,1,2,3,4,5,6,7,8,9,10,0,1,2,3,4,5,6,7,8,9,10,0,1,2,3,4,5,6,7,8,9,10,0,1,2,3,4,5,6,7,8,9,10,0,1,2,3,4,5,6,7,8,9,10,0,1,2,3,4,5,6,7,8,9,10,0,1,2,3,4,5,6,7,8,9,10],[0,1,2,3,4,5,6,7,8,9,10,0,1,2,3,4,5,6,7,8,9,10,0,1,2,3,4,5,6,7,8,9,10,0,1,2,3,4,5,6,7,8,9,10,0,1,2,3,4,5,6,7,8,9,10,0,1,2,3,4,5,6,7,8,9,10,0,1,2,3,4,5,6,7,8,9,10,0,1,2,3,4,5,6,7,8,9,10,0,1,2,3,4,5,6,7,8,9,10,0,1,2,3,4,5,6,7,8,9,10],[-1.12,-0.5,0.21,1.66,-0.23,-0.49,0.18,0.94,-0.87,-1.91,-0.73,-0.01,0.84,1.45,0.18,0.26,1.11,0.34,0.72,0.27,-0.57,-0.7,1.19,-1.35,0.1,-0.22,-0.13,0.58,1.45,0.57,1.54,-0.09,-1.57,0.39,-1.23,-0.44,0.27,-0.86,0.11,1.28,-0.67,-1.07,-1.27,0.72,1.31,-0.15,0.64,-0.64,-1.5,-0.1,1.39,0.78,-0.73,0.67,1.07,0.14,-1.21,2.44,0.25,-0.71,0.31,0.83,-0.57,0.13,-0.65,-0.12,-0.38,-0.42,0.61,-0.09,0.27,0.07,-0.7,-0.29,-0.34,-1.87,0.55,1.07,-0.08,0.11,0.35,0.38,-1.34,0.13,0.22,-0.87,1.43,-0.48,-0.93,-0.09,-0.03,1.75,1.18,-0.39,0.38,1.13,-0.38,-0.41,1.61,0.43,-1.83,-0.3,0.76,0.3,-1.19,1.73,0.08,-0.19,0.38,-2.44],[-1.12,0.5,2.21,4.66,3.77,4.51,6.18,7.94,7.13,7.09,9.27,-0.01,1.84,3.45,3.18,4.26,6.11,6.34,7.72,8.27,8.43,9.3,1.19,-0.35,2.1,2.78,3.87,5.58,7.45,7.57,9.54,8.91,8.43,0.39,-0.23,1.56,3.27,3.14,5.11,7.28,6.33,6.93,7.73,10.72,1.31,0.85,2.64,2.36,2.5,4.9,7.39,7.78,7.27,9.67,11.07,0.14,-0.21,4.44,3.25,3.29,5.31,6.83,6.43,8.13,8.35,9.88,-0.38,0.58,2.61,2.91,4.27,5.07,5.3,6.71,7.66,7.13,10.55,1.07,0.92,2.11,3.35,4.38,3.66,6.13,7.22,7.13,10.43,9.52,-0.93,0.91,1.97,4.75,5.18,4.61,6.38,8.13,7.62,8.59,11.61,0.43,-0.83,1.7,3.76,4.3,3.81,7.73,7.08,7.81,9.38,7.56]],"container":"<table class=\"display\">\n <thead>\n <tr>\n <th> <\/th>\n <th>x<\/th>\n <th>y_hat<\/th>\n <th>e<\/th>\n <th>y<\/th>\n <\/tr>\n <\/thead>\n<\/table>","options":{"pageLength":7,"columnDefs":[{"className":"dt-right","targets":[1,2,3,4]},{"orderable":false,"targets":0}],"order":[],"autoWidth":false,"orderClasses":false,"lengthMenu":[7,10,25,50,100]}},"evals":[],"jsHooks":[]}</script> --- # So sieht additives Wachstum aus .pull-left[ ```r ggplot(d) + aes(x = x, y = y) + geom_point() + geom_smooth(method = "lm") ``` ] .pull-right[  ] Bei einem Unterschied in X von 1, beträgt der vorhergesagte Unterschied in Y 1 (bzw. `\(k\)` im allgemeinen Fall). Für jede Einheit, die X steigt, steigt Y um einen festen Wert `\(k\)`: additives Wachstum. ✔️ *Beispiel:* Für jede Stunde Lernen für die Klausur, "wächst" der vorhergesagte Klausurerfolg um 0,42 Punkte. --- class: center, middle, inverse # LogY-Regression --- name:log-regression # LogY-Regression ## Exponentieller Zusammenhang `$$log(y) = x$$` Exponentiert man beide Seite, so erhält man: `$$y = e^x$$` `\(e\)` ist die Eulersche Zahl: 2.71... --- # Einfache Beispiele für exponentielle Zusammenhänge - Eine Bakterienmenge verdoppelt sich jeden Tag - Pro Jahr erzielt eine Kapitalanlage 10% Zinsen - Während einer bestimmten Periode verdoppelten sich die Coronafälle alle 10 Tage - Die Menge der Vitamine in einem Lebensmittel verringert sich pro Zeiteinheit um den Faktor `\(k\)` Generell bieten sich Wachstumsprozesse für exponentielle Zusammenhänge an. Man kann auch "datengetrieben" eine Log-Regression verwenden, wenn man sieht, dass sich so die Vorhersageleistung verbessert. --- # Exponentielles Wachstum Beim exponentiellen Wachstum wächst eine Größe pro Zeitabschnitt immer um denselben Faktor. Die Änderung einer Größe `\(A\)` pro Zeitabschnitt `\(t\)` ist proportional<sup>*</sup> zum Bestand von `\(A\)`: `$$\frac{dA}{dt} \sim A$$` Exponentielles Wachstum wächst (ab einem bestimmten Zeitpunkt) sehr stark und wird daher leicht unterschätzt. .footnote[<sup>*</sup> Proportional bedeutet, Verdopplung (Verdreifachung, Vervierfachung...) einer Größe ist stets mit der Verdopplung (Verdreifachung, Vervierfachung, ...) der anderen Größe verbunden. So ist der Kreisumfang proportional zum Kreisdurchmesser mit dem Proportionalitätsfaktor 3.14.] --- # `d2`: Daten für exponentiellen Zusammenhang ```r euler_e <- 2.71 d2 <- tibble( x = rep(0:100, 10), y_hat = euler_e^(0.1*x) %>% round(2), e = rnorm(n = (101)*10) %>% round(2), y = y_hat + e ) ``` --- # So sieht der Datensatz `d2` aus <div id="htmlwidget-182276eaf960533aac79" style="width:100%;height:auto;" class="datatables html-widget"></div> <script type="application/json" data-for="htmlwidget-182276eaf960533aac79">{"x":{"filter":"none","data":[["1","2","3","4","5","6","7","8","9","10","11","12","13","14","15","16","17","18","19","20","21","22","23","24","25","26","27","28","29","30","31","32","33","34","35","36","37","38","39","40","41","42","43","44","45","46","47","48","49","50","51","52","53","54","55","56","57","58","59","60","61","62","63","64","65","66","67","68","69","70","71","72","73","74","75","76","77","78","79","80","81","82","83","84","85","86","87","88","89","90","91","92","93","94","95","96","97","98","99","100","101","102","103","104","105","106","107","108","109","110","111","112","113","114","115","116","117","118","119","120","121","122","123","124","125","126","127","128","129","130","131","132","133","134","135","136","137","138","139","140","141","142","143","144","145","146","147","148","149","150","151","152","153","154","155","156","157","158","159","160","161","162","163","164","165","166","167","168","169","170","171","172","173","174","175","176","177","178","179","180","181","182","183","184","185","186","187","188","189","190","191","192","193","194","195","196","197","198","199","200","201","202","203","204","205","206","207","208","209","210","211","212","213","214","215","216","217","218","219","220","221","222","223","224","225","226","227","228","229","230","231","232","233","234","235","236","237","238","239","240","241","242","243","244","245","246","247","248","249","250","251","252","253","254","255","256","257","258","259","260","261","262","263","264","265","266","267","268","269","270","271","272","273","274","275","276","277","278","279","280","281","282","283","284","285","286","287","288","289","290","291","292","293","294","295","296","297","298","299","300","301","302","303","304","305","306","307","308","309","310","311","312","313","314","315","316","317","318","319","320","321","322","323","324","325","326","327","328","329","330","331","332","333","334","335","336","337","338","339","340","341","342","343","344","345","346","347","348","349","350","351","352","353","354","355","356","357","358","359","360","361","362","363","364","365","366","367","368","369","370","371","372","373","374","375","376","377","378","379","380","381","382","383","384","385","386","387","388","389","390","391","392","393","394","395","396","397","398","399","400","401","402","403","404","405","406","407","408","409","410","411","412","413","414","415","416","417","418","419","420","421","422","423","424","425","426","427","428","429","430","431","432","433","434","435","436","437","438","439","440","441","442","443","444","445","446","447","448","449","450","451","452","453","454","455","456","457","458","459","460","461","462","463","464","465","466","467","468","469","470","471","472","473","474","475","476","477","478","479","480","481","482","483","484","485","486","487","488","489","490","491","492","493","494","495","496","497","498","499","500","501","502","503","504","505","506","507","508","509","510","511","512","513","514","515","516","517","518","519","520","521","522","523","524","525","526","527","528","529","530","531","532","533","534","535","536","537","538","539","540","541","542","543","544","545","546","547","548","549","550","551","552","553","554","555","556","557","558","559","560","561","562","563","564","565","566","567","568","569","570","571","572","573","574","575","576","577","578","579","580","581","582","583","584","585","586","587","588","589","590","591","592","593","594","595","596","597","598","599","600","601","602","603","604","605","606","607","608","609","610","611","612","613","614","615","616","617","618","619","620","621","622","623","624","625","626","627","628","629","630","631","632","633","634","635","636","637","638","639","640","641","642","643","644","645","646","647","648","649","650","651","652","653","654","655","656","657","658","659","660","661","662","663","664","665","666","667","668","669","670","671","672","673","674","675","676","677","678","679","680","681","682","683","684","685","686","687","688","689","690","691","692","693","694","695","696","697","698","699","700","701","702","703","704","705","706","707","708","709","710","711","712","713","714","715","716","717","718","719","720","721","722","723","724","725","726","727","728","729","730","731","732","733","734","735","736","737","738","739","740","741","742","743","744","745","746","747","748","749","750","751","752","753","754","755","756","757","758","759","760","761","762","763","764","765","766","767","768","769","770","771","772","773","774","775","776","777","778","779","780","781","782","783","784","785","786","787","788","789","790","791","792","793","794","795","796","797","798","799","800","801","802","803","804","805","806","807","808","809","810","811","812","813","814","815","816","817","818","819","820","821","822","823","824","825","826","827","828","829","830","831","832","833","834","835","836","837","838","839","840","841","842","843","844","845","846","847","848","849","850","851","852","853","854","855","856","857","858","859","860","861","862","863","864","865","866","867","868","869","870","871","872","873","874","875","876","877","878","879","880","881","882","883","884","885","886","887","888","889","890","891","892","893","894","895","896","897","898","899","900","901","902","903","904","905","906","907","908","909","910","911","912","913","914","915","916","917","918","919","920","921","922","923","924","925","926","927","928","929","930","931","932","933","934","935","936","937","938","939","940","941","942","943","944","945","946","947","948","949","950","951","952","953","954","955","956","957","958","959","960","961","962","963","964","965","966","967","968","969","970","971","972","973","974","975","976","977","978","979","980","981","982","983","984","985","986","987","988","989","990","991","992","993","994","995","996","997","998","999","1000","1001","1002","1003","1004","1005","1006","1007","1008","1009","1010"],[0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100],[1,1.1,1.22,1.35,1.49,1.65,1.82,2.01,2.22,2.45,2.71,2.99,3.31,3.65,4.04,4.46,4.93,5.45,6.02,6.65,7.34,8.11,8.96,9.9,10.94,12.09,13.36,14.76,16.3,18.01,19.9,21.99,24.29,26.84,29.65,32.76,36.2,39.99,44.19,48.82,53.94,59.59,65.84,72.74,80.36,88.79,98.1,108.38,119.74,132.3,146.17,161.49,178.42,197.12,217.79,240.62,265.84,293.71,324.51,358.52,396.11,437.64,483.51,534.2,590.21,652.08,720.44,795.97,879.41,971.6,1073.46,1185.99,1310.32,1447.69,1599.46,1767.13,1952.39,2157.07,2383.2,2633.04,2909.07,3214.04,3550.98,3923.24,4334.53,4788.94,5290.98,5845.65,6458.47,7135.54,7883.58,8710.05,9623.15,10631.99,11746.58,12978.01,14338.55,15841.71,17502.46,19337.31,21364.51,1,1.1,1.22,1.35,1.49,1.65,1.82,2.01,2.22,2.45,2.71,2.99,3.31,3.65,4.04,4.46,4.93,5.45,6.02,6.65,7.34,8.11,8.96,9.9,10.94,12.09,13.36,14.76,16.3,18.01,19.9,21.99,24.29,26.84,29.65,32.76,36.2,39.99,44.19,48.82,53.94,59.59,65.84,72.74,80.36,88.79,98.1,108.38,119.74,132.3,146.17,161.49,178.42,197.12,217.79,240.62,265.84,293.71,324.51,358.52,396.11,437.64,483.51,534.2,590.21,652.08,720.44,795.97,879.41,971.6,1073.46,1185.99,1310.32,1447.69,1599.46,1767.13,1952.39,2157.07,2383.2,2633.04,2909.07,3214.04,3550.98,3923.24,4334.53,4788.94,5290.98,5845.65,6458.47,7135.54,7883.58,8710.05,9623.15,10631.99,11746.58,12978.01,14338.55,15841.71,17502.46,19337.31,21364.51,1,1.1,1.22,1.35,1.49,1.65,1.82,2.01,2.22,2.45,2.71,2.99,3.31,3.65,4.04,4.46,4.93,5.45,6.02,6.65,7.34,8.11,8.96,9.9,10.94,12.09,13.36,14.76,16.3,18.01,19.9,21.99,24.29,26.84,29.65,32.76,36.2,39.99,44.19,48.82,53.94,59.59,65.84,72.74,80.36,88.79,98.1,108.38,119.74,132.3,146.17,161.49,178.42,197.12,217.79,240.62,265.84,293.71,324.51,358.52,396.11,437.64,483.51,534.2,590.21,652.08,720.44,795.97,879.41,971.6,1073.46,1185.99,1310.32,1447.69,1599.46,1767.13,1952.39,2157.07,2383.2,2633.04,2909.07,3214.04,3550.98,3923.24,4334.53,4788.94,5290.98,5845.65,6458.47,7135.54,7883.58,8710.05,9623.15,10631.99,11746.58,12978.01,14338.55,15841.71,17502.46,19337.31,21364.51,1,1.1,1.22,1.35,1.49,1.65,1.82,2.01,2.22,2.45,2.71,2.99,3.31,3.65,4.04,4.46,4.93,5.45,6.02,6.65,7.34,8.11,8.96,9.9,10.94,12.09,13.36,14.76,16.3,18.01,19.9,21.99,24.29,26.84,29.65,32.76,36.2,39.99,44.19,48.82,53.94,59.59,65.84,72.74,80.36,88.79,98.1,108.38,119.74,132.3,146.17,161.49,178.42,197.12,217.79,240.62,265.84,293.71,324.51,358.52,396.11,437.64,483.51,534.2,590.21,652.08,720.44,795.97,879.41,971.6,1073.46,1185.99,1310.32,1447.69,1599.46,1767.13,1952.39,2157.07,2383.2,2633.04,2909.07,3214.04,3550.98,3923.24,4334.53,4788.94,5290.98,5845.65,6458.47,7135.54,7883.58,8710.05,9623.15,10631.99,11746.58,12978.01,14338.55,15841.71,17502.46,19337.31,21364.51,1,1.1,1.22,1.35,1.49,1.65,1.82,2.01,2.22,2.45,2.71,2.99,3.31,3.65,4.04,4.46,4.93,5.45,6.02,6.65,7.34,8.11,8.96,9.9,10.94,12.09,13.36,14.76,16.3,18.01,19.9,21.99,24.29,26.84,29.65,32.76,36.2,39.99,44.19,48.82,53.94,59.59,65.84,72.74,80.36,88.79,98.1,108.38,119.74,132.3,146.17,161.49,178.42,197.12,217.79,240.62,265.84,293.71,324.51,358.52,396.11,437.64,483.51,534.2,590.21,652.08,720.44,795.97,879.41,971.6,1073.46,1185.99,1310.32,1447.69,1599.46,1767.13,1952.39,2157.07,2383.2,2633.04,2909.07,3214.04,3550.98,3923.24,4334.53,4788.94,5290.98,5845.65,6458.47,7135.54,7883.58,8710.05,9623.15,10631.99,11746.58,12978.01,14338.55,15841.71,17502.46,19337.31,21364.51,1,1.1,1.22,1.35,1.49,1.65,1.82,2.01,2.22,2.45,2.71,2.99,3.31,3.65,4.04,4.46,4.93,5.45,6.02,6.65,7.34,8.11,8.96,9.9,10.94,12.09,13.36,14.76,16.3,18.01,19.9,21.99,24.29,26.84,29.65,32.76,36.2,39.99,44.19,48.82,53.94,59.59,65.84,72.74,80.36,88.79,98.1,108.38,119.74,132.3,146.17,161.49,178.42,197.12,217.79,240.62,265.84,293.71,324.51,358.52,396.11,437.64,483.51,534.2,590.21,652.08,720.44,795.97,879.41,971.6,1073.46,1185.99,1310.32,1447.69,1599.46,1767.13,1952.39,2157.07,2383.2,2633.04,2909.07,3214.04,3550.98,3923.24,4334.53,4788.94,5290.98,5845.65,6458.47,7135.54,7883.58,8710.05,9623.15,10631.99,11746.58,12978.01,14338.55,15841.71,17502.46,19337.31,21364.51,1,1.1,1.22,1.35,1.49,1.65,1.82,2.01,2.22,2.45,2.71,2.99,3.31,3.65,4.04,4.46,4.93,5.45,6.02,6.65,7.34,8.11,8.96,9.9,10.94,12.09,13.36,14.76,16.3,18.01,19.9,21.99,24.29,26.84,29.65,32.76,36.2,39.99,44.19,48.82,53.94,59.59,65.84,72.74,80.36,88.79,98.1,108.38,119.74,132.3,146.17,161.49,178.42,197.12,217.79,240.62,265.84,293.71,324.51,358.52,396.11,437.64,483.51,534.2,590.21,652.08,720.44,795.97,879.41,971.6,1073.46,1185.99,1310.32,1447.69,1599.46,1767.13,1952.39,2157.07,2383.2,2633.04,2909.07,3214.04,3550.98,3923.24,4334.53,4788.94,5290.98,5845.65,6458.47,7135.54,7883.58,8710.05,9623.15,10631.99,11746.58,12978.01,14338.55,15841.71,17502.46,19337.31,21364.51,1,1.1,1.22,1.35,1.49,1.65,1.82,2.01,2.22,2.45,2.71,2.99,3.31,3.65,4.04,4.46,4.93,5.45,6.02,6.65,7.34,8.11,8.96,9.9,10.94,12.09,13.36,14.76,16.3,18.01,19.9,21.99,24.29,26.84,29.65,32.76,36.2,39.99,44.19,48.82,53.94,59.59,65.84,72.74,80.36,88.79,98.1,108.38,119.74,132.3,146.17,161.49,178.42,197.12,217.79,240.62,265.84,293.71,324.51,358.52,396.11,437.64,483.51,534.2,590.21,652.08,720.44,795.97,879.41,971.6,1073.46,1185.99,1310.32,1447.69,1599.46,1767.13,1952.39,2157.07,2383.2,2633.04,2909.07,3214.04,3550.98,3923.24,4334.53,4788.94,5290.98,5845.65,6458.47,7135.54,7883.58,8710.05,9623.15,10631.99,11746.58,12978.01,14338.55,15841.71,17502.46,19337.31,21364.51,1,1.1,1.22,1.35,1.49,1.65,1.82,2.01,2.22,2.45,2.71,2.99,3.31,3.65,4.04,4.46,4.93,5.45,6.02,6.65,7.34,8.11,8.96,9.9,10.94,12.09,13.36,14.76,16.3,18.01,19.9,21.99,24.29,26.84,29.65,32.76,36.2,39.99,44.19,48.82,53.94,59.59,65.84,72.74,80.36,88.79,98.1,108.38,119.74,132.3,146.17,161.49,178.42,197.12,217.79,240.62,265.84,293.71,324.51,358.52,396.11,437.64,483.51,534.2,590.21,652.08,720.44,795.97,879.41,971.6,1073.46,1185.99,1310.32,1447.69,1599.46,1767.13,1952.39,2157.07,2383.2,2633.04,2909.07,3214.04,3550.98,3923.24,4334.53,4788.94,5290.98,5845.65,6458.47,7135.54,7883.58,8710.05,9623.15,10631.99,11746.58,12978.01,14338.55,15841.71,17502.46,19337.31,21364.51,1,1.1,1.22,1.35,1.49,1.65,1.82,2.01,2.22,2.45,2.71,2.99,3.31,3.65,4.04,4.46,4.93,5.45,6.02,6.65,7.34,8.11,8.96,9.9,10.94,12.09,13.36,14.76,16.3,18.01,19.9,21.99,24.29,26.84,29.65,32.76,36.2,39.99,44.19,48.82,53.94,59.59,65.84,72.74,80.36,88.79,98.1,108.38,119.74,132.3,146.17,161.49,178.42,197.12,217.79,240.62,265.84,293.71,324.51,358.52,396.11,437.64,483.51,534.2,590.21,652.08,720.44,795.97,879.41,971.6,1073.46,1185.99,1310.32,1447.69,1599.46,1767.13,1952.39,2157.07,2383.2,2633.04,2909.07,3214.04,3550.98,3923.24,4334.53,4788.94,5290.98,5845.65,6458.47,7135.54,7883.58,8710.05,9623.15,10631.99,11746.58,12978.01,14338.55,15841.71,17502.46,19337.31,21364.51],[-1.32,-0.59,-0.38,-1.23,0.07,-0.92,-0.06,-2.42,-1,-1.94,0.91,-0.57,-1.5,-0.54,0.03,0.47,-1.95,0.11,-0.96,-0.32,-0.47,0.31,0.86,0.68,-0.34,-1.94,0.59,-0.82,0.9,0.07,0.7,-0.45,-0.15,-0.14,1.34,-0.82,-1.03,0.47,-0.34,0.07,-1.79,-1.1,-0.12,-0.78,2.49,-0.59,1.58,0.65,-0.37,-1.38,0.29,-0.96,-0.89,0.22,-0.94,-1.27,2.09,0.85,-1.05,-1.16,1.52,-1.1,-0.07,0.01,-1.2,-0.94,-0.46,0.92,0.36,0.23,-0.11,-1.12,1.1,-0.95,-0.05,-1.13,0.15,0.97,-0.04,0.16,-0.44,1.01,-0.43,-0.59,0.82,-0.27,-1.51,-0.86,0.11,-2.03,0.7,-1.27,0.29,-0.71,-0.01,0.59,1.1,1.7,-0.33,0.8,-1.32,0.23,0.51,-1.41,1.48,-2.06,0.46,0.44,0.53,1.22,-0.55,-0.09,-0.19,0.7,1.46,-0.28,3.09,0.23,-0.67,-0.3,0.4,-0.85,0.04,0.76,-0.56,-0.84,-1.06,-1.13,1.99,0.77,-1.94,-0.15,0.39,-0.87,-0.02,0.75,0.34,-0.99,0.64,1.61,-0.23,-1.2,-0.4,-0.17,-0.28,-1.37,0.54,-0.72,-0.78,1.08,0.11,0.19,0.05,-1.35,0.2,0.16,-0.51,-1.37,-0.27,-0.87,0.59,1.49,0.4,-0.91,0.22,-0.68,0.15,-0.42,-0.2,-1.25,1.35,0.25,-1.34,0.12,-0.3,-1.26,-1.19,2.59,1.07,-0.27,0.77,-0.55,1.19,-1.78,0.66,-0.03,0.39,0.12,0.62,1.62,0.08,0.57,-0.59,0.04,1.48,-1.15,-0.77,0.99,0.65,-0.88,-0.06,3.32,-0.08,0.76,0.67,-1.03,0.22,0.22,0.88,-0.72,0.49,-1.82,-0.63,0.38,-2.16,-1.07,-0.4,-0.07,1.48,-0.51,-0.35,-0.71,-0.31,-0.14,0.6,0.93,-0.91,-0.3,1.69,-1.58,-1.5,-0.14,-0.26,0.15,-0.56,1.09,0.47,-1.95,-0.57,-0.45,1.28,0.57,0.21,-0.67,0.87,0.36,-1.79,-1.91,-1.26,-0.24,-0.7,0.62,-0.95,0.55,-2.28,-1.99,-0.19,0.35,-0.26,1.24,-1.01,1.58,1.26,0.43,0.49,1.05,0.57,0.13,1.21,-0.16,0.36,0.11,2.4,-1.22,-0.38,-0.26,1.57,0.13,2.11,2.27,0.37,1.16,-0.12,-2,0.93,-1.08,-0.88,0.6,-0.22,-0.16,0.25,1.24,0.61,1.77,0.95,-0.66,-0.51,-0.5,0.8,-0.77,-0.85,-0.85,-0.06,0.58,0.65,-0.02,0.58,0.57,-0.93,1.01,-0.81,1.89,-0.96,0.62,-0.33,1.6,-0.77,-2.26,-1.54,-0.06,0.53,-1.17,-1.17,0.28,0.43,-0.58,1.89,-1.25,-0.24,-0.6,-0.23,-0.01,1.65,-0.39,-0.44,-0.82,-1.83,-0.54,0.85,-0.11,-0.44,-1.19,-0.62,-0.04,-0.29,0.72,-0.84,0.44,-0.45,0.08,-0.56,-1.54,0.36,-0.53,-0.01,-0.34,-1.14,0.09,1.32,0.42,-2.2,0.49,0.14,0.7,-0.46,-0.37,-1.54,0.33,-0.92,-0.17,0.56,1.42,1.22,0.5,0.62,1.03,-0.01,0.44,1.18,0.4,-0.35,1.41,-0.33,-0.29,1.92,-0.88,-0.42,0.8,2.03,0.08,0.37,0.82,-0.31,-2.88,0.22,0.68,0.44,-0.73,1.13,1.08,0.07,-0.37,0.24,-0.66,0.84,0.96,1.15,-0.27,-0.64,1.36,-0.17,-0.73,-0.37,-0.45,-0.11,-1.27,-0.55,0.48,-0.21,-1.22,-0.93,-0.2,0.3,1.39,-0.17,-0.05,0.24,0.64,-1.6,0.45,0.06,-1.55,3.37,-1.05,-1,-0.43,0.14,-1.07,0.78,-0.79,-1.03,-0.27,-1.07,1.53,-0.4,1.51,-0.6,-0.55,2,0.35,-0.92,-0.07,1.63,-0.44,-0.37,-0.86,0.67,-0.38,-1.28,-0.01,-0.36,-1.18,1.49,0.69,1.17,-0.18,1.53,-1.53,-1.2,1.07,0.14,-0.07,0.24,-0.41,-0.41,-1.51,0.51,-0.93,0.95,-0.45,0.95,0.25,-0.35,-1.29,0.23,-0.38,0.48,-0.73,0.84,-0.19,0.78,-0.43,1.5,0.5,-1.62,0.37,-1.77,-0.09,0.31,0.35,-0.86,0.42,-0.95,0.22,-2.45,0.67,-0.71,-0.75,-0.57,-0.16,-0.77,0.91,-1.35,0.08,-1.12,2.28,0.29,1.03,-0.77,0.54,1.25,1,0.62,-0.98,0.07,-0.16,1.91,0.5,-0.16,-0.28,-0.68,-0.48,-0.27,-0.17,0.01,0.01,0.12,1.32,0.29,-1.24,0.56,0.37,-0.48,0.22,0.29,0.33,-0.31,0.23,-0.09,0.7,0.28,1.5,0.45,-0,0.68,-1.45,-0.11,-0.83,0.22,0.41,0.45,0.82,1.3,0.12,2.53,0.82,-0.17,0.26,-0.47,0.02,0.49,-1.05,-0.52,0.7,0.18,-0.12,1.43,-1.15,-0.35,0.03,-0.26,1.14,-0.03,-0.03,0.28,1.02,2.59,-1.21,-1.38,1.52,-0.02,1.38,1.57,-0.76,-0.28,0.1,1.21,0.1,-1.09,0.68,2.01,1.59,0.9,1.07,-1.32,-0.42,-1.71,0.03,-0.21,0.15,0.2,0.19,-0.69,-0.67,-0.37,0.92,-1.21,-0.43,0.14,-0.36,0.16,-0.23,0.06,-0.9,-0.9,1.84,-0.33,1.28,0.79,1.69,-0.89,-0.14,0.72,-1.44,0.08,-0.49,-0.68,1.18,0.85,0.62,1.69,0.88,0.49,-1.48,-1.44,0.89,0.82,1.87,-1.01,0.59,0.71,-0.83,-0.28,0.11,-2.03,1.38,-0.56,-1.25,1.42,0.66,-2.02,0.91,2.01,1.06,-0.02,0.14,0.88,-0.18,0.24,0.69,0.4,0.4,-0.33,-0.86,-0.4,1.8,-0.29,0.73,1.52,-0.27,1.44,-0.95,1.48,0.04,0.72,-1.33,-0.51,-0.18,0.82,-0.1,0.06,-0.43,-0.07,-0.85,-1.52,-0.17,-0.54,-0.94,1.39,0.3,-0.01,0.23,-1.07,-0.27,-1.26,-2.27,0.61,-1.95,0.34,2.02,-0.92,1.26,-0.13,-0.57,1.31,0.92,0.11,-0.32,-0.1,-0.93,-0.7,0.23,-0.69,-1.44,1.3,-1.08,0.42,-1.16,0.55,-0.35,0.36,0.4,-1.13,1.45,-0.28,-0.77,0.65,1.09,-0.39,0.56,-0.76,0.83,-0.59,-0.75,0.99,1.59,0.87,-1.25,-1.46,1.59,1.07,0.52,0.32,0.48,1.39,-0.62,-0.65,0.13,0.87,-0.38,-1.04,1.44,-0.28,-0.34,0.08,-0.39,0.82,-1.24,0,0.28,-0,-1.18,-1.07,0.38,2.44,0.83,0.11,0.99,-0.53,-0.85,1.23,0.22,-0.58,-1.11,0.06,0.36,0.17,1.15,0.47,-0.03,-1.18,0.67,1.12,0.63,0.05,1.78,0.2,0.43,0.19,0.83,-0.75,-2.42,0.42,1.17,-0.46,0.03,-0.43,1.64,-0.35,1.04,0.1,-0.57,-1.81,-1.91,1.29,0.69,0.2,0.03,1.08,2.28,0.96,-1.51,-0.56,-1.16,0.6,1.46,1.03,0.84,-1.47,0.17,-1.27,0.47,0.45,-1.45,0.3,2.58,0.17,0.84,0.26,-0.77,0.37,1.39,0.96,-1.08,-0.14,-1.97,1.1,0.77,0.03,-2.39,0.2,-2.82,-0.01,-0.32,0.27,0.54,-0.23,0.38,0.2,-0.73,0.61,-0.6,-0.94,0.14,1.31,-0.67,-1.41,-1.43,0.7,-0.65,-1.23,-0.19,0.33,1.72,-0.58,-0,-1.72,-0.66,1.57,1.78,0.02,0.2,-1.2,-0.57,1.15,-0.59,-0.59,-0.05,-1.52,-0.13,-1.61,-2.57,1.52,1.79,1.17,-1.02,0.59,-0.54,0.69,-0.77,-0.31,0.49,-1.85,-0.2,0.25,0.24,-0.2,1.76,0.15,0.56,0.11,-0.18,1.23,-0.35,-0.11,-0.59,-0.42,0.01,-0.31,-0.72,-0.71,-1.26,0.46,-0.03,-0.26,-0.05,-2.45,-0.26,1.31,-0.4,-0.93,0.85,0.95,1.75,1.88,-1.3,-1.42,-1.36,0.12,-0.42,0.12,-0.07,-0.86,0.01,0.37,-1.43,0.26,-0.38,-1.32,2.11,0.92,-0.7,0.66,-1.09,0.84,-0.19,-1.08,-0.68,-0.51,-0.9,-1.62,1.34,0.91,0.6,-0.09,0.18,0.78,-0.29,-0.12,-0.37,0.25,-0.49,-0.58,1.18,1.13,-0.31,-1.94,1.36,0.32,0.69,-0.89,-0.34,0.3,0.42,1.04,1.22,0.37,1.64,-0.17,0,-1.05,-2.19,1.4,-0.59,-1.04,-0.84,0.69,0.2,0.13,0.38,1.31,1.07,0.56,1.11,-1.34,0.34,-0.24,-0.79,-1.11,0.75],[-0.32,0.51,0.84,0.12,1.56,0.73,1.76,-0.41,1.22,0.51,3.62,2.42,1.81,3.11,4.07,4.93,2.98,5.56,5.06,6.33,6.87,8.42,9.82,10.58,10.6,10.15,13.95,13.94,17.2,18.08,20.6,21.54,24.14,26.7,30.99,31.94,35.17,40.46,43.85,48.89,52.15,58.49,65.72,71.96,82.85,88.2,99.68,109.03,119.37,130.92,146.46,160.53,177.53,197.34,216.85,239.35,267.93,294.56,323.46,357.36,397.63,436.54,483.44,534.21,589.01,651.14,719.98,796.89,879.77,971.83,1073.35,1184.87,1311.42,1446.74,1599.41,1766,1952.54,2158.04,2383.16,2633.2,2908.63,3215.05,3550.55,3922.65,4335.35,4788.67,5289.47,5844.79,6458.58,7133.51,7884.28,8708.78,9623.44,10631.28,11746.57,12978.6,14339.65,15843.41,17502.13,19338.11,21363.19,1.23,1.61,-0.19,2.83,-0.57,2.11,2.26,2.54,3.44,1.9,2.62,2.8,4.01,5.11,3.76,7.55,5.16,4.78,5.72,7.05,6.49,8.15,9.72,9.34,10.1,11.03,12.23,16.75,17.07,16.07,19.75,22.38,23.42,26.82,30.4,33.1,35.21,40.63,45.8,48.59,52.74,59.19,65.67,72.46,78.99,89.33,97.38,107.6,120.82,132.41,146.36,161.54,177.07,197.32,217.95,240.11,264.47,293.44,323.64,359.11,397.6,438.04,482.6,534.42,589.53,652.23,720.02,795.77,878.16,972.95,1073.71,1184.65,1310.44,1447.39,1598.2,1765.94,1954.98,2158.14,2382.93,2633.81,2908.52,3215.23,3549.2,3923.9,4334.5,4789.33,5291.1,5846.27,6460.09,7135.62,7884.15,8709.46,9623.19,10633.47,11745.43,12977.24,14339.54,15842.36,17501.58,19337.25,21367.83,0.92,1.86,1.89,0.32,1.71,1.87,2.7,1.29,2.71,0.63,2.08,3.37,1.15,2.58,3.64,4.39,6.41,4.94,5.67,5.94,7.03,7.97,9.56,10.83,10.03,11.79,15.05,13.18,14.8,17.87,19.64,22.14,23.73,27.93,30.12,30.81,35.63,39.54,45.47,49.39,54.15,58.92,66.71,73.1,78.57,86.88,96.84,108.14,119.04,132.92,145.22,162.04,176.14,195.13,217.6,240.97,265.58,294.95,323.5,360.1,397.37,438.07,484,535.25,590.78,652.21,721.65,795.81,879.77,971.71,1075.86,1184.77,1309.94,1447.43,1601.03,1767.26,1954.5,2159.34,2383.57,2634.2,2908.95,3212.04,3551.91,3922.16,4333.65,4789.54,5290.76,5845.49,6458.72,7136.78,7884.19,8711.82,9624.1,10631.33,11746.07,12977.51,14339.35,15840.94,17501.61,19336.46,21364.45,1.58,1.75,1.2,1.93,2.06,0.72,2.83,1.2,4.11,1.49,3.33,2.66,4.91,2.88,1.78,2.92,4.87,5.98,4.85,5.48,7.62,8.54,8.38,11.79,9.69,11.85,12.76,14.53,16.29,19.66,19.51,21.55,23.47,25.01,29.11,33.61,36.09,39.55,43,48.2,53.9,59.3,66.56,71.9,80.8,88.34,98.18,107.82,118.2,132.66,145.64,161.48,178.08,195.98,217.88,241.94,266.26,291.51,325,358.66,396.81,437.18,483.14,532.66,590.54,651.16,720.27,796.53,880.83,972.82,1073.96,1186.61,1311.35,1447.68,1599.9,1768.31,1952.79,2156.72,2384.61,2632.71,2908.78,3215.96,3550.1,3922.82,4335.33,4790.97,5291.06,5846.02,6459.29,7135.23,7880.7,8710.27,9623.83,10632.43,11745.85,12979.14,14339.63,15841.78,17502.09,19337.55,21363.85,1.84,2.06,2.37,1.08,0.85,3.01,1.65,1.28,1.85,2,2.6,1.72,2.76,4.13,3.83,3.24,4,5.25,6.32,8.04,7.17,8.06,9.2,10.54,9.34,12.54,13.42,13.21,19.67,16.96,18.9,21.56,24.43,25.77,30.43,31.97,35.17,39.72,43.12,50.35,53.54,61.1,65.24,72.19,82.36,89.14,97.18,108.31,121.37,131.86,145.8,160.63,179.09,196.74,216.51,240.61,265.48,292.53,326,359.21,397.28,437.46,485.04,532.67,589.01,653.15,720.58,795.9,879.65,971.19,1073.05,1184.48,1310.83,1446.76,1600.41,1766.68,1953.34,2157.32,2382.85,2631.75,2909.3,3213.66,3551.46,3922.51,4335.37,4788.75,5291.76,5845.22,6459.97,7136.04,7881.96,8710.42,9621.38,10631.9,11746.89,12978.36,14337.69,15842.13,17501.51,19337.53,21362.06,1.67,0.39,0.47,0.78,1.33,0.88,2.73,0.66,2.3,1.33,4.99,3.28,4.34,2.88,4.58,5.71,5.93,6.07,5.04,6.72,7.18,10.02,9.46,9.74,10.66,11.41,12.88,14.49,16.13,18.02,19.91,22.11,25.61,27.13,28.41,33.32,36.57,39.51,44.41,49.11,54.27,59.28,66.07,72.65,81.06,89.07,99.6,108.83,119.74,132.98,144.72,161.38,177.59,197.34,218.2,241.07,266.66,295.01,324.63,361.05,396.93,437.47,483.77,533.73,590.23,652.57,719.39,795.45,880.11,971.78,1073.34,1187.42,1309.17,1447.34,1599.49,1766.87,1953.53,2157.04,2383.17,2633.32,2910.09,3216.63,3549.77,3921.86,4336.05,4788.92,5292.36,5847.22,6457.71,7135.26,7883.68,8711.26,9623.25,10630.9,11747.26,12980.02,14340.14,15842.61,17503.53,19335.99,21364.09,-0.71,1.13,1.01,1.5,1.69,1.84,1.13,1.34,1.85,3.37,1.5,2.56,3.45,3.29,4.2,4.23,4.99,4.55,5.12,8.49,7.01,9.39,9.75,11.59,10.05,11.95,14.08,13.32,16.38,17.52,19.22,23.17,25.14,27.46,31.34,33.64,36.69,38.51,42.75,49.71,54.76,61.46,64.83,73.33,81.07,87.96,97.82,108.49,117.71,133.68,145.61,160.24,179.84,197.78,215.77,241.53,267.85,294.77,324.49,358.66,396.99,437.46,483.75,534.89,590.61,652.48,720.11,795.11,879.01,973.4,1073.17,1186.72,1311.84,1447.42,1600.9,1766.18,1953.87,2157.11,2383.92,2631.71,2908.56,3213.86,3551.8,3923.14,4334.59,4788.51,5290.91,5844.8,6456.95,7135.37,7883.04,8709.11,9624.54,10632.29,11746.57,12978.24,14337.48,15841.44,17501.2,19335.04,21365.12,-0.95,1.44,3.24,0.43,2.75,1.52,1.25,3.32,3.14,2.56,2.39,2.89,2.38,2.95,4.27,3.77,3.49,6.75,4.94,7.07,6.18,8.66,8.61,10.26,11.34,10.96,14.81,14.48,15.53,18.66,20.99,21.6,24.85,26.08,30.48,32.17,35.45,40.98,45.78,49.69,52.69,58.13,67.43,73.81,80.88,89.11,98.58,109.77,119.12,131.65,146.3,162.36,178.04,196.08,219.23,240.34,265.5,293.79,324.12,359.34,394.87,437.64,483.79,534.2,589.03,651.01,720.82,798.41,880.24,971.71,1074.45,1185.46,1309.47,1448.92,1599.68,1766.55,1951.28,2157.13,2383.56,2633.21,2910.22,3214.51,3550.95,3922.06,4335.2,4790.06,5291.61,5845.7,6460.25,7135.74,7884.01,8710.24,9623.98,10631.24,11744.16,12978.43,14339.72,15841.25,17502.49,19336.88,21366.15,0.65,2.14,1.32,0.78,-0.32,-0.26,3.11,2.7,2.42,2.48,3.79,5.27,4.27,2.14,3.48,3.3,5.53,6.91,7.05,7.49,5.87,8.28,7.69,10.37,11.39,10.64,13.66,17.34,16.47,18.85,20.16,21.22,24.66,28.23,30.61,31.68,36.06,38.02,45.29,49.59,53.97,57.2,66.04,69.92,80.35,88.47,98.37,108.92,119.51,132.68,146.37,160.76,179.03,196.52,216.85,240.76,267.15,293.04,323.1,357.09,396.81,436.99,482.28,534.01,590.54,653.8,719.86,795.97,877.69,970.94,1075.03,1187.77,1310.34,1447.89,1598.26,1766.56,1953.54,2156.48,2382.61,2632.99,2907.55,3213.91,3549.37,3920.67,4336.05,4790.73,5292.15,5844.63,6459.06,7135,7884.27,8709.28,9622.84,10632.48,11744.73,12977.81,14338.8,15841.95,17502.26,19339.07,21364.66,1.56,1.21,1.04,2.58,1.14,1.54,1.23,1.59,2.23,2.14,1.99,2.28,2.05,4.11,4.01,4.2,4.88,3,5.76,7.96,6.94,7.18,9.81,10.85,12.69,13.97,12.06,13.34,14.94,18.13,19.48,22.11,24.22,25.98,29.66,33.13,34.77,40.25,43.81,47.5,56.05,60.51,65.14,73.4,79.27,89.63,97.91,107.3,119.06,131.79,145.27,159.87,179.76,198.03,218.39,240.53,266.02,294.49,324.22,358.4,395.74,437.89,483.02,533.62,591.39,653.21,720.13,794.03,880.77,971.92,1074.15,1185.1,1309.98,1447.99,1599.88,1768.17,1953.61,2157.44,2384.84,2632.87,2909.07,3212.99,3548.79,3924.64,4333.94,4787.9,5290.14,5846.34,6458.67,7135.67,7883.96,8711.36,9624.22,10632.55,11747.69,12976.67,14338.89,15841.47,17501.67,19336.2,21365.26]],"container":"<table class=\"display\">\n <thead>\n <tr>\n <th> <\/th>\n <th>x<\/th>\n <th>y_hat<\/th>\n <th>e<\/th>\n <th>y<\/th>\n <\/tr>\n <\/thead>\n<\/table>","options":{"pageLength":7,"columnDefs":[{"className":"dt-right","targets":[1,2,3,4]},{"orderable":false,"targets":0}],"order":[],"autoWidth":false,"orderClasses":false,"lengthMenu":[7,10,25,50,100]}},"evals":[],"jsHooks":[]}</script> --- # Exponentiellen Zusammenhang visualisieren .pull-left[ ```r ggplot(d2) + aes(x = x, y = y) + geom_point() + geom_smooth() ``` ] .pull-right[  ] Steigt X um 1 Einheit, so steigt Y um einen konstanten Faktor: exponentielles Wachstum. --- # Log-Y-Regression in R ```r lm_logy <- lm(log(y) ~ x, data = filter(d2, y > 0)) lm_logy ``` ``` ## ## Call: ## lm(formula = log(y) ~ x, data = filter(d2, y > 0)) ## ## Coefficients: ## (Intercept) x ## -0.04559 0.10033 ``` *Achtung*: Für negative Zahlen ist der Logarithmus nicht definiert. --- # Interpretation einer Log-Y-Regression .bg-light-blue.b--dark-blue.bw2.br3.shadow-5.ph4.mt5[ .center[Log-Y-Regression modelliert exponentiellen Zusammenhang]] Kleine Koeffizienten `\([-0.3;0.3]\)` lassen sich ohne delogarithmieren als Wachstumsfaktoren interpretieren: ```r coef(lm_logy) ``` ``` ## (Intercept) x ## -0.04559037 0.10032727 ``` ```r exp(0.1) ``` ``` ## [1] 1.105171 ``` "Zwei Beobachtungen die sich um eine Einheit in X unterscheiden, unterscheiden sich etwa um 10% in Y". --- # Wann soll ich eine Log-Y-Regression verwenden? ## Verwenden Sie die Log-Y-Regression, wenn Sie von einem exponentiellen Zusammenhang ausgehen. Beispiele: - Wachstumsprozesse (z.B. Bevölkerung, Corona, Bakterien, radiokativer Zerfall) - Verzinsung <i class="fas fa-exclamation-triangle"></i> Wenn sich Y um einen konstanten *Faktor* verändert, wenn sich X um einen konstanten *Wert* verändert, ist eine Log-Y-Regression sinnvoll. --- # Multiple LogY-Regression Ein lineare Modell in der Log-Skalierung entspricht einem multiplikativen Modell in der ursprünglichen Skalierung: `$$log (y) = b_0 + b_1x_1 + b_2x_2 + \ldots + \epsilon$$` Exponenziert man beide Seiten, so erhält man `$$y= e^{b_0 + b_1x_1 + b_2x_2 + \ldots + \epsilon}$$` $$y = e^{b_0} \cdot e^{b_1x_1} \cdot e^{b_2x_2} \cdot \ldots \cdot e^{\epsilon} $$ 💡 Y wird hier als multiplikative Funktion der Prädiktoren modelliert. --- name: log-log-regression class: center, middle, inverse # LogY-LogX-Regression --- # LogY-LogX-Regression `$$y = x^2$$` Logarithmiert man beide Seiten, erhält man: `$$log(y) = 2 log(x)$$` Sowohl Y als auch X sind logarithmiert. Eine Log-Log-Regression stellt also eine *Potenzfunktion* dar. 💡 Verwenden Sie die Log-Log-Regression, um quadratische (oder kubische...) Zusammenhänge zu modellieren. --- # `d3`: Daten für Zusammenhänge nach einer Potenzfunktion ```r d3 <- tibble( x = rep(0:100, 100), y_hat = x^2, e = rnorm(n = (101)*100) %>% round(2), y = y_hat + e ) ``` Hier am Beispiel einer Quadratfunktion. --- # So sieht der Datensatz `d3` aus <div id="htmlwidget-d2f62f53291053cffc30" style="width:100%;height:auto;" class="datatables html-widget"></div> <script type="application/json" data-for="htmlwidget-d2f62f53291053cffc30">{"x":{"filter":"none","data":[["1","2","3","4","5","6","7","8","9","10","11","12","13","14","15","16","17","18","19","20","21","22","23","24","25","26","27","28","29","30","31","32","33","34","35","36","37","38","39","40","41","42","43","44","45","46","47","48","49","50","51","52","53","54","55","56","57","58","59","60","61","62","63","64","65","66","67","68","69","70","71","72","73","74","75","76","77","78","79","80","81","82","83","84","85","86","87","88","89","90","91","92","93","94","95","96","97","98","99","100","101","102","103","104","105","106","107","108","109","110","111","112","113","114","115","116","117","118","119","120","121","122","123","124","125","126","127","128","129","130","131","132","133","134","135","136","137","138","139","140","141","142","143","144","145","146","147","148","149","150","151","152","153","154","155","156","157","158","159","160","161","162","163","164","165","166","167","168","169","170","171","172","173","174","175","176","177","178","179","180","181","182","183","184","185","186","187","188","189","190","191","192","193","194","195","196","197","198","199","200","201","202","203","204","205","206","207","208","209","210","211","212","213","214","215","216","217","218","219","220","221","222","223","224","225","226","227","228","229","230","231","232","233","234","235","236","237","238","239","240","241","242","243","244","245","246","247","248","249","250","251","252","253","254","255","256","257","258","259","260","261","262","263","264","265","266","267","268","269","270","271","272","273","274","275","276","277","278","279","280","281","282","283","284","285","286","287","288","289","290","291","292","293","294","295","296","297","298","299","300","301","302","303","304","305","306","307","308","309","310","311","312","313","314","315","316","317","318","319","320","321","322","323","324","325","326","327","328","329","330","331","332","333","334","335","336","337","338","339","340","341","342","343","344","345","346","347","348","349","350","351","352","353","354","355","356","357","358","359","360","361","362","363","364","365","366","367","368","369","370","371","372","373","374","375","376","377","378","379","380","381","382","383","384","385","386","387","388","389","390","391","392","393","394","395","396","397","398","399","400","401","402","403","404","405","406","407","408","409","410","411","412","413","414","415","416","417","418","419","420","421","422","423","424","425","426","427","428","429","430","431","432","433","434","435","436","437","438","439","440","441","442","443","444","445","446","447","448","449","450","451","452","453","454","455","456","457","458","459","460","461","462","463","464","465","466","467","468","469","470","471","472","473","474","475","476","477","478","479","480","481","482","483","484","485","486","487","488","489","490","491","492","493","494","495","496","497","498","499","500","501","502","503","504","505","506","507","508","509","510","511","512","513","514","515","516","517","518","519","520","521","522","523","524","525","526","527","528","529","530","531","532","533","534","535","536","537","538","539","540","541","542","543","544","545","546","547","548","549","550","551","552","553","554","555","556","557","558","559","560","561","562","563","564","565","566","567","568","569","570","571","572","573","574","575","576","577","578","579","580","581","582","583","584","585","586","587","588","589","590","591","592","593","594","595","596","597","598","599","600","601","602","603","604","605","606","607","608","609","610","611","612","613","614","615","616","617","618","619","620","621","622","623","624","625","626","627","628","629","630","631","632","633","634","635","636","637","638","639","640","641","642","643","644","645","646","647","648","649","650","651","652","653","654","655","656","657","658","659","660","661","662","663","664","665","666","667","668","669","670","671","672","673","674","675","676","677","678","679","680","681","682","683","684","685","686","687","688","689","690","691","692","693","694","695","696","697","698","699","700","701","702","703","704","705","706","707","708","709","710","711","712","713","714","715","716","717","718","719","720","721","722","723","724","725","726","727","728","729","730","731","732","733","734","735","736","737","738","739","740","741","742","743","744","745","746","747","748","749","750","751","752","753","754","755","756","757","758","759","760","761","762","763","764","765","766","767","768","769","770","771","772","773","774","775","776","777","778","779","780","781","782","783","784","785","786","787","788","789","790","791","792","793","794","795","796","797","798","799","800","801","802","803","804","805","806","807","808","809","810","811","812","813","814","815","816","817","818","819","820","821","822","823","824","825","826","827","828","829","830","831","832","833","834","835","836","837","838","839","840","841","842","843","844","845","846","847","848","849","850","851","852","853","854","855","856","857","858","859","860","861","862","863","864","865","866","867","868","869","870","871","872","873","874","875","876","877","878","879","880","881","882","883","884","885","886","887","888","889","890","891","892","893","894","895","896","897","898","899","900","901","902","903","904","905","906","907","908","909","910","911","912","913","914","915","916","917","918","919","920","921","922","923","924","925","926","927","928","929","930","931","932","933","934","935","936","937","938","939","940","941","942","943","944","945","946","947","948","949","950","951","952","953","954","955","956","957","958","959","960","961","962","963","964","965","966","967","968","969","970","971","972","973","974","975","976","977","978","979","980","981","982","983","984","985","986","987","988","989","990","991","992","993","994","995","996","997","998","999","1000","1001","1002","1003","1004","1005","1006","1007","1008","1009","1010","1011","1012","1013","1014","1015","1016","1017","1018","1019","1020","1021","1022","1023","1024","1025","1026","1027","1028","1029","1030","1031","1032","1033","1034","1035","1036","1037","1038","1039","1040","1041","1042","1043","1044","1045","1046","1047","1048","1049","1050","1051","1052","1053","1054","1055","1056","1057","1058","1059","1060","1061","1062","1063","1064","1065","1066","1067","1068","1069","1070","1071","1072","1073","1074","1075","1076","1077","1078","1079","1080","1081","1082","1083","1084","1085","1086","1087","1088","1089","1090","1091","1092","1093","1094","1095","1096","1097","1098","1099","1100","1101","1102","1103","1104","1105","1106","1107","1108","1109","1110","1111","1112","1113","1114","1115","1116","1117","1118","1119","1120","1121","1122","1123","1124","1125","1126","1127","1128","1129","1130","1131","1132","1133","1134","1135","1136","1137","1138","1139","1140","1141","1142","1143","1144","1145","1146","1147","1148","1149","1150","1151","1152","1153","1154","1155","1156","1157","1158","1159","1160","1161","1162","1163","1164","1165","1166","1167","1168","1169","1170","1171","1172","1173","1174","1175","1176","1177","1178","1179","1180","1181","1182","1183","1184","1185","1186","1187","1188","1189","1190","1191","1192","1193","1194","1195","1196","1197","1198","1199","1200","1201","1202","1203","1204","1205","1206","1207","1208","1209","1210","1211","1212","1213","1214","1215","1216","1217","1218","1219","1220","1221","1222","1223","1224","1225","1226","1227","1228","1229","1230","1231","1232","1233","1234","1235","1236","1237","1238","1239","1240","1241","1242","1243","1244","1245","1246","1247","1248","1249","1250","1251","1252","1253","1254","1255","1256","1257","1258","1259","1260","1261","1262","1263","1264","1265","1266","1267","1268","1269","1270","1271","1272","1273","1274","1275","1276","1277","1278","1279","1280","1281","1282","1283","1284","1285","1286","1287","1288","1289","1290","1291","1292","1293","1294","1295","1296","1297","1298","1299","1300","1301","1302","1303","1304","1305","1306","1307","1308","1309","1310","1311","1312","1313","1314","1315","1316","1317","1318","1319","1320","1321","1322","1323","1324","1325","1326","1327","1328","1329","1330","1331","1332","1333","1334","1335","1336","1337","1338","1339","1340","1341","1342","1343","1344","1345","1346","1347","1348","1349","1350","1351","1352","1353","1354","1355","1356","1357","1358","1359","1360","1361","1362","1363","1364","1365","1366","1367","1368","1369","1370","1371","1372","1373","1374","1375","1376","1377","1378","1379","1380","1381","1382","1383","1384","1385","1386","1387","1388","1389","1390","1391","1392","1393","1394","1395","1396","1397","1398","1399","1400","1401","1402","1403","1404","1405","1406","1407","1408","1409","1410","1411","1412","1413","1414","1415","1416","1417","1418","1419","1420","1421","1422","1423","1424","1425","1426","1427","1428","1429","1430","1431","1432","1433","1434","1435","1436","1437","1438","1439","1440","1441","1442","1443","1444","1445","1446","1447","1448","1449","1450","1451","1452","1453","1454","1455","1456","1457","1458","1459","1460","1461","1462","1463","1464","1465","1466","1467","1468","1469","1470","1471","1472","1473","1474","1475","1476","1477","1478","1479","1480","1481","1482","1483","1484","1485","1486","1487","1488","1489","1490","1491","1492","1493","1494","1495","1496","1497","1498","1499","1500","1501","1502","1503","1504","1505","1506","1507","1508","1509","1510","1511","1512","1513","1514","1515","1516","1517","1518","1519","1520","1521","1522","1523","1524","1525","1526","1527","1528","1529","1530","1531","1532","1533","1534","1535","1536","1537","1538","1539","1540","1541","1542","1543","1544","1545","1546","1547","1548","1549","1550","1551","1552","1553","1554","1555","1556","1557","1558","1559","1560","1561","1562","1563","1564","1565","1566","1567","1568","1569","1570","1571","1572","1573","1574","1575","1576","1577","1578","1579","1580","1581","1582","1583","1584","1585","1586","1587","1588","1589","1590","1591","1592","1593","1594","1595","1596","1597","1598","1599","1600","1601","1602","1603","1604","1605","1606","1607","1608","1609","1610","1611","1612","1613","1614","1615","1616","1617","1618","1619","1620","1621","1622","1623","1624","1625","1626","1627","1628","1629","1630","1631","1632","1633","1634","1635","1636","1637","1638","1639","1640","1641","1642","1643","1644","1645","1646","1647","1648","1649","1650","1651","1652","1653","1654","1655","1656","1657","1658","1659","1660","1661","1662","1663","1664","1665","1666","1667","1668","1669","1670","1671","1672","1673","1674","1675","1676","1677","1678","1679","1680","1681","1682","1683","1684","1685","1686","1687","1688","1689","1690","1691","1692","1693","1694","1695","1696","1697","1698","1699","1700","1701","1702","1703","1704","1705","1706","1707","1708","1709","1710","1711","1712","1713","1714","1715","1716","1717","1718","1719","1720","1721","1722","1723","1724","1725","1726","1727","1728","1729","1730","1731","1732","1733","1734","1735","1736","1737","1738","1739","1740","1741","1742","1743","1744","1745","1746","1747","1748","1749","1750","1751","1752","1753","1754","1755","1756","1757","1758","1759","1760","1761","1762","1763","1764","1765","1766","1767","1768","1769","1770","1771","1772","1773","1774","1775","1776","1777","1778","1779","1780","1781","1782","1783","1784","1785","1786","1787","1788","1789","1790","1791","1792","1793","1794","1795","1796","1797","1798","1799","1800","1801","1802","1803","1804","1805","1806","1807","1808","1809","1810","1811","1812","1813","1814","1815","1816","1817","1818","1819","1820","1821","1822","1823","1824","1825","1826","1827","1828","1829","1830","1831","1832","1833","1834","1835","1836","1837","1838","1839","1840","1841","1842","1843","1844","1845","1846","1847","1848","1849","1850","1851","1852","1853","1854","1855","1856","1857","1858","1859","1860","1861","1862","1863","1864","1865","1866","1867","1868","1869","1870","1871","1872","1873","1874","1875","1876","1877","1878","1879","1880","1881","1882","1883","1884","1885","1886","1887","1888","1889","1890","1891","1892","1893","1894","1895","1896","1897","1898","1899","1900","1901","1902","1903","1904","1905","1906","1907","1908","1909","1910","1911","1912","1913","1914","1915","1916","1917","1918","1919","1920","1921","1922","1923","1924","1925","1926","1927","1928","1929","1930","1931","1932","1933","1934","1935","1936","1937","1938","1939","1940","1941","1942","1943","1944","1945","1946","1947","1948","1949","1950","1951","1952","1953","1954","1955","1956","1957","1958","1959","1960","1961","1962","1963","1964","1965","1966","1967","1968","1969","1970","1971","1972","1973","1974","1975","1976","1977","1978","1979","1980","1981","1982","1983","1984","1985","1986","1987","1988","1989","1990","1991","1992","1993","1994","1995","1996","1997","1998","1999","2000","2001","2002","2003","2004","2005","2006","2007","2008","2009","2010","2011","2012","2013","2014","2015","2016","2017","2018","2019","2020","2021","2022","2023","2024","2025","2026","2027","2028","2029","2030","2031","2032","2033","2034","2035","2036","2037","2038","2039","2040","2041","2042","2043","2044","2045","2046","2047","2048","2049","2050","2051","2052","2053","2054","2055","2056","2057","2058","2059","2060","2061","2062","2063","2064","2065","2066","2067","2068","2069","2070","2071","2072","2073","2074","2075","2076","2077","2078","2079","2080","2081","2082","2083","2084","2085","2086","2087","2088","2089","2090","2091","2092","2093","2094","2095","2096","2097","2098","2099","2100","2101","2102","2103","2104","2105","2106","2107","2108","2109","2110","2111","2112","2113","2114","2115","2116","2117","2118","2119","2120","2121","2122","2123","2124","2125","2126","2127","2128","2129","2130","2131","2132","2133","2134","2135","2136","2137","2138","2139","2140","2141","2142","2143","2144","2145","2146","2147","2148","2149","2150","2151","2152","2153","2154","2155","2156","2157","2158","2159","2160","2161","2162","2163","2164","2165","2166","2167","2168","2169","2170","2171","2172","2173","2174","2175","2176","2177","2178","2179","2180","2181","2182","2183","2184","2185","2186","2187","2188","2189","2190","2191","2192","2193","2194","2195","2196","2197","2198","2199","2200","2201","2202","2203","2204","2205","2206","2207","2208","2209","2210","2211","2212","2213","2214","2215","2216","2217","2218","2219","2220","2221","2222","2223","2224","2225","2226","2227","2228","2229","2230","2231","2232","2233","2234","2235","2236","2237","2238","2239","2240","2241","2242","2243","2244","2245","2246","2247","2248","2249","2250","2251","2252","2253","2254","2255","2256","2257","2258","2259","2260","2261","2262","2263","2264","2265","2266","2267","2268","2269","2270","2271","2272","2273","2274","2275","2276","2277","2278","2279","2280","2281","2282","2283","2284","2285","2286","2287","2288","2289","2290","2291","2292","2293","2294","2295","2296","2297","2298","2299","2300","2301","2302","2303","2304","2305","2306","2307","2308","2309","2310","2311","2312","2313","2314","2315","2316","2317","2318","2319","2320","2321","2322","2323","2324","2325","2326","2327","2328","2329","2330","2331","2332","2333","2334","2335","2336","2337","2338","2339","2340","2341","2342","2343","2344","2345","2346","2347","2348","2349","2350","2351","2352","2353","2354","2355","2356","2357","2358","2359","2360","2361","2362","2363","2364","2365","2366","2367","2368","2369","2370","2371","2372","2373","2374","2375","2376","2377","2378","2379","2380","2381","2382","2383","2384","2385","2386","2387","2388","2389","2390","2391","2392","2393","2394","2395","2396","2397","2398","2399","2400","2401","2402","2403","2404","2405","2406","2407","2408","2409","2410","2411","2412","2413","2414","2415","2416","2417","2418","2419","2420","2421","2422","2423","2424","2425","2426","2427","2428","2429","2430","2431","2432","2433","2434","2435","2436","2437","2438","2439","2440","2441","2442","2443","2444","2445","2446","2447","2448","2449","2450","2451","2452","2453","2454","2455","2456","2457","2458","2459","2460","2461","2462","2463","2464","2465","2466","2467","2468","2469","2470","2471","2472","2473","2474","2475","2476","2477","2478","2479","2480","2481","2482","2483","2484","2485","2486","2487","2488","2489","2490","2491","2492","2493","2494","2495","2496","2497","2498","2499","2500","2501","2502","2503","2504","2505","2506","2507","2508","2509","2510","2511","2512","2513","2514","2515","2516","2517","2518","2519","2520","2521","2522","2523","2524","2525","2526","2527","2528","2529","2530","2531","2532","2533","2534","2535","2536","2537","2538","2539","2540","2541","2542","2543","2544","2545","2546","2547","2548","2549","2550","2551","2552","2553","2554","2555","2556","2557","2558","2559","2560","2561","2562","2563","2564","2565","2566","2567","2568","2569","2570","2571","2572","2573","2574","2575","2576","2577","2578","2579","2580","2581","2582","2583","2584","2585","2586","2587","2588","2589","2590","2591","2592","2593","2594","2595","2596","2597","2598","2599","2600","2601","2602","2603","2604","2605","2606","2607","2608","2609","2610","2611","2612","2613","2614","2615","2616","2617","2618","2619","2620","2621","2622","2623","2624","2625","2626","2627","2628","2629","2630","2631","2632","2633","2634","2635","2636","2637","2638","2639","2640","2641","2642","2643","2644","2645","2646","2647","2648","2649","2650","2651","2652","2653","2654","2655","2656","2657","2658","2659","2660","2661","2662","2663","2664","2665","2666","2667","2668","2669","2670","2671","2672","2673","2674","2675","2676","2677","2678","2679","2680","2681","2682","2683","2684","2685","2686","2687","2688","2689","2690","2691","2692","2693","2694","2695","2696","2697","2698","2699","2700","2701","2702","2703","2704","2705","2706","2707","2708","2709","2710","2711","2712","2713","2714","2715","2716","2717","2718","2719","2720","2721","2722","2723","2724","2725","2726","2727","2728","2729","2730","2731","2732","2733","2734","2735","2736","2737","2738","2739","2740","2741","2742","2743","2744","2745","2746","2747","2748","2749","2750","2751","2752","2753","2754","2755","2756","2757","2758","2759","2760","2761","2762","2763","2764","2765","2766","2767","2768","2769","2770","2771","2772","2773","2774","2775","2776","2777","2778","2779","2780","2781","2782","2783","2784","2785","2786","2787","2788","2789","2790","2791","2792","2793","2794","2795","2796","2797","2798","2799","2800","2801","2802","2803","2804","2805","2806","2807","2808","2809","2810","2811","2812","2813","2814","2815","2816","2817","2818","2819","2820","2821","2822","2823","2824","2825","2826","2827","2828","2829","2830","2831","2832","2833","2834","2835","2836","2837","2838","2839","2840","2841","2842","2843","2844","2845","2846","2847","2848","2849","2850","2851","2852","2853","2854","2855","2856","2857","2858","2859","2860","2861","2862","2863","2864","2865","2866","2867","2868","2869","2870","2871","2872","2873","2874","2875","2876","2877","2878","2879","2880","2881","2882","2883","2884","2885","2886","2887","2888","2889","2890","2891","2892","2893","2894","2895","2896","2897","2898","2899","2900","2901","2902","2903","2904","2905","2906","2907","2908","2909","2910","2911","2912","2913","2914","2915","2916","2917","2918","2919","2920","2921","2922","2923","2924","2925","2926","2927","2928","2929","2930","2931","2932","2933","2934","2935","2936","2937","2938","2939","2940","2941","2942","2943","2944","2945","2946","2947","2948","2949","2950","2951","2952","2953","2954","2955","2956","2957","2958","2959","2960","2961","2962","2963","2964","2965","2966","2967","2968","2969","2970","2971","2972","2973","2974","2975","2976","2977","2978","2979","2980","2981","2982","2983","2984","2985","2986","2987","2988","2989","2990","2991","2992","2993","2994","2995","2996","2997","2998","2999","3000","3001","3002","3003","3004","3005","3006","3007","3008","3009","3010","3011","3012","3013","3014","3015","3016","3017","3018","3019","3020","3021","3022","3023","3024","3025","3026","3027","3028","3029","3030","3031","3032","3033","3034","3035","3036","3037","3038","3039","3040","3041","3042","3043","3044","3045","3046","3047","3048","3049","3050","3051","3052","3053","3054","3055","3056","3057","3058","3059","3060","3061","3062","3063","3064","3065","3066","3067","3068","3069","3070","3071","3072","3073","3074","3075","3076","3077","3078","3079","3080","3081","3082","3083","3084","3085","3086","3087","3088","3089","3090","3091","3092","3093","3094","3095","3096","3097","3098","3099","3100","3101","3102","3103","3104","3105","3106","3107","3108","3109","3110","3111","3112","3113","3114","3115","3116","3117","3118","3119","3120","3121","3122","3123","3124","3125","3126","3127","3128","3129","3130","3131","3132","3133","3134","3135","3136","3137","3138","3139","3140","3141","3142","3143","3144","3145","3146","3147","3148","3149","3150","3151","3152","3153","3154","3155","3156","3157","3158","3159","3160","3161","3162","3163","3164","3165","3166","3167","3168","3169","3170","3171","3172","3173","3174","3175","3176","3177","3178","3179","3180","3181","3182","3183","3184","3185","3186","3187","3188","3189","3190","3191","3192","3193","3194","3195","3196","3197","3198","3199","3200","3201","3202","3203","3204","3205","3206","3207","3208","3209","3210","3211","3212","3213","3214","3215","3216","3217","3218","3219","3220","3221","3222","3223","3224","3225","3226","3227","3228","3229","3230","3231","3232","3233","3234","3235","3236","3237","3238","3239","3240","3241","3242","3243","3244","3245","3246","3247","3248","3249","3250","3251","3252","3253","3254","3255","3256","3257","3258","3259","3260","3261","3262","3263","3264","3265","3266","3267","3268","3269","3270","3271","3272","3273","3274","3275","3276","3277","3278","3279","3280","3281","3282","3283","3284","3285","3286","3287","3288","3289","3290","3291","3292","3293","3294","3295","3296","3297","3298","3299","3300","3301","3302","3303","3304","3305","3306","3307","3308","3309","3310","3311","3312","3313","3314","3315","3316","3317","3318","3319","3320","3321","3322","3323","3324","3325","3326","3327","3328","3329","3330","3331","3332","3333","3334","3335","3336","3337","3338","3339","3340","3341","3342","3343","3344","3345","3346","3347","3348","3349","3350","3351","3352","3353","3354","3355","3356","3357","3358","3359","3360","3361","3362","3363","3364","3365","3366","3367","3368","3369","3370","3371","3372","3373","3374","3375","3376","3377","3378","3379","3380","3381","3382","3383","3384","3385","3386","3387","3388","3389","3390","3391","3392","3393","3394","3395","3396","3397","3398","3399","3400","3401","3402","3403","3404","3405","3406","3407","3408","3409","3410","3411","3412","3413","3414","3415","3416","3417","3418","3419","3420","3421","3422","3423","3424","3425","3426","3427","3428","3429","3430","3431","3432","3433","3434","3435","3436","3437","3438","3439","3440","3441","3442","3443","3444","3445","3446","3447","3448","3449","3450","3451","3452","3453","3454","3455","3456","3457","3458","3459","3460","3461","3462","3463","3464","3465","3466","3467","3468","3469","3470","3471","3472","3473","3474","3475","3476","3477","3478","3479","3480","3481","3482","3483","3484","3485","3486","3487","3488","3489","3490","3491","3492","3493","3494","3495","3496","3497","3498","3499","3500","3501","3502","3503","3504","3505","3506","3507","3508","3509","3510","3511","3512","3513","3514","3515","3516","3517","3518","3519","3520","3521","3522","3523","3524","3525","3526","3527","3528","3529","3530","3531","3532","3533","3534","3535","3536","3537","3538","3539","3540","3541","3542","3543","3544","3545","3546","3547","3548","3549","3550","3551","3552","3553","3554","3555","3556","3557","3558","3559","3560","3561","3562","3563","3564","3565","3566","3567","3568","3569","3570","3571","3572","3573","3574","3575","3576","3577","3578","3579","3580","3581","3582","3583","3584","3585","3586","3587","3588","3589","3590","3591","3592","3593","3594","3595","3596","3597","3598","3599","3600","3601","3602","3603","3604","3605","3606","3607","3608","3609","3610","3611","3612","3613","3614","3615","3616","3617","3618","3619","3620","3621","3622","3623","3624","3625","3626","3627","3628","3629","3630","3631","3632","3633","3634","3635","3636","3637","3638","3639","3640","3641","3642","3643","3644","3645","3646","3647","3648","3649","3650","3651","3652","3653","3654","3655","3656","3657","3658","3659","3660","3661","3662","3663","3664","3665","3666","3667","3668","3669","3670","3671","3672","3673","3674","3675","3676","3677","3678","3679","3680","3681","3682","3683","3684","3685","3686","3687","3688","3689","3690","3691","3692","3693","3694","3695","3696","3697","3698","3699","3700","3701","3702","3703","3704","3705","3706","3707","3708","3709","3710","3711","3712","3713","3714","3715","3716","3717","3718","3719","3720","3721","3722","3723","3724","3725","3726","3727","3728","3729","3730","3731","3732","3733","3734","3735","3736","3737","3738","3739","3740","3741","3742","3743","3744","3745","3746","3747","3748","3749","3750","3751","3752","3753","3754","3755","3756","3757","3758","3759","3760","3761","3762","3763","3764","3765","3766","3767","3768","3769","3770","3771","3772","3773","3774","3775","3776","3777","3778","3779","3780","3781","3782","3783","3784","3785","3786","3787","3788","3789","3790","3791","3792","3793","3794","3795","3796","3797","3798","3799","3800","3801","3802","3803","3804","3805","3806","3807","3808","3809","3810","3811","3812","3813","3814","3815","3816","3817","3818","3819","3820","3821","3822","3823","3824","3825","3826","3827","3828","3829","3830","3831","3832","3833","3834","3835","3836","3837","3838","3839","3840","3841","3842","3843","3844","3845","3846","3847","3848","3849","3850","3851","3852","3853","3854","3855","3856","3857","3858","3859","3860","3861","3862","3863","3864","3865","3866","3867","3868","3869","3870","3871","3872","3873","3874","3875","3876","3877","3878","3879","3880","3881","3882","3883","3884","3885","3886","3887","3888","3889","3890","3891","3892","3893","3894","3895","3896","3897","3898","3899","3900","3901","3902","3903","3904","3905","3906","3907","3908","3909","3910","3911","3912","3913","3914","3915","3916","3917","3918","3919","3920","3921","3922","3923","3924","3925","3926","3927","3928","3929","3930","3931","3932","3933","3934","3935","3936","3937","3938","3939","3940","3941","3942","3943","3944","3945","3946","3947","3948","3949","3950","3951","3952","3953","3954","3955","3956","3957","3958","3959","3960","3961","3962","3963","3964","3965","3966","3967","3968","3969","3970","3971","3972","3973","3974","3975","3976","3977","3978","3979","3980","3981","3982","3983","3984","3985","3986","3987","3988","3989","3990","3991","3992","3993","3994","3995","3996","3997","3998","3999","4000","4001","4002","4003","4004","4005","4006","4007","4008","4009","4010","4011","4012","4013","4014","4015","4016","4017","4018","4019","4020","4021","4022","4023","4024","4025","4026","4027","4028","4029","4030","4031","4032","4033","4034","4035","4036","4037","4038","4039","4040","4041","4042","4043","4044","4045","4046","4047","4048","4049","4050","4051","4052","4053","4054","4055","4056","4057","4058","4059","4060","4061","4062","4063","4064","4065","4066","4067","4068","4069","4070","4071","4072","4073","4074","4075","4076","4077","4078","4079","4080","4081","4082","4083","4084","4085","4086","4087","4088","4089","4090","4091","4092","4093","4094","4095","4096","4097","4098","4099","4100","4101","4102","4103","4104","4105","4106","4107","4108","4109","4110","4111","4112","4113","4114","4115","4116","4117","4118","4119","4120","4121","4122","4123","4124","4125","4126","4127","4128","4129","4130","4131","4132","4133","4134","4135","4136","4137","4138","4139","4140","4141","4142","4143","4144","4145","4146","4147","4148","4149","4150","4151","4152","4153","4154","4155","4156","4157","4158","4159","4160","4161","4162","4163","4164","4165","4166","4167","4168","4169","4170","4171","4172","4173","4174","4175","4176","4177","4178","4179","4180","4181","4182","4183","4184","4185","4186","4187","4188","4189","4190","4191","4192","4193","4194","4195","4196","4197","4198","4199","4200","4201","4202","4203","4204","4205","4206","4207","4208","4209","4210","4211","4212","4213","4214","4215","4216","4217","4218","4219","4220","4221","4222","4223","4224","4225","4226","4227","4228","4229","4230","4231","4232","4233","4234","4235","4236","4237","4238","4239","4240","4241","4242","4243","4244","4245","4246","4247","4248","4249","4250","4251","4252","4253","4254","4255","4256","4257","4258","4259","4260","4261","4262","4263","4264","4265","4266","4267","4268","4269","4270","4271","4272","4273","4274","4275","4276","4277","4278","4279","4280","4281","4282","4283","4284","4285","4286","4287","4288","4289","4290","4291","4292","4293","4294","4295","4296","4297","4298","4299","4300","4301","4302","4303","4304","4305","4306","4307","4308","4309","4310","4311","4312","4313","4314","4315","4316","4317","4318","4319","4320","4321","4322","4323","4324","4325","4326","4327","4328","4329","4330","4331","4332","4333","4334","4335","4336","4337","4338","4339","4340","4341","4342","4343","4344","4345","4346","4347","4348","4349","4350","4351","4352","4353","4354","4355","4356","4357","4358","4359","4360","4361","4362","4363","4364","4365","4366","4367","4368","4369","4370","4371","4372","4373","4374","4375","4376","4377","4378","4379","4380","4381","4382","4383","4384","4385","4386","4387","4388","4389","4390","4391","4392","4393","4394","4395","4396","4397","4398","4399","4400","4401","4402","4403","4404","4405","4406","4407","4408","4409","4410","4411","4412","4413","4414","4415","4416","4417","4418","4419","4420","4421","4422","4423","4424","4425","4426","4427","4428","4429","4430","4431","4432","4433","4434","4435","4436","4437","4438","4439","4440","4441","4442","4443","4444","4445","4446","4447","4448","4449","4450","4451","4452","4453","4454","4455","4456","4457","4458","4459","4460","4461","4462","4463","4464","4465","4466","4467","4468","4469","4470","4471","4472","4473","4474","4475","4476","4477","4478","4479","4480","4481","4482","4483","4484","4485","4486","4487","4488","4489","4490","4491","4492","4493","4494","4495","4496","4497","4498","4499","4500","4501","4502","4503","4504","4505","4506","4507","4508","4509","4510","4511","4512","4513","4514","4515","4516","4517","4518","4519","4520","4521","4522","4523","4524","4525","4526","4527","4528","4529","4530","4531","4532","4533","4534","4535","4536","4537","4538","4539","4540","4541","4542","4543","4544","4545","4546","4547","4548","4549","4550","4551","4552","4553","4554","4555","4556","4557","4558","4559","4560","4561","4562","4563","4564","4565","4566","4567","4568","4569","4570","4571","4572","4573","4574","4575","4576","4577","4578","4579","4580","4581","4582","4583","4584","4585","4586","4587","4588","4589","4590","4591","4592","4593","4594","4595","4596","4597","4598","4599","4600","4601","4602","4603","4604","4605","4606","4607","4608","4609","4610","4611","4612","4613","4614","4615","4616","4617","4618","4619","4620","4621","4622","4623","4624","4625","4626","4627","4628","4629","4630","4631","4632","4633","4634","4635","4636","4637","4638","4639","4640","4641","4642","4643","4644","4645","4646","4647","4648","4649","4650","4651","4652","4653","4654","4655","4656","4657","4658","4659","4660","4661","4662","4663","4664","4665","4666","4667","4668","4669","4670","4671","4672","4673","4674","4675","4676","4677","4678","4679","4680","4681","4682","4683","4684","4685","4686","4687","4688","4689","4690","4691","4692","4693","4694","4695","4696","4697","4698","4699","4700","4701","4702","4703","4704","4705","4706","4707","4708","4709","4710","4711","4712","4713","4714","4715","4716","4717","4718","4719","4720","4721","4722","4723","4724","4725","4726","4727","4728","4729","4730","4731","4732","4733","4734","4735","4736","4737","4738","4739","4740","4741","4742","4743","4744","4745","4746","4747","4748","4749","4750","4751","4752","4753","4754","4755","4756","4757","4758","4759","4760","4761","4762","4763","4764","4765","4766","4767","4768","4769","4770","4771","4772","4773","4774","4775","4776","4777","4778","4779","4780","4781","4782","4783","4784","4785","4786","4787","4788","4789","4790","4791","4792","4793","4794","4795","4796","4797","4798","4799","4800","4801","4802","4803","4804","4805","4806","4807","4808","4809","4810","4811","4812","4813","4814","4815","4816","4817","4818","4819","4820","4821","4822","4823","4824","4825","4826","4827","4828","4829","4830","4831","4832","4833","4834","4835","4836","4837","4838","4839","4840","4841","4842","4843","4844","4845","4846","4847","4848","4849","4850","4851","4852","4853","4854","4855","4856","4857","4858","4859","4860","4861","4862","4863","4864","4865","4866","4867","4868","4869","4870","4871","4872","4873","4874","4875","4876","4877","4878","4879","4880","4881","4882","4883","4884","4885","4886","4887","4888","4889","4890","4891","4892","4893","4894","4895","4896","4897","4898","4899","4900","4901","4902","4903","4904","4905","4906","4907","4908","4909","4910","4911","4912","4913","4914","4915","4916","4917","4918","4919","4920","4921","4922","4923","4924","4925","4926","4927","4928","4929","4930","4931","4932","4933","4934","4935","4936","4937","4938","4939","4940","4941","4942","4943","4944","4945","4946","4947","4948","4949","4950","4951","4952","4953","4954","4955","4956","4957","4958","4959","4960","4961","4962","4963","4964","4965","4966","4967","4968","4969","4970","4971","4972","4973","4974","4975","4976","4977","4978","4979","4980","4981","4982","4983","4984","4985","4986","4987","4988","4989","4990","4991","4992","4993","4994","4995","4996","4997","4998","4999","5000","5001","5002","5003","5004","5005","5006","5007","5008","5009","5010","5011","5012","5013","5014","5015","5016","5017","5018","5019","5020","5021","5022","5023","5024","5025","5026","5027","5028","5029","5030","5031","5032","5033","5034","5035","5036","5037","5038","5039","5040","5041","5042","5043","5044","5045","5046","5047","5048","5049","5050","5051","5052","5053","5054","5055","5056","5057","5058","5059","5060","5061","5062","5063","5064","5065","5066","5067","5068","5069","5070","5071","5072","5073","5074","5075","5076","5077","5078","5079","5080","5081","5082","5083","5084","5085","5086","5087","5088","5089","5090","5091","5092","5093","5094","5095","5096","5097","5098","5099","5100","5101","5102","5103","5104","5105","5106","5107","5108","5109","5110","5111","5112","5113","5114","5115","5116","5117","5118","5119","5120","5121","5122","5123","5124","5125","5126","5127","5128","5129","5130","5131","5132","5133","5134","5135","5136","5137","5138","5139","5140","5141","5142","5143","5144","5145","5146","5147","5148","5149","5150","5151","5152","5153","5154","5155","5156","5157","5158","5159","5160","5161","5162","5163","5164","5165","5166","5167","5168","5169","5170","5171","5172","5173","5174","5175","5176","5177","5178","5179","5180","5181","5182","5183","5184","5185","5186","5187","5188","5189","5190","5191","5192","5193","5194","5195","5196","5197","5198","5199","5200","5201","5202","5203","5204","5205","5206","5207","5208","5209","5210","5211","5212","5213","5214","5215","5216","5217","5218","5219","5220","5221","5222","5223","5224","5225","5226","5227","5228","5229","5230","5231","5232","5233","5234","5235","5236","5237","5238","5239","5240","5241","5242","5243","5244","5245","5246","5247","5248","5249","5250","5251","5252","5253","5254","5255","5256","5257","5258","5259","5260","5261","5262","5263","5264","5265","5266","5267","5268","5269","5270","5271","5272","5273","5274","5275","5276","5277","5278","5279","5280","5281","5282","5283","5284","5285","5286","5287","5288","5289","5290","5291","5292","5293","5294","5295","5296","5297","5298","5299","5300","5301","5302","5303","5304","5305","5306","5307","5308","5309","5310","5311","5312","5313","5314","5315","5316","5317","5318","5319","5320","5321","5322","5323","5324","5325","5326","5327","5328","5329","5330","5331","5332","5333","5334","5335","5336","5337","5338","5339","5340","5341","5342","5343","5344","5345","5346","5347","5348","5349","5350","5351","5352","5353","5354","5355","5356","5357","5358","5359","5360","5361","5362","5363","5364","5365","5366","5367","5368","5369","5370","5371","5372","5373","5374","5375","5376","5377","5378","5379","5380","5381","5382","5383","5384","5385","5386","5387","5388","5389","5390","5391","5392","5393","5394","5395","5396","5397","5398","5399","5400","5401","5402","5403","5404","5405","5406","5407","5408","5409","5410","5411","5412","5413","5414","5415","5416","5417","5418","5419","5420","5421","5422","5423","5424","5425","5426","5427","5428","5429","5430","5431","5432","5433","5434","5435","5436","5437","5438","5439","5440","5441","5442","5443","5444","5445","5446","5447","5448","5449","5450","5451","5452","5453","5454","5455","5456","5457","5458","5459","5460","5461","5462","5463","5464","5465","5466","5467","5468","5469","5470","5471","5472","5473","5474","5475","5476","5477","5478","5479","5480","5481","5482","5483","5484","5485","5486","5487","5488","5489","5490","5491","5492","5493","5494","5495","5496","5497","5498","5499","5500","5501","5502","5503","5504","5505","5506","5507","5508","5509","5510","5511","5512","5513","5514","5515","5516","5517","5518","5519","5520","5521","5522","5523","5524","5525","5526","5527","5528","5529","5530","5531","5532","5533","5534","5535","5536","5537","5538","5539","5540","5541","5542","5543","5544","5545","5546","5547","5548","5549","5550","5551","5552","5553","5554","5555","5556","5557","5558","5559","5560","5561","5562","5563","5564","5565","5566","5567","5568","5569","5570","5571","5572","5573","5574","5575","5576","5577","5578","5579","5580","5581","5582","5583","5584","5585","5586","5587","5588","5589","5590","5591","5592","5593","5594","5595","5596","5597","5598","5599","5600","5601","5602","5603","5604","5605","5606","5607","5608","5609","5610","5611","5612","5613","5614","5615","5616","5617","5618","5619","5620","5621","5622","5623","5624","5625","5626","5627","5628","5629","5630","5631","5632","5633","5634","5635","5636","5637","5638","5639","5640","5641","5642","5643","5644","5645","5646","5647","5648","5649","5650","5651","5652","5653","5654","5655","5656","5657","5658","5659","5660","5661","5662","5663","5664","5665","5666","5667","5668","5669","5670","5671","5672","5673","5674","5675","5676","5677","5678","5679","5680","5681","5682","5683","5684","5685","5686","5687","5688","5689","5690","5691","5692","5693","5694","5695","5696","5697","5698","5699","5700","5701","5702","5703","5704","5705","5706","5707","5708","5709","5710","5711","5712","5713","5714","5715","5716","5717","5718","5719","5720","5721","5722","5723","5724","5725","5726","5727","5728","5729","5730","5731","5732","5733","5734","5735","5736","5737","5738","5739","5740","5741","5742","5743","5744","5745","5746","5747","5748","5749","5750","5751","5752","5753","5754","5755","5756","5757","5758","5759","5760","5761","5762","5763","5764","5765","5766","5767","5768","5769","5770","5771","5772","5773","5774","5775","5776","5777","5778","5779","5780","5781","5782","5783","5784","5785","5786","5787","5788","5789","5790","5791","5792","5793","5794","5795","5796","5797","5798","5799","5800","5801","5802","5803","5804","5805","5806","5807","5808","5809","5810","5811","5812","5813","5814","5815","5816","5817","5818","5819","5820","5821","5822","5823","5824","5825","5826","5827","5828","5829","5830","5831","5832","5833","5834","5835","5836","5837","5838","5839","5840","5841","5842","5843","5844","5845","5846","5847","5848","5849","5850","5851","5852","5853","5854","5855","5856","5857","5858","5859","5860","5861","5862","5863","5864","5865","5866","5867","5868","5869","5870","5871","5872","5873","5874","5875","5876","5877","5878","5879","5880","5881","5882","5883","5884","5885","5886","5887","5888","5889","5890","5891","5892","5893","5894","5895","5896","5897","5898","5899","5900","5901","5902","5903","5904","5905","5906","5907","5908","5909","5910","5911","5912","5913","5914","5915","5916","5917","5918","5919","5920","5921","5922","5923","5924","5925","5926","5927","5928","5929","5930","5931","5932","5933","5934","5935","5936","5937","5938","5939","5940","5941","5942","5943","5944","5945","5946","5947","5948","5949","5950","5951","5952","5953","5954","5955","5956","5957","5958","5959","5960","5961","5962","5963","5964","5965","5966","5967","5968","5969","5970","5971","5972","5973","5974","5975","5976","5977","5978","5979","5980","5981","5982","5983","5984","5985","5986","5987","5988","5989","5990","5991","5992","5993","5994","5995","5996","5997","5998","5999","6000","6001","6002","6003","6004","6005","6006","6007","6008","6009","6010","6011","6012","6013","6014","6015","6016","6017","6018","6019","6020","6021","6022","6023","6024","6025","6026","6027","6028","6029","6030","6031","6032","6033","6034","6035","6036","6037","6038","6039","6040","6041","6042","6043","6044","6045","6046","6047","6048","6049","6050","6051","6052","6053","6054","6055","6056","6057","6058","6059","6060","6061","6062","6063","6064","6065","6066","6067","6068","6069","6070","6071","6072","6073","6074","6075","6076","6077","6078","6079","6080","6081","6082","6083","6084","6085","6086","6087","6088","6089","6090","6091","6092","6093","6094","6095","6096","6097","6098","6099","6100","6101","6102","6103","6104","6105","6106","6107","6108","6109","6110","6111","6112","6113","6114","6115","6116","6117","6118","6119","6120","6121","6122","6123","6124","6125","6126","6127","6128","6129","6130","6131","6132","6133","6134","6135","6136","6137","6138","6139","6140","6141","6142","6143","6144","6145","6146","6147","6148","6149","6150","6151","6152","6153","6154","6155","6156","6157","6158","6159","6160","6161","6162","6163","6164","6165","6166","6167","6168","6169","6170","6171","6172","6173","6174","6175","6176","6177","6178","6179","6180","6181","6182","6183","6184","6185","6186","6187","6188","6189","6190","6191","6192","6193","6194","6195","6196","6197","6198","6199","6200","6201","6202","6203","6204","6205","6206","6207","6208","6209","6210","6211","6212","6213","6214","6215","6216","6217","6218","6219","6220","6221","6222","6223","6224","6225","6226","6227","6228","6229","6230","6231","6232","6233","6234","6235","6236","6237","6238","6239","6240","6241","6242","6243","6244","6245","6246","6247","6248","6249","6250","6251","6252","6253","6254","6255","6256","6257","6258","6259","6260","6261","6262","6263","6264","6265","6266","6267","6268","6269","6270","6271","6272","6273","6274","6275","6276","6277","6278","6279","6280","6281","6282","6283","6284","6285","6286","6287","6288","6289","6290","6291","6292","6293","6294","6295","6296","6297","6298","6299","6300","6301","6302","6303","6304","6305","6306","6307","6308","6309","6310","6311","6312","6313","6314","6315","6316","6317","6318","6319","6320","6321","6322","6323","6324","6325","6326","6327","6328","6329","6330","6331","6332","6333","6334","6335","6336","6337","6338","6339","6340","6341","6342","6343","6344","6345","6346","6347","6348","6349","6350","6351","6352","6353","6354","6355","6356","6357","6358","6359","6360","6361","6362","6363","6364","6365","6366","6367","6368","6369","6370","6371","6372","6373","6374","6375","6376","6377","6378","6379","6380","6381","6382","6383","6384","6385","6386","6387","6388","6389","6390","6391","6392","6393","6394","6395","6396","6397","6398","6399","6400","6401","6402","6403","6404","6405","6406","6407","6408","6409","6410","6411","6412","6413","6414","6415","6416","6417","6418","6419","6420","6421","6422","6423","6424","6425","6426","6427","6428","6429","6430","6431","6432","6433","6434","6435","6436","6437","6438","6439","6440","6441","6442","6443","6444","6445","6446","6447","6448","6449","6450","6451","6452","6453","6454","6455","6456","6457","6458","6459","6460","6461","6462","6463","6464","6465","6466","6467","6468","6469","6470","6471","6472","6473","6474","6475","6476","6477","6478","6479","6480","6481","6482","6483","6484","6485","6486","6487","6488","6489","6490","6491","6492","6493","6494","6495","6496","6497","6498","6499","6500","6501","6502","6503","6504","6505","6506","6507","6508","6509","6510","6511","6512","6513","6514","6515","6516","6517","6518","6519","6520","6521","6522","6523","6524","6525","6526","6527","6528","6529","6530","6531","6532","6533","6534","6535","6536","6537","6538","6539","6540","6541","6542","6543","6544","6545","6546","6547","6548","6549","6550","6551","6552","6553","6554","6555","6556","6557","6558","6559","6560","6561","6562","6563","6564","6565","6566","6567","6568","6569","6570","6571","6572","6573","6574","6575","6576","6577","6578","6579","6580","6581","6582","6583","6584","6585","6586","6587","6588","6589","6590","6591","6592","6593","6594","6595","6596","6597","6598","6599","6600","6601","6602","6603","6604","6605","6606","6607","6608","6609","6610","6611","6612","6613","6614","6615","6616","6617","6618","6619","6620","6621","6622","6623","6624","6625","6626","6627","6628","6629","6630","6631","6632","6633","6634","6635","6636","6637","6638","6639","6640","6641","6642","6643","6644","6645","6646","6647","6648","6649","6650","6651","6652","6653","6654","6655","6656","6657","6658","6659","6660","6661","6662","6663","6664","6665","6666","6667","6668","6669","6670","6671","6672","6673","6674","6675","6676","6677","6678","6679","6680","6681","6682","6683","6684","6685","6686","6687","6688","6689","6690","6691","6692","6693","6694","6695","6696","6697","6698","6699","6700","6701","6702","6703","6704","6705","6706","6707","6708","6709","6710","6711","6712","6713","6714","6715","6716","6717","6718","6719","6720","6721","6722","6723","6724","6725","6726","6727","6728","6729","6730","6731","6732","6733","6734","6735","6736","6737","6738","6739","6740","6741","6742","6743","6744","6745","6746","6747","6748","6749","6750","6751","6752","6753","6754","6755","6756","6757","6758","6759","6760","6761","6762","6763","6764","6765","6766","6767","6768","6769","6770","6771","6772","6773","6774","6775","6776","6777","6778","6779","6780","6781","6782","6783","6784","6785","6786","6787","6788","6789","6790","6791","6792","6793","6794","6795","6796","6797","6798","6799","6800","6801","6802","6803","6804","6805","6806","6807","6808","6809","6810","6811","6812","6813","6814","6815","6816","6817","6818","6819","6820","6821","6822","6823","6824","6825","6826","6827","6828","6829","6830","6831","6832","6833","6834","6835","6836","6837","6838","6839","6840","6841","6842","6843","6844","6845","6846","6847","6848","6849","6850","6851","6852","6853","6854","6855","6856","6857","6858","6859","6860","6861","6862","6863","6864","6865","6866","6867","6868","6869","6870","6871","6872","6873","6874","6875","6876","6877","6878","6879","6880","6881","6882","6883","6884","6885","6886","6887","6888","6889","6890","6891","6892","6893","6894","6895","6896","6897","6898","6899","6900","6901","6902","6903","6904","6905","6906","6907","6908","6909","6910","6911","6912","6913","6914","6915","6916","6917","6918","6919","6920","6921","6922","6923","6924","6925","6926","6927","6928","6929","6930","6931","6932","6933","6934","6935","6936","6937","6938","6939","6940","6941","6942","6943","6944","6945","6946","6947","6948","6949","6950","6951","6952","6953","6954","6955","6956","6957","6958","6959","6960","6961","6962","6963","6964","6965","6966","6967","6968","6969","6970","6971","6972","6973","6974","6975","6976","6977","6978","6979","6980","6981","6982","6983","6984","6985","6986","6987","6988","6989","6990","6991","6992","6993","6994","6995","6996","6997","6998","6999","7000","7001","7002","7003","7004","7005","7006","7007","7008","7009","7010","7011","7012","7013","7014","7015","7016","7017","7018","7019","7020","7021","7022","7023","7024","7025","7026","7027","7028","7029","7030","7031","7032","7033","7034","7035","7036","7037","7038","7039","7040","7041","7042","7043","7044","7045","7046","7047","7048","7049","7050","7051","7052","7053","7054","7055","7056","7057","7058","7059","7060","7061","7062","7063","7064","7065","7066","7067","7068","7069","7070","7071","7072","7073","7074","7075","7076","7077","7078","7079","7080","7081","7082","7083","7084","7085","7086","7087","7088","7089","7090","7091","7092","7093","7094","7095","7096","7097","7098","7099","7100","7101","7102","7103","7104","7105","7106","7107","7108","7109","7110","7111","7112","7113","7114","7115","7116","7117","7118","7119","7120","7121","7122","7123","7124","7125","7126","7127","7128","7129","7130","7131","7132","7133","7134","7135","7136","7137","7138","7139","7140","7141","7142","7143","7144","7145","7146","7147","7148","7149","7150","7151","7152","7153","7154","7155","7156","7157","7158","7159","7160","7161","7162","7163","7164","7165","7166","7167","7168","7169","7170","7171","7172","7173","7174","7175","7176","7177","7178","7179","7180","7181","7182","7183","7184","7185","7186","7187","7188","7189","7190","7191","7192","7193","7194","7195","7196","7197","7198","7199","7200","7201","7202","7203","7204","7205","7206","7207","7208","7209","7210","7211","7212","7213","7214","7215","7216","7217","7218","7219","7220","7221","7222","7223","7224","7225","7226","7227","7228","7229","7230","7231","7232","7233","7234","7235","7236","7237","7238","7239","7240","7241","7242","7243","7244","7245","7246","7247","7248","7249","7250","7251","7252","7253","7254","7255","7256","7257","7258","7259","7260","7261","7262","7263","7264","7265","7266","7267","7268","7269","7270","7271","7272","7273","7274","7275","7276","7277","7278","7279","7280","7281","7282","7283","7284","7285","7286","7287","7288","7289","7290","7291","7292","7293","7294","7295","7296","7297","7298","7299","7300","7301","7302","7303","7304","7305","7306","7307","7308","7309","7310","7311","7312","7313","7314","7315","7316","7317","7318","7319","7320","7321","7322","7323","7324","7325","7326","7327","7328","7329","7330","7331","7332","7333","7334","7335","7336","7337","7338","7339","7340","7341","7342","7343","7344","7345","7346","7347","7348","7349","7350","7351","7352","7353","7354","7355","7356","7357","7358","7359","7360","7361","7362","7363","7364","7365","7366","7367","7368","7369","7370","7371","7372","7373","7374","7375","7376","7377","7378","7379","7380","7381","7382","7383","7384","7385","7386","7387","7388","7389","7390","7391","7392","7393","7394","7395","7396","7397","7398","7399","7400","7401","7402","7403","7404","7405","7406","7407","7408","7409","7410","7411","7412","7413","7414","7415","7416","7417","7418","7419","7420","7421","7422","7423","7424","7425","7426","7427","7428","7429","7430","7431","7432","7433","7434","7435","7436","7437","7438","7439","7440","7441","7442","7443","7444","7445","7446","7447","7448","7449","7450","7451","7452","7453","7454","7455","7456","7457","7458","7459","7460","7461","7462","7463","7464","7465","7466","7467","7468","7469","7470","7471","7472","7473","7474","7475","7476","7477","7478","7479","7480","7481","7482","7483","7484","7485","7486","7487","7488","7489","7490","7491","7492","7493","7494","7495","7496","7497","7498","7499","7500","7501","7502","7503","7504","7505","7506","7507","7508","7509","7510","7511","7512","7513","7514","7515","7516","7517","7518","7519","7520","7521","7522","7523","7524","7525","7526","7527","7528","7529","7530","7531","7532","7533","7534","7535","7536","7537","7538","7539","7540","7541","7542","7543","7544","7545","7546","7547","7548","7549","7550","7551","7552","7553","7554","7555","7556","7557","7558","7559","7560","7561","7562","7563","7564","7565","7566","7567","7568","7569","7570","7571","7572","7573","7574","7575","7576","7577","7578","7579","7580","7581","7582","7583","7584","7585","7586","7587","7588","7589","7590","7591","7592","7593","7594","7595","7596","7597","7598","7599","7600","7601","7602","7603","7604","7605","7606","7607","7608","7609","7610","7611","7612","7613","7614","7615","7616","7617","7618","7619","7620","7621","7622","7623","7624","7625","7626","7627","7628","7629","7630","7631","7632","7633","7634","7635","7636","7637","7638","7639","7640","7641","7642","7643","7644","7645","7646","7647","7648","7649","7650","7651","7652","7653","7654","7655","7656","7657","7658","7659","7660","7661","7662","7663","7664","7665","7666","7667","7668","7669","7670","7671","7672","7673","7674","7675","7676","7677","7678","7679","7680","7681","7682","7683","7684","7685","7686","7687","7688","7689","7690","7691","7692","7693","7694","7695","7696","7697","7698","7699","7700","7701","7702","7703","7704","7705","7706","7707","7708","7709","7710","7711","7712","7713","7714","7715","7716","7717","7718","7719","7720","7721","7722","7723","7724","7725","7726","7727","7728","7729","7730","7731","7732","7733","7734","7735","7736","7737","7738","7739","7740","7741","7742","7743","7744","7745","7746","7747","7748","7749","7750","7751","7752","7753","7754","7755","7756","7757","7758","7759","7760","7761","7762","7763","7764","7765","7766","7767","7768","7769","7770","7771","7772","7773","7774","7775","7776","7777","7778","7779","7780","7781","7782","7783","7784","7785","7786","7787","7788","7789","7790","7791","7792","7793","7794","7795","7796","7797","7798","7799","7800","7801","7802","7803","7804","7805","7806","7807","7808","7809","7810","7811","7812","7813","7814","7815","7816","7817","7818","7819","7820","7821","7822","7823","7824","7825","7826","7827","7828","7829","7830","7831","7832","7833","7834","7835","7836","7837","7838","7839","7840","7841","7842","7843","7844","7845","7846","7847","7848","7849","7850","7851","7852","7853","7854","7855","7856","7857","7858","7859","7860","7861","7862","7863","7864","7865","7866","7867","7868","7869","7870","7871","7872","7873","7874","7875","7876","7877","7878","7879","7880","7881","7882","7883","7884","7885","7886","7887","7888","7889","7890","7891","7892","7893","7894","7895","7896","7897","7898","7899","7900","7901","7902","7903","7904","7905","7906","7907","7908","7909","7910","7911","7912","7913","7914","7915","7916","7917","7918","7919","7920","7921","7922","7923","7924","7925","7926","7927","7928","7929","7930","7931","7932","7933","7934","7935","7936","7937","7938","7939","7940","7941","7942","7943","7944","7945","7946","7947","7948","7949","7950","7951","7952","7953","7954","7955","7956","7957","7958","7959","7960","7961","7962","7963","7964","7965","7966","7967","7968","7969","7970","7971","7972","7973","7974","7975","7976","7977","7978","7979","7980","7981","7982","7983","7984","7985","7986","7987","7988","7989","7990","7991","7992","7993","7994","7995","7996","7997","7998","7999","8000","8001","8002","8003","8004","8005","8006","8007","8008","8009","8010","8011","8012","8013","8014","8015","8016","8017","8018","8019","8020","8021","8022","8023","8024","8025","8026","8027","8028","8029","8030","8031","8032","8033","8034","8035","8036","8037","8038","8039","8040","8041","8042","8043","8044","8045","8046","8047","8048","8049","8050","8051","8052","8053","8054","8055","8056","8057","8058","8059","8060","8061","8062","8063","8064","8065","8066","8067","8068","8069","8070","8071","8072","8073","8074","8075","8076","8077","8078","8079","8080","8081","8082","8083","8084","8085","8086","8087","8088","8089","8090","8091","8092","8093","8094","8095","8096","8097","8098","8099","8100","8101","8102","8103","8104","8105","8106","8107","8108","8109","8110","8111","8112","8113","8114","8115","8116","8117","8118","8119","8120","8121","8122","8123","8124","8125","8126","8127","8128","8129","8130","8131","8132","8133","8134","8135","8136","8137","8138","8139","8140","8141","8142","8143","8144","8145","8146","8147","8148","8149","8150","8151","8152","8153","8154","8155","8156","8157","8158","8159","8160","8161","8162","8163","8164","8165","8166","8167","8168","8169","8170","8171","8172","8173","8174","8175","8176","8177","8178","8179","8180","8181","8182","8183","8184","8185","8186","8187","8188","8189","8190","8191","8192","8193","8194","8195","8196","8197","8198","8199","8200","8201","8202","8203","8204","8205","8206","8207","8208","8209","8210","8211","8212","8213","8214","8215","8216","8217","8218","8219","8220","8221","8222","8223","8224","8225","8226","8227","8228","8229","8230","8231","8232","8233","8234","8235","8236","8237","8238","8239","8240","8241","8242","8243","8244","8245","8246","8247","8248","8249","8250","8251","8252","8253","8254","8255","8256","8257","8258","8259","8260","8261","8262","8263","8264","8265","8266","8267","8268","8269","8270","8271","8272","8273","8274","8275","8276","8277","8278","8279","8280","8281","8282","8283","8284","8285","8286","8287","8288","8289","8290","8291","8292","8293","8294","8295","8296","8297","8298","8299","8300","8301","8302","8303","8304","8305","8306","8307","8308","8309","8310","8311","8312","8313","8314","8315","8316","8317","8318","8319","8320","8321","8322","8323","8324","8325","8326","8327","8328","8329","8330","8331","8332","8333","8334","8335","8336","8337","8338","8339","8340","8341","8342","8343","8344","8345","8346","8347","8348","8349","8350","8351","8352","8353","8354","8355","8356","8357","8358","8359","8360","8361","8362","8363","8364","8365","8366","8367","8368","8369","8370","8371","8372","8373","8374","8375","8376","8377","8378","8379","8380","8381","8382","8383","8384","8385","8386","8387","8388","8389","8390","8391","8392","8393","8394","8395","8396","8397","8398","8399","8400","8401","8402","8403","8404","8405","8406","8407","8408","8409","8410","8411","8412","8413","8414","8415","8416","8417","8418","8419","8420","8421","8422","8423","8424","8425","8426","8427","8428","8429","8430","8431","8432","8433","8434","8435","8436","8437","8438","8439","8440","8441","8442","8443","8444","8445","8446","8447","8448","8449","8450","8451","8452","8453","8454","8455","8456","8457","8458","8459","8460","8461","8462","8463","8464","8465","8466","8467","8468","8469","8470","8471","8472","8473","8474","8475","8476","8477","8478","8479","8480","8481","8482","8483","8484","8485","8486","8487","8488","8489","8490","8491","8492","8493","8494","8495","8496","8497","8498","8499","8500","8501","8502","8503","8504","8505","8506","8507","8508","8509","8510","8511","8512","8513","8514","8515","8516","8517","8518","8519","8520","8521","8522","8523","8524","8525","8526","8527","8528","8529","8530","8531","8532","8533","8534","8535","8536","8537","8538","8539","8540","8541","8542","8543","8544","8545","8546","8547","8548","8549","8550","8551","8552","8553","8554","8555","8556","8557","8558","8559","8560","8561","8562","8563","8564","8565","8566","8567","8568","8569","8570","8571","8572","8573","8574","8575","8576","8577","8578","8579","8580","8581","8582","8583","8584","8585","8586","8587","8588","8589","8590","8591","8592","8593","8594","8595","8596","8597","8598","8599","8600","8601","8602","8603","8604","8605","8606","8607","8608","8609","8610","8611","8612","8613","8614","8615","8616","8617","8618","8619","8620","8621","8622","8623","8624","8625","8626","8627","8628","8629","8630","8631","8632","8633","8634","8635","8636","8637","8638","8639","8640","8641","8642","8643","8644","8645","8646","8647","8648","8649","8650","8651","8652","8653","8654","8655","8656","8657","8658","8659","8660","8661","8662","8663","8664","8665","8666","8667","8668","8669","8670","8671","8672","8673","8674","8675","8676","8677","8678","8679","8680","8681","8682","8683","8684","8685","8686","8687","8688","8689","8690","8691","8692","8693","8694","8695","8696","8697","8698","8699","8700","8701","8702","8703","8704","8705","8706","8707","8708","8709","8710","8711","8712","8713","8714","8715","8716","8717","8718","8719","8720","8721","8722","8723","8724","8725","8726","8727","8728","8729","8730","8731","8732","8733","8734","8735","8736","8737","8738","8739","8740","8741","8742","8743","8744","8745","8746","8747","8748","8749","8750","8751","8752","8753","8754","8755","8756","8757","8758","8759","8760","8761","8762","8763","8764","8765","8766","8767","8768","8769","8770","8771","8772","8773","8774","8775","8776","8777","8778","8779","8780","8781","8782","8783","8784","8785","8786","8787","8788","8789","8790","8791","8792","8793","8794","8795","8796","8797","8798","8799","8800","8801","8802","8803","8804","8805","8806","8807","8808","8809","8810","8811","8812","8813","8814","8815","8816","8817","8818","8819","8820","8821","8822","8823","8824","8825","8826","8827","8828","8829","8830","8831","8832","8833","8834","8835","8836","8837","8838","8839","8840","8841","8842","8843","8844","8845","8846","8847","8848","8849","8850","8851","8852","8853","8854","8855","8856","8857","8858","8859","8860","8861","8862","8863","8864","8865","8866","8867","8868","8869","8870","8871","8872","8873","8874","8875","8876","8877","8878","8879","8880","8881","8882","8883","8884","8885","8886","8887","8888","8889","8890","8891","8892","8893","8894","8895","8896","8897","8898","8899","8900","8901","8902","8903","8904","8905","8906","8907","8908","8909","8910","8911","8912","8913","8914","8915","8916","8917","8918","8919","8920","8921","8922","8923","8924","8925","8926","8927","8928","8929","8930","8931","8932","8933","8934","8935","8936","8937","8938","8939","8940","8941","8942","8943","8944","8945","8946","8947","8948","8949","8950","8951","8952","8953","8954","8955","8956","8957","8958","8959","8960","8961","8962","8963","8964","8965","8966","8967","8968","8969","8970","8971","8972","8973","8974","8975","8976","8977","8978","8979","8980","8981","8982","8983","8984","8985","8986","8987","8988","8989","8990","8991","8992","8993","8994","8995","8996","8997","8998","8999","9000","9001","9002","9003","9004","9005","9006","9007","9008","9009","9010","9011","9012","9013","9014","9015","9016","9017","9018","9019","9020","9021","9022","9023","9024","9025","9026","9027","9028","9029","9030","9031","9032","9033","9034","9035","9036","9037","9038","9039","9040","9041","9042","9043","9044","9045","9046","9047","9048","9049","9050","9051","9052","9053","9054","9055","9056","9057","9058","9059","9060","9061","9062","9063","9064","9065","9066","9067","9068","9069","9070","9071","9072","9073","9074","9075","9076","9077","9078","9079","9080","9081","9082","9083","9084","9085","9086","9087","9088","9089","9090","9091","9092","9093","9094","9095","9096","9097","9098","9099","9100","9101","9102","9103","9104","9105","9106","9107","9108","9109","9110","9111","9112","9113","9114","9115","9116","9117","9118","9119","9120","9121","9122","9123","9124","9125","9126","9127","9128","9129","9130","9131","9132","9133","9134","9135","9136","9137","9138","9139","9140","9141","9142","9143","9144","9145","9146","9147","9148","9149","9150","9151","9152","9153","9154","9155","9156","9157","9158","9159","9160","9161","9162","9163","9164","9165","9166","9167","9168","9169","9170","9171","9172","9173","9174","9175","9176","9177","9178","9179","9180","9181","9182","9183","9184","9185","9186","9187","9188","9189","9190","9191","9192","9193","9194","9195","9196","9197","9198","9199","9200","9201","9202","9203","9204","9205","9206","9207","9208","9209","9210","9211","9212","9213","9214","9215","9216","9217","9218","9219","9220","9221","9222","9223","9224","9225","9226","9227","9228","9229","9230","9231","9232","9233","9234","9235","9236","9237","9238","9239","9240","9241","9242","9243","9244","9245","9246","9247","9248","9249","9250","9251","9252","9253","9254","9255","9256","9257","9258","9259","9260","9261","9262","9263","9264","9265","9266","9267","9268","9269","9270","9271","9272","9273","9274","9275","9276","9277","9278","9279","9280","9281","9282","9283","9284","9285","9286","9287","9288","9289","9290","9291","9292","9293","9294","9295","9296","9297","9298","9299","9300","9301","9302","9303","9304","9305","9306","9307","9308","9309","9310","9311","9312","9313","9314","9315","9316","9317","9318","9319","9320","9321","9322","9323","9324","9325","9326","9327","9328","9329","9330","9331","9332","9333","9334","9335","9336","9337","9338","9339","9340","9341","9342","9343","9344","9345","9346","9347","9348","9349","9350","9351","9352","9353","9354","9355","9356","9357","9358","9359","9360","9361","9362","9363","9364","9365","9366","9367","9368","9369","9370","9371","9372","9373","9374","9375","9376","9377","9378","9379","9380","9381","9382","9383","9384","9385","9386","9387","9388","9389","9390","9391","9392","9393","9394","9395","9396","9397","9398","9399","9400","9401","9402","9403","9404","9405","9406","9407","9408","9409","9410","9411","9412","9413","9414","9415","9416","9417","9418","9419","9420","9421","9422","9423","9424","9425","9426","9427","9428","9429","9430","9431","9432","9433","9434","9435","9436","9437","9438","9439","9440","9441","9442","9443","9444","9445","9446","9447","9448","9449","9450","9451","9452","9453","9454","9455","9456","9457","9458","9459","9460","9461","9462","9463","9464","9465","9466","9467","9468","9469","9470","9471","9472","9473","9474","9475","9476","9477","9478","9479","9480","9481","9482","9483","9484","9485","9486","9487","9488","9489","9490","9491","9492","9493","9494","9495","9496","9497","9498","9499","9500","9501","9502","9503","9504","9505","9506","9507","9508","9509","9510","9511","9512","9513","9514","9515","9516","9517","9518","9519","9520","9521","9522","9523","9524","9525","9526","9527","9528","9529","9530","9531","9532","9533","9534","9535","9536","9537","9538","9539","9540","9541","9542","9543","9544","9545","9546","9547","9548","9549","9550","9551","9552","9553","9554","9555","9556","9557","9558","9559","9560","9561","9562","9563","9564","9565","9566","9567","9568","9569","9570","9571","9572","9573","9574","9575","9576","9577","9578","9579","9580","9581","9582","9583","9584","9585","9586","9587","9588","9589","9590","9591","9592","9593","9594","9595","9596","9597","9598","9599","9600","9601","9602","9603","9604","9605","9606","9607","9608","9609","9610","9611","9612","9613","9614","9615","9616","9617","9618","9619","9620","9621","9622","9623","9624","9625","9626","9627","9628","9629","9630","9631","9632","9633","9634","9635","9636","9637","9638","9639","9640","9641","9642","9643","9644","9645","9646","9647","9648","9649","9650","9651","9652","9653","9654","9655","9656","9657","9658","9659","9660","9661","9662","9663","9664","9665","9666","9667","9668","9669","9670","9671","9672","9673","9674","9675","9676","9677","9678","9679","9680","9681","9682","9683","9684","9685","9686","9687","9688","9689","9690","9691","9692","9693","9694","9695","9696","9697","9698","9699","9700","9701","9702","9703","9704","9705","9706","9707","9708","9709","9710","9711","9712","9713","9714","9715","9716","9717","9718","9719","9720","9721","9722","9723","9724","9725","9726","9727","9728","9729","9730","9731","9732","9733","9734","9735","9736","9737","9738","9739","9740","9741","9742","9743","9744","9745","9746","9747","9748","9749","9750","9751","9752","9753","9754","9755","9756","9757","9758","9759","9760","9761","9762","9763","9764","9765","9766","9767","9768","9769","9770","9771","9772","9773","9774","9775","9776","9777","9778","9779","9780","9781","9782","9783","9784","9785","9786","9787","9788","9789","9790","9791","9792","9793","9794","9795","9796","9797","9798","9799","9800","9801","9802","9803","9804","9805","9806","9807","9808","9809","9810","9811","9812","9813","9814","9815","9816","9817","9818","9819","9820","9821","9822","9823","9824","9825","9826","9827","9828","9829","9830","9831","9832","9833","9834","9835","9836","9837","9838","9839","9840","9841","9842","9843","9844","9845","9846","9847","9848","9849","9850","9851","9852","9853","9854","9855","9856","9857","9858","9859","9860","9861","9862","9863","9864","9865","9866","9867","9868","9869","9870","9871","9872","9873","9874","9875","9876","9877","9878","9879","9880","9881","9882","9883","9884","9885","9886","9887","9888","9889","9890","9891","9892","9893","9894","9895","9896","9897","9898","9899","9900","9901","9902","9903","9904","9905","9906","9907","9908","9909","9910","9911","9912","9913","9914","9915","9916","9917","9918","9919","9920","9921","9922","9923","9924","9925","9926","9927","9928","9929","9930","9931","9932","9933","9934","9935","9936","9937","9938","9939","9940","9941","9942","9943","9944","9945","9946","9947","9948","9949","9950","9951","9952","9953","9954","9955","9956","9957","9958","9959","9960","9961","9962","9963","9964","9965","9966","9967","9968","9969","9970","9971","9972","9973","9974","9975","9976","9977","9978","9979","9980","9981","9982","9983","9984","9985","9986","9987","9988","9989","9990","9991","9992","9993","9994","9995","9996","9997","9998","9999","10000","10001","10002","10003","10004","10005","10006","10007","10008","10009","10010","10011","10012","10013","10014","10015","10016","10017","10018","10019","10020","10021","10022","10023","10024","10025","10026","10027","10028","10029","10030","10031","10032","10033","10034","10035","10036","10037","10038","10039","10040","10041","10042","10043","10044","10045","10046","10047","10048","10049","10050","10051","10052","10053","10054","10055","10056","10057","10058","10059","10060","10061","10062","10063","10064","10065","10066","10067","10068","10069","10070","10071","10072","10073","10074","10075","10076","10077","10078","10079","10080","10081","10082","10083","10084","10085","10086","10087","10088","10089","10090","10091","10092","10093","10094","10095","10096","10097","10098","10099","10100"],[0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100],[0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000,0,1,4,9,16,25,36,49,64,81,100,121,144,169,196,225,256,289,324,361,400,441,484,529,576,625,676,729,784,841,900,961,1024,1089,1156,1225,1296,1369,1444,1521,1600,1681,1764,1849,1936,2025,2116,2209,2304,2401,2500,2601,2704,2809,2916,3025,3136,3249,3364,3481,3600,3721,3844,3969,4096,4225,4356,4489,4624,4761,4900,5041,5184,5329,5476,5625,5776,5929,6084,6241,6400,6561,6724,6889,7056,7225,7396,7569,7744,7921,8100,8281,8464,8649,8836,9025,9216,9409,9604,9801,10000],[-0.93,0.78,0.91,-0.98,-0.54,0.97,1.53,0.47,-0.06,2.65,0.41,1.25,-0.48,-0.39,-1.6,1.1,-0.49,0.97,-0.94,-1.09,0.42,2.04,0.57,3.05,-0.53,-0.26,0.54,2.08,-0.63,-0.39,0.25,-0.21,0.67,-3.19,-0.98,-0.22,1.4,-0.77,0.08,0.65,0.57,1.24,1.3,1.44,0.84,-0.79,-0.16,-0.14,-1.38,0.1,-0.63,-0.35,0.97,-0.44,0.85,0.2,-0.52,0.22,-0.51,0.87,-1.87,1.5,0.34,-0.57,-0.8,0.55,1.53,0.53,1.52,-2.52,0.15,0.01,1.89,-0.69,-1.09,1.77,-0.91,-1.1,-0.74,-0.53,-1.54,-0.86,-0.41,-2.25,1.73,-1.02,-0.7,0.6,-2.18,0.27,1.39,0.29,-1.55,-0.76,0.35,-0.19,-0.06,0,-0.04,1.14,1.14,0.91,0.05,0.17,-0.17,0.51,1.63,-0.67,3.56,-0.44,1.44,-0.68,-0.79,-0.14,-0.59,-0.35,1.47,-1.06,-0.09,0.41,-1.16,-1.71,1.98,-0.26,-2.11,0.09,-2.27,2.72,0.19,0.29,-1.2,0.75,2.31,1.09,-0.89,-0.92,-0.79,-1.46,-0.45,-0.08,-0.69,-0.06,-1.38,-0.41,-1.19,0.88,-0.61,0.73,-0.01,-0.26,0.71,1.33,1.82,-1.19,0.29,-0.21,0.24,-1.49,0.91,0.03,-0.36,0.67,1.38,0.37,-0.02,1.02,0.75,1.43,0.51,1.47,-0.34,0.8,-0.7,0.39,-0.45,0.74,-0.53,-1.53,0.85,1.76,1.08,0.69,-2.1,-0.94,0.2,1.35,0.29,0.22,-1.71,-0.08,0.04,0.19,0.54,-0.27,0.8,0.26,0.5,-0.8,-2.03,0.62,-0.67,-0.59,-0.74,2.78,1.34,1.37,-0.58,-0.82,0.38,-0.19,0.39,0.61,-0.3,0.43,1.45,-1,1.4,-0.22,-0.17,1.95,-0.61,1.54,-1.03,-0.67,-0.46,0.5,0.08,-1.36,1.24,1.66,0.32,0.71,-1.43,-0.75,0.81,-0.37,-0.55,0.48,0.98,-1.8,0.13,-1.8,0.51,-0.51,0.64,0.13,-0.55,0.43,1.52,0.14,-1.05,1.24,-0.23,1.1,2.04,-0.8,0.45,0.99,0.87,0.28,-0.83,0.11,-1.42,-0.57,-2.13,-1.65,0.29,-0.33,0.34,-1.18,-0.94,0.8,0.04,-0.29,0.44,-0.86,-1.66,-0.53,-2.36,-0.12,1.21,0.01,-1.3,0.06,0.58,0.98,1.13,-0.46,2.35,0.75,-0.16,1.82,1.19,-0.73,1.16,-1.6,-1.22,-0.99,-0.71,0.84,1.16,-1.18,0.3,-0.62,-1.5,1.12,-1.69,0.19,1.31,-0.32,1.23,-0.58,-0.66,-0.66,-0.18,-1.48,1.16,-1.49,2.26,-1.23,2.56,-0.32,0.09,-0.1,-0.51,0.17,-0.28,-0.25,-0.27,-2.91,0.16,1.17,0.37,-0.86,0.94,0.53,-0.7,-1.08,-0.01,-1.56,0.61,0.52,-0.77,0.5,1.39,-1.02,0.21,-1.08,1.19,-0.04,-0.84,-0.56,0.33,2.06,0.54,-0.45,0.4,1.31,2.05,0.19,0.95,-0.14,0.51,1.25,2.24,0.9,0.29,-1.28,1.71,-0.58,-2.55,0.13,-0.56,-0.08,1.18,0.14,0.89,2,-0.77,0.17,0.03,1.18,1.5,0.52,1.05,0.38,-1.59,1.25,1.74,-1.87,0.13,-0.18,-0.57,0.41,-1.52,0.69,0.27,0.3,-1.17,-0.62,0.35,-0.48,0.92,1.14,-0.41,0.38,-2.08,-0.61,0.36,1.24,-0.65,-0.49,0.33,0.3,1.11,-0.74,-1.08,0.9,-2.36,-0.83,-0.99,0.77,0.2,0.34,0.7,0.34,-0.5,-1.14,-1.9,0.41,0.56,-1.33,-0.48,0.63,0.1,1.02,1.16,-1.05,0.37,-1.56,-1.18,-0.68,0.61,-1.19,-0.23,0.93,-0.28,0.5,-0.74,-0.95,-1.41,-0.59,-0.66,0.08,0.51,-0.01,-0.08,-0.69,1.35,0.97,-1.3,1.39,-1.25,0.56,-1.38,-0.87,1.11,-2.73,1.11,-0.55,-0.29,0.34,0.75,-1.16,1.29,-0.46,-0.98,0.49,-0.99,1.11,0.52,1.22,-1.28,0.68,-1.46,-0.67,-0.19,0.52,0.54,0.74,0.64,-0.16,1.39,-0.88,-1,1.46,0.6,-0.13,-1.01,-0.89,1.09,0.92,-0.18,0.1,0.54,-0.69,0.3,-1.13,0.43,-0.77,-1.47,0.96,-0.78,-0.39,-0.37,-1.06,-0.21,-0.46,0.8,-1.53,-1.67,-0.86,2.13,0.63,0.77,-0.49,-0.27,-0.17,1.74,-2.99,-0.85,-1.37,1.32,1.25,0.24,0.1,-0.94,0.7,-0.56,-0.65,0.21,-0.09,1,0.33,0.07,-0.85,-0.49,0.83,-1.43,0.87,-0.82,0.27,0.17,0.84,-0.89,0.69,0.29,-0.05,0.81,0.44,-2.14,1.35,0.89,-0.46,0.27,0.78,-1.19,-0.28,0.05,-2.12,0.13,-1.17,-2.2,-1.67,0.04,1.75,-1.03,-0.53,2.53,-1.58,0.18,-2.02,-1.53,1.06,-1.04,0.96,1.76,-0.32,0.94,0.65,0.08,-0.97,-0.78,0.71,1.6,-1.54,-0.89,-0.82,0.51,0.05,-0.19,1.94,0.2,-0.33,0.58,0.52,1.71,-0.63,-0.9,-0.31,-0.88,0.17,-0.82,1,0.57,1.58,-0.61,-1.23,1.73,-1.76,0.04,1.33,1.02,1.51,0.46,0.26,-0.81,-0.87,-0.67,-0.53,0.56,0.61,-1.08,0.11,1.86,2.93,0.24,-0.76,-0.24,-0.55,-1.5,1.06,-0.32,-1.22,-0.63,-0.9,-0.84,0.76,0.83,0.16,-1.92,-1.32,1.73,0.27,1.24,-1.71,0.81,0.8,-0.27,1.13,-0.61,-0.45,0.32,0.2,-1.6,2.05,0.98,-0.06,0.97,-0.03,-0.83,-0.41,2.68,0.59,-0.51,0.62,-0.86,0.89,-0.64,-2.5,-0.41,-1.16,-0.79,2.91,-0.23,0.56,-0.7,-0.43,0.09,-0.71,0.49,1.42,1.18,-1.47,-0.7,-0.19,-0.59,-0.88,-1.16,0.08,0.12,1.1,-0.08,-1.27,2.14,-0.05,0.45,-1.39,0.35,-0.67,0.17,0.28,1.4,0.39,-0.87,-0.01,0.41,0.98,-0.9,-0.18,-0.21,-0.02,0.5,0.58,0.2,-0.03,-0.7,1.47,0.07,-0.11,0.38,0.76,0.43,-1.5,0.34,-1.1,2.23,0.11,1.28,0.79,-0.33,-1.47,0.47,2.9,-1.4,-0.35,1.5,0.31,1.1,-1.22,-0.45,0.09,1.79,1.17,-0.46,0.66,-0.94,-0.06,0.6,-0.89,-0.72,2.51,-0.01,-1.8,-0.05,-0.26,-0.34,0.21,-0.57,-0.11,0.38,-0.02,-0.59,-0.85,-0.19,0.09,0.46,0.77,-0.74,0.94,-0.35,-0.52,-0.07,0.84,-0.91,2.15,1.81,-0.34,0.3,0.34,-0.13,0.04,-0.4,-0.32,0.62,1.62,-0.08,-0.97,0.5,-0.82,1.15,-0.06,0.88,-0.86,-0.5,0.53,0.31,-1.27,-1.15,-0.58,-1.88,-0.67,-0.87,0.17,0.53,-1.41,-0.65,-0.21,0.42,-0.56,1.29,-1.14,-0.04,0.56,-1.07,-0.76,0.33,-0.81,-0.98,-0.5,0.07,1.45,0.58,-0.1,0.66,-0.76,-0.11,-0.27,0.51,0.7,0.56,-1.07,-0.66,1.17,-0.34,-2.7,-0.56,-1.47,0.86,-0.18,-1.89,0.69,0.51,-1.88,-0.04,-2.85,0.4,0.02,-0.9,1.91,-0.61,-0.1,-0.55,-0.75,1.37,-1.71,-0.08,0.84,-0.79,0.86,0.52,-0.07,0.8,0.58,0.38,0.11,-0.29,-2.01,0.08,-0.96,1.43,-1.9,-0.88,0.08,0.47,-1.29,-1.16,-0.02,1.36,0.32,2.07,2.36,0.67,-0.8,1,-0.14,0.83,-0.19,1.63,-1.25,0.14,-1.57,1.4,0.86,-0.14,1.9,-0.42,0.39,3.19,1.48,-0.34,-0.55,-0.51,0.6,-1.26,0.74,0.43,0.69,-0.5,-0.01,-0.76,-0.15,-0.9,-0.35,-0.69,1.22,2.27,0.23,1.32,-1.54,-2.4,0.63,1.76,0.59,-0.54,1.02,0.65,1.11,1.19,1.25,1.71,-0.84,0.38,0.28,-0.96,-1.25,-0.45,-0.81,-1.12,0.73,-1.49,-0.76,-0.09,1.38,0.13,0.05,0.53,-0.03,1.68,0.22,-0.43,-0.71,-0.83,0.43,0.53,-0.08,0.66,0.09,-0.71,-1.56,-1,-0.17,1.5,0.59,-1.66,1.04,1.17,0.53,-0.88,-1.14,-0.91,-2.13,0.1,-0,-0.79,-0.79,-2.07,0.61,0.65,-1.57,-0.88,-1.3,0.07,-0.58,-2.28,1.08,1.04,0.05,0.31,0.45,-0.06,1.67,-0.54,0.28,-1.22,0.7,-0.9,0.12,0.42,-0.15,-1.3,-1.06,-1.08,2.05,0.06,-0.71,0.35,0.57,0.37,-0.6,0.77,-0.86,-0.24,-0.79,1.31,1.83,-1.78,-0.61,1.24,0.16,-0.32,1.34,0.2,1.33,-0.14,1.46,-1.04,-0.64,0.45,-0.45,0.66,-0.11,-0.41,1.82,0.11,0.79,1.83,0.72,-0.66,-1.91,-0.88,-1.46,-0.01,2.11,-1.26,1.51,0.67,-0.91,0.43,0.16,-2.11,-0.49,0.32,1.38,1.36,0.01,-1.16,-0.77,-1.02,0.94,0.73,-0.55,-0.82,0.81,-0.59,0.19,1.4,-0.25,-0.52,0.37,-0.02,-1.21,-1,-0.09,1.16,0.73,0.77,0.42,0.35,1,-1.89,-1.42,-1.05,0.76,0.19,0.35,0.68,1.39,1.13,0.07,-0.75,0.26,0.83,1.09,-0.96,-0.23,0.69,-0.48,-0.5,0.5,-0.83,1.7,-0.43,-2.25,0.68,-0.78,-0.27,0.89,-0.38,-1.03,-1.31,0.24,-0.25,1.2,1.63,-0.85,1.46,1.23,1.63,0.39,-0.32,-0.49,-0.16,0.04,0.09,1.37,-0.88,-1.11,0.07,-1.94,-0.22,0.35,0.12,1.92,-0.37,1.05,-0.84,-1.7,1.01,1.11,-1.61,-0.4,-0.67,-0.11,-0.85,0.44,0.4,-1.4,-1.1,-0.36,-0.02,1.47,0.55,0.21,1.27,1.58,0.14,1.48,-1.17,-1.62,-1.62,-1.2,0.09,-0.84,-0.94,-0.59,0.83,-1.92,0.98,0.43,-0.71,0.91,0.34,1.43,-0.99,-0.61,-0.26,0.99,-0.14,-0.6,1.49,0.91,-1.94,-1.85,-0.74,1.33,-0.06,1.88,-0.42,-1.29,0.12,-0.08,0.44,-0.55,0.58,0.2,0.26,-0.5,1.26,-0.88,-0.18,0.5,-0.21,1.06,-0.47,0.23,-1.55,0.71,0.25,0.13,-0.02,-0.24,0.08,-1.09,1.54,-1.01,0.27,0.16,1.68,-0.79,-0.76,0.23,0.15,-1.45,-0.3,-1.13,0.57,0.54,-0.04,0.27,-0.31,-1.72,1.91,0.12,0.74,-0.9,0.03,-0.65,-0.23,-0.43,-0.45,-0.13,0.02,2.16,0.82,0.69,1.51,0.13,0.08,-1.85,-1.42,-0.72,-2,1.05,0.5,0.55,-1.32,0.51,-0.84,-0.79,-1.15,-0.28,1.55,0.2,-0.69,0.46,0.41,1.58,-0.52,-1.93,1.01,-0.04,0.85,-0.1,-0.45,0.36,0.25,-0.21,-1.72,-1.23,-0.95,0.7,1.8,0.56,-0.42,-1.13,-0.21,0.22,1.68,0.52,1.55,0.65,-0.34,-0.75,2.27,-1.24,-0.5,-0.63,-1.17,-0.46,0.53,0.3,1.16,0.54,0.19,-0.54,1.26,-0.62,-0.48,-0.55,-0.68,1.51,1.13,1.49,-0.59,0.1,-1.7,-1.11,0.5,0.02,1.73,0.59,0.23,1.06,0.08,0.57,0.61,-1.2,-0.15,-0.48,-0.78,-0.83,1.09,1.06,1.5,-0.07,1.64,1.58,1.3,-0.22,1.29,0.51,1.29,0.28,0.07,-1.69,0.68,0.58,-1.57,3.32,0.44,1,1.78,0.4,-0.21,-1.59,-0.23,-0.09,0.6,1.18,1.19,-0.8,-0.1,-0.74,-0.01,0.91,0.5,0.48,0.65,0.79,-0.25,0.92,-0.77,-0.69,-0.79,-1.63,-0.53,-0.42,-0.53,-4.06,0.17,-0.24,0.3,-0.1,-0.83,0.14,0.4,-0.54,1.22,-0.44,-0.58,-0.1,-0.78,0.2,-2.03,1.97,0.33,-0.36,1.17,2.1,1.15,-0.75,-2.07,0.25,0.12,0.4,0.09,0.03,0.86,-0.03,-2.15,-0.71,-0.2,0.73,1.68,1.29,-1.47,0.07,0.25,-0.35,-0.73,0.03,1.45,0.14,-0.22,1.67,0.95,0.08,1.64,-0.06,-0.71,-1.05,-0.12,-0.68,-1.11,-1.01,1.49,1.4,-2.08,1.25,0.51,1.28,-0.46,0.46,0.95,-0.95,-0.71,-1.33,0.67,1.02,0.27,-1.39,-0.36,-1.22,-0.27,0.01,0.82,0.09,-1.31,1.15,-1.43,0.77,2.01,1.2,-0.99,-0.02,-1.03,0.11,-0.5,0.43,-0.24,1.57,-1.53,0.99,2.27,1.18,-1.12,-1.06,-0.01,1.61,-1.01,-0.61,0.3,0.61,0.71,-0.3,1.47,-0.09,0.08,0.04,0.02,-0.31,0.46,1.61,-0.98,1.03,0.05,0.07,-0.4,1.34,-1.42,1.06,-0.16,-0.13,-0.15,0.01,0.59,0.56,1.02,0.83,-0.29,0.24,1,-2.52,0,1.07,-0.18,-1.4,0.63,-1.07,-0.87,-0.28,0.1,-1.01,1.51,2.04,-1.37,-1.05,0.94,1.38,0.35,-0.85,-0.02,0.35,-0.76,-0.18,0.72,1.18,-1.21,0.35,-0.02,0.05,0.16,-0.5,-0.84,0.24,-0.12,1.86,1.4,-0.08,-2.11,-1.88,0.3,-0.98,1.03,0.01,-1.5,-0.49,-1.2,-0.43,-0.31,0.99,0.72,-1.47,0.07,-0.95,1.4,-0.44,1.68,-0.89,1.14,-1.35,-1.43,-1.23,1.17,-0.15,-0.79,-0.36,-0.81,0.17,1.58,-1.02,1.04,0.87,-0.37,-0.14,1.62,-1.38,-0.3,0.81,-1.01,1.52,0.86,0.27,0.14,-0.1,-0.48,-0.41,-0.83,2.1,-0.85,-1.15,-0.67,0.51,0.98,0.71,-1.7,0.82,-0.03,-0.59,-0.33,1.02,-0.29,-0.1,-0.56,2.88,0.49,0.39,0.2,0.69,-0.64,1.49,-0.83,-0.06,0,-1.47,0.03,-0.17,-0.33,-0.48,0.97,0.38,-0.07,1.47,0.16,0.49,1.23,-0.57,0.15,0.86,-1.34,-0.3,-0.07,0.18,0.35,-0.4,-1.22,-0.95,0.43,0.26,-0.24,0.26,1.37,0.32,-2.07,-0.54,1.5,-0.53,1.58,0.93,0.1,1.12,-0.68,1.38,-0.74,-0.23,0.37,-0.99,0.82,0.13,-0.73,0.51,1.02,2.64,1.54,-0.94,0.3,1.36,0.49,-0.58,-0.16,0.52,1.91,1.47,-0.57,-1.47,-0.41,0.29,-0.8,1.18,-0.56,-0.02,1.49,-0.06,-0.63,0.4,0.44,0.38,-1.13,0.77,1.94,-0.9,-0.41,0.67,1.88,0.33,0.9,0.12,-0.29,0.02,0.99,0.51,-1.66,-0.07,2.11,-2.08,2.58,0.96,-0.51,-1.22,-0.39,-1.21,1.6,0.47,0.13,0.66,0.74,-0.46,-0.77,-1.36,-1.93,0.34,1.55,-1.15,-2.24,0.01,0.49,-0.94,1.96,0,1.08,-0.57,-2.28,0.37,1.14,-1.45,-1.93,0.41,-1.35,-0.57,1.86,0.55,-0.47,-0.45,0.35,-0.45,-1.29,0.38,-2.11,-1.35,-1.13,-0.65,-1.6,-0.35,0.42,-1.28,-0.12,-0.49,-0.34,0.75,0.19,0.68,-0.34,0.02,-0.25,-1,2.5,0.04,-1.86,0.34,-0.07,0.52,2.2,0.48,0.02,1.11,-1.81,1.09,-0.14,-0.2,-0.11,0.36,0.54,-0.95,1.44,-1.05,-1.85,-2,0.16,0.91,1.92,0.68,2.15,-0.9,0.1,-0.15,0.99,-0.16,0.35,-1.05,-0.84,-2.34,1.02,-0.29,-0.57,0.88,0.87,-0.58,-0.36,-1.4,1.32,-0.84,0.35,0.32,1.63,-1.36,0.8,0.49,-1.62,0.37,-1.11,-0.95,-1.13,0.98,0.88,0.88,0.61,-0.83,0.06,-0.19,-0.71,-0.39,1.83,-0.8,-0.02,1.35,0.93,0.27,0.74,-1.38,-0.59,0.28,-0.03,-0.47,0.94,0.56,0.98,1.76,0.5,1.53,-0.47,-0.83,-0.75,-0.81,0.54,-0.32,-1.4,0.88,0.22,0.28,2.32,1.29,-1.3,-0.17,-0.92,-0.19,-0.23,1.69,-0.89,1.38,1.54,-2.02,1.18,2.25,0.93,-0.43,-0.36,0.57,0.03,0.33,-1.02,-1.34,-1.3,-0.07,0.17,0.25,0.53,-2.81,1.3,0.08,-0.6,0.34,0.39,2.11,-2.51,-0.79,0.46,1,-0.44,0.29,-0.26,0.27,-1.67,-0.12,0.61,0.42,-1.71,1.45,1.49,-1.03,0.94,-0.06,-0.52,0.53,-0.49,0.92,0.22,-0.11,0.05,-1.03,0.68,0.11,0.48,-0.83,-1.05,-1.55,-1.09,-1.09,0.55,-0.66,1.69,-2.15,-1.03,0.28,1.3,0.77,-0.8,-1.26,-2.17,-0.05,-1.79,-1.16,2.57,-0.41,0.45,1.13,-0.13,1.64,1.78,-1.65,0.14,0.69,1.14,0.81,-0.32,0.23,0.11,0.28,-0.16,-1.66,0.11,0.96,-2.56,-0.16,0.7,0.74,-0.95,0.25,1.39,-1.04,0.96,-1.1,-1.34,-0.16,-0.45,-1,-1.1,0.92,-1.12,-1.77,0.96,-0.11,-0.2,1.5,-0.31,0.66,-1.01,0.74,0.09,0.01,0.25,-0.11,-0.37,-0.55,-0.35,-2.31,1.22,0.86,-0.34,0.27,-2.5,-1.71,-0.43,-1.19,0.37,-0.84,0.24,0.71,1.07,0.44,-0.2,-1.27,-0.07,0.89,-0.6,-1.16,-0.17,-1.33,-0.8,-0.97,1.08,-1.18,-1.06,-0.6,2.22,0.29,1.02,0.22,-1.05,-0.87,0.27,1.64,-0.03,1.18,0.05,0.91,-0.72,-0.67,0.08,0.07,0.49,2.81,-2.03,0.05,0.9,-0.63,-0.7,-1.17,1.61,-1.23,-0.46,0.16,-2.82,-1.55,-0.1,-2.83,-2.5,-1.51,-0.94,0.62,0.19,-0.32,-0.5,-0.74,-1.1,-0.19,-0.57,0.63,0.77,-0.93,0.86,-0.05,0.16,-1.12,-3.42,-3.4,-1.35,0.65,1.24,1.62,1.66,-0.54,-0.72,0.34,-0.45,-0.27,-0.67,2.33,0.6,1.56,-0.03,-0.82,2.17,0.46,-1.11,-0.57,-0.66,0.79,0.64,-1.43,-0.91,-0.57,-1.08,0.76,0.33,-0.58,0.75,-0.67,0.56,-1.02,-0.39,-0.12,-0.02,-0.68,0.36,-0.75,0.36,0.54,0.24,-1.08,-0.55,1.09,-0.36,-0.57,-1.19,-0.92,1.01,-1.35,0.77,1.23,0.16,0.05,0.16,1.12,-0.16,-0.01,3.41,1.94,-0.01,0.89,1.22,-0.03,0.88,-1.04,1.17,-0.15,-1.25,-0.3,-1.01,0.94,0.67,0.8,-0.84,0.94,0.26,1.33,0.58,-0.4,0.94,-0.81,-0.92,-0.11,-0.55,1.47,2.8,0.42,0.05,0.15,0.7,0.17,-1.25,0.23,0.72,0.24,-0.08,0.17,-1.65,-0.36,1.05,0.88,-0.27,-1.28,0.35,0.49,0.02,-0.86,-1.73,-1.71,-0.65,0.39,0.08,-0.01,0.88,-0.51,-1.66,0.63,-0.49,2.51,-0.95,-0.43,-1.82,0.76,-1.17,-0.78,0.08,-0.67,1.23,-1.96,1.08,-1.11,-2.02,0.18,1.46,1.02,0.69,0.97,-0.89,1.55,-0.63,-0.51,-0.74,0.72,1.26,0.97,-0.59,-0.71,1.21,0.45,1.99,-1.7,-0.45,0.99,-1.82,-0.45,0.35,0.15,0.03,0.84,0.42,1.09,1.41,-1.34,-0.56,-2.61,1.6,0.45,-1.58,-0.3,0.69,-0.63,-0.7,-1.07,0.56,-0.44,0.59,0.47,-0.31,-0.6,0.38,0.31,0.29,-1.36,1.87,-0.3,-0.15,0.62,-0.53,0.78,0.55,-0.69,-0.81,-1.92,0.93,-2.31,-0.86,0.2,0.43,1.07,0.97,1.91,-0.41,0.01,0.34,0.66,1.59,0.72,-0.59,0.96,1.09,0.83,0.2,-0.01,-0.31,0.97,-1.17,-0.88,-0.64,-0.02,-0.05,-0.57,0.77,0.72,1.2,-0.91,1.55,0.58,0.75,0.96,0.32,-0.24,0.56,-0.77,-0.59,-1.75,-0.86,0.52,-0.65,0.03,-0.85,1.94,1.52,-0.83,-0.52,-1.31,-0.51,1.42,-0.15,-1.19,-0.2,-0.78,0.54,0.11,-1.68,0.98,-0.59,0.04,-1.4,-0.05,-0.19,0.69,0.43,-0.82,-0.04,0.93,0.55,-0.77,-0.24,-1.86,0.27,1.68,0.54,0.88,-1.55,0.11,0.88,0.84,-0.51,1.29,1.13,0.56,-2.01,-0.07,0.33,0.31,0.03,-1.49,-0.37,-1.15,0.78,1.3,1.18,0.18,-0.19,0.52,-0.16,1.58,-0.52,0.84,-0.38,-0.04,-0.9,2,-0.03,1.37,1.09,1.26,0.21,-0.45,-0.13,-1.22,-0.34,-0.96,0.05,-1.2,-1.17,-1.04,-2,-0.41,-0.3,0.77,0.1,-0.66,0.27,-0.8,0.36,0.12,-0.51,-2.36,0.4,-0.14,0.36,0.11,-0.73,2.07,-0.2,1.42,1.74,0.15,0.99,0.87,1.32,0.99,-0.49,-0.46,0.33,0.15,0.64,1.75,-2,-0.31,1.22,-1.62,-0.88,-0.83,-0.96,-0.21,-1.36,-0.51,1.67,0.94,-0.77,0.56,-1.04,0.11,-0.7,0.58,0.5,1.69,-0.34,-0.17,0.93,0.12,1.36,-1.9,0.02,-0.48,-0.88,0.03,0.24,0.08,1.28,0.97,-0.26,0.3,-0.78,0.63,2.28,-0.52,1.56,-0.06,0.08,0.38,-0.92,1.01,-0.71,0.13,0.1,-1.02,-1.04,-0.26,-0.87,-1.56,-0.61,-1.2,-0.21,-1.71,0.56,-0.86,-0.98,-1.08,-1.23,-0.13,-0.57,0.63,2.52,0.51,-0.65,-0.13,0.22,-0.01,1.01,-0.17,-1.37,-0.66,2.56,1.49,0.91,-1.1,0.31,-0.19,0.26,-1.27,0.51,0.28,0.88,2.09,0.79,-2.04,-1.51,-0.55,0.75,-0.59,-0.5,-0.57,-0.21,2.5,1.65,1.13,1.08,1.17,-0.17,2.35,0.23,0.02,-0.19,0.78,0.5,-1.24,0.29,-0.09,0.27,-0.8,-0.88,0.32,-1.51,0.5,-0.33,0.7,-0.67,1.13,0.05,-0.3,-0.3,0.65,1.39,-1.59,0.51,-1.93,-0.66,0.21,0.27,-0.17,-0.44,-0.34,0.4,0.92,-0.39,-0.13,-0.31,1.34,0.61,0.23,-0.46,-1.3,-0.64,-0.95,1.02,0.22,1.08,-0.46,0.31,-0.5,-1.3,-0.68,0.94,-0.64,0.07,0.97,1.07,0.13,1.38,-0.82,1.33,0.25,-0.42,1.31,1.78,1.1,-1.07,-0.28,-0.09,0.06,-1.6,1.82,0.97,1.62,1.46,-2.14,-0.15,0.51,-1.48,0.75,-2.22,0.19,-0.34,0.2,-0.39,-1.27,1.44,-0.17,-0.29,0.84,-0.47,-1.1,0.08,-1.56,-0.95,-1.42,-0.73,-0.19,0.78,-1.08,-0.47,-0.93,-0.57,0.13,-1.33,0.25,0.06,0.6,-1.42,-1.19,-0.25,1.22,0.92,-0.35,-0.02,0.62,0.78,0.34,-0.78,0.77,-0.01,-0.56,-0.25,-1.68,0.14,-0.26,0.09,-0.18,-0.37,-0.38,-0.06,0.15,-1.41,2.3,0.41,-1.55,-1.9,1.29,-0.94,-0.25,0.92,0.39,0.04,0.55,0.14,0.7,-1.88,0.79,0.63,2.13,-0.08,-0.13,-1.66,-0.29,2.02,-0.55,-0.89,0.23,-0.71,0.91,-0.75,-0.63,0.12,0.3,-0.62,-0.05,0.42,-0.14,-0.91,-1.31,0.49,2.11,-1.18,-0.81,-0.31,1.32,0.35,0.64,-0.73,0.03,-0.71,0.35,-0.76,-0.11,-0.78,-0.22,-0.56,2.04,0.12,-2.53,1.34,-0.82,0.23,-0.82,-1.27,-0.74,0.68,-0.37,1.21,0.8,1.24,-0.57,0.19,-1.19,1.26,0.66,1.27,-1,-0.1,1.06,1.47,0.93,0.69,1.18,-0.23,-1.57,-0.98,-1.12,-1.26,0.4,-0.62,1.34,0.36,-1.86,-1.38,-1.67,0.37,-0.65,0.16,-1.1,0.4,1.23,1.19,0.46,0.89,0.09,-0.61,-0.2,0.7,-1.2,-1.11,0.81,1.35,0.54,1.09,-1.35,0.4,-0.51,-0.74,-1.46,-1.65,0.42,-1.11,-0.48,0.85,0.07,-1.63,-2.06,0.25,2.21,1.39,-0.47,1.57,1.83,2.21,-0.15,1.86,0.34,-2.35,-0.81,-1.06,0.2,-0.45,-0.48,-0.63,0.67,-0.67,-0.73,-0.01,-0.27,0.4,0.7,0.75,1.92,-1.25,-0.62,1.02,-0.07,0.47,-0.82,-0.62,1.3,-1.23,-0.34,-0.06,-0.69,-0.01,1.26,-0.96,-1.3,2.72,0.89,0.58,2.83,1.48,-0.67,-0.08,0.17,-0.45,1.58,-0.18,0.31,0.22,-0.76,1.4,1.77,0.67,0.74,-1.49,0.11,0.68,-0.92,0.6,1.41,-0.45,-0.51,-0.28,-0.26,1.1,0.99,0.58,-1.02,-0.09,-0.39,0.89,0.07,1.11,-0.18,0.69,-0.25,-2.44,0.45,1.48,-0.24,0.57,-1.24,-0.32,-0.01,-0.44,1.67,-0.41,-1.41,2.52,-0.35,0.59,-0.08,-0.81,0.14,-0.93,-1.76,-0.25,0.18,0.38,0.16,1.34,0.78,-1.54,-0.19,-0.88,-0.27,0.07,1.42,2.54,-0.29,-0.92,1.42,-2.19,0.12,-0.62,0.66,-1.3,-0.29,0.61,0.2,-0.84,-0.69,-1.17,1.34,0.64,-0.39,1.11,-1.31,0.45,-0.92,-0.33,0.75,-0.66,1.84,1.75,0.09,-0.43,0.14,-0.6,0.28,0.65,0.04,-0.01,-0.95,-0.27,1.19,-2.89,-0.27,-1.67,-1.37,0.26,-0.32,-0.05,-0.68,-1.06,0.34,-0.98,-0.5,0.21,1.59,-0.09,-0.6,-1.38,0.49,-0.92,-1.19,-0.62,1.09,2.66,-1.49,0.91,0.72,-1.14,0.46,-0.45,0.39,-0.36,0.37,0.93,-0.7,-0.89,-1.61,0.72,-1.34,-2.17,1.21,0.49,-0.6,0.08,1.84,0.13,0.38,0.83,-0.57,-0.65,0.9,1.07,-0.7,1.69,0.24,0.51,-0.36,0.3,-0.53,-0.64,0.38,0.24,-0.02,0.73,-0.45,-0.26,1.07,-0.56,0.25,1.02,-1.27,-0.47,0.34,-0.91,-0.71,-1.24,-0,-0.75,-0.3,-1.23,1.64,0.25,1.99,0.24,1.32,-0.99,0.12,0.82,-0.05,0.84,-0.29,-0.12,0.98,-0.22,1.67,0.47,-0.16,0.67,-0.4,1.53,0.42,-0.62,-0.51,-0.95,-1.64,-0.02,0.56,0.52,0.8,-1.24,-0.41,-0.6,0.64,1.07,1.14,-0.29,0.75,0.41,0.04,-0.3,-0.14,1.36,0.3,0.71,0.39,-0.39,-0.99,0.69,-0.69,0.5,0.24,-0.65,-0.41,1.01,0.2,1.64,0.06,1.52,1.56,-1.07,0.02,0.35,-1.58,-1.42,-2.37,-0.65,0.75,0.38,-1.01,-0.49,1.19,0.37,-1.14,-0.22,0.05,1.78,-0.37,-0.67,0.17,-1.11,0.9,-1.04,-0.6,-0.39,0.79,0,0.11,-2.02,0.15,0.91,0.52,-1.28,-1.62,0.04,1.67,0.86,0.12,-0.42,-1.11,-0.34,-0.41,-1.05,-0.14,0,-0.79,-1.51,-1.03,-0.31,-0.79,1.63,0.86,-0.63,0.24,-1.4,0.72,-0.03,-0.45,-1.81,0.62,0.89,-0.41,1.06,0.02,-1.04,1.49,0.86,-1.08,-1.39,1.46,-0.4,-0.26,-0.34,0.86,-0.01,-0.05,-0.62,-1.13,-0.49,-0.11,1.3,0.36,-2.35,-0.25,0.8,-1.14,1.01,-0.71,0.07,-0.02,0.1,-1.92,-0.25,-1.93,1.54,-0.52,1.07,1.24,-1.4,0.47,-0.23,0.14,0.06,-1.86,-2.67,0.87,-1.42,-0.24,-0.56,-1.04,-1.71,0.57,-0.99,-0.69,-0.06,0.28,-1.88,-1.44,-0.07,0.28,0.09,-1.31,-0.1,-0.82,-0.16,0.01,0.88,-0.99,-1.63,1.06,-0.32,-0.54,-0.18,0.95,-1.77,1.07,-0.77,-0.3,-0.04,-1.24,2.19,2.08,-0.94,0.56,-0.39,-0.57,1.03,-0.05,0.39,-1.18,0.36,1.61,0.32,0.49,0.61,-0.56,-1.02,2.18,-0.63,-1.65,0.56,0.84,0.52,-0.29,0.3,-0.67,-1.07,1.62,1.31,0.22,0.15,0.43,0.24,-0.7,-0.53,-0.49,0.86,-1.03,0.17,-0.64,2.68,0.26,1.08,-1.32,0.1,0.03,-0.43,1.38,0.77,1.67,-0.27,-0.63,1.04,0.29,-0.72,-1.41,0.19,0.31,-0.89,0.48,-0.52,2.02,-1.22,-1.07,1.3,0.17,0.83,1.9,-0.5,0.33,-0.24,1.12,0.76,-2.74,-0.27,0.49,0.79,0.22,1.91,1.95,0.3,-0.21,-0.98,-0.16,0.46,0.54,-0.43,0.04,0.18,0.21,0.76,1.13,-1.29,0.62,0.98,-0.17,1.6,-0.75,-1.55,0.7,-1.54,-0.49,-1.11,0.24,0.99,-0.25,1.95,0.46,-0.77,0.08,-0.86,0.38,-0.3,-0.94,1.95,1.18,1.08,0.9,-0.14,-0.33,0.54,0.75,0.6,-0.44,2.01,-0.31,0.17,0.42,-1.11,-0.83,-1.39,-0.23,0.21,-1.13,0.43,-2.9,-0.6,0.1,0.43,0.66,0.4,-1.71,-0.84,1.52,1.37,0.06,-1,1.06,-0.9,-1.13,-0.46,-1.74,-0.91,-2.14,-1.66,0.68,-0.81,0.38,0.24,0.04,0.86,0.13,0.01,1.07,-1.51,-0.2,0.96,0.73,0.85,-2.69,1.8,0.84,-0.25,0.53,-0.59,-0.79,-2.64,0.54,0.48,-0.54,-1.2,1.6,-0.05,-1.07,-1.55,1.04,0.15,0.95,1.54,-0.3,-0.34,-0.93,0.63,0.01,-0.85,-0.13,0.18,-0.69,-0.47,1.19,-1.03,1.2,1.17,0.62,0.15,-0.54,1.08,-0.61,-0.41,-0.35,2.07,1.45,-1.37,-0.6,-1.84,-0.2,0.45,-1.65,2.07,-1.11,-0.86,0.48,-0.76,0.85,1.93,0.3,-0.01,-1.26,-1.93,0.57,1.18,-1.21,0.7,-0.39,1.16,-2.01,1,1.53,-0.68,0.41,-0.06,-0.78,0.63,-0.76,-0.43,-0.92,0.47,0.63,0.53,0.05,1.09,0.28,-0.77,0,-1.07,1.45,0.51,1.53,1.81,0.31,-3.06,-0.23,0.92,-1.09,0.68,0.19,0.22,1.89,-0.23,0.68,0.07,-0.8,0.31,0.44,1.04,0.56,-2.63,1.41,1.23,1.49,0.73,1.24,0.24,0.03,-0.79,0.03,-0.9,-0.05,0.19,-0.4,0.75,1.2,2.07,0.86,1.65,0.73,-1,-1.06,0.16,1.25,-2.1,0.35,-0.83,1.76,-0.5,1.14,-0.58,0.65,1.76,0.15,0.26,-0.53,0.31,0.04,0.04,-0.95,-1.35,0.66,1.12,-1.44,0.85,0.36,1.54,3.02,0.25,0.18,0.49,-0.5,0.26,0.09,-0.85,-0.31,0.21,-2.6,-0.89,-0.08,1.67,-0.66,0.72,0.38,-0.98,0.34,0.25,0.61,-0.02,0.47,0.34,-2.24,-0.46,1.57,-0.9,0.57,1.44,0.74,-1.2,1.13,0.06,-1.97,-0.79,-0.5,-0.71,-0.47,-0.49,1.26,0.65,-0.14,1.36,-1.17,-1.9,0.59,2.4,0.19,-0.07,-0.05,-1.08,-0.83,-1.56,-0.45,-1.39,0.21,0.13,0.22,0.11,1.09,-1.19,0.51,-1.83,1.73,0.31,0.18,-0.33,0.87,1.36,0.22,0.86,1.37,-0.96,-0.31,1.64,0.05,1.69,-0.79,-0.96,-0.53,0.35,1.43,-0.37,0.45,0.56,-0.15,0.28,-0.58,-0.01,-0.57,0.33,-2.16,0.64,-0.9,1.85,0.66,-1.39,0.29,-1.26,0.76,-0.05,-0.6,-0.18,0.38,-0.21,-1.31,0.14,1.7,-0.54,1.08,-1.46,-0.86,-1.29,0.76,0.89,-0.15,-2.92,0.98,2.81,1.55,0.62,0.47,-0.21,0.43,0.63,0.12,-0.08,-0.28,0.08,-0.69,2.2,-0.85,0.73,0.91,-0.44,-0.97,-0.59,-1.08,-1.64,-0,1.12,-1.16,-0.29,0.77,2.19,-0.43,0.39,-0.96,2.71,-1.44,-3.03,0.46,0.04,0.82,-0.27,0.32,0.87,-0.24,1.13,0.06,-0.16,0.98,-0.79,-0.47,-2.56,0.53,0.54,-1.06,0.32,0.06,-0.43,0.14,1.06,-0.39,1.4,-1.91,1.3,-0.99,1.47,0.27,-0.67,-1.07,0.62,0.06,0.43,-1.36,1.06,0.4,0.37,0.11,0.99,-1.38,0.39,-0.53,1.41,-0.84,-1.44,-0.36,1.35,-0.38,0.4,0.01,-0.66,0.36,0.43,0.62,0.41,0.2,0.82,-0.65,-0.63,-0.91,-1.95,-0.03,0.24,0.46,1.22,-0.41,-0.56,1.7,0.6,1.63,0.9,1.05,-1.41,-0.85,0.64,-0.02,-0.72,0.04,-0.92,-0.69,-0.9,0.23,0.26,-0.69,-1.27,-0.45,1.14,-0.25,-0.9,-0.02,-1.74,0.73,0.75,-0.38,1.52,0.19,1.04,-0.44,-0.15,0.67,1.66,-1.34,0.82,-0.03,-1.24,0.39,-0.14,-0.32,-0.77,1.87,-0.16,1.15,-0.48,-1.06,0.22,-0.46,-1.62,-1.14,1.44,-1.48,0.36,1.09,-0.01,1.75,-0,0.33,-1.56,-1.03,-0.14,0.32,0.56,-0.76,0.83,1.77,0.65,-1.09,-0.7,0.25,-1.2,0.96,0.51,1.04,0.11,0.96,0.3,0.37,-0.53,0.75,0.27,-0.39,-0.29,2.28,0.4,-0.33,-0.72,-0.88,-1.32,0.59,-1.21,-0.28,0.35,0.29,-0.86,0.04,2.32,-0.42,0.64,0.76,0.97,-0.11,0.29,-0.08,1.72,-0.75,-1.11,-0.07,-0.18,0.71,0.12,1.54,0.29,0.61,0.73,0.67,-0.31,0.17,1.46,-0.65,-1.44,-0.48,-0.17,0.14,0.71,0.54,1.38,-0.06,1.3,1.93,-0.74,2.44,0.63,-1.77,-0.25,1.18,0.18,-1.8,-0.97,-1.11,0.47,-0.07,-0.54,1.35,1.01,-0.71,-0.59,1.93,0.31,0.64,-0.87,0.12,0.44,0.28,-0.94,0.34,-0.36,1.41,1.06,0.44,0.82,0.13,1.36,0.67,-1.42,0.19,0.03,1.41,0.34,0.98,-0.73,-0.4,-0.92,-0.71,-0.3,1.1,0.24,0.23,0.88,-1.27,2.11,-0.71,-0.34,0.67,0.11,0.38,-1.7,0.85,-1.08,0.2,-0.05,-0.28,0.03,-2.12,1.28,2.29,-0.57,-0.11,0.41,0.71,-0.55,-0.74,0.92,-0.71,-0.08,2.01,-0.78,0.37,0.67,2.03,-1.67,-1.91,-0.1,-1.56,-0.91,1.25,-1.04,0.51,1.08,0.58,-1.99,0.75,0.23,-0.75,0.97,0.75,0.25,1.68,0.18,-2.45,-0.46,-0.39,0.16,-0.41,0.19,3.11,2.29,0.27,1.75,0.16,-0.27,0.16,-0.89,-0.14,-0.88,0.37,0.6,0.6,-1.18,0.11,-0.86,0.15,1,-0.19,-1.22,-1.39,0.14,0.5,-2.04,0.98,-0.33,-0.76,-0.25,-0.7,1.51,-0.36,1.53,-1.54,0.89,-0.64,-0.55,0.55,0.77,0.94,0.15,-0.6,0.52,-3.3,0.04,0.68,1.56,-1.22,0.02,0.9,-0.22,-0.45,0.85,-1.23,-1.25,-0.3,-0.56,-1.55,1.76,0.26,1.19,1.4,1.3,2.08,0.13,-1.04,-0.5,1.17,-0.25,1.54,-0.13,-1.27,-0.15,-0.48,0.64,-0.56,0.26,-1.78,0.68,0.11,0.17,0.74,-1.52,1.41,-0.72,-0.4,-0.15,0.84,0.92,1.37,0.6,0.79,0.92,-1.95,0.53,0.94,-0.02,-0.23,1.16,1.61,0.39,-0.13,-0.24,0.96,0.63,0.55,-0.38,-0.66,0.02,-0.19,-0.5,0.21,-1.64,1.99,-1.05,-0.07,0.17,-0.22,-0.81,-1.36,0.12,-0.71,-0.31,0.39,0.75,1.04,0.18,-0.63,0.29,-0.15,-0.67,0.71,0.38,0.24,0.59,-0.8,-1.51,-0.3,-0.61,-0.61,-0.63,-1.46,-0.05,-1.11,-2.64,0.83,1.33,1.17,0.52,0.16,-0.51,0.76,1.17,-0.47,-0.8,0.26,-0.41,-0.63,-0.29,0.28,-0.55,-1.04,-0.05,0.84,-0.18,1.07,-0.54,-2.59,-0.94,-1.51,-0.19,0.87,0.11,-0.13,-1.52,0.5,0.09,-1.95,-1.38,-2.1,-0.73,-0.01,0.65,0.01,0.8,-0.47,-0.68,-0.2,-2.26,0.96,1.43,-0.47,1.13,-2.44,-0.07,0.29,-0.41,-1.1,0.91,1.21,0.8,0.23,-0.25,0.47,-0.71,-1.24,-0.03,-2.49,0.71,0.5,-1.39,-1.09,2.31,-1.44,-0.73,-0.65,0.08,-1.03,-0.41,-1.28,0.88,0.77,2.47,0.05,1.68,2.49,0.73,-1.06,-0.46,-0.35,-0.68,1.43,-0.07,-1.14,-1.58,1.45,-0.63,-0.92,1.28,2.27,0.48,-0.44,-0.77,-0.24,-0.19,0.73,0.07,0.83,-0.18,0.51,-0.86,-0.44,1.25,1.41,1.88,1.14,0.14,-0.87,-0.04,2.42,-0.11,0.11,-0.37,-1.61,-1.38,1.89,-0.98,-0.69,1.62,-0.25,-0.86,1.12,-0.22,-1.45,0.45,0.77,0.11,0.13,1.73,0.87,-0.42,0.46,0.86,0.58,-1.02,0.06,0.66,-0.42,0.91,0.06,-1.05,0.27,0.39,0.19,1.6,-1.74,-0.32,-0.48,-1.34,0.71,0.56,-0.7,1.33,0.21,-0.75,-1.15,-0.32,0.89,-0.07,-0.05,0.47,-1.54,0.86,-1.18,0.33,0.73,-0.36,-0.3,-1.21,0.73,-0.39,-0.43,-0.23,-0.36,1.08,0.76,0.55,-0.21,0.39,1.09,1.26,-0.62,1.09,-1.35,0.05,-0.3,0.02,0.75,0.02,-0.66,-0.23,0.12,-0.07,-1.15,0.95,-0.18,-2.26,0.09,0.21,-0.31,-0.12,0.93,-1.17,1.49,-1.84,2.88,0.16,-0.15,-0.41,0.79,0.19,-1.51,-1.13,0.87,1.73,-0.25,-0.64,-0.62,-0.55,1.21,-1.2,1.1,-0.56,-0.6,-0.07,-0.2,-0.36,1.56,0.94,-0.93,2.1,-0.97,0.05,1.2,-0.75,-0.06,-1.86,-0.86,-0.72,-0.98,0.61,-1.85,1.2,-1.21,0.28,0.97,-1.61,-0.14,-0.37,0.74,-0.19,-0.51,0.51,-0.4,0.56,-1.2,-0.85,-1.28,-0.28,-0.73,-0.12,1.26,1.08,0.39,-0.7,0.56,1.1,1.83,1.03,-1.96,-0.45,-0.26,-1.19,0.02,-0.53,1.57,0.31,-0.24,0.27,0.82,0.56,-0.05,1.34,1.59,-0.78,-1.26,0.51,-1.37,-0.84,-0.23,1.41,0.03,-0.55,-0.55,0.48,-0.78,-1.62,0.73,0.41,0.26,-2.09,0.81,0.21,-0.12,-1.39,-2.32,0.54,0.28,0.47,-0.92,-0.75,0.28,0.13,-1.82,1.96,-0.84,0.05,-0.33,0.74,-0.37,-1.3,0.39,1.09,1.19,-0.46,0.8,1.04,0.72,-0.89,0.65,-1.64,-1.03,1.28,1.88,1.23,-0.59,1.51,2.19,0.31,0.31,-0.76,-0.29,0.46,-1.26,-0.88,-0.46,-1.06,-0.45,-0.08,-0.85,-1.02,-0.83,-0.83,-0.69,-0.94,0.08,-0.87,0.14,-0.52,0.18,-0.54,-0.35,-0.08,0.82,-0.28,-0.38,1.21,0.38,-1.15,-0.36,-1.89,1.8,0.49,-0.9,0.74,-0.94,0.17,0.35,-1.67,1.02,-0.5,-1.41,-0.21,-0.11,-1.83,-0.92,0.05,0.83,0.31,-1.53,-2.12,0.96,0.4,1.18,-0.57,1.03,-0.15,1.65,-0.15,-1.85,-0.43,-1.16,0.91,-1.75,-0.4,-0.98,-0.09,-0.65,-0.58,1.74,-0.09,0.61,1.71,-0.1,-1.04,0.7,1.1,0.12,1.07,-0.55,-0.96,0.29,-0.33,-0.62,-0.08,0.45,-0.81,1.36,-2.52,-1.43,1.36,0.21,-1.2,0.51,-0.17,0.26,-1.07,1.31,-2.06,-0.53,0.19,-0.64,-0.66,0.95,1.06,-1.38,0.1,0.2,-1.02,0.49,-1.35,-1.36,0.2,0.56,-1.77,1.18,1.61,0.5,-0.01,0.85,-1.15,-1.95,0.27,-2.02,-1.27,0.2,0.98,2.58,0.1,0.02,-2.25,-0.96,-0.26,-2.04,-0.49,-0,-1.23,0.71,0.18,-0.31,0.89,-0.24,-0.29,-0.5,0.13,0.84,0.77,-1.21,-0.52,-0.1,-0.65,-1.59,-1.4,-1.27,1.14,0.51,-0.94,-1.02,-0.4,0.79,1.4,-0.02,-0.03,-1.06,1.4,-0.05,-2.23,2.08,-0.13,0.18,0.16,-1.64,0.44,0.84,1.76,0.32,0.6,-2.32,-0.69,2.08,-0.01,0.62,-0.18,-0.62,-0.47,-0.91,-0.53,0.91,-0.72,-1.05,0.5,-0.11,0.65,-0.01,-0.35,1.49,-0.64,-1.12,-0.54,0.74,-0.64,0.21,1,0.76,-0.98,0.85,0.18,1.57,1.59,0.05,-0.34,-0.09,0.29,-0.87,-0.11,-0.17,0.03,-0.38,-0.23,-0.27,0.41,-0.18,-1.86,-0.83,-0.69,-0.26,-2.33,0.11,-0.65,0.27,-1.69,0.2,0.75,-0.03,0.65,-1.64,0.48,-1.28,-0.65,-0.73,1.25,-1.3,-0.73,1.5,-1.97,1.13,1.39,-1.34,1.38,-1.3,0.37,2.7,0.61,-1.63,0.13,1.26,1.16,1.41,0.46,0.18,-0.14,1.04,-1.98,0.92,1.58,0.28,0.02,-0.33,-0.25,0.94,-1.29,1.13,0.13,0.89,0.72,-2.44,0.26,0.73,-0.32,0.91,-0.08,0.13,-1.01,-2.5,-0.43,-0.05,0.35,-0.5,-1.76,0.49,0.35,-0.72,0.47,2.06,-0.13,1.09,0.36,1.64,-1.9,-0.27,-0.19,-0.23,1.12,-0.23,1,0.49,-0.29,-0.23,-0.74,0.18,-1.46,0.11,-1.24,0.21,-0.58,0.82,0.51,1.09,2.5,-0.73,-1.46,0.93,2.03,-1.35,0.84,0.01,0.89,-0.38,0.12,1.97,-0.09,0.98,0.1,0.21,-0.31,0.14,2.35,-0.51,0.46,0.29,0.72,0.05,-1.06,0.52,0.41,1.17,0.57,0.96,0.87,-0.33,1.14,0.6,-0.56,1.51,-0.31,1,-0.13,-0.74,1.45,0.06,0.21,-0.17,-0.32,0.67,1.41,-0.59,-0.88,-1.4,-1.02,-1.39,0.33,-1.68,-0.05,0.8,0.23,0.82,1.69,-0.5,-1.65,-0.33,-0.04,1.49,1.03,-0.83,1.23,-0.27,1.67,1.7,0.6,0.94,-0.25,1.65,-0.72,0.27,-1.01,-0.35,2.48,1.43,-0.75,0.34,-0.3,1.21,-2.01,-1.26,-0.26,-0.3,-2.26,0.32,1.35,-0.44,-0.04,1.37,-0.41,-0.17,-0.14,0.15,0.56,-0.49,1.62,0.44,0.77,0.4,1.21,-0.27,0.78,-1.19,0.99,-0.57,1.02,-0.46,0.7,0.22,-0.2,0.22,1.22,-0.68,-0.33,0.48,-0.09,-0.96,0.57,1.63,0.36,-0.45,0.48,0.46,-0.61,0.38,1.55,-1.17,0.86,-0.23,0.86,0.43,-0.74,-0.05,0.83,-2.3,0.48,-1.62,-1.34,0.62,-0.15,-0.27,0.19,0.41,0.78,1.14,-1.12,0.06,0.86,0.99,1.08,0.95,-0.45,-0.43,0.58,0.64,-1.59,0.4,-2.32,1.78,0.9,0.42,1.05,-0.96,-0.22,0.27,-1.03,-0.91,-0.05,0.42,-1.46,0.46,-1.4,-0.69,-0.53,-1.84,0.65,-0.75,1.14,1.59,-1.37,-1.33,-2.09,-1.38,-0.34,-1.74,-0.05,-0.84,-0.7,-1.98,0.56,1.19,0.53,0.31,0.01,-0.47,0.62,1,-1.49,-0.27,-0.01,-0.42,-0.1,-0.65,0.69,0.37,-2.21,-0.15,0.96,0.32,2.81,-1.32,0.94,-1.13,-0.72,-1.23,-0.38,0.75,0.75,0.76,0.06,1.21,1.42,0.75,-1.16,-0.11,0.31,0.69,0.38,0.04,0.56,0.4,0.3,-1.2,-0.36,0.43,0.12,0.64,-0.41,-1.73,0.55,0.43,-2.47,-0.63,0.57,1.75,1.09,1.46,-0.68,0.67,-0.25,0.19,0.75,-0.36,-0.52,-0.94,1.51,-2.48,0.57,-0.35,0.38,0.83,0.87,-2.06,0.12,-0.4,-0.97,1.01,0.06,0.22,-0.1,-0.17,0.1,1.5,-0.42,-1.01,0.28,-0.4,-0.05,0.22,-0.66,-0.48,0.16,-1.82,0.76,-0.08,0,-0.91,-1.9,0.08,0.78,0.47,0.14,0.98,-0.07,-0.98,2.5,-0.74,-1.74,-1.23,-0.56,-0.8,0.53,-1.11,-0.63,1.36,-1.02,-0.15,0.43,-0.87,-1,-1.88,-2.06,0.98,-1.8,-0.5,1.11,-1.13,-1.29,-0.73,-0.01,-2.36,1.42,-0.23,-1.71,-0.09,1.59,-0,-0.73,-0.73,0.36,1.28,1.52,0.69,1.41,-0.78,0.35,-1.16,-0.92,-0.04,-0.17,-0.72,-0.66,-0.42,0.57,-0.55,0.67,1.5,-0.08,0.98,1.08,0.65,2.24,-1.75,-0.14,-0.31,1.85,0.06,1.15,0.07,0.59,0.25,-1.38,-0.29,-1.26,2.37,1.75,-2.06,-0.79,-0.79,1.48,-0.3,-1.26,-1.22,-0.5,3.18,0.18,-1.08,0.34,-0.68,1.84,-0.97,1.79,-1.02,-0.69,0.63,-0.57,0.91,-0.93,-1.42,0.27,-1.6,0.72,-1.99,-2.96,0.47,1.02,-1.12,0.68,0.8,0.16,-0.17,2.05,-1.15,0.44,-1.89,-1.31,1.02,1.26,-0.06,-0.13,-2.49,-0.58,-0.08,1.12,-0.52,0.79,0.61,1.47,0.84,-1.66,1.76,-0.69,-0.2,-0.32,-0.17,-1.65,0.83,1.72,0.74,0.01,1.29,-0.33,-1.43,1.92,-0.57,1.46,-0.63,1.57,-0.88,-0.98,0.75,0.18,-0.08,-1.32,1.2,0.22,-1.17,0.81,-0.52,0.19,-0.56,1.08,0.65,0.02,0.79,1.01,1.01,0.08,-0.51,0.37,-0.77,0.39,0.17,0.97,0.1,0.76,-0.2,1.43,0.35,-0.38,-0.25,0.89,0.82,0.49,0.36,-1.26,-0.86,-0.19,-1.3,0.27,1.17,-0.93,1.33,0.36,-0.37,-0.4,0.91,0.11,-0.32,-1.37,-1.21,0.3,-0.34,-0.77,-0.58,0.51,-0.7,-0.28,0.5,-0.35,0.31,-0.16,-0.9,1.17,-0.82,-1.06,-0.44,2.4,-2.9,0.62,-0.37,0.94,0.6,-0.01,-0.19,1,-1.18,0.4,-0.17,-0,0.28,-1.03,-0.85,-1.04,-0.92,1.32,-0.23,-0.2,-1.02,0.02,-0,1.5,0.67,-0.82,2,-0.2,0.44,0.78,-1.06,-1.72,-0.44,-1.32,2.56,0.21,-1.55,-0.45,0.49,0.61,1.02,0.5,-0.67,-2.06,0.63,1.28,-0.16,-0.12,0.17,2.35,-0.44,0.28,-0.63,-0.03,0.26,-1.52,0.88,2.03,1.1,0.29,1.5,-0.26,-1.01,-0.83,-0.24,0.67,0.13,-0.88,1.19,1.67,-0.83,0.34,0.11,0.04,-1.35,-0.05,-1.48,-0.75,0.27,-1.31,0.46,-0.81,1.16,-1.93,0.01,0.01,0.64,-0.97,-0.18,-1.16,-1.18,-0.06,0.65,-0.54,-1.29,-0.74,-0.35,1.45,-0.44,0.07,-0.25,-1.24,-0.34,0.39,-0.73,-3.08,-0.31,0.1,-1.52,-0.2,1.69,-0.18,0.6,-1.46,-0.26,-0.12,-1.5,0.74,1.43,1.69,0.64,0.66,0.21,-0.45,0.4,-1.47,-0.11,1.28,2.26,-1.38,-1.1,-0.09,0.98,0.74,-0.32,0.38,0.86,-0.35,-1.94,-0.8,-0.61,-0.87,-0.21,1.27,0.39,1.73,-0.14,-0.92,0.53,-0.72,0.12,0.21,-0.34,-0.22,-0.6,-0.66,-0.95,-1.63,-0.06,-0.42,0.99,0.64,0.7,-0.96,-1.24,-1,1.01,-0.77,0.09,-1.31,0.98,-0.81,1.69,-1.35,-0.81,-0.29,-0.24,0.72,1.31,0.09,-0.21,-0.54,0.3,-0.68,-0.45,1.09,-0.02,-0.59,0.2,-0.59,-0.61,-0.94,0.83,-0.83,-0.8,-0.5,-1.17,-0.46,-0.59,0.23,0.99,-0.84,0.92,1.37,-0.51,-1.89,-0.48,0.28,0.65,1.38,1.55,-1.24,-1.84,0.86,0.43,0.63,-0.24,-0.85,-0.95,-0.76,-1.21,0.46,2.16,0.1,0.73,-0.19,0.24,-0.26,0.2,2.12,-0.3,-1.96,-0.63,-0.64,0.92,0.39,0.4,-1.01,-1.68,-0.3,1.85,-1.71,0.29,0.15,0.86,-0.95,1.25,-0.85,0.29,-0.12,0.04,-0.16,-0.68,-1.22,1.03,-1.59,-1.79,-0.46,-0.37,0,-0.51,-0.73,-1.75,-0.67,-0.47,0.39,-0.52,1.87,0.17,1.64,0.8,1.89,-0.88,0.77,0.45,0.23,-0.84,-0.45,-1.65,0.14,-0.12,-1.38,-0.06,-0.41,-1.11,-1.19,-0.69,-0.71,0.45,-0.53,0.96,-1.44,0.85,-0.09,-0.21,-0.2,-0.31,-0.36,0.07,-0.65,0.11,-0.71,0.35,0.29,-2.6,-0.59,0.84,-0.34,0.13,-0.63,0.99,-0.27,0.84,-0,-0.44,0.78,-1.45,-0.2,0.56,0.19,-0.06,1.79,-1.1,-0.43,2.25,-0.56,-0.12,-2.08,1.64,-0.04,-0.09,0.91,-0.62,0.55,0.2,-0.04,-0.7,0.02,0.22,-0.55,-1.23,1.69,1.51,-0.24,-0.98,0.69,-0.3,-0.63,-0.85,-2.12,0.29,-0.46,-0.78,-0.04,-0.03,-0.94,1.33,-0.72,0.25,-0.11,0.05,-1.26,-0.84,0.93,-0.33,-0.95,-0.05,-2.63,1.01,1.23,-0.84,0.83,0.59,-2.24,0.77,0.05,0.42,-0.1,0.69,-1.84,1.26,0.49,-0.59,0.49,0.82,0.45,-0.01,-0.34,-0.26,-0.94,-0.09,0.1,-0.32,1.07,2.05,1.38,-0.24,0.71,1.18,-0.38,0.5,2.58,1.41,1.21,-0.37,0.41,0.62,-0.44,0.92,1.09,1.43,0.38,0.18,1.72,-0.44,-2.38,0.38,-1.89,1.08,0.04,1.02,-1.34,0.16,-1.64,0.83,-1.15,1.86,2.09,0.48,-0.62,1.82,-3.05,-0.64,-0.26,-0.7,1,0.57,-0.43,0.74,1.56,1.52,-0.76,0.21,-1.34,0.69,-0.46,-0.02,-0.37,-0.51,-1.46,-0.29,-0.3,0.35,1.79,0.19,-1.76,0.19,0.58,1.64,-2.2,2.1,0.42,0.16,-1.24,1.18,0.7,1.38,0.51,1.34,-0.83,1.95,1.86,1.21,0.22,-0.05,1.41,0.61,0.95,-0.84,1.09,-0.24,0.06,-1.02,-0.01,-0.15,0.12,-1.9,-1.41,-0.95,-0.63,0.59,-0.68,0.11,-1.91,0,-0.41,0.79,-0.91,-0.43,-1.21,0.09,-1.56,-0.08,-0.91,-0.96,0.17,1.08,1.86,-1.47,-1.3,0.33,0.12,-0.47,1.94,-1.09,-2.29,0.52,1.42,0.43,-0.18,1.23,0.88,-1.66,-0.5,0.16,-1.93,-0.37,-1.48,-1.48,-1.37,0.95,0.43,1.54,-0.14,-0.17,-0.96,0.47,0.29,1.82,0.95,-0.06,1.22,-0.01,1.13,-0.71,-2.73,-1.02,0.3,1.21,-0.8,-1.85,0.42,0.12,-1.04,-0.4,0.04,0.12,0.01,1.36,1.54,0.66,-0.4,0.47,-1.06,-0.9,0.23,3.11,-0.4,-2.33,0.33,-0.83,0.41,0.96,-0.84,-0.2,-1.12,-0.13,-0.57,0.9,1.98,-0.69,-1.21,-0.97,-1.41,0.51,0.35,0.49,2.08,-0.02,-0.72,-0.14,-1.65,0.72,0.2,0.39,0.44,-0.96,-0.61,1.92,0.92,-0.61,-1.99,1.26,0.06,-0.56,0.33,0.54,-0.21,0.73,-1.47,-0.85,-0.31,-0.1,-0.04,-0.33,-0.14,-2.35,-0.1,-1.31,0.41,0.33,-0.96,-2.52,-0.21,-0.08,-0.08,-0.09,-0.07,0.7,-0.57,0.61,-0.38,-1.34,-0.31,-0.39,1.2,-0.2,0.27,-0.8,-0.41,0.42,1.23,-0.02,-1.32,1.64,-0.42,0.15,-0.18,-1.38,-1.53,-0.42,0.32,-0.48,0.82,-0.07,-0.79,-0.88,-0.07,1.08,1.14,0.45,-0.39,-1.2,-0.05,-0.58,2.28,-0.36,0.24,-0.8,0.39,0.49,0.28,0.05,-0.66,-0.34,-0.23,-0.17,-0.15,0.91,0.39,0.63,1.28,0.61,-0.62,0.5,-1,-0.15,-0.59,0.58,-1.41,1.04,1.24,0.42,-0.03,0.78,-0.95,1.18,-1.82,0.65,1.13,-0,-0.97,1.09,-2.2,0.1,-2.88,-0.37,0.14,1.53,-1.24,-0.72,0.93,-1.87,0.23,0.46,0.83,0.87,-1.72,-0.15,0.3,-0.13,0.89,-0.72,0.91,-1.45,-0.05,2.45,-0.07,-1.13,-0.74,-0.71,-0.74,0.18,0.5,-0.06,0.49,0.63,0.5,1.48,-0.36,0.51,-0.72,0.41,-0.83,-1.1,0.37,0.16,0.16,0.42,-0.28,-0.11,0.64,1.45,-0.16,0.53,0.51,1.17,0.69,-1.64,0.54,-0.3,-0.52,-1.9,-1.93,-0.55,-1.5,-0.26,0.77,0.69,-1.72,-0.18,-1.7,-0.35,2.43,-1.15,-0.37,-1.48,0.28,-0.78,-1.26,-1.29,1.06,0.29,0.52,-1.55,-1.27,0.65,1.1,0.08,-0.37,0.12,-1.07,-0.18,-0.31,0.7,0.78,-0.99,-1.57,-1.36,-1.26,-0.46,-0.52,-0.55,1.74,0.03,2.01,-0.17,-0.65,0.45,-1.16,-0.74,0.7,0.56,0.59,-1.09,2.02,0.61,-0.93,-0.74,1.49,-0.74,-0.78,-0.2,0.29,-0.05,1.01,-1.44,0.04,-1.09,1.46,1.52,0.82,-1.01,1.65,-0.57,-0.57,1.57,0.61,0.06,-0.38,0.49,-1.99,1.13,-1.07,-0.99,0.08,-0.1,0.13,-0.01,1.08,1.74,-0.07,-1.14,-0.32,0.73,-0.78,-1.55,-0.46,0.5,-0.29,-0.11,-0.11,1.09,1.37,-1.38,0.68,0.1,-0.45,-1.34,1.22,0.14,-0.78,-1.28,0.66,1.76,2.05,0.12,0.05,-0.39,-1.01,1.32,1.04,-0.09,0.16,1.05,1.76,-0.05,0.67,-0.11,1.02,-1.51,-0.17,0.13,-0.72,-0.33,-0.02,-2.4,0.53,0.79,-1.77,-0.07,0.51,1.35,0.74,0.6,-1.06,0.22,0.52,0.28,1.53,-0.33,0.61,0.12,-0.53,1.67,0.47,-1.44,-1.17,-0.84,0.84,-1.48,0.67,0.18,-0.32,0.61,-0.19,-1.44,0.33,-0.97,0.51,-0.04,0.22,-0.07,-2.09,0.13,0,-0.66,-1.02,-0.56,-0.78,-0.33,-1.26,1.22,1.34,0.47,-1.05,0.24,1.57,2.03,-1.4,1.63,-0.26,0.23,-0.13,1.63,1.51,1.38,0.79,0.87,0.03,0.25,-0.29,0,-0.75,-0.73,-1.19,-0.17,0.59,-1,-1.81,-1.99,-0.84,-0.59,1.68,-0.33,-0.49,-0.09,-0.6,-1.12,0.55,0.06,0.52,0.39,0.06,1.47,2.66,-0.82,0.13,-1.09,-0.16,1.34,0.85,0.57,-0.12,-0.19,0.4,1.1,0.82,0.87,1.39,-0.32,-0.12,-2.35,0.9,-0.26,-1.1,0.64,1.14,2.47,0.42,-0.33,0.26,3,-1.12,1.41,-0.65,-0.34,-0.98,-0.41,0.02,0.85,-0.14,0.44,-0.6,-0.75,1.21,0.52,0.46,1.43,1.73,1.04,0.61,0.25,0.41,-1.49,-1.33,-0.57,0.02,0.85,0.71,0.18,0.76,-0.04,-0.13,-1.76,-0.97,-0.58,0.39,-0.42,2.09,-1.09,-1.36,0.27,-0.71,-0.53,-0.05,-1.43,0.05,-0.83,-0.07,0.37,-0.5,-1.11,1.35,-0.09,0.69,-0.26,-0.54,-1.21,-0.03,0.22,0.38,-0.09,1.2,-0.81,2.58,-0.83,0.18,-0.78,-0.21,1.02,-0.99,0.32,-0.14,0.06,-1.23,0.21,-0.21,-1.1,-1.16,1.28,-0.38,0.24,-0.84,-0.2,-0.2,0.15,-0.42,0.27,-1.07,-0.2,-0.15,-0.79,-0.77,-0.14,-0.12,0.83,-0.19,-0.21,1.46,-1.04,-0.68,-0.58,0.74,0.81,1,-0.27,0.35,-0.79,-0.37,-0.31,-0.77,0.14,0.64,-0,0.02,0.72,1.65,0.25,-1.18,0.38,0.66,-1.15,0.49,1.93,-0.01,-0.37,0.09,-0.7,-0.23,-0.33,0.94,-0.73,0.51,0.19,-0.34,0.09,0.57,-0.55,-1.07,0.7,-0.87,0.08,0.71,1.51,0.79,-1.16,-0.3,0.3,0.02,-0.25,0.89,0.58,0.23,0.69,-1.17,0.56,0.14,-0.28,-1.65,-0.67,0.77,0.53,0.59,0.68,0.62,1.44,-0.4,-0.9,-0.83,-1.4,-0.41,0.78,-0.5,1.55,0.53,-0.53,0.08,0.75,-2.09,-1.15,0.23,0.81,0.76,0.91,1.88,-0.27,-1.21,0.06,2.19,-1.14,0.48,1,0.54,0.46,1.29,0.2,-0.6,1.52,-0.37,-1.01,-0.77,-0.34,-0.79,-0.31,1.34,0.12,0.54,-0.07,-1.4,0.41,2.1,1.32,1.07,1.41,0.41,0.9,-0.72,-1.88,-0.64,-0.87,-0.32,0.11,0.11,-0.11,-3.07,-1.59,1.36,-0.29,-1.15,-0.76,0.9,-2.1,1.67,0.77,1.2,0.76,1.2,0.18,0.26,-2.15,-1.7,-0.19,-0.02,-1.03,0.45,0.63,-1.33,0.45,-0.71,1.61,-1.1,-0.74,0.92,-0.12,-1.31,-0.96,0.51,-1.92,0.71,0.24,-0.22,0.13,-0.92,0.71,1.04,0.14,1.55,0.62,-0.79,0.29,-0.9,-0.26,-0,0.78,-1.46,-1.09,1.33,-0.13,1.01,-0.21,0.65,-0.53,-0.99,1.51,-0.07,1.23,0.34,-0.97,0.98,-0.1,0.56,-0.1,-0.05,-1.43,1.35,-0.71,0.15,-1.28,-0.21,-1.13,0.21,-1.14,0.13,-0.99,1.58,-0.04,-0.27,-0.24,1.07,0.86,0.93,0.38,-0.52,-0.28,-0.63,1.55,-1.91,0.4,1.98,-0.27,0.53,-0.46,-0.93,-0.56,-1.44,1.91,-0.02,-0.22,-0.03,-0.92,0.9,-1.29,0.86,-1.17,0.54,0.67,0.01,1.31,1.41,-0.38,-0.98,-0.68,-0.4,1.96,0.44,0.34,-0.94,-0.39,-0.39,0.03,2.35,0.17,-0.44,-0.49,-0.05,1.27,-0.33,-0.42,0.94,-3.02,-1.61,-1.12,-0.8,-0.69,-1.34,-0.09,-0.35,0.55,-1.19,0.29,-1.18,-0.56,0.86,0.16,0.48,0.71,-0.85,1.63,-2.24,1.15,-0.05,0.78,1.09,0.82,-2.13,1.67,1.42,-0.95,1.08,-3.28,-0.96,0.36,-0,1.3,0.26,-0.08,-0.33,0.19,-2.18,0.76,-0.44,-0.33,-0.73,-0.58,-0.17,1.14,-0.18,-2.14,-0.49,-0.6,-0.51,0.81,1.15,0.05,-1.72,1.49,-0.12,0.51,-1.61,-0.75,0.39,0.18,0.2,1.37,1.37,0.28,0.09,-2.23,0.53,-0.61,-0.74,-0.26,-0.55,-1.58,0.32,1.43,-0.14,0.47,-2.32,0.58,0.1,0.2,0.21,0.17,-0.1,-0.94,-1.35,-0.01,-0.69,-0.95,0.64,0.63,-1.77,-2.42,-0.33,1.28,-0.25,-0.93,0.41,1.34,-0.35,0.47,-0.72,0.38,0.1,-0,-0.2,1.27,1.35,1.69,-1.4,-0.33,-1.07,-0.82,-0.6,0.91,-0.37,-0.5,0.31,2.19,0.28,0.4,-0.01,0.61,-0.91,-1,0.61,0.86,-0.18,0.69,-1.43,-0.25,-0.74,-1.39,0.71,-0.97,-0.54,0.49,-0.99,0.51,-1.81,-0.84,1.09,0.94,-0.13,0.63,-0.45,1.02,0.18,-2.35,-0.5,-0.69,0.55,2.04,-0.1,0.69,-0.46,-0.94,-0.79,1.05,0.24,-0.33,0.71,-0.67,-0.48,0.03,1.01,0.96,-0.34,-0.78,1.68,-1.9,-0.17,0.47,-2.24,1.25,1.37,-1.72,-0.51,-0.49,-0.06,0.4,-0.62,-0.02,0.58,0.45,0.51,-0.31,0.72,0.2,0.37,0.66,0.94,-0.33,-0.12,1.08,-0.06,0.33,0.48,1.33,-1.67,1.54,0.33,0.63,-0.51,-1.94,1.12,-0.42,1.08,0,-0.62,-0.13,-0.1,-1.08,1.31,0.54,-0.07,0.68,0,-0.44,0.94,-0.81,0.71,0.12,-2.57,-0.11,-0.86,-1.13,-0.3,0.25,-1.04,0.28,-0.4,0.08,-1.04,-1,0.63,1.52,0.77,0.45,-1.98,0.3,0.55,-0.85,1.45,-0.3,2.52,-0.16,-0.7,0.64,-1.01,0.25,0.63,0.79,0.52,-0.43,0.57,0.74,-2.32,0.46,0.96,-1.52,-1.11,0.54,-0.44,0.85,-1.99,-0.51,0.06,0.36,-0.85,-0.56,0,-1.33,-1.49,1.25,-0.2,2.27,1.48,0.74,-0.06,0.56,-0.86,0.86,1.64,-1.28,0.01,1.19,0.43,-0.23,-0.58,-0.49,-0.13,-0.61,-0.46,1.16,-1.01,-0.62,-0.86,0.78,-1.33,-0.43,-0.02,-1.85,1.37,-1.11,1.39,0.12,0.04,-1.83,0.7,0.21,-0.41,1.13,0.08,0.17,-1.12,-0.7,-0.77,0.71,1.82,-0.49,-0.38,0.21,0.04,0.31,-1.17,-2.03,1.23,1.09,0.96,0.66,0.72,-1.19,-1.15,0.13,0.62,0.59,1.17,-2.58,0.63,-0.38,0.46,-0.52,-0.83,-0.47,0.57,0.17,-1.23,-0.54,3.02,0.1,-0.05,-1.51,-0.03,0.4,-0,0.72,0.02,-0.09,-0.32,-1.92,0.18,0.87,-1.03,-2.64,0.06,-0.08,0.33,1.28,0.21,-0.28,-0.4,-0.56,0.33,-1.16,-0.07,1.07,0.72,1.08,-0.74,-0.29,-0.95,-1.22,-0.46,-1.82,-0.33,-0.16,-1.16,0.5,-1.12,-0.06,-0.17,0.04,-1.64,0.48,0.1,2.11,-0.5,0.43,-0.13,-0.49,0.5,-1.17,0.88,0.02,-0.82,1.44,-0.25,0.76,-0.73,-0.99,0.73,-0.2,-1.07,-1.13,-0.64,-0.03,1.16,0.93,0.95,-1.95,1.3,0.64,-1.69,0.8,-0.58,-0.01,0.84,1.3,0.09,0.31,-1.84,-0.28,-1.92,0.44,-1.58,0.62,-0.64,2.27,-0.45,-1.6,-0.5,1.26,0.52,0.57,0.83,1.7,-0.69,1.04,0.45,-1.06,1.25,2.03,0.86,1.25,-1.51,0.81,-1.73,1.43,-1.28,-0.36,-0.17,0.04,-1.75,-0.77,0.5,0.91,1.09,0.18,-1.72,-1.15,1.01,-2.74,0.93,-2.15,-0.78,-1.06,2,-0.32,1.73,0,0.4,1.03,0.44,0.36,0.84,0.98,-0.45,-1.05,-1.5,1.15,1.02,-0.81,0.71,1.87,-0.25,0.63,-0.37,1.48,0.77,1.69,-1.32,0.86,-0.43,0.02,-0.06,-0.78,1.12,-1.01,-1.44,1.04,-0.66,0.26,-0.87,-1.7,0.65,0.33,0.52,-1.15,1.37,1.9,0.33,-1.12,2,0.63,1.26,-1.11,0.12,0.8,0.7,-0.09,0.6,-2.08,0.31,1.17,0.94,-1.65,-0.1,-0.08,-0.14,1.07,-0.21,0.99,-1.2,1.27,-0.39,-1.04,-0.16,-0.25,-0.04,-1.59,-0.24,0.45,0.12,1.62,1.27,-0.57,-0.63,0.66,0.68,0.63,-0.15,0.46,-1.13,0.57,-0.69,0.88,-1.24,-0.51,0.49,0.04,0.78,0.34,-0.45,0.66,-0.28,-0.51,0.53,-0.74,-0.09,1.54,-1.05,-0.6,-1.78,0.09,-0.74,0.1,-0.55,-0.85,0.2,-0.61,-1.18,-0.39,0.75,-1.36,0.88,1.46,-1.43,-1.28,-0.09,-1.05,-0.14,0.84,-1.17,-0.39,1.41,0.59,0.02,-0.86,-0.24,0.35,0.96,-1.97,0.89,2.46,-1.32,0.15,1.3,0.59,0.18,1.12,-2.01,-0.09,0.43,-0.85,0.47,-0.07,1.74,-1.17,-0.22,0.88,0.07,-0.04,-0.82,-1.24,0.53,0.33,-0.77,-1.35,-0.25,-0.45,-1.77,1.17,0,-1.31,-0.54,0.4,1.02,-1.39,1.25,0.84,-0.26,0.61,-0.77,0.29,-0.42,0.47,-0.5,-0.9,0.62,-1.12,0.06,0.08,-0.47,-1.33,-1.14,-0.95,-0.4,1.71,1.24,0.15,-1.16,-0.63,-0.09,-1.36,-0.24,1.91,-0.47,-0.82,1.2,-1.18,1.85,-0.47,0.81,-1.06,-0.04,0.31,-0.02,-0.64,0.98,0.92,-0.1,2.12,0.57,0.33,0.89,-0.78,-1.74,-1.29,1.19,0.62,0.25,0.79,0.94,1.86,-0.68,-0.37,0.39,-1.43,-0.99,-0.74,1.79,0.41,-1.43,-0.97,1.01,1.67,0.68,-0.39,0.94,0.93,-1.59,-0.74,-1,-0.03,-1.86,0.76,1.16,0.46,-0.38,-1.1,-0.58,0.93,0.96,2.85,-0.37,-0.54,-0.6,-0.97,0.95,-0.48,2.12,-0.84,0.38,-0.82,-1.84,0.11,-0.6,1.22,0.83,-0.13,-1.07,-0.65,-1.08,0.44,0.67,0.95,0.85,0.07,1.03,-1.4,0.01,0.98,1.59,-0.54,1.39,0.14,0.3,0.4,-0.68,-1.37,-1.36,-0.04,0.08,-0.31,-0.43,-0.15,-2.34,-1.16,0.89,-0.12,-0.55,0.25,0.32,0.47,0.07,0.64,0.52,-0.9,-1.63,-0.31,0.35,-0.8,0.76,0.04,-0.13,1.28,-0.18,-0.74,1.68,-0.57,0.91,-1.04,-1.98,1.42,-0.23,-0.69,-1.08,0.18,1.87,1.8,-1.01,-0.39,0.16,0.62,-1.71,0.68,-0.03,2.35,0.11,-0.6,-0.48,0.87,-0.47,0.4,-2.43,2.26,0.32,-0.85,-0.4,1.22,0.49,-0.32,-0.07,-1.25,0.61,0.11,0.28,-0.6,-0.15,0.1,0.32,2.16,1.35,0.91,0.66,-0.28,-0.63,-1.15,0.76,-0.6,-0.86,0.46,-1.44,-1.08,0.15,-0.66,-0.67,0.3,-1.2,-0.58,0.65,-1.96,-1.28,1.4,0.24,0.33,-0.04,0.39,-0.02,0.1,0.9,-0.75,2.88,1.24,0.92,-0.03,-0.1,-0.78,1.06,-1.41,-0.17,-1.19,0.73,-0.89,-0.59,0.61,1.19,1.08,0.23,0.17,1.29,0.76,0.32,-0.94,-1.19,-0.43,-0.18,1.1,1.52,1.43,0.38,-1.76,1.36,-0.91,-0.44,-0.68,0.7,1.39,0.06,0.11,-0.23,-0.59,-0.64,-0.28,-0.08,3.27,-1.03,-0.86,-1.57,0.03,0.13,1.83,0.53,0.34,0.63,1.42,0.98,-1.43,1.57,0.43,0.32,-2.43,0.35,1.27,1.07,0.85,0.48,0.01,-0.8,-0.57,1.05,-0.6,0.55,0.03,0.17,0.22,-1.57,-2.01,0.84,-1.25,0.15,-1.6,2.42,-0.52,-0.38,1.64,-0.87,0.86,2.38,-1.64,1,-0.41,-0.4,-0.37,-1.17,-0.65,0.1,-1.28,0.87,2.23,-0.79,-0.21,-0.18,1.23,-0.27,0.61,-1.01,-0.43,0.24,1.19,0.4,-1.27,-1.55,-0.88,-0.32,0.31,-1.81,-0.05,-1.71,-0.05,0.24,-1.59,0.42,-1.51,-0.71,-1.18,0.85,-0.65,-0.22,1.77,-0.11,0.71,-1.42,0.07,0.3,1.35,-1.4,0.83,2.13,0.99,-0.35,0.08,0.39,-0.91,0.14,-0.08,0.6,-0.15,0.76,-0.09,0.02,0.13,-0.11,-0.08,-0.78,1.61,-0.26,0.86,0.32,-0.4,-0.93,-0.28,0.48,-0.95,0.97,-1.21,1.69,-0.52,0.39,-2.09,-0.32,-2.07,-2.86,0.41,-0.05,0.52,0.06,-2.71,0.63,2.24,0.69,-0.21,0.16,-0.35,1,0.84,1.11,-0.87,0.68,-0.21,0.58,-1.57,0.55,0.09,1.18,-0.84,0.1,0.33,-0.28,1.59,-1.08,0.61,0.84,-0.11,0.86,-0.39,-0.25,-1.42,-0.43,2.14,0.27,0.17,0.1,0.79,0.54,0.44,-0.97,-1.83,-1.58,-1.19,-0.85,1.15,1.88,-1.33,-0.01,-0.78,1.32,-0.76,1,-0.89,-0.47,-0.92,-0.33,-0.98,-0.09,-0.53,-0.85,-1.34,0.56,-0.59,0.22,0.07,0.8,-2.06,-1.38,2.13,-1.6,1.96,-0.67,-0.74,-0,0.69,-0.65,0.72,-0.68,-0.67,-0.08,-0.6,0.1,0.51,0.85,0.69,-1.08,0.25,1.09,-0.27,0.78,-2.41,0.27,0.02,1.13,-0.08,-0.36,2.4,0.39,0.91,2.95,-0.51,0.19,0.86,1.65,-0.69,-0.9,0.46,1.37,-0.45,-1.51,-0.27,-0.92,0.08,-1.2,-2.53,-0.27,0.17,-0.2,1.03,-0.73,0.1,0.81,-0.45,-1.21,0.62,-1.13,1.96,0.51,0.27,0.22,-1.06,0.13,-0.42,0.23,0.65,1.07,0.03,0.79,1.12,-0.86,0.82,1.7,1.66,-0.04,-1.31,2.53,-1.14,-0.71,0.33,-0.56,-0.32,0.53,0.09,-0.87,-2.01,-1.62,1.02,0.29,-0.43,-0.12,0.7,-0.37,0.6,1.07,-1.31,-1.79,0.65,0.7,-0.72,1.75,0.31,-0.64,0.65,-1.26,-0.19,0.53,0.29,1.85,-0.88,0.82,0.7,-0.42,-0.02,1.63,2.06,-0.14,1.03,-0.67,1.18,-1.94,-0.22,0.86,1.16,1.33,0.02,-0.21,1.01,-1.71,0.89,-1.2,-1.44,0.33,0.01,0.51,-1.25,0.99,-1.73,1.01,-0.23,-0.89,-0.67,-0.62,0.52,0.23,-0.49,-2.1,1.33,-0.3,1.66,0.5,0.1,-0.24,-0.59,-1.51,0.22,-0.24,-0.77,-0.29,-0.67,0.06,-1.9,0.93,-2.87,-0.57,-1.09,-0.2,-0.33,1.96,1.05,-0.05,0.4,0.2,-0.13,-1.33,1.35,-0.29,-0.64,-0.59,-1.13,1.94,-1.59,-2.64,-0.88,0.52,1.03,0.53,-0.55,-1.02,-0.28,2,0.85,-1.31,-0.83,-0.34,1.41,0.52,-0.6,1.36,-0.5,0.3,-0.83,-0.44,-1.15,-1.67,0.14,-0.45,-1.34,0.05,1.3,0.64,-0.08,0.8,-0.28,0.47,0.61,-0.74,-1.95,-0.67,-0.93,-2.31,-0.39,-1.71,-0.71,-0.06,-0.71,-0.88,-0.88,-0.04,-1.25,0.13,1.39,-1.49,0.47,-0.64,1.07,-0.5,-1.54,0.25,-0.38,1.61,0.78,-1.59,-2.8,-0.61,-2.21,0.72,-0.49,0.78,0.67,0.31,-1.28,0.26,0.09,-0.36,-1.55,0.34,1.05,0.14,0.71,0.06,-0.16,-1.15,1.88,-0.55,0.41,1.25,-1.74,0.87,-0.01,-0.05,-0.54,-0.14,0.57,-0.42,0.33,-1.01,-0.05,-0.26,0.17,0.46,-0.68,0.99,-0.74,1.13,0.8,-0.81,1.15,-0.51,2.48,1.64,-0.03,-0.48,1.44,1.07,0.59,-1.75,1.2,-0.21,-0.36,0.93,0.69,0.32,0.22,-0.49,-0.03,-1.03,-0.06,-0.09,-0.06,0.03,-0.28,-1.27,0.8,1.43,-0.39,-0.43,-0.1,-0.62,-0.68,1.4,-1.12,-0.51,1.39,0.3,-0.16,1.15,1.37,-0.73,-0.86,0.04,0.58,0.66,-0.77,1.53,-0.01,0.44,-0.44,0.59,-1.42,-1.84,0.33,0.89,0.1,-0.23,-0.17,2.07,2.27,1.31,-0.93,-0.84,0.42,-0.09,-1.76,0.08,2.39,1.3,-0.42,-0.23,-1.15,-0.79,0.18,0.81,-1.36,0.89,-0.32,-0.95,0.88,-1.48,-0.15,2.47,-1.16,0.67,0.42,0.68,1.05,-1.43,0.58,-0.69,-0.27,-0.06,0.23,0.62,-1.67,-0.21,1.21,0.16,-0.02,-0.83,-1.12,1.9,0.19,1.71,-2.61,-1.08,0.08,0.02,0.62,0.31,-0.79,0.18,-0.36,-1.12,0.87,-0.91,-1.26,-1.49,-0.1,0.13,-1.47,0.48,-1.42,1.27,0.06,-0.43,0.47,-1.66,0.3,-0.04,1.02,-1.38,0.37,1.11,-1.14,-0.61,1.13,-1.21,0.12,-1.38,0.16,-0.84,-0.6,0.42,-2.17,-0.42,0.83,-0.46,1,-0.53,-1.43,0.28,-0.65,0.75,-0.49,-1.23,-1.08,1.35,0.72,0.16,-0.17,-0.66,0.23,1.36,1.21,-0.01,1.49,0.75,-0.27,-0.11,1.63,-0.84,1.08,-0.58,0.55,-2.29,1.59,-1.78,-1.7,-0.55,-0.23,0.19,0.22,1.07,-1.61,-0.07,0.35,-0.46,-0.47,2.56,-3.25,2.33,1.07,-0.35,-0.19,-1.61,0.71,0.11,-0.08,-0.98,-0.46,0.56,0.42,1.43,-0.84,0.72,0.42,1.2,0.04,1,0.53,1.03,-0.21,0.44,-0.65,-0.78,-0.61,-2.35,1.04,-0.31,0.95,-1.96,-0.53,-1.32,-1.64,0.96,-0.38,-1.61,0.09,0.15,-0.12,0.03,-1.81,0.66,0.89,-0.01,1.5,-0.15,0.73,-2.5,-0.8,-0.19,-0.08,0.18,-0.03,3.14,0.64,-0.76,0.76,-0.67,2.28,-0.47,0.68,-1.66,1.29,1,0.68,-2.48,0.02,0.4,0.69,0,-0.87,0.87,1.41,-0.8,-0.57,1.87,-0.84,0.39,-1.76,-0.55,-0.4,0.25,0.05,0.92,-0.8,-0.79,1.54,0.95,-0,-0.15,0.48,0.75,-0.09,0.87,0.42,1.93,-0.42,0.64,1.15,0.22,-0.22,-2.46,0.07,0.04,0.97,2.27,1.25,-0.55,-1.13,0.31,0.04,0.57,-0.93,-0.22,0.32,-0.2,-0.79,-1.08,-0.03,-2.41,-1.62,0.09,-0.07,0.42,0.63,-0.06,-0.1,0.13,-0.68,1.67,-0.55,-0.95,-0.47,0.41,-0.89,-1.13,-0.04,-0.09,-1.05,-1.17,0.09,0.43,1.7,-2.02,0.5,0.2,-0.38,1.06,1.65,0.35,1.06,-1.55,-0.36,-1.16,1.4,-0.19,-0.71,0.16,-0.73,2.25,1.22,-1.37,1.73,0.04,1.3,0.33,0.32,1.38,0.65,-0.24,0.06,0.83,-0.55,0.41,-0.12,0.9,-0.12,2.1,-0.82,-0.81,-0.03,0.26,0.37,-0.92,1.41,0.39,0.23,0.65,0.43,0.76,-0.2,-0.14,-1.1,-1.54,1.33,-0.19,-0.21,-0.81,0.86,0.43,0.41,1.31,0.62,0.48,-1.61,-0.36,1.47,0.18,1.2,1.04,-0.72,0.66,-1.64,-0.53,-1.52,-0.06,-1.69,0.43,-0.22,-0.68,-0.02,-0.8,-0.51,0.46,0.66,-0.2,-0.07,2.63,-0.26,-0.51,1.46,-0.49,3.02,-0.52,1.75,-0.55,-0.59,1.39,-0.53,0.7,0.21,0.67,1.1,-0.57,-0.55,1.51,1.75,0.47,-1.28,0.61,1.79,-0.54,-0.3,0.31,0.67,0.28,1.79,-1.81,0.26,-0.75,-0.63,0.09,0.78,-0.13,-1.36,0.67,0.59,0.12,-0.72,0.36,1.71,0.12,-0.12,0.26,0.17,-1.39,0.96,-0.95,0.58,-0.22,-2.3,-0.53,0.48,0.32,-0.37,0.07,-0.2,-1.07,-0.48,0.4,-0.43,0.33,0.82,-0.15,-0.31,-0.55,2.22,1.05,0.44,0.35,0.69,-0.84,-0.35,-0.31,-0.27,0.26,0.13,0.96,0.42,1.18,-0.48,-0.77,1.21,-0.68,-0.87,0.32,-0.22,0.91,1.25,0.65,0.54,1.19,-0.63,1.03,0.38,-0.77,-0.12,-1.16,0.48,0.18,0.89,0.51,-1.77,-2.15,-0.39,0.83,0.71,1.83,-0.16,0.03,1.49,-0.43,-1.17,-1.3,-1.6,-0.4,0.93,0.31,-1.11,-0.82,0.58,-0.05,0.11,-1.21,-0.85,0.21,0.6,-0.24,-0.02,-0.97,0.69,0.12,-1.23,0.08,0.81,-1.11,1.77,0.32,-0.23,0.27,0.19,0.61,-0.36,1.27,0.92,0.16,0.46,1.16,1.63,-0.53,1.41,0.12,1.35,0.14,0.09,1.2,1.77,0.36,-2.11,1.2,-0.63,1.23,-0.82,-0.72,0.92,-1.1,0.03,-0.79,-0.9,-0.38,0.8,0.57,2.11,-0.69,-0.88,0.04,1.26,0.68,1.19,-1.43,1.21,-1.2,1.21,1.01,-0.26,0.13,0.26,1.11,-0.88,-0.51,0.69,0.81,-0.74,-0.53,1.5,-0.49,-1.05,0.7,0.21,0.94,1.28,1.59,-0.76,2.25,-0.74,0.27,0.55,-0.55,0.18,1.17,-0.62,0.24,-0.23,-0.39,1.63,0.07,-1.59,0.24,-0.16,-1.34,-1.4,-1.11,-0.04,-0.93,-1.81,0.45,1.32,-0.27,-0.03,-1.6,0.12,0.39,2.33,1.47,-0.08,-0.14,0.52,-0.61,0.84,0.64,0.41,1.18,0.13,1.41,0.53,1.29,-0,0.59,0.12,0.2,1.45,-0.67,-0.51,-0.15,2.29,-0.09,0.5,0.98,-0.51,1.32,-0.62,-0.69,1.08,-0.76,-1.06,-0.23,-0.09,1.14,0.81,0.4,-0.63,-2.19,0.03,-0.02,-0.23,2.21,1.02,0.55,-1.12,-1.4,0.39,-0.2,-1.97,1.18,0.75,-0.93,0.15,-1.06,1.09,1.09,0.5,-0.32,-0.86,-0.21,0.5,1.22,1.66,-1.51,-0.51,1.61,-0.32,-0.06,-1.38,0.49,0.67,0.99,1.03,-1.66,-0.82,-0.34,-0.53,-0.09,1.38,-0.02,0.25,0.66,-0.1,0.64,0.52,0.04,0.86,-0.33,-0.79,1.19,1.54,1.26,-2.66,-0.15,0.61,-0.68,-0.19,-0.18,-1.08,0.66,-0.11,-0.75,0.42,0.65,-0.05,0.51,-1.11,-0.36,1.33,1.14,2.77,-0.61,1.48,0.69,1.05,0.89,1.14,-0.49,-0.43,-1.42,0.19,-1.18,-0.86,0.16,0.12,0.13,0.97,0.47,0.41,-0.99,-0.52,-0.59,1.68,1.09,0.12,0.22,-0.48,-1.91,-1.01,-0.41,-0.05,0.89,-1.19,-0.37,2.36,0.93,-0.04,-0.34,-1.1,0.69,1.23,0.79,0.27,0.26,-0.43,1.06,-1.14,0.98,0.39,-0.14,0.69,-0.7,1.51,-0.49,0.63,1.1,0.69,-0.69,1.41,1.52,0.12,1.06,0.21,0.37,-0.06,-0.86,1.74,0.84,-0.71,0.11,1.49,0.86,0.91,-0.08,-0.94,0.12,0.49,0.42,-0.17,0.65,0.58,-0.4,0.01,2.78,-0.59,1.05,0.08,1.83,-0.61,0.56,-0.39,0.89,-0.21,1.67,2.03,-0.93,-0.09,0.02,-0.79,-0.75,-1.43,1.76,-0.17,-1.17,-0.44,-1.81,-0.93,0.35,-1.96,0.38,0.91,-0.2,0.43,0.4,1.34,1.6,0.18,1.3,0.16,-0.18,1.68,1.61,-1.12,0.37,0.94,-0.12,-0.44,0.77,-0.42,1.25,0.84,-0.94,-1.53,0.94,2.06,0.66,-0.05,0.03,-1.86,-0.42,-0.02,-0.03,0.52,-0.02,2,-1.91,0.52,-0.41,2.27,-1.68,0.82,0.65,-1.17,-0.63,1.69,-0.18,-0.68,0.98,0.05,-0.03,-1.02,-0.91,1.21,0.6,-0.66,-0.55,-0.83,-0.14,-2.02,0.6,0.3,-0.19,-0.62,-0.5,-1.35,-1.91,-0.5,0.1,2.48,-0.44,-1.28,0.26,0.73,0.61,-0.15,-0.51,-0.05,-1.11,2.43,0.31,-0.27,0.8,1.19,-1.4,-1.2,1.61,-0.35,0.93,-0.01,-0.87,1.06,-0.25,1.15,1.12,2.78,-0.44,-0.3,0.77,1.16,-0.84,-0.18,-1.36,0.64,0.22,-0.27,0.86,2.08,2.23,0.35,0.77,0.14,1.01,1.19,1.36,1.52,-0.19,1.05,0.9,-0.59,-2.15,0.54,0.27,0.1,-0.67,-1.11,-0.88,-0.78,0.38,1.07,-0.13,-0.72,2.45,-1.46,1.26,-0.08,-0.1,-2.04,0.71,0.25,-0.07,0.18,-0.86,1.71,-0.49,-2.19,-0.5,1.16,-0.59,0.98,0.1,0.97,-0.47,0.29,-1.54,-0.87,-0.22,0.5,-0.67,-0,-0.15,-0.27,0.67,0.3,1.95,-0.23,1.32,0.65,-0.56,1.42,1.65,0.9,0.76,-0.71,-0.91,0.36,0.18,-1.35,0.35,-0.14,0.7,0.1,-1.28,-0.79,0.04,-0.39,0.35,-0.34,-1.23,1.13,1.34,-0.57,2.06,-0.16,2.17,0.14,-1.24,-1.73,1.27,0.25,-0.56,-0.62,0.55,-1.58,-0.56,-0.64,-1.09,1.42,0.8,0.48,1.05,-0.2,-1.29,0.24,-0.96,-1,-0.15,-1.45,1.13,-0.9,0.73,-0.78,-1.8,-1.13,-0.54,-0.51,1.22,-0.53,-1.22,-0.95,-0.22,1.02,1.01,-1.39,-1.3,-0.7,-0.29,0.74,0.3,1.28,-1.19,0.39,1.35,-1.13,-0.42,-0.13,-0.1,0.45,1.06,-0.53,-0.23,0.72,-0.78,-0.88,-0.66,0.83,0.57,0.09,0.37,0.84,0.13,2.66,0.38,-0.82,-0.25,-1.62,-0.35,-0.61,-0.09,1.31,1.13,-1.21,0.34,0.14,-1.12,-1.57,0.63,-1.19,-0.68,2.04,-0.49,-1.47,-0.62,-1.43,-0.14,0.74,0.49,0.03,2.28,-1.17,1.84,0.46,-0.12,0.56,1.66,1,-0.76,0.74,-1.21,-1.43,0.27,0.18,1.74,-0.11,0.62,-1.06,-0.61,-0.95,-0.11,0.06,-1.25,-0.03,0.79,-1.39,0.71,-0.87,0.07,-0.67,1.01,0.06,0.14,-1.2,-1.37,1.07,0.12,-0.1,0.55,1.71,-0.65,-0.64,0.91,0.38,0.12,0.15,-0.65,-0.73,0.82,-1.64,0.3,-0.1,-1.89,0.01,1.31,0.21,-0.46,-0.71,-0.13,-1.01,0.55,0.36,-0.64,0.54,0.36,-0.41,-0.27,0.42,-0.6,-0.64,-0.57,-0.43,0.11,-0.24,-0.24,-0.1,0.53,-0.18,-0.16,-0.56,1.38,0.67,1.14,0.09,0.31,1.77,-1.03,-0.71,-1.1,0.29,0.18,1.75,-1.37,1.15,0.66,0.01,0.04,-0.24,3.06,-0.7,1.84,1.26,1.02,0.58,-0.5,-0.96,0.65,-1.64,-0.44,0.94,0.49,-0.87,-0.24,1.43,0.79,-0.2,0.07,-2.31,0.34,-2.04,0.67,-0.74,-0.56,1.29,-1,-0.37,1.91,-1.36,-1.13,-0.05,0.78,-0.39,-0.38,0.81,-0.54,0.52,0.06,-0.38,-0.06,-0.75,-0.72,1.14,-0.2,-0.15,-1.18,0.21,-0.61,-0.13,-0.93,0.27,-0.72,0.02,-0.07,0.62,0.9,1.67,0.68,0.55,-0.86,-0.04,0.55,0.68,1.55,0.65,0.84,0.88,-0.67,-0.63,-2.25,0.02,-0.69,-0.74,-0.43,-0.54,0.23,-1.67,0.63,-0.14,0.57,-2.43,0.28,-1.19,0.44,-0.78,-0.17,0.3,0.41,2.39,-1.17,-1.23,-0.41,-1.17,-0.52,1.7,0.44,-2.44,0.41,0.2,-0.28,-0.4,-0.61,0.85,-1.45,0.64,-1.79,-0.55,1.43,-0.96,0.04,-1.1,-0.79,-1,-0.17,-0.05,1.05,-0.13,0.39,-1.19,-1.08,1.59,0.21,0.38,-1.43,0.26,0.29,0.31,1.03,-0.54,1.33,0.03,-0.36,1.33,2.28,-1.25,0.29,-0.61,0.35,0.4,1.79,-0.54,0.84,0.57,2.03,-1.28,0.53,-1.32,-1.48,0.35,1.61,-1.01,0.61,-1.06,0.08,0.39,0.79,-1.96,-0.68,-1.72,-0.48,0.17,-1.66,0.66,-0.8,0.02,0.23,-1.1,-1.26,-0.53,0.06,-0.22,-0.26,-0.73,-1.78,1,0.77,1.54,-1.12,-0.75,-1.44,0.58,0.03,2.16,0.11,-0.19,-1.19,0.21,-0.95,0.79,-0.69,-1.98,-0.19,-0.36,-0.75,-0.17,0.7,-0.94,-0.22,-0.83,0.58,0.13,0.23,0.38,-0.9,-0.88,0.25,-1.57,0.15,0.38,0.54,-0.09,0.21,1.21,-0.83,-1.98,1.6,-0.47,-0.17,1.41,0.98,-0.23,2.51,-0.55,1.22,1.04,2.27,-0.73,0.95,-0.24,0.11,-1.44,-0.26,-0.23,1.78,0.14,-0.36,-0.29,1.79,-0.61,-0.17,0.67,-0.56,-0.96,-0.46,-0.01,-1.15,-1.41,0.92,-0.18,-2.06,1.52,0.84,-0.53,-1.16,1.59,0.41,0.07,-0.71,-0.49,0.78,-0.02,-1.44,-0.75,0.65,0.16,-0.56,-0.47,-1.27,-0.11,-0.44,1.52,0.47,-1.41,1.64,-0.63,-0.4,1.82,1.05,0.18,-0.67,-2.19,1.77,1.56,1.11,2.71,1.35,1.95,0.24,-1.41,0.02,1.35,0.03,0.24,0.23,0.39,-0.56,-0.84,0.48,-0.01,1.05,-0.32,-0.22,-0.73,-0.82,0.17,1.18,0.08,0.93,-0.39,-0.82,-0.85,-2.21,0.23,-0.94,-0.44,-1.83,-0.37,0.73,0.73,-1.28,0.1,0.72,-1.33,-1.04,-0.02,-0.23,1.48,2.53,-0.88,-1.49,-1.04,1.84,-0.31,-1.73,-0.67,2.97,-0.32,-0.36,1.21,-0.73,1.1,-0.05,0.33,0.66,0.78,1.21,-0.31,0.3,-1.43,-0.36,-0.05,0.27,1.75,0.3,-1.54,0.12,1.58,-0.39,-1.03,-1.03,0.56,-1.37,-0.03,-0.3,0.27,-0.65,-0.16,-0.99,0.22,0.9,-0.03,0.64,1.87,0.88,-2.14,1.68,-1.22,1.69,1.28,2.01,2.07,-1.53,0.87,0.49,-1.03,-0.12,0.22,0.46,-0.8,-0.04,0.77,-1.27,-0.9,0.31,1.69,0.31,-1.27,1,0.64,-0.04,-0.46,-1.1,1.56,-1.68,-0.15,0.9,0.42,-0.1,0.97,0.55,0.7,-1.7,-2.22,0.01,-0.48,-1.63,-0.83,0.41,0.48,0.8,0.81,-0.36,-1.39,0.49,1.81,0.86,-1.23,-0.05,-0.54,-1.1,0.36,-0.71,0.48,2.44,-0.83,2.08,-0.59,-0.4,-2.28,-0.23,-0.78,1.01,1.57,0.37,1.17,2.32,2.78,-0.35,-0.11,1.61,-0.99,0.42,1.8,-0.36,-0.49,0.3,-0.05,1.05,-2.4,0.41,0.28,0.08,0.81,-0.65,-0.62,1.78,-0.87,-0.66,-0.22,-0.5,-0.27,-2.47,1.75,0.9,-1.13,0.39,-0.13,-0.09,-0.73,-0.32,-1,0.85,0.08,2,0.4,-0.04,-1.09,-1.29,-1.22,-0.14,1.1,0.88,1.22,1.23,1.11,-0.13,-0.32,-0.67,2.35,0.72,-0.79,-0.15,-0.47,1,-0.38,0.66,0.78,-1.34,0.89,-0.04,0.82,-0.78,-1.27,-1.42,-0.52,0.02,0.96,0.67,-1.12,0.6,-2.3,-0.77,0.7,1.3,-0.73,1.35,1.15,-1.25,-1.96,0.03,0.35,0.27,1.51,1.65,-0.14,-0.3,-0.14,-0.76,-0.86,2.16,1.12,-0.02,1.23,0.93,0.65,0.87,0.8,-1.1,0.78,-1.44,1.44,0.54,-0.55,-1.34,0.65,-0.01,-0.87,-2.28,2.55,-0.76,0.77,0.34,-1.18,-2.16,-1.56,1.02,-1.38,-0.99,1.36,0.17,-0.07,-0.79,-1.55,0.56,0.12,0.2,0.34,0.92,1.02,0.53,-0.08,0.25,1.35,-0.19,0.27,0.13,-0.11,-0.97,-0.5,-0.54,-1.14,1.26,0.23,0.69,2.26,-0.43,-0.77,0.38,-0.2,1.8,0.06,-2.22,0.78,0.75,0.91,-1.48,-0.02,1.37,-0.52,-0.14,-1.38,0.41,1.68,1.02,-0.76,0.18,0.79,-0.95,1.66,0.22,0.88,-0.83,0.76,0.24,0.09,-2.45,-0.19,1.49,-0.95,-0.01,-0.03,-0.58,0.83,-0.32,0.16,0.48,0.82,-0.89,1.14,-0.45,-0.59,0.09,-0,-0.96,0.42,-0.68,-1.12,-1.37,-1.09,-0.45,-0.78,1.45,0.21,-0.94,0.17,1.03,0.51,-0.76,0.13,-2.57,3.04,0.8,-0.96,0.14,2.13,-1.75,0.69,-0.2,1.07,-1.53,-1.29,-0.86,0.39,1.46,0.09,1.71,-0.61,-2.17,0.09,-0.85,1.96,-1.06,-0.18,-0.62,0.04,0.86,-0.43,-0.34,-0.56,1.33,-0.52,0.12,1.2,-0.45,-1.15,0.46,-0.71,0.31,0.21,1.3,-0.62,1.34,0.35,-1.24,-1.42,0.68,0.2,1.75,0.64,0.63,0.35,1.07,0.04,0.85,0.71,-0.85,2,-0.17,-0.81,-1.28,-0.84],[-0.93,1.78,4.91,8.02,15.46,25.97,37.53,49.47,63.94,83.65,100.41,122.25,143.52,168.61,194.4,226.1,255.51,289.97,323.06,359.91,400.42,443.04,484.57,532.05,575.47,624.74,676.54,731.08,783.37,840.61,900.25,960.79,1024.67,1085.81,1155.02,1224.78,1297.4,1368.23,1444.08,1521.65,1600.57,1682.24,1765.3,1850.44,1936.84,2024.21,2115.84,2208.86,2302.62,2401.1,2499.37,2600.65,2704.97,2808.56,2916.85,3025.2,3135.48,3249.22,3363.49,3481.87,3598.13,3722.5,3844.34,3968.43,4095.2,4225.55,4357.53,4489.53,4625.52,4758.48,4900.15,5041.01,5185.89,5328.31,5474.91,5626.77,5775.09,5927.9,6083.26,6240.47,6398.46,6560.14,6723.59,6886.75,7057.73,7223.98,7395.3,7569.6,7741.82,7921.27,8101.39,8281.29,8462.45,8648.24,8836.35,9024.81,9215.94,9409,9603.96,9802.14,10001.14,0.91,1.05,4.17,8.83,16.51,26.63,35.33,52.56,63.56,82.44,99.32,120.21,143.86,168.41,195.65,226.47,254.94,288.91,324.41,359.84,398.29,442.98,483.74,526.89,576.09,622.73,678.72,729.19,784.29,839.8,900.75,963.31,1025.09,1088.11,1155.08,1224.21,1294.54,1368.55,1443.92,1520.31,1599.94,1679.62,1763.59,1847.81,1936.88,2024.39,2116.73,2208.99,2303.74,2401.71,2501.33,2602.82,2702.81,2809.29,2915.79,3025.24,3134.51,3249.91,3364.03,3480.64,3600.67,3722.38,3844.37,3968.98,4097.02,4225.75,4357.43,4489.51,4625.47,4760.66,4900.8,5040.3,5184.39,5328.55,5476.74,5624.47,5774.47,5929.85,6085.76,6242.08,6400.69,6558.9,6723.06,6889.2,7057.35,7225.29,7396.22,7567.29,7743.92,7921.04,8100.19,8281.54,8463.73,8649.8,8836.26,9025.5,9215.2,9406.97,9604.62,9800.33,9999.41,-0.74,3.78,5.34,10.37,15.42,24.18,36.38,48.81,64.39,81.61,99.7,121.43,145.45,168,197.4,224.78,255.83,290.95,323.39,362.54,398.97,440.33,483.54,529.5,576.08,623.64,677.24,730.66,784.32,841.71,898.57,960.25,1024.81,1088.63,1155.45,1225.48,1296.98,1367.2,1444.13,1519.2,1600.51,1680.49,1764.64,1849.13,1935.45,2025.43,2117.52,2209.14,2302.95,2402.24,2499.77,2602.1,2706.04,2808.2,2916.45,3025.99,3136.87,3249.28,3363.17,3481.11,3598.58,3720.43,3841.87,3967.35,4096.29,4224.67,4356.34,4487.82,4623.06,4761.8,4900.04,5040.71,5184.44,5328.14,5474.34,5624.47,5773.64,5928.88,6085.21,6241.01,6398.7,6561.06,6724.58,6889.98,7057.13,7224.54,7398.35,7569.75,7743.84,7922.82,8101.19,8280.27,8465.16,8647.4,8834.78,9024.01,9215.29,9409.84,9605.16,9799.82,10000.3,-0.62,-0.5,5.12,7.31,16.19,26.31,35.68,50.23,63.42,80.34,99.34,120.82,142.52,170.16,194.51,227.26,254.77,291.56,323.68,361.09,399.9,440.49,484.17,528.72,575.75,624.73,673.09,729.16,785.17,841.37,899.14,961.94,1024.53,1088.3,1154.92,1224.99,1294.44,1369.61,1444.52,1520.23,1600.5,1682.39,1762.98,1849.21,1934.92,2026.19,2115.96,2208.16,2303.44,2401.33,2502.06,2601.54,2703.55,2809.4,2917.31,3027.05,3136.19,3249.95,3363.86,3481.51,3601.25,3723.24,3844.9,3969.29,4094.72,4226.71,4355.42,4486.45,4624.13,4760.44,4899.92,5042.18,5184.14,5329.89,5478,5624.23,5776.17,5929.03,6085.18,6242.5,6400.52,6562.05,6724.38,6887.41,7057.25,7226.74,7394.13,7569.13,7743.82,7920.43,8100.41,8279.48,8464.69,8649.27,8836.3,9023.83,9215.38,9409.35,9603.52,9801.92,10001.14,-0.41,1.38,1.92,8.39,16.36,26.24,35.35,48.51,64.33,81.3,101.11,120.26,142.92,169.9,193.64,224.17,255.01,289.77,324.2,361.34,400.7,441.34,483.5,527.86,574.1,625.41,676.56,727.67,783.52,841.63,900.1,962.02,1025.16,1087.95,1156.37,1223.44,1294.82,1368.32,1444.61,1519.81,1599.77,1681.93,1763.72,1849.5,1935.26,2024.05,2114.59,2208.41,2303.34,2401.08,2500.51,2600.99,2703.92,2808.31,2917.35,3025.97,3134.7,3250.39,3362.75,3481.56,3598.62,3720.13,3845.11,3966.27,4097.11,4224.45,4355.71,4489.34,4624.75,4759.84,4901.29,5040.54,5183.02,5329.49,5475.01,5626.11,5776.52,5930.22,6082.72,6241.68,6398.54,6560.33,6723.81,6889.52,7056.54,7225.74,7396.64,7568.84,7745.39,7920.12,8099,8282.46,8464.6,8648.87,8834.99,9024.11,9217.09,9409.92,9603.82,9801.1,10000.54,-0.69,1.3,2.87,9.43,15.23,23.53,36.96,48.22,63.61,80.63,98.94,120.79,143.54,169.8,194.47,223.33,255.14,291.13,324.63,361.77,399.51,440.73,483.83,530.74,573.01,624.15,674.63,730.32,785.25,841.24,900.1,960.06,1024.7,1088.44,1155.35,1225.21,1295.91,1370,1444.33,1521.07,1599.15,1680.51,1764.83,1847.57,1936.87,2024.18,2116.27,2209.17,2304.84,2400.11,2500.69,2601.29,2703.95,2809.81,2916.44,3022.86,3137.35,3249.89,3363.54,3481.27,3600.78,3719.81,3843.72,3969.05,4093.88,4225.13,4354.83,4486.8,4622.33,4761.04,4901.75,5039.97,5183.47,5331.53,5474.42,5625.18,5773.98,5927.47,6085.06,6239.96,6400.96,6562.76,6723.68,6889.94,7056.65,7225.08,7395.03,7568.22,7744.71,7922.6,8098.46,8280.11,8463.18,8649.51,8836.05,9024.81,9217.94,9409.2,9603.67,9801.58,10000.52,1.71,0.37,3.1,8.69,15.12,25.17,35.18,50,64.57,82.58,99.39,119.77,145.73,167.24,196.04,226.33,257.02,290.51,324.46,361.26,399.19,440.13,483.33,528.47,576.56,625.61,674.92,729.11,785.86,843.93,900.24,960.24,1023.76,1088.45,1154.5,1226.06,1295.68,1367.78,1443.37,1520.1,1599.16,1681.76,1764.83,1849.16,1934.08,2023.68,2117.73,2209.27,2305.24,2399.29,2500.81,2601.8,2703.73,2810.13,2915.39,3024.55,3136.32,3249.2,3362.4,3483.05,3600.98,3720.94,3844.97,3968.97,4095.17,4224.59,4358.68,4489.59,4623.49,4761.62,4899.14,5041.89,5183.36,5326.5,5475.59,5623.84,5775.21,5931.91,6083.77,6241.56,6399.3,6560.57,6724.09,6888.29,7056.49,7226.42,7397.18,7567.53,7743.3,7920.81,8099.41,8280.12,8462.84,8649.08,8836.12,9026.1,9215.92,9407.73,9606.14,9800.95,10000.45,-1.39,1.35,3.33,9.17,16.28,26.4,36.39,48.13,63.99,81.41,100.98,120.1,143.82,168.79,195.98,225.5,256.58,289.2,323.97,360.3,401.47,441.07,483.89,529.38,576.76,625.43,674.5,729.34,782.9,843.23,900.11,962.28,1024.79,1088.67,1154.53,1225.47,1298.9,1367.6,1443.65,1522.5,1600.31,1682.1,1762.78,1848.55,1936.09,2026.79,2117.17,2208.54,2304.66,2400.06,2499.94,2601.6,2703.11,2808.28,2918.51,3024.99,3134.2,3248.95,3363.74,3480.66,3600.21,3720.43,3843.89,3969.38,4095.98,4224.41,4355.15,4488.81,4624.09,4761.46,4900.77,5040.26,5184.94,5328.65,5475.48,5624.93,5776.84,5928.09,6086.15,6242.81,6399.66,6561.3,6724.34,6888.87,7056.04,7224.6,7395.68,7569.62,7745.62,7920.92,8099.03,8281.5,8463.18,8650.15,8835.94,9025.88,9215.14,9408.5,9604.53,9801.31,9998.73,-1.15,0.42,2.12,8.33,15.13,25.17,36.53,47.59,63.35,80.79,100.42,120.44,145.29,167.86,195.96,225.56,254.93,288.24,324.33,360.19,399.02,440.5,484.07,530.45,576.58,624.9,676.66,728.24,783.89,840.73,900.51,961.7,1024.56,1087.93,1155.34,1226.17,1295.66,1366.3,1443.44,1519.53,1600.86,1680.82,1762.11,1849.69,1936.51,2023.12,2115.96,2206.15,2304.4,2401.02,2499.1,2602.91,2703.39,2808.9,2915.45,3024.25,3137.37,3247.29,3363.92,3481.84,3599.21,3721.86,3844.52,3968.93,4096.8,4225.58,4356.38,4489.11,4623.71,4758.99,4900.08,5040.04,5185.43,5327.1,5475.12,5625.08,5776.47,5927.71,6082.84,6240.98,6401.36,6561.32,6726.07,6891.36,7056.67,7224.2,7397,7568.86,7744.83,7920.81,8101.63,8279.75,8464.14,8647.43,8837.4,9025.86,9215.86,9410.9,9603.58,9801.39,10003.19,1.48,0.66,3.45,8.49,16.6,23.74,36.74,49.43,64.69,80.5,99.99,120.24,143.85,168.1,195.65,224.31,257.22,291.27,324.23,362.32,398.46,438.6,484.63,530.76,576.59,624.46,677.02,729.65,785.11,842.19,901.25,962.71,1023.16,1089.38,1156.28,1224.04,1294.75,1368.55,1443.19,1519.88,1600.73,1679.51,1763.24,1848.91,1937.38,2025.13,2116.05,2209.53,2303.97,2402.68,2500.22,2600.57,2703.29,2808.17,2916.43,3025.53,3135.92,3249.66,3364.09,3480.29,3598.44,3720,3843.83,3970.5,4096.59,4223.34,4357.04,4490.17,4624.53,4760.12,4898.86,5040.09,5181.87,5329.1,5476,5624.21,5775.21,5926.93,6084.61,6241.65,6398.43,6560.12,6722.7,6889.07,7055.42,7222.72,7397.08,7570.04,7744.05,7921.31,8100.45,8280.94,8465.67,8648.46,8836.28,9023.78,9216.7,9408.1,9604.12,9801.42,9999.85,-1.3,-0.0600000000000001,2.92,11.05,16.06,24.29,36.35,49.57,64.37,80.4,100.77,120.14,143.76,168.21,197.31,226.83,254.22,288.39,325.24,361.16,399.68,442.34,484.2,530.33,575.86,626.46,674.96,728.36,784.45,840.55,900.66,960.89,1023.59,1090.82,1156.11,1225.79,1297.83,1369.72,1443.34,1519.09,1599.12,1679.54,1763.99,1851.11,1934.74,2026.51,2116.67,2208.09,2304.43,2401.16,2497.89,2600.51,2704.32,2810.38,2917.36,3025.01,3134.84,3248.23,3362.98,3481.94,3600.73,3720.45,3843.18,3969.81,4095.41,4225.19,4357.4,4488.75,4623.48,4761.37,4899.98,5039.79,5183,5328.91,5477.16,5625.73,5776.77,5929.42,6084.35,6242,6398.11,6559.58,6722.95,6889.76,7056.19,7225.35,7396.68,7570.39,7745.13,7921.07,8099.25,8281.26,8464.83,8650.09,8835.04,9024.77,9216.69,9408.52,9603.5,9801.5,9999.17,1.7,0.57,1.75,9.68,15.22,24.73,36.89,48.62,62.97,79.69,100.24,120.75,145.2,170.63,195.15,226.46,257.23,290.63,324.39,360.68,399.51,440.84,484.04,529.09,577.37,624.12,674.89,729.07,782.06,840.78,900.35,961.12,1025.92,1088.63,1157.05,1224.16,1294.3,1370.01,1445.11,1519.39,1599.6,1680.33,1763.89,1848.15,1936.44,2025.4,2114.6,2207.9,2303.64,2400.98,2501.47,2601.55,2704.21,2810.27,2917.58,3025.14,3137.48,3247.83,3362.38,3479.38,3598.8,3721.09,3843.16,3968.06,4095.41,4225.83,4354.08,4489.98,4624.43,4760.29,4900.91,5041.34,5185.43,5328.01,5475.39,5624.74,5776.99,5928.86,6083.4,6242.49,6400.91,6559.06,6722.15,6888.26,7057.33,7224.94,7397.88,7568.58,7742.71,7921.12,8099.92,8281.44,8463.45,8649.58,8836.2,9025.26,9215.5,9410.26,9603.12,9800.82,10000.5,-0.21,2.06,3.53,9.23,14.45,25.71,36.25,49.13,63.98,80.76,100.08,119.91,145.54,167.99,196.27,225.16,257.68,288.21,323.24,361.23,400.15,439.55,483.7,527.87,576.57,625.54,675.96,729.27,783.69,839.28,901.91,961.12,1024.74,1088.1,1156.03,1224.35,1295.77,1368.57,1443.55,1520.87,1600.02,1683.16,1764.82,1849.69,1937.51,2025.13,2116.08,2207.15,2302.58,2400.28,2498,2602.05,2704.5,2809.55,2914.68,3025.51,3135.16,3248.21,3362.85,3480.72,3601.55,3721.2,3843.31,3969.46,4096.41,4226.58,4355.48,4487.07,4625.01,4760.96,4900.85,5040.9,5183.55,5329.36,5476.25,5624.79,5774.28,5927.77,6083.05,6241.7,6401.8,6561.56,6723.58,6887.87,7055.79,7225.22,7397.68,7569.52,7745.55,7921.65,8099.66,8280.25,8466.27,8647.76,8835.5,9024.37,9214.83,9408.54,9604.53,9801.3,10001.16,0.54,1.19,3.46,10.26,15.38,24.52,35.45,48.32,65.51,82.13,101.49,120.41,144.1,167.3,194.89,225.5,256.02,290.73,324.59,361.23,401.06,441.08,484.57,529.61,574.8,624.85,675.52,728.22,783.17,842.09,901.06,962.5,1023.93,1090.64,1157.58,1226.3,1295.78,1370.29,1444.51,1522.29,1600.28,1681.07,1762.31,1849.68,1936.58,2023.43,2119.32,2209.44,2305,2402.78,2500.4,2600.79,2702.41,2808.77,2915.91,3025.6,3137.18,3250.19,3363.2,3480.9,3599.26,3720.99,3844.91,3969.5,4096.48,4225.65,4356.79,4488.75,4624.92,4760.23,4899.31,5040.21,5182.37,5328.47,5475.58,5624.47,5771.94,5929.17,6083.76,6241.3,6399.9,6560.17,6724.14,6889.4,7055.46,7226.22,7395.56,7568.42,7743.9,7920.22,8100.2,8278.97,8465.97,8649.33,8835.64,9026.17,9218.1,9410.15,9603.25,9798.93,10000.25,0.12,1.4,4.09,9.03,16.86,24.97,33.85,48.29,63.8,81.73,101.68,122.29,142.53,169.07,196.25,224.65,255.27,289.03,325.45,361.14,399.78,442.67,484.95,529.08,577.64,624.94,675.29,727.95,783.88,840.32,898.89,959.99,1025.49,1090.4,1153.92,1226.25,1296.51,1370.28,1443.54,1521.46,1600.95,1680.05,1763.29,1847.67,1936.67,2026.02,2116.27,2207.61,2303.64,2399.78,2499.73,2601.01,2704.82,2809.09,2914.69,3026.15,3134.57,3249.77,3366.01,3482.2,3599.01,3720.98,3842.97,3969.11,4095.5,4225.43,4355.76,4490.57,4622.47,4761.99,4902.27,5042.18,5182.88,5327.94,5475.99,5626.61,5774.99,5928.39,6084.3,6241.61,6400.71,6560.7,6725.47,6888.91,7056.08,7225.04,7396.02,7568.69,7744.46,7922.61,8099.02,8282.03,8464.05,8649.07,8835.6,9026.34,9214.58,9410.06,9603.84,9800.87,9999.85,0.01,1.59,4.56,10.02,16.83,24.71,36.24,50,61.48,81,101.07,120.82,142.6,169.63,194.93,224.13,255.72,289.1,322.99,362.51,402.04,439.63,482.95,529.94,577.38,625.35,675.15,728.98,784.35,840.24,899.82,961.72,1025.18,1087.79,1156.35,1224.98,1296.05,1369.16,1443.5,1520.16,1600.24,1680.88,1765.86,1850.4,1935.92,2022.89,2114.12,2209.3,2303.02,2402.03,2500.01,2599.5,2703.51,2807.8,2915.57,3024.69,3136.99,3249.72,3362.53,3481.07,3599.05,3722.4,3843.56,3970.68,4095.11,4226.14,4354.65,4487.57,4622.77,4762.17,4899.85,5040.21,5183.64,5328.19,5476.17,5626.58,5774.98,5930.04,6084.87,6240.63,6399.86,6562.62,6722.62,6888.7,7056.81,7223.99,7397.52,7569.86,7744.27,7921.14,8099.9,8280.52,8463.59,8648.17,8838.1,9024.15,9214.85,9408.33,9604.51,9801.98,10000.71,-1.7,1.82,3.97,8.41,15.67,26.02,35.71,48.9,63.44,83.88,100.49,121.39,144.2,169.69,195.36,226.49,255.17,288.94,324,359.53,400.03,440.83,483.67,528.52,576.97,625.38,675.93,730.47,784.16,841.49,901.23,960.43,1024.15,1089.86,1154.66,1224.7,1295.93,1369.18,1444.35,1520.6,1598.78,1680.05,1764.43,1849.26,1935.76,2025.26,2117.37,2209.32,2301.93,2400.46,2501.5,2600.47,2705.58,2809.93,2916.1,3026.12,3135.32,3250.38,3363.26,3480.77,3600.37,3720.01,3844.82,3969.13,4095.27,4225.51,4357.02,4491.64,4625.54,4760.06,4900.3,5042.36,5184.49,5328.42,5475.84,5625.52,5777.91,5930.47,6083.43,6239.53,6399.59,6561.29,6723.2,6890.18,7055.44,7224.98,7397.49,7568.94,7743.37,7921.4,8100.44,8281.38,8462.87,8649.77,8837.94,9024.1,9215.59,9409.67,9605.88,9801.33,10000.9,0.12,0.71,4.02,9.99,16.51,23.34,35.93,51.11,61.92,83.58,100.96,120.49,142.78,168.61,194.79,226.6,256.47,289.13,324.66,361.74,399.54,440.23,482.64,527.07,576.34,626.55,674.85,726.76,784.01,841.49,899.06,962.96,1024,1090.08,1155.43,1222.72,1296.37,1370.14,1442.55,1519.07,1600.41,1679.65,1763.43,1850.86,1936.55,2024.53,2115.55,2209.35,2303.55,2399.71,2500.38,2598.89,2702.65,2807.87,2915.35,3023.4,3135.65,3249.42,3362.72,3480.88,3599.51,3720.66,3844.75,3969.19,4096.68,4224.66,4356.02,4488.75,4623,4763.5,4900.04,5039.14,5184.34,5328.93,5476.52,5627.2,5776.48,5929.02,6085.11,6239.19,6401.09,6560.86,6723.8,6888.89,7056.36,7225.54,7395.05,7570.44,7742.95,7919.15,8098,8281.16,8464.91,8650.92,8836.68,9027.15,9215.1,9409.1,9603.85,9801.99,9999.84,0.35,-0.05,3.16,6.66,17.02,24.71,35.43,49.88,64.87,80.42,99.64,119.6,145.32,168.16,196.35,225.32,257.63,287.64,324.8,361.49,398.38,441.37,482.89,528.05,574.87,625.98,676.88,729.88,784.61,840.17,900.06,960.81,1023.29,1088.61,1157.83,1224.2,1295.98,1370.35,1444.93,1521.27,1600.74,1679.62,1763.41,1849.28,1935.97,2024.53,2116.94,2209.56,2304.98,2402.76,2500.5,2602.53,2703.53,2808.17,2915.25,3024.19,3136.54,3248.68,3362.6,3481.88,3600.22,3721.28,3846.32,3970.29,4094.7,4224.83,4355.08,4488.81,4623.77,4762.69,4899.11,5042.38,5185.54,5326.98,5477.18,5627.25,5776.93,5928.57,6083.64,6241.57,6400.03,6561.33,6722.98,6887.66,7054.7,7224.93,7396.17,7569.25,7744.53,7918.19,8101.3,8281.08,8463.4,8649.34,8836.39,9027.11,9213.49,9408.21,9604.46,9802,9999.56,0.29,0.74,4.27,7.33,15.88,25.61,36.42,47.29,65.45,82.49,98.97,121.94,143.94,168.48,196.53,224.51,256.92,289.22,323.89,361.05,398.97,441.68,484.11,529.48,575.17,623.95,674.45,727.91,782.91,841.55,899.34,962.69,1021.85,1087.97,1156.28,1226.3,1296.77,1368.2,1442.74,1518.83,1599.95,1679.21,1762.84,1851.57,1935.59,2025.45,2117.13,2208.87,2305.64,2402.78,2498.35,2601.14,2704.69,2810.14,2916.81,3024.68,3136.23,3249.11,3364.28,3480.84,3598.34,3721.11,3844.96,3966.44,4095.84,4225.7,4356.74,4488.05,4624.25,4762.39,4898.96,5041.96,5182.9,5327.66,5475.84,5624.55,5775,5927.9,6084.92,6239.88,6398.23,6561.96,6723.89,6888.8,7057.5,7224.69,7396.66,7567.99,7744.74,7921.09,8100.01,8281.25,8463.89,8648.63,8835.45,9024.65,9213.69,9410.22,9604.86,9800.66,10000.27,-2.5,-0.71,3.57,7.81,16.37,24.16,36.24,49.71,65.07,81.44,99.8,119.73,143.93,169.89,195.4,223.84,255.83,287.67,323.2,360.03,401.08,439.82,482.94,528.4,578.22,625.29,677.02,729.22,782.95,840.13,900.27,962.64,1023.97,1090.18,1156.05,1225.91,1295.28,1368.33,1444.08,1521.07,1600.49,1683.81,1761.97,1849.05,1936.9,2024.37,2115.3,2207.83,2305.61,2399.77,2499.54,2601.16,2701.18,2807.45,2915.9,3022.17,3133.5,3247.49,3363.06,3481.62,3600.19,3720.68,3843.5,3968.26,4094.9,4224.81,4355.43,4489.63,4624.77,4760.07,4900.86,5040.95,5184.16,5327.88,5472.58,5621.6,5774.65,5929.65,6085.24,6242.62,6401.66,6560.46,6723.28,6889.34,7055.55,7224.73,7395.33,7571.33,7744.6,7922.56,8099.97,8280.18,8466.17,8649.46,8834.89,9024.43,9215.34,9409.79,9604.64,9799.57,9999.09,-0.57,-0.0800000000000001,4.76,9.33,15.42,25.75,35.33,49.56,62.98,80.61,99.88,120.98,143.32,169.36,195.25,225.36,256.54,289.24,322.92,360.45,401.09,440.64,483.43,527.81,575.08,626.01,674.65,729.77,785.23,841.16,900.05,961.16,1025.12,1088.84,1155.99,1228.41,1297.94,1368.99,1444.89,1522.22,1599.97,1681.88,1762.96,1850.17,1935.85,2023.75,2115.7,2207.99,2304.94,2401.67,2500.8,2600.16,2704.94,2809.26,2917.33,3025.58,3135.6,3249.94,3363.19,3480.08,3599.89,3720.45,3845.47,3971.8,4096.42,4225.05,4356.15,4489.7,4624.17,4759.75,4900.23,5041.72,5184.24,5328.92,5476.17,5623.35,5775.64,5930.05,6084.88,6240.73,6398.72,6561.35,6724.49,6889.02,7055.14,7223.27,7394.29,7568.35,7744.39,7921.08,8099.99,8281.88,8463.49,8647.34,8836.63,9024.51,9218.51,9408.05,9603.57,9799.18,10000.76,-1.17,0.22,4.08,8.33,17.23,23.04,37.08,47.89,61.98,81.18,101.46,122.02,144.69,169.97,195.11,226.55,255.37,288.49,323.26,361.72,401.26,441.97,483.41,528.29,577.21,625.45,677.99,727.3,783.55,841.99,898.18,960.55,1024.35,1089.15,1156.03,1225.84,1296.42,1370.09,1445.41,1519.66,1599.44,1678.39,1765.6,1849.45,1934.42,2024.7,2116.69,2208.37,2303.3,2399.93,2500.56,2600.56,2704.59,2809.47,2915.69,3024.4,3136.38,3249.31,3364.29,3479.64,3601.87,3720.7,3843.85,3969.62,4095.47,4225.78,4356.55,4488.31,4623.19,4759.08,4900.93,5038.69,5183.14,5329.2,5476.43,5626.07,5776.97,5930.91,6083.59,6241.01,6400.34,6561.66,6725.59,6889.72,7055.41,7225.96,7397.09,7569.83,7744.2,7920.99,8099.69,8281.97,8462.83,8648.12,8835.36,9024.98,9215.95,9408.43,9604.77,9801.72,10001.2,-0.91,2.55,4.58,9.75,16.96,25.32,35.76,49.56,63.23,80.41,98.25,120.14,144.52,168.35,196.03,224.15,257.94,290.52,323.17,360.48,398.69,440.49,485.42,528.85,574.81,624.8,675.22,729.54,784.11,839.32,900.98,960.41,1024.04,1087.6,1155.95,1224.81,1296.69,1369.43,1443.18,1520.96,1600.93,1681.55,1763.23,1848.76,1934.14,2025.27,2117.68,2209.54,2304.88,2399.45,2500.11,2601.88,2704.84,2808.49,2917.29,3026.13,3136.56,3246.99,3363.93,3481.33,3600.31,3721.03,3842.51,3968.63,4094.85,4225.78,4357.3,4490.18,4624.18,4760.81,4900.52,5040.84,5185.58,5328.48,5476.84,5624.62,5775.96,5928.1,6086,6240.97,6401.37,6562.09,6725.26,6889.21,7055.55,7224.87,7394.78,7568.66,7743.04,7921.05,8098.8,8279.83,8462.96,8647,8835.59,9024.7,9216.77,9409.1,9603.34,9801.27,9999.2,0.36,1.12,3.49,6.64,16.4,24.86,36.36,49.11,63.27,83.07,99.8,122.42,145.74,169.15,196.99,225.87,257.32,289.99,323.51,360.54,400.33,441.15,484.64,530.75,574,624.69,677.22,727.38,783.12,840.17,899.04,960.79,1022.64,1088.49,1157.67,1225.94,1295.23,1369.56,1442.96,1521.11,1599.3,1681.58,1764.5,1850.69,1935.66,2024.83,2116.93,2209.12,2305.36,2399.1,2500.02,2600.52,2703.12,2809.03,2916.24,3025.08,3137.28,3249.97,3363.74,3481.3,3599.22,3721.63,3846.28,3968.48,4097.56,4224.94,4356.08,4489.38,4623.08,4762.01,4899.29,5041.13,5184.1,5327.98,5474.96,5624.74,5775.13,5927.44,6083.39,6239.8,6399.79,6559.29,6724.56,6888.14,7055.02,7223.92,7394.77,7568.87,7743.43,7921.63,8102.52,8281.51,8463.35,8648.87,8836.22,9024.99,9217.01,9408.83,9602.63,9800.34,10002.56,1.49,1.91,2.9,9.31,15.81,25.26,34.73,49.51,64.28,81.88,102.09,121.79,141.96,167.49,195.45,225.75,255.41,288.5,323.43,360.79,402.5,442.65,485.13,530.08,577.17,624.83,678.35,729.23,784.02,840.81,900.78,961.5,1022.76,1089.29,1155.91,1225.27,1295.2,1368.12,1444.32,1519.49,1600.5,1680.67,1764.7,1848.33,1937.13,2025.05,2115.7,2208.7,2304.65,2402.39,2498.41,2601.51,2702.07,2808.34,2916.21,3025.27,3135.83,3248.56,3363.66,3481.4,3600.92,3720.61,3843.87,3968.69,4097.34,4225.61,4356.23,4488.54,4622.7,4760.36,4899.05,5042.02,5184.22,5330.08,5475.54,5625.31,5775.5,5927.7,6083.32,6241.94,6399.36,6561.07,6724.97,6890.07,7056.13,7226.38,7395.18,7570.33,7744.25,7920.58,8101.31,8282.78,8465.1,8647.93,8835.72,9024.91,9216.06,9407.4,9605.82,9801.97,10001.62,1.46,-1.14,3.85,9.51,14.52,25.75,33.78,49.19,63.66,81.2,99.61,119.73,145.44,168.83,195.71,225.84,255.53,287.9,324.08,359.44,399.05,439.58,483.27,528.81,576.78,623.92,675.53,728.07,783.43,841.13,898.67,961.25,1024.06,1089.6,1154.58,1223.81,1295.75,1370.22,1444.92,1520.65,1599.98,1681.62,1764.78,1849.34,1935.22,2025.77,2115.99,2208.44,2303.75,2399.32,2500.14,2600.74,2704.09,2808.82,2915.63,3024.62,3135.94,3249.15,3362.59,3483.3,3600.41,3719.45,3842.1,3970.29,4095.06,4224.75,4356.92,4489.39,4624.04,4761.55,4900.14,5041.7,5182.12,5329.79,5476.63,5627.13,5775.92,5928.87,6082.34,6240.71,6402.02,6560.45,6723.11,6889.23,7055.29,7225.91,7395.25,7568.37,7744.12,7921.3,8099.38,8280.95,8464.42,8648.86,8835.09,9023.69,9216.49,9411.11,9602.82,9800.19,9999.69,1.32,1.35,4.64,8.27,16.03,24.29,36.35,48.24,63.89,80.22,99.78,120.44,146.04,169.12,193.47,226.34,255.18,289.23,323.18,359.73,399.26,441.68,483.63,530.21,576.8,626.24,675.43,729.19,782.81,842.26,900.66,962.27,1023,1088.9,1157.06,1226.47,1296.93,1369.69,1445.18,1520.77,1598.43,1680.02,1762.88,1847.74,1936.4,2024.38,2117.34,2209.36,2302.14,2399.62,2498.33,2601.37,2703.35,2809.16,2914.9,3025.4,3137.23,3250.19,3364.46,3481.89,3600.09,3720.39,3843.8,3969.7,4094.8,4223.89,4356.81,4490.35,4624.54,4762.09,4898.65,5041.4,5183.49,5328.26,5474.54,5623.35,5776.42,5927.89,6083.52,6241.85,6400.07,6559.37,6721.94,6889.25,7058.21,7226.39,7395.53,7570.57,7745.83,7923.21,8099.85,8282.86,8464.34,8646.65,8835.19,9023.94,9216.2,9408.55,9603.52,9800.37,10000.67,-0.67,0.27,3.99,8.73,16.4,25.7,36.75,50.92,62.75,80.38,101.02,120.93,144.47,168.18,195.38,226.3,254.77,288.66,323.94,360.31,399.99,442.26,483.04,527.7,578.72,625.89,676.58,731.83,785.48,840.33,899.92,961.17,1023.55,1090.58,1155.82,1225.31,1296.22,1368.24,1445.4,1522.77,1600.67,1681.74,1762.51,1849.11,1936.68,2024.08,2116.6,2210.41,2303.55,2400.49,2499.72,2600.74,2705.1,2809.99,2916.58,3023.98,3135.91,3248.61,3364.89,3481.07,3601.11,3720.82,3844.69,3968.75,4093.56,4225.45,4357.48,4488.76,4624.57,4759.76,4899.68,5040.99,5183.56,5330.67,5475.59,5623.59,5778.52,5928.65,6084.59,6240.92,6399.19,6561.14,6723.07,6887.24,7055.75,7225.18,7396.38,7569.16,7745.34,7921.78,8098.46,8280.81,8463.12,8648.73,8836.07,9026.42,9218.54,9408.71,9603.08,9802.42,9997.81,0.12,0.38,4.66,7.7,15.71,25.61,36.2,48.16,63.31,79.83,101.34,121.64,143.61,170.11,194.69,225.45,255.08,288.67,324.75,360.34,401.84,442.75,484.09,528.57,576.14,624.4,676.28,729.65,784.04,840.99,899.05,960.73,1025.19,1086.11,1155.73,1223.33,1294.63,1369.26,1443.68,1520.95,1599.32,1679.94,1764.34,1848.02,1935.5,2025.21,2117.59,2208.91,2303.4,2399.62,2500.49,2600.08,2702.81,2808.38,2917.09,3027.66,3134.51,3249.91,3364.72,3479.86,3600.46,3720.55,3844.39,3968.64,4096.37,4225.93,4355.3,4488.11,4622.39,4761.72,4898.66,5038.83,5185.21,5329.49,5475.4,5625.08,5777.84,5929.13,6084.38,6241.83,6399.43,6560.35,6724.9,6890.07,7055.3,7226.69,7396.24,7569.51,7743.64,7921.3,8099.47,8280.36,8464.38,8649.24,8835.98,9025.73,9215.55,9408.74,9605.07,9800.44,10000.25,1.02,-0.27,3.53,9.34,15.09,24.29,34.76,49,63.25,80.7,98.77,122.64,144.25,170.99,196.24,226.32,255.01,289.12,324.82,360.95,400.84,440.71,483.88,529.98,575.78,626.67,676.47,728.84,784.67,840.6,901.53,961.42,1023.38,1088.49,1155.05,1223.36,1295.98,1369.56,1444.52,1521.8,1598.76,1680.59,1763.4,1849.64,1937.07,2026.14,2115.71,2209.75,2304.41,2401.04,2499.7,2600.86,2705.36,2809.3,2916.71,3025.39,3135.61,3248.01,3364.69,3480.31,3600.5,3721.24,3843.35,3968.59,4097.01,4225.2,4357.64,4489.06,4625.52,4762.56,4898.93,5041.02,5184.35,5327.42,5474.58,5622.63,5775.35,5929.75,6084.38,6239.99,6399.51,6562.19,6724.37,6887.86,7055.78,7225.05,7397.78,7568.63,7743.33,7921.17,8098.89,8281.9,8462.96,8648.4,8835.61,9025.79,9216,9409.11,9601.98,9801.15,10000.91,0.52,-0.28,2.38,9.04,17.67,25.86,36.12,48.58,62.89,80.66,99.59,119.95,143.86,169,195.21,223.49,254.97,288.69,323.21,362.63,400.86,440.37,484.24,527.6,576.72,624.97,675.55,727.19,784.62,841.89,899.59,962.06,1024.02,1087.96,1157.49,1225.86,1294.92,1367.61,1445.46,1520.6,1599.74,1680.66,1764.86,1848.99,1935.95,2024.38,2114.87,2208.51,2303.89,2402.3,2500.36,2598.65,2703.75,2809.8,2914.86,3026.01,3135.29,3249.07,3363.98,3481.1,3598.08,3720.75,3842.07,3970.54,4095.48,4226.07,4357.24,4487.6,4624.47,4760.77,4900.14,5041.06,5182.14,5326.33,5476.87,5623.58,5775.76,5928.44,6082.96,6239.29,6400.57,6560.01,6723.31,6888.94,7056.28,7223.12,7394.56,7568.93,7744.28,7921.09,8098.69,8280.9,8463.18,8648.84,8836.01,9025.88,9215.01,9407.37,9605.06,9800.68,9999.46,-0.18,1.95,2.23,10.07,15.23,24.7,35.96,47.76,66.19,83.08,99.06,121.56,143.61,168.43,197.03,224.95,256.39,287.82,324.36,362.61,400.32,441.49,484.61,528.44,574.98,627.18,675.37,727.35,784.56,841.84,900.52,960.71,1024.3,1088.33,1154.93,1226.62,1297.31,1369.22,1444.15,1521.43,1600.24,1680.3,1763.47,1848.51,1936.86,2023.97,2116.17,2208.36,2306.68,2401.26,2501.08,2599.68,2704.1,2809.03,2915.57,3026.38,3136.77,3250.67,3363.73,3480.37,3601.04,3721.29,3843.28,3967.59,4096.19,4225.31,4355.11,4489.48,4623.48,4763.02,4898.78,5039.93,5185.3,5329.17,5476.83,5626.9,5775.5,5929.33,6083.76,6242.12,6400.76,6558.26,6723.73,6889.49,7056.79,7225.22,7397.91,7570.95,7744.3,7920.79,8099.02,8280.84,8464.46,8649.54,8835.57,9025.04,9216.18,9409.21,9604.76,9802.13,9998.71,0.62,1.98,3.83,10.6,15.25,23.45,36.7,47.46,63.51,79.89,100.24,121.99,143.75,170.95,196.46,224.23,256.08,288.14,324.38,360.7,399.06,442.95,485.18,530.08,576.9,624.86,675.67,729.54,784.75,841.6,899.56,963.01,1023.69,1089.17,1156.42,1223.89,1295.17,1367.61,1443.77,1521.21,1598.87,1681.43,1761.1,1848.4,1936.1,2025.43,2116.66,2209.4,2302.29,2400.16,2501.52,2602.37,2704.06,2808,2917.06,3024.1,3134.87,3248.54,3362.26,3480.09,3597.86,3719.34,3844.68,3968.19,4096.38,4225.24,4356.04,4489.86,4624.13,4761.01,4901.07,5039.49,5183.8,5329.96,5476.73,5625.85,5773.31,5930.8,6084.84,6240.75,6400.53,6560.41,6723.21,6886.36,7056.54,7225.48,7395.46,7567.8,7745.6,7920.95,8098.93,8279.45,8465.04,8649.15,8836.95,9026.54,9215.7,9408.66,9603.07,9801.63,10000.01,-0.85,0.87,4.18,8.31,15.53,26.19,34.97,50.2,65.17,81.62,100.15,120.46,145.08,168.39,195.59,224.65,258.07,290.45,322.63,360.4,398.16,440.8,484.45,527.35,578.07,623.89,675.14,729.48,783.24,841.85,901.93,961.3,1023.99,1087.74,1154.07,1225.57,1297.18,1367.79,1444.7,1520.61,1601.16,1678.99,1765,1850.53,1935.32,2025.41,2115.94,2208.22,2304.63,2400.24,2499.57,2600.08,2704.47,2809.63,2916.53,3025.05,3137.09,3249.28,3363.23,3481,3598.93,3722.45,3844.51,3970.53,4097.81,4225.31,4352.94,4488.77,4624.92,4759.91,4900.68,5041.19,5184.22,5330.89,5475.77,5625.68,5776.07,5928.2,6084.31,6241.44,6401.04,6561.56,6721.37,6890.41,7057.23,7226.49,7396.73,7570.24,7744.24,7921.03,8099.21,8281.03,8463.1,8648.95,8836.19,9024.6,9216.75,9410.2,9606.07,9801.86,10001.65,0.73,0,2.94,9.16,17.25,22.9,36.35,48.17,65.76,80.5,101.14,120.42,144.65,170.76,196.15,225.26,255.47,289.31,324.04,361.04,399.05,439.65,484.66,530.12,574.56,625.85,676.36,730.54,787.02,841.25,900.18,961.49,1023.5,1089.26,1156.09,1224.15,1295.69,1369.21,1441.4,1520.11,1599.92,1682.67,1763.34,1849.72,1936.38,2024.02,2116.34,2209.25,2304.61,2400.98,2500.47,2601.34,2701.76,2808.54,2917.57,3024.1,3136.57,3250.44,3364.74,3479.8,3601.13,3721.06,3842.03,3968.21,4095.5,4224.29,4355.53,4488.51,4625.26,4761.65,4899.86,5042.36,5182.83,5327.1,5476.59,5627.4,5776.19,5928.93,6083.95,6239.92,6399.17,6559.44,6723.55,6887.61,7056.21,7225.13,7396.22,7569.11,7745.09,7919.81,8100.51,8279.17,8465.73,8649.31,8836.18,9024.67,9216.87,9410.36,9604.22,9801.86,10001.37,-0.96,0.69,5.64,9.05,17.69,24.21,35.04,48.47,64.35,82.43,99.63,121.45,144.56,168.85,196.28,224.42,255.99,288.43,324.33,358.84,400.64,440.1,485.85,529.66,574.61,625.29,674.74,729.76,783.95,840.4,899.82,961.38,1023.79,1087.69,1156.14,1226.7,1295.46,1370.08,1442.54,1520.14,1598.71,1681.76,1764.89,1848.85,1933.08,2025.98,2118.81,2210.55,2304.62,2401.47,2499.79,2601.43,2704.63,2809.12,2915.92,3024.72,3136.08,3248.31,3366.2,3480.15,3600.73,3721.91,3843.56,3968.03,4095.41,4223.92,4354.36,4489,4625.12,4759.84,4899.71,5041.77,5186.19,5328.57,5476.39,5624.04,5778.71,5927.56,6080.97,6241.46,6400.04,6561.82,6723.73,6889.32,7056.87,7224.76,7397.13,7569.06,7743.84,7921.98,8099.21,8280.53,8461.44,8649.53,8836.54,9023.94,9216.32,9409.06,9603.57,9801.14,10001.06,-0.39,2.4,2.09,10.3,15.01,26.47,36.27,48.33,62.93,81.62,100.06,121.43,142.64,170.06,196.4,225.37,256.11,289.99,322.62,361.39,399.47,442.41,483.16,527.56,575.64,626.35,675.62,729.4,784.01,840.34,900.36,961.43,1024.62,1089.41,1156.2,1225.82,1295.35,1368.37,1443.09,1519.05,1599.97,1681.24,1764.46,1850.22,1935.59,2024.44,2117.7,2209.6,2305.63,2401.9,2501.05,2599.59,2703.15,2809.64,2915.98,3024.28,3136.04,3248.08,3363.31,3480.1,3600.23,3721.26,3843.31,3967.73,4095.55,4226.14,4355.75,4488.1,4623.98,4759.26,4900.73,5041.75,5183.62,5330.52,5476.19,5626.04,5775.56,5928.85,6084.67,6242.66,6398.66,6561.82,6723.97,6887.76,7056.39,7224.86,7395.68,7568.23,7745.87,7920.84,8101.15,8280.52,8462.94,8649.22,8835.54,9023.38,9214.86,9410.44,9602.52,9801.36,10001.09,-0.01,2.75,4,9.33,14.44,23.97,35.86,49.32,64.56,80.24,100.83,122.77,144.65,167.91,195.3,225.25,254.8,289.96,324.51,362.04,400.11,441.96,484.3,529.37,575.47,625.75,676.27,728.61,783.71,843.28,900.4,960.67,1023.28,1088.12,1154.68,1225.59,1294.79,1368.72,1444.35,1521.29,1599.14,1681.04,1766.32,1848.58,1936.64,2025.76,2116.97,2208.89,2304.29,2400.92,2501.72,2600.25,2702.89,2808.93,2915.82,3025.71,3136.12,3250.54,3364.29,3481.61,3600.73,3721.67,3843.69,3969.17,4097.46,4224.35,4354.56,4488.52,4623.83,4761.14,4900.71,5041.54,5185.38,5328.94,5477.3,5626.93,5775.26,5931.44,6084.63,6239.23,6399.75,6562.18,6724.18,6887.2,7055.03,7223.89,7396.47,7568.93,7743.46,7922.35,8101.01,8280.29,8463.41,8650.93,8836.31,9025.64,9215.13,9409.12,9604.44,9801.28,9999.06,0.34,0.64,5.41,10.06,16.44,25.82,36.13,50.36,64.67,79.58,100.19,121.03,145.41,169.34,196.98,224.27,255.6,288.08,323.29,360.7,401.1,441.24,484.23,529.88,574.73,627.11,675.29,728.66,784.67,841.11,900.38,959.3,1024.85,1087.92,1156.2,1224.95,1295.72,1369.03,1441.88,1522.28,1602.29,1680.43,1763.89,1849.41,1936.71,2024.45,2115.26,2209.92,2303.29,2400.92,2502.01,2600.22,2704.37,2809.67,2918.03,3023.33,3134.09,3248.9,3362.44,3480.09,3601.25,3719.96,3844.51,3970.08,4096.58,4223.01,4356.75,4489.23,4623.25,4761.97,4900.75,5041.25,5185.68,5329.18,5473.55,5624.54,5775.61,5929.16,6083.59,6241.19,6403.11,6563.29,6724.27,6890.75,7056.16,7224.73,7396.16,7568.11,7743.86,7920.12,8100.37,8281.6,8464.6,8647.82,8836.11,9024.14,9216.15,9410,9603.81,9799.78,9998.61,0.14,1.5,1.96,9.98,15.67,24.24,35.75,48.3,65.51,80.64,101.53,119.46,144.89,168.36,195.45,225.55,256.77,289.94,324.15,360.4,400.52,437.7,484.04,529.68,577.56,623.78,676.02,729.9,783.78,840.55,900.85,959.77,1022.75,1088.7,1155.44,1223.45,1297.76,1369.26,1445.19,1522.4,1601.3,1683.08,1764.13,1847.96,1935.5,2026.17,2115.75,2210.54,2303.87,2399.73,2499.85,2600.52,2704.64,2808.44,2916.26,3023.22,3136.68,3249.11,3364.17,3481.74,3598.48,3722.41,3843.28,3968.6,4095.85,4225.84,4356.92,4490.37,4624.6,4761.79,4900.92,5039.05,5184.53,5329.94,5475.98,5624.77,5777.16,5930.61,6084.39,6240.87,6399.76,6561.96,6724.63,6889.55,7055.62,7224.34,7396.02,7568.81,7743.5,7921.21,8098.36,8282.99,8462.95,8648.93,8836.17,9024.78,9215.19,9407.64,9604.12,9800.29,9999.69,0.39,1.75,5.04,9.18,15.37,25.29,35.85,48.33,64.71,81.38,100.24,121.59,143.2,167.49,195.7,224.39,255.39,288.37,322.54,360.95,398.89,438.36,484.83,530.33,577.17,625.52,676.16,728.49,784.76,842.17,899.53,960.2,1024.26,1088.59,1155.37,1224.71,1296.28,1368.45,1442.96,1520.95,1600.84,1680.82,1765.07,1848.46,1933.41,2024.06,2114.49,2208.81,2304.87,2401.11,2499.87,2599.48,2704.5,2809.09,2914.05,3023.62,3133.9,3248.27,3363.99,3481.65,3600.01,3721.8,3843.53,3968.32,4095.8,4222.74,4356.96,4490.43,4623.53,4762.13,4897.56,5040.93,5184.29,5328.59,5474.9,5625.91,5777.21,5929.8,6084.23,6240.75,6400.47,6560.29,6722.76,6888.97,7053.51,7225.71,7396.5,7567.61,7742.91,7923.31,8098.56,8280.27,8463.35,8649.08,8834.97,9024.59,9214.72,9409.88,9604.77,9803.47,10000.05,1.68,3.49,4.73,7.94,15.54,24.65,35.32,50.43,63.93,79.86,98.42,122.45,143.37,168.08,197.28,227.27,256.48,288.56,323.23,360.76,399.81,441.73,484.07,529.83,575.82,625.51,675.14,728.56,785.25,842.41,901.88,962.14,1024.14,1088.13,1155.96,1227.42,1295.89,1369.11,1443.63,1519.39,1598.62,1682.89,1763.02,1848.31,1937.62,2024.75,2115.14,2210.12,2303.78,2399.55,2500.45,2601.77,2704.11,2809.13,2917.73,3025.87,3135.58,3249.46,3364.86,3481.58,3598.98,3721.06,3844.66,3968.58,4096.91,4225.06,4354.95,4489.27,4624.39,4761.19,4901.6,5039.26,5183.68,5328.52,5474.66,5625.71,5776.56,5928.3,6085.33,6241.21,6399.25,6559.85,6723.68,6889.89,7055.93,7224.95,7396.47,7567.46,7744.86,7919.82,8100.33,8281.73,8463.64,8648.7,8834.79,9025.73,9215.61,9408.57,9603.77,9800.64,10001.08,0.76,1.55,3.79,9.39,17.09,26.26,35.38,50.09,62.65,81.05,99.7,121.02,144.75,169.02,195.34,224.77,256.12,288.93,322.85,361.95,399.82,438.74,484.09,529.21,575.69,624.88,676.93,727.83,785.49,839.16,902.88,961.16,1023.85,1088.59,1156.79,1225.19,1294.49,1367.87,1444.87,1522.73,1599.75,1680.36,1763.38,1848.45,1937.21,2023.8,2117.1,2208.44,2303.4,2400.93,2499.8,2600.64,2705.56,2809.94,2915.07,3027.1,3135.03,3249.05,3365.2,3480.25,3599.94,3719.14,3843.14,3968.28,4095.02,4225.61,4354.15,4490.2,4622.79,4761.28,4900.97,5039.39,5183.86,5328.63,5476.74,5624.81,5775.49,5929.51,6083.6,6241.56,6398.8,6560.15,6722.72,6888.72,7055.27,7224.88,7397.26,7570.08,7744.39,7920.3,8100.56,8282.1,8465.83,8650.03,8834.04,9024.55,9215.74,9407.81,9604.02,9800.47,10001.57,0.31,0.76,4.27,9.82,16.56,24.95,37.34,50.59,63.22,79.74,100.51,119.63,143.16,168.77,197.41,225.03,255.45,288.45,324.48,360.22,398.38,441.73,484.41,529.26,573.91,625.81,676.21,728.88,782.61,838.68,900.54,961.28,1024.47,1088.08,1155.25,1225.28,1296.13,1367.18,1445.96,1520.16,1600.05,1680.67,1764.74,1848.63,1934.7,2025.39,2117.09,2210.19,2303.54,2401.8,2501.04,2601.72,2703.11,2809.65,2914.36,3023.97,3137.28,3250.88,3365.23,3480.41,3601.51,3723.19,3844.31,3969.31,4095.24,4224.71,4356.46,4487.74,4623.12,4760.54,4898.94,5040.55,5183.92,5328.15,5474.98,5624.17,5775.17,5928.31,6083.06,6241.08,6399.13,6561.14,6723.48,6889.18,7055.46,7224.65,7395.92,7569.82,7743.72,7920.62,8101.21,8281.38,8462.85,8648.64,8834.11,9026.8,9216.49,9408.1,9604.74,9800.06,10000.17,0.35,-0.67,5.02,8.5,14.59,24.79,35.89,47.17,63.08,81.05,100.83,121.31,142.47,166.88,196.96,225.4,257.18,288.43,325.03,360.85,401.65,440.85,482.15,528.57,574.84,625.91,674.25,728.6,783.02,840.91,899.35,960.42,1025.74,1088.91,1156.61,1226.71,1295.9,1367.96,1444.7,1522.1,1600.12,1682.07,1763.45,1848.04,1936.29,2024.67,2115.38,2208.92,2304.45,2400.19,2501.36,2598.48,2702.57,2810.36,2916.21,3023.8,3136.51,3248.83,3364.26,3479.93,3601.31,3718.94,3843.47,3969.19,4095.36,4224.34,4356.95,4490.06,4622.62,4761.1,4900.2,5039.98,5184.49,5327.65,5474.64,5625.2,5776.56,5927.23,6085.18,6242.61,6400.5,6560.99,6724.85,6887.85,7054.05,7225.27,7393.98,7567.73,7744.2,7921.98,8102.58,8281.1,8464.02,8646.75,8835.04,9024.74,9213.96,9408.51,9604,9799.77,10000.71,0.18,0.69,4.89,8.76,15.71,24.5,36.13,49.84,64.77,79.79,99.48,120.9,143.35,167.41,194.6,223.73,257.14,289.51,323.06,359.98,399.6,441.79,485.4,528.98,575.97,623.94,677.4,728.95,781.77,843.08,899.87,961.18,1024.16,1087.36,1156.44,1225.84,1297.76,1369.32,1444.6,1518.68,1599.31,1683.08,1763.99,1849.62,1935.82,2024.38,2115.53,2208.09,2303.47,2401.91,2499.28,2599.95,2704.5,2808.89,2916.65,3024.99,3135.65,3250.49,3363.36,3479.88,3599.46,3721.74,3843.36,3969.21,4097,4225.76,4355.02,4489.85,4624.18,4762.57,4901.59,5041.05,5183.66,5328.91,5476.29,5624.13,5775.89,5928.83,6084.03,6240.62,6399.77,6560.73,6724.41,6888.82,7054.14,7224.17,7395.31,7568.74,7741.67,7921.11,8099.35,8281.27,8462.31,8649.2,8836.75,9024.97,9216.65,9407.36,9604.48,9799.72,9999.35,-0.73,2.25,2.7,8.27,17.5,23.03,37.13,50.39,62.66,82.38,98.7,121.37,146.7,169.61,194.37,225.13,257.26,290.16,325.41,361.46,400.18,440.86,485.04,527.02,576.92,626.58,676.28,729.02,783.67,840.75,900.94,959.71,1025.13,1089.13,1156.89,1225.72,1293.56,1369.26,1444.73,1520.68,1600.91,1680.92,1764.13,1847.99,1933.5,2024.57,2115.95,2209.35,2303.5,2399.24,2500.49,2601.35,2703.28,2809.47,2918.06,3024.87,3137.09,3249.36,3365.64,3479.1,3599.73,3720.81,3843.77,3970.12,4095.77,4226,4356.49,4488.71,4623.77,4760.26,4900.18,5039.54,5184.11,5327.76,5476.21,5624.42,5776.82,5929.51,6085.09,6243.5,6399.27,6559.54,6724.93,6891.03,7054.65,7225.84,7396.01,7569.89,7743.62,7921.12,8101.97,8280.91,8464.98,8649.1,8836.21,9024.69,9216.14,9411.35,9603.49,9801.46,10000.29,0.72,1.05,2.94,9.52,16.41,26.17,36.57,49.96,64.87,80.67,101.14,121.6,143.44,170.51,195.69,226,255.87,288.26,325.45,361.06,400.21,440.83,483.68,529.67,577.41,624.41,675.12,727.6,782.98,839.61,900.33,959.32,1023.95,1089.8,1156.23,1225.82,1297.69,1368.5,1442.35,1520.67,1599.96,1682.49,1765.03,1848.17,1937.23,2024.73,2117.67,2210.7,2304.6,2401.94,2499.75,2602.65,2703.28,2809.27,2914.99,3024.65,3138.48,3250.43,3363.25,3481.34,3599.7,3722.21,3841.99,3967.74,4095.74,4224.7,4353.74,4489.32,4625.35,4760.56,4899.96,5042.37,5183.59,5328.83,5475.86,5625.15,5776.56,5928.51,6085.62,6241.44,6400.77,6561.4,6725.21,6888.73,7056.78,7223.81,7396.99,7568.43,7745.02,7920.54,8100.7,8281.22,8463.8,8649.22,8837.22,9024.32,9215.67,9409.48,9603.91,9800.04,10000.57,1.63,1.36,3.55,9.48,16.46,24.39,36.38,50.55,62.83,81.86,99.77,121.86,144.43,168.26,195.95,225.83,253.7,289.48,322.38,359.66,400.62,440.85,483.73,529.19,576.41,625.78,677.14,727.88,784.06,841.86,900.99,962.08,1024.95,1088.55,1155.57,1225.58,1296.64,1367.41,1444.4,1518.68,1601.78,1681.9,1764.42,1850.05,1935.04,2024.78,2116.27,2207.97,2303.09,2400.95,2500.42,2599.54,2704.46,2807.6,2915.31,3024.47,3134.16,3249.65,3363.25,3482.14,3601.59,3719.63,3842.67,3966.91,4094.62,4224.66,4354.26,4488.95,4623.16,4760.3,4898.02,5041.56,5185.19,5329.53,5476.31,5625.01,5775.53,5929.62,6085,6239.51,6399.73,6560.99,6723.58,6888.9,7055.35,7225.69,7396.37,7566.79,7743.85,7921.96,8100.32,8283.81,8462.68,8649.94,8834.87,9024.28,9214.77,9408.62,9604.75,9801.75,10000.76,0.06,2.21,5.42,9.75,14.84,24.89,36.31,49.69,64.38,81.04,100.56,121.4,144.3,167.8,195.64,225.43,256.12,289.64,323.59,359.27,400.55,441.43,481.53,528.37,576.57,626.75,677.09,730.46,783.32,841.67,899.75,961.19,1024.75,1088.64,1155.48,1224.06,1297.51,1366.52,1444.57,1520.65,1600.38,1681.83,1764.87,1846.94,1936.12,2024.6,2115.03,2210.01,2304.06,2401.22,2499.9,2600.83,2704.1,2810.5,2915.58,3023.99,3136.28,3248.6,3363.95,3481.22,3599.34,3720.52,3844.16,3967.18,4096.76,4224.92,4356,4488.09,4622.1,4761.08,4900.78,5041.47,5184.14,5329.98,5475.93,5624.02,5778.5,5928.26,6082.26,6239.77,6399.44,6560.2,6724.53,6887.89,7055.37,7226.36,7394.98,7568.85,7744.43,7920.13,8099,8279.12,8461.94,8649.98,8834.2,9024.5,9217.11,9407.87,9602.71,9800.27,9999.99,-2.36,2.42,3.77,7.29,15.91,26.59,36,48.27,63.27,81.36,101.28,122.52,144.69,170.41,195.22,225.35,254.84,288.08,323.96,360.83,399.28,440.34,483.58,529.57,575.45,625.67,677.5,728.92,784.98,842.08,900.65,963.24,1022.25,1088.86,1155.69,1226.85,1296.06,1370.15,1444.07,1521.59,1600.25,1679.62,1763.71,1847.74,1938.37,2026.75,2113.94,2208.21,2303.21,2402.48,2499.7,2599.74,2702.78,2808.5,2919.18,3025.18,3134.92,3249.34,3363.32,3482.84,3599.03,3722.79,3842.98,3968.31,4096.63,4224.43,4356.91,4488.07,4622.58,4761.27,4898.4,5041.72,5182.01,5326.04,5476.47,5626.02,5774.88,5929.68,6084.8,6241.16,6399.83,6563.05,6722.85,6889.44,7054.11,7223.69,7397.02,7570.26,7743.94,7920.87,8097.51,8280.42,8463.92,8650.12,8835.48,9025.79,9216.61,9410.47,9604.84,9799.34,10001.76,-0.69,0.8,3.68,8.83,14.35,25.83,37.72,49.74,64.01,82.29,99.67,119.57,145.92,168.43,197.46,224.37,257.57,288.12,323.02,361.75,400.18,440.92,482.68,530.2,576.22,623.83,676.81,728.48,784.19,840.44,901.08,961.65,1024.02,1089.79,1157.01,1226.01,1296.08,1368.49,1444.37,1520.23,1600.39,1681.17,1764.97,1849.1,1936.76,2024.8,2117.43,2209.35,2303.62,2400.75,2500.89,2601.82,2704.49,2809.36,2914.74,3024.14,3135.81,3247.7,3364.27,3482.17,3599.07,3722.33,3844.36,3968.63,4095.6,4225.91,4356.11,4488.68,4622.63,4759.79,4900.3,5040.66,5183.23,5328.42,5476.51,5624.3,5775.72,5929.5,6083.65,6241.31,6399.84,6560.1,6725.17,6888.18,7054.94,7224.56,7398.4,7566.1,7744.62,7920.63,8100.94,8281.6,8463.99,8648.81,8837,9023.82,9216.4,9408.83,9604,9801.28,9998.97,-0.85,-0.04,3.08,10.32,15.77,24.8,34.98,49.02,64,82.5,100.67,120.18,146,168.8,196.44,225.78,254.94,287.28,323.56,359.68,402.56,441.21,482.45,528.55,576.49,625.61,677.02,729.5,783.33,838.94,900.63,962.28,1023.84,1088.88,1156.17,1227.35,1295.56,1369.28,1443.37,1520.97,1600.26,1679.48,1764.88,1851.03,1937.1,2025.29,2117.5,2208.74,2302.99,2400.17,2499.76,2601.67,2704.13,2808.12,2917.19,3026.67,3135.17,3249.34,3364.11,3481.04,3598.65,3720.95,3842.52,3968.25,4096.27,4223.69,4356.46,4488.19,4625.16,4759.07,4900.01,5041.01,5184.64,5328.03,5475.82,5623.84,5774.82,5928.94,6084.65,6240.46,6398.71,6560.26,6723.65,6890.45,7055.56,7225.07,7395.75,7567.76,7743.66,7921.39,8099.27,8277.92,8463.69,8649.1,8834.48,9024.8,9217.69,9408.82,9604.6,9799.54,9999.74,-0.12,-0.5,4.74,10.43,17.69,25.64,36.66,49.21,63.55,81.4,98.53,120.89,145.28,171.26,194.62,223.9,255.91,289.98,324.74,360.68,400.38,441.86,483.65,527.06,575.2,624.39,675.13,728.79,785.27,841.39,901.73,960.86,1023.08,1089.53,1155.28,1225.12,1296.21,1368.66,1443.78,1520.4,1599.34,1680.05,1762.37,1848.94,1935.58,2025.99,2116.64,2209.7,2303.04,2399.76,2499,2602.01,2703.23,2809.09,2914.69,3025.98,3135.19,3250.69,3362.65,3480.19,3599.71,3720.76,3844.72,3970.31,4096.09,4224.79,4355.46,4489.3,4623.32,4760.55,4901.09,5040.98,5183.41,5329.2,5475.41,5624.39,5775.06,5929.83,6083.17,6240.2,6399.5,6559.83,6723.54,6888.41,7056.23,7225.99,7395.16,7569.92,7745.37,7920.49,8098.11,8280.52,8464.28,8649.65,8837.38,9026.55,9214.76,9407.16,9604.86,9801.43,10000.63,-0.24,0.15,3.05,8.24,14.79,25.46,38.16,49.1,64.73,80.81,100.24,120.74,144.2,171.12,195.7,223.04,255.37,288.36,324.92,361.39,400.4,439.99,482.32,528.7,577.85,623.29,676.29,729.15,784.86,840.05,901.25,960.15,1024.29,1088.88,1156.04,1224.84,1295.32,1367.78,1445.03,1519.41,1598.21,1680.54,1763.63,1849,1935.49,2024.27,2114.25,2208.33,2303.53,2401.39,2499.48,2602.87,2704.17,2810.64,2916.8,3026.89,3135.12,3249.77,3364.45,3481.23,3599.16,3720.55,3842.35,3969.14,4095.88,4223.62,4355.94,4488.59,4622.89,4759.81,4899.31,5040.29,5184.45,5328.47,5476.96,5623.56,5776.85,5928.91,6083.79,6240.8,6399.69,6560.64,6724.07,6888.35,7056.11,7224.29,7396.35,7569.29,7741.4,7920.41,8100.84,8280.66,8464.13,8648.37,8836.99,9024.73,9216.84,9409,9603.56,9801.78,9998.55,-0.2,1.56,4.19,8.94,17.79,23.9,35.57,51.25,63.44,80.88,97.92,122.64,143.96,168.91,196.91,224.38,256.55,289.2,323.96,360.3,400.02,441.22,483.45,527.77,577.69,626.51,675.76,728.02,784.69,840.7,899.37,960.15,1021.88,1089.29,1155.54,1224.22,1295.96,1368.97,1443.06,1522.33,1599.28,1681.25,1763.89,1849.05,1934.74,2024.16,2116.93,2208.67,2303.05,2400.95,2497.37,2602.01,2705.23,2808.16,2916.83,3025.59,3133.76,3249.77,3364.05,3481.42,3599.9,3721.69,3842.16,3970.26,4096.49,4224.41,4356.49,4489.82,4624.45,4760.99,4899.66,5040.74,5183.06,5328.91,5476.1,5624.68,5777.07,5931.05,6085.38,6240.76,6400.71,6562.18,6723.62,6889.5,7058.58,7226.41,7397.21,7568.63,7744.41,7921.62,8099.56,8281.92,8465.09,8650.43,8836.38,9025.18,9217.72,9408.56,9601.62,9801.38,9998.11,1.08,1.04,5.02,7.66,16.16,23.36,36.83,47.85,65.86,83.09,100.48,120.38,145.82,165.95,195.36,224.74,255.3,290,324.57,360.57,400.74,442.56,485.52,528.24,576.21,623.66,676.69,728.54,783.98,840.63,899.49,959.54,1023.71,1088.7,1156.35,1226.79,1296.19,1367.24,1444.19,1521.58,1601.64,1678.8,1766.1,1849.42,1936.16,2023.76,2117.18,2209.7,2305.38,2401.51,2501.34,2600.17,2705.95,2810.86,2917.21,3025.22,3135.95,3250.41,3364.61,3481.95,3599.16,3722.09,3843.76,3969.06,4094.98,4224.99,4355.85,4489.12,4622.1,4759.59,4899.05,5040.37,5184.59,5328.32,5476.11,5623.09,5776,5928.59,6084.79,6240.09,6399.57,6559.79,6724.09,6887.44,7055.92,7224.09,7395.04,7569.17,7745.08,7922.86,8098.53,8279.7,8464.33,8649.12,8835.53,9026.94,9214.91,9406.71,9604.52,9802.42,10000.43,-0.18,2.23,4.88,7.34,15.5,25.16,34.07,48.63,62.52,79.52,98.63,121.95,144.43,170.54,195.86,224.83,255.04,289.47,324.29,362.82,400.95,440.94,485.22,528.99,577.13,624.29,673.27,727.98,784.3,842.21,899.2,959.15,1024.42,1089.12,1154.96,1224.6,1296.04,1369.12,1444.01,1522.36,1601.54,1681.66,1763.6,1849.47,1934.94,2024.1,2116.23,2212.11,2303.6,2398.67,2500.33,2600.17,2704.41,2809.96,2915.16,3024.8,3134.88,3248.87,3363.43,3481.9,3601.98,3720.31,3842.79,3968.03,4094.59,4225.51,4356.35,4489.49,4626.08,4760.98,4899.28,5040.86,5182.35,5329.72,5476.2,5625.39,5776.44,5928.04,6083.39,6242.92,6400.92,6560.39,6722.01,6890.26,7056.06,7224.44,7396.33,7569.54,7743.79,7921.73,8098.53,8280.15,8463.69,8648.9,8835.96,9024.67,9215.86,9406.65,9603.9,9799.69,10000.41,0.33,0.04,1.48,8.79,15.92,24.92,35.91,48.93,64.7,80.43,100.61,120.62,142.66,168.69,195.61,226.2,255.8,289.27,323.2,360.59,400.42,442.23,483.98,527.68,577.64,624.58,676.15,728.82,782.62,839.47,899.58,961.32,1023.52,1089.82,1155.93,1224.21,1295.12,1368.93,1445.08,1522.14,1600.45,1680.61,1762.8,1848.95,1935.42,2027.28,2115.64,2209.24,2303.2,2401.39,2500.49,2601.28,2704.05,2808.34,2915.66,3024.77,3135.83,3248.85,3364.91,3481.39,3600.63,3722.28,3844.61,3968.38,4096.5,4224,4355.85,4488.41,4624.58,4759.59,4901.04,5042.24,5184.42,5328.97,5476.78,5624.05,5777.18,5927.18,6084.65,6242.13,6400,6560.03,6725.09,6886.8,7056.1,7222.12,7395.63,7569.14,7745.53,7919.76,8099.28,8281.93,8462.13,8649.23,8836.46,9025.83,9216.87,9407.28,9603.85,9801.3,9999.87,0.89,0.28,4.91,7.55,15.95,27.45,35.93,47.87,63.26,80.29,99.26,121.18,144.5,168.94,196.49,225.63,256.5,290.48,323.64,361.51,399.28,441.41,483.17,527.9,576.37,625.16,676.16,729.42,783.72,840.89,900.64,962.45,1023.84,1089.53,1156.51,1226.17,1296.69,1367.36,1444.54,1520.7,1599.48,1679.1,1762.07,1848.45,1934.5,2024.74,2116.77,2209.69,2302.28,2400.82,2498.3,2600.65,2706.43,2807.85,2915.63,3023.52,3136.28,3248.22,3362.74,3479.71,3601.06,3721.29,3844.52,3967.45,4094.73,4225.65,4357.1,4489.08,4623.63,4761.12,4898.93,5040.82,5183.69,5329.7,5476.78,5624.01,5774.43,5927.64,6082.74,6240.54,6399.48,6560.45,6725.74,6889.03,7058.01,7224.83,7395.35,7569.45,7742.84,7920.26,8100.7,8281.56,8464.59,8647.91,8838.02,9025.61,9215.07,9408.26,9605.49,9800.26,9999.22,-0.2,1.29,3.95,10.01,14.56,25.04,34.91,50.46,65.52,81.82,98.99,122.65,143.43,168.43,197.57,225.61,256.06,288.62,324.49,359.01,401.13,439.93,483.01,529.08,575.9,625.13,675.99,730.08,785.74,840.93,898.86,960.68,1024.73,1088.22,1154.45,1224.54,1296.5,1368.71,1443.89,1520.89,1601.09,1682.37,1762.62,1849.68,1936.1,2024.55,2114.66,2210.22,2304.14,2400.22,2498.72,2601.66,2705.76,2811.05,2916.12,3025.05,3135.61,3247.99,3365.32,3482.04,3599.91,3721.16,3845.05,3970.76,4095.95,4225.67,4355.89,4490.02,4622.49,4760.83,4900.13,5040.28,5183.67,5328.98,5473.6,5625.53,5776.79,5927.23,6083.93,6241.51,6401.35,6561.74,6724.6,6887.94,7056.22,7225.52,7396.28,7570.53,7743.67,7921.61,8100.12,8280.47,8465.67,8649.47,8834.56,9023.83,9215.16,9409.84,9602.52,9801.67,10000.18,-0.32,1.61,3.81,7.56,16.33,24.03,36.51,48.96,64.22,80.93,97.91,121.13,144,168.34,194.98,224.44,255.22,288.67,322.74,362.22,401.34,441.47,482.95,529.24,577.57,627.03,674.6,730.63,783.74,841.23,899.87,962.63,1025.51,1090.38,1156.79,1225.87,1296.03,1369.25,1443.71,1521,1599.25,1680.27,1762.81,1848.83,1936.59,2024,2114.19,2207.01,2303.16,2400.41,2501.68,2600.67,2703.51,2808.91,2915.4,3023.88,3136.55,3249.06,3364.52,3481.39,3600.06,3722.47,3846.66,3968.18,4096.13,4223.91,4355.84,4490.34,4624.85,4761.57,4899.88,5040.81,5184.4,5330.1,5476.82,5625.87,5777.39,5928.68,6083.88,6238.65,6400.9,6560.74,6722.9,6889.64,7057.14,7227.47,7396.42,7568.67,7744.26,7924,8098.88,8282.41,8463.35,8648.66,8835.02,9024.59,9216.02,9409.85,9603.86,9801.44,9999.4,-0.75,2.21,4.52,9.46,17.43,26.73,37.04,49.61,64.25,81.41,98.51,119.67,143.43,169.02,196.85,225.71,256.18,289.76,323.96,360.87,398.24,440.03,483.42,529.39,575.58,627.09,674.91,727.64,784.27,840.29,899.47,960.95,1022.57,1089.05,1155.17,1224.93,1296.37,1368.5,1442.89,1522.35,1599.91,1681.69,1763.74,1848.46,1934.79,2024.97,2116.22,2209.38,2303.91,2402.2,2499.19,2603.58,2703.17,2809.18,2915.22,3024.79,3137.02,3248.01,3364.32,3480.86,3600.06,3719.77,3844.21,3968.79,4094.9,4223.84,4357.28,4488.62,4624.24,4760.16,4899.8,5040.8,5184.15,5328.58,5476.27,5623.93,5775.8,5928.85,6083.21,6240.23,6399.86,6560.88,6724.83,6888.81,7055.79,7226.46,7394.96,7568.32,7743.42,7921.74,8100.81,8282,8463.73,8649.35,8835.21,9024.63,9215.69,9408.23,9604.14,9801.64,10000,0.02,1.72,5.65,9.25,14.82,25.38,36.66,47.85,64.49,82.93,99.99,120.63,144.09,168.3,195.77,224.67,256.94,288.27,324.51,361.19,399.66,441.09,484.57,528.45,574.93,625.7,675.13,729.08,784.71,842.51,900.79,959.84,1023.7,1089.3,1156.02,1224.75,1296.89,1369.58,1444.23,1521.69,1598.83,1681.56,1764.14,1848.72,1934.35,2024.33,2116.77,2209.53,2304.59,2401.68,2500.62,2602.44,2703.6,2808.1,2915.17,3023.6,3135.59,3249.78,3363.5,3482.55,3600.53,3720.47,3844.08,3969.75,4093.91,4223.85,4356.23,4489.81,4624.76,4761.91,4901.88,5040.73,5182.79,5329.06,5478.19,5623.86,5776.48,5930,6084.54,6241.46,6401.29,6561.2,6723.4,6890.52,7055.63,7223.99,7395.23,7568.66,7743.21,7920.69,8101.34,8281.12,8464.54,8648.93,8834.6,9025.41,9218.1,9410.32,9605.07,9802.41,10000.41,0.9,0.28,2.12,8.36,15.13,24.68,36.11,49.11,63.89,77.93,98.41,122.36,143.71,167.85,195.24,225.9,253.9,290.67,324.77,362.2,400.76,442.2,484.18,529.26,573.85,623.3,675.81,728.98,782.97,841.45,900.63,959.67,1024.45,1088.29,1157.61,1223.9,1295.26,1369.92,1443.88,1519.69,1599.04,1681.51,1762.08,1849.71,1936.24,2024.78,2116.13,2208.08,2304.71,2402.04,2500.14,2602.55,2704.62,2808.21,2916.29,3024.1,3135.74,3249,3364.78,3479.54,3598.91,3722.33,3843.87,3970.01,4095.79,4225.65,4355.47,4488.01,4625.51,4760.93,4901.23,5041.34,5183.03,5329.98,5475.9,5625.56,5775.9,5928.95,6082.57,6242.35,6399.29,6561.15,6722.72,6888.79,7054.87,7225.21,7394.86,7569.13,7743.01,7922.58,8099.96,8280.73,8463.76,8650.07,8836.86,9025.93,9216.38,9408.48,9603.72,9800.37,10001.55,-1.91,1.4,5.98,8.73,16.53,24.54,35.07,48.44,62.56,82.91,99.98,120.78,143.97,168.08,196.9,223.71,256.86,287.83,324.54,361.67,400.01,442.31,485.41,528.62,575.02,624.32,675.6,730.96,784.44,841.34,899.06,960.61,1023.61,1089.03,1158.35,1225.17,1295.56,1368.51,1443.95,1522.27,1599.67,1680.58,1764.94,1845.98,1934.39,2023.88,2115.2,2208.31,2302.66,2400.91,2499.65,2601.55,2702.81,2809.29,2914.82,3024.44,3136.86,3249.16,3364.48,3481.71,3599.15,3722.63,3841.76,3970.15,4095.95,4225.78,4357.09,4489.82,4621.87,4762.67,4901.42,5040.05,5185.08,5325.72,5475.04,5625.36,5776,5930.3,6084.26,6240.92,6399.67,6561.19,6721.82,6889.76,7055.56,7224.67,7395.27,7568.42,7743.83,7922.14,8099.82,8278.86,8463.51,8648.4,8835.49,9025.81,9217.15,9409.05,9602.28,9802.49,9999.88,0.51,-0.61,3.25,9.39,16.18,25.2,37.37,50.37,64.28,81.09,97.77,121.53,143.39,168.26,195.74,224.45,254.42,289.32,325.43,360.86,400.47,438.68,484.58,529.1,576.2,625.21,676.17,728.9,783.06,839.65,899.99,960.31,1023.05,1089.64,1156.63,1223.23,1293.58,1368.67,1445.28,1520.75,1599.07,1681.41,1765.34,1848.65,1936.47,2024.28,2116.38,2209.1,2304,2400.8,2501.27,2602.35,2705.69,2807.6,2915.67,3023.93,3135.18,3248.4,3364.91,3480.63,3599.5,3721.31,3846.19,3969.28,4096.4,4224.99,4356.61,4488.09,4623,4761.61,4900.86,5040.82,5184.69,5327.57,5475.75,5624.26,5774.61,5929.71,6083.03,6240.46,6400.49,6560.01,6724.51,6887.19,7055.16,7226.09,7396.94,7568.87,7744.63,7920.55,8101.02,8281.18,8461.65,8648.5,8835.31,9025.55,9218.04,9408.9,9604.69,9800.54,9999.06,-0.79,2.05,4.24,8.67,16.71,24.33,35.52,49.03,65.01,81.96,99.66,120.22,145.68,167.1,195.83,225.47,253.76,290.25,325.37,359.28,399.49,440.51,483.94,529.4,575.38,624.98,676.58,729.45,784.51,840.69,900.72,961.2,1024.37,1089.66,1156.94,1224.67,1295.88,1370.08,1443.94,1521.33,1600.48,1682.33,1762.33,1850.54,1936.33,2025.63,2115.49,2207.06,2305.12,2400.58,2501.08,2601,2703.38,2808.87,2915.9,3023.92,3137.31,3249.54,3363.93,3481.68,3600,3720.56,3844.94,3968.19,4096.71,4225.12,4353.43,4488.89,4623.14,4759.87,4899.7,5041.25,5182.96,5329.28,5475.6,5625.08,5774.96,5928,6084.63,6242.52,6400.77,6561.45,6722.02,6889.3,7056.55,7224.15,7397.45,7568.7,7746.52,7920.84,8099.3,8281.64,8462.99,8649.25,8836.63,9025.79,9216.52,9408.57,9604.57,9801.74,9997.68,0.46,1.96,2.48,7.89,16.54,24.56,36.85,47.01,63.49,81.06,100.36,120.15,143.44,169,194.67,223.51,257.25,288.8,326.27,362.48,400.74,440.94,484.56,528.14,576.86,626.64,674.72,729.01,785.19,841.43,899.77,960.42,1023.51,1088.87,1155.39,1224.54,1297.16,1367.99,1443.38,1520.14,1600.78,1679.67,1763.57,1848.98,1934.15,2026.37,2114.89,2210.39,2304.12,2401.04,2498.17,2601.7,2704.21,2808.59,2917.13,3025.08,3136.17,3247.88,3363.3,3480.23,3600.71,3722.82,3843.51,3968.62,4096.21,4225.04,4356.31,4487.83,4621.97,4762.23,4901.09,5041.96,5184.66,5329.72,5474.81,5623.85,5776.13,5929.62,6084.59,6242.17,6397.42,6561.63,6723.62,6889.46,7055.48,7224.17,7395.53,7569.57,7744.17,7919.77,8099.46,8284.02,8464.1,8648.95,8834.49,9024.97,9216.4,9409,9604.72,9801.02,9999.91,-0.32,-0.92,4.18,9.87,14.97,22.36,36.06,48.92,64.33,82.28,100.21,120.72,143.6,168.44,196.33,223.84,255.93,290.07,324.72,362.08,399.26,440.71,483.05,527.78,575.54,623.18,675.67,728.84,782.84,841.5,898.88,960.94,1023.83,1089.04,1154.36,1225.48,1296.1,1371.11,1443.5,1521.43,1599.87,1680.51,1764.5,1847.83,1936.88,2025.02,2115.18,2210.44,2303.75,2401.76,2499.27,2600.01,2704.73,2808.8,2914.93,3023.87,3135.36,3248.97,3365.16,3481.93,3600.95,3719.05,3845.3,3969.64,4094.31,4225.8,4355.42,4488.99,4624.84,4762.3,4900.09,5041.31,5182.16,5328.72,5474.08,5625.44,5774.42,5929.62,6083.36,6243.27,6399.55,6559.4,6723.5,6890.26,7056.52,7225.57,7396.83,7570.7,7743.31,7922.04,8100.45,8279.94,8465.25,8651.03,8836.86,9026.25,9214.49,9409.81,9602.27,9802.43,9998.72,-0.36,0.83,4.04,7.25,15.23,25.5,36.91,50.09,64.18,79.28,98.85,122.01,141.26,169.93,193.85,224.22,254.94,291,323.68,362.73,400,441.4,485.03,529.44,576.36,625.84,676.98,728.55,782.95,839.5,901.15,962.02,1023.19,1089.71,1157.87,1224.75,1296.63,1368.63,1445.48,1521.77,1601.69,1679.68,1764.86,1848.57,1936.02,2024.94,2115.22,2210.12,2302.99,2399.56,2501.04,2600.34,2704.26,2808.13,2914.3,3025.65,3136.33,3249.52,3362.85,3482.37,3601.9,3721.33,3842.88,3971,4096.63,4226.26,4354.89,4489.12,4624.8,4761.7,4899.91,5041.6,5181.92,5329.31,5477.17,5625.94,5774.35,5928.9,6083.92,6240.86,6401.07,6560.79,6724.99,6887.8,7057.27,7224.61,7394.96,7568.84,7743.75,7920.96,8098.41,8280.76,8464.45,8649.12,8837.62,9026.27,9215.43,9408.37,9604.66,9801.68,10000.63,-0.15,1.46,2.87,9.57,15.31,25.88,34.76,48.49,64.49,81.04,100.78,121.34,143.55,169.66,195.72,224.49,256.53,288.26,323.91,362.54,398.95,440.4,482.22,529.09,575.26,625.1,675.45,728.15,784.2,840.39,898.82,960.61,1024.75,1087.64,1156.88,1226.46,1294.57,1367.72,1443.91,1519.95,1599.86,1681.84,1762.83,1848.61,1937.41,2025.59,2116.02,2208.14,2303.76,2401.35,2500.96,2599.03,2704.89,2811.46,2914.68,3025.15,3137.3,3249.59,3364.18,3482.12,3597.99,3720.91,3844.43,3968.15,4096.47,4224.93,4357.74,4487.83,4623.78,4761.88,4900.07,5040.96,5183.18,5327.76,5476.53,5625.33,5775.23,5927.65,6083.75,6240.55,6398.23,6562.17,6724,6887.69,7055.46,7225.4,7397.02,7567.61,7745.25,7921.84,8099.74,8281.61,8463.23,8649.29,8835.58,9025.47,9215.5,9408.1,9604.62,9799.88,10000.06,0.08,0.53,2.67,7.86,15.05,24.6,37.71,50.24,64.15,79.84,99.37,120.91,142.64,168.76,197.91,224.53,255.18,290.2,322.82,362.85,399.53,441.81,482.94,528.96,576.31,624.98,675.36,729.98,784.92,840.9,902.12,961.57,1024.33,1089.89,1155.22,1223.26,1294.71,1370.19,1444.62,1521.25,1600.79,1681.94,1765.86,1848.32,1935.63,2025.39,2114.57,2208.01,2303.26,2402.79,2500.41,2599.57,2703.03,2810.01,2917.67,3025.68,3135.61,3249.94,3364.93,3479.41,3599.26,3720,3843.97,3967.14,4096.76,4226.16,4356.46,4488.62,4622.9,4760.42,4900.93,5041.96,5186.85,5328.63,5475.46,5624.4,5775.03,5929.95,6083.52,6243.12,6399.16,6561.38,6723.18,6887.16,7056.11,7224.4,7397.22,7569.83,7743.87,7919.93,8099.35,8279.92,8464.44,8649.67,8836.95,9025.85,9216.07,9410.03,9602.6,9801.01,10000.98,1.59,0.46,5.39,9.14,16.3,25.4,35.32,47.63,62.64,80.96,100.08,120.69,143.57,168.85,193.66,223.84,256.89,288.88,323.45,361.25,400.32,441.47,484.07,529.64,576.52,624.1,674.37,728.69,784.35,840.2,900.76,961.04,1023.87,1090.28,1155.82,1224.26,1297.68,1368.43,1444.91,1519.96,1598.02,1682.42,1763.77,1848.31,1934.92,2025.18,2117.87,2210.8,2302.99,2400.61,2500.16,2601.62,2702.29,2809.68,2915.97,3027.35,3136.11,3248.4,3363.52,3481.87,3599.53,3721.4,3841.57,3971.26,4096.32,4224.15,4355.6,4490.22,4624.49,4760.68,4899.93,5039.75,5184.61,5329.11,5476.28,5624.4,5775.85,5929.1,6084.32,6243.16,6401.35,6561.91,6724.66,6888.72,7055.37,7223.85,7396.76,7568.4,7743.14,7921.46,8098.56,8279.92,8464.15,8648.34,8835.33,9025.3,9214.8,9408.42,9604.65,9799.04,9998.72,1.4,1.24,4.33,8.96,16.39,24.98,36.1,49.9,63.25,83.88,101.24,121.92,143.97,168.9,195.22,226.06,254.59,288.83,322.81,361.73,399.11,440.41,484.61,530.19,577.08,625.23,676.17,730.29,784.76,841.32,899.06,959.81,1023.57,1088.82,1157.1,1226.52,1297.43,1369.38,1442.24,1522.36,1599.09,1680.56,1763.32,1849.7,1937.39,2025.06,2116.11,2208.77,2303.41,2400.36,2499.72,2600.92,2707.27,2807.97,2915.14,3023.43,3136.03,3249.13,3365.83,3481.53,3600.34,3721.63,3845.42,3969.98,4094.57,4226.57,4356.43,4489.32,4621.57,4761.35,4901.27,5042.07,5184.85,5329.48,5476.01,5624.2,5775.43,5930.05,6083.4,6241.55,6400.03,6561.17,6724.22,6887.43,7053.99,7225.84,7394.75,7569.15,7742.4,7923.42,8099.48,8280.62,8465.64,8648.13,8836.86,9027.38,9214.36,9410,9603.59,9800.6,9999.63,-1.17,0.35,4.1,7.72,16.87,27.23,35.21,48.79,63.82,82.23,99.73,121.61,142.99,168.57,196.24,226.19,256.4,287.73,322.45,360.12,399.68,441.31,482.19,528.95,574.29,624.95,676.24,727.41,784.42,839.49,899.29,959.82,1024.85,1088.35,1155.78,1226.77,1295.89,1369.71,1442.58,1521.07,1600.3,1682.35,1762.6,1849.83,1938.13,2025.99,2115.65,2209.08,2304.39,2400.09,2500.14,2600.92,2704.6,2808.85,2916.76,3024.91,3136.02,3249.13,3363.89,3480.92,3599.22,3722.61,3843.74,3969.86,4096.32,4224.6,4355.07,4488.72,4624.48,4760.05,4900.97,5039.79,5185.69,5328.48,5476.39,5622.91,5775.68,5926.93,6081.14,6241.41,6399.95,6561.52,6724.06,6886.29,7056.63,7227.24,7396.69,7568.79,7744.16,7920.65,8101,8281.84,8465.11,8648.13,8836.68,9024.79,9216.58,9407.43,9604.55,9801.09,10001.18,-0.84,1.1,4.33,8.72,17.59,23.92,36.61,49.84,63.89,81.86,99.61,120.75,142.58,168.57,198.14,225.27,256.17,289.1,324.79,361.54,400.44,440.03,482.17,527.42,574.81,624.15,677.15,730.88,782.67,840.99,899.22,962.32,1023.24,1090,1155.11,1224.53,1295.08,1368.67,1443.02,1520.91,1599.47,1680.15,1762.66,1849.56,1935.41,2025.22,2116.07,2209.8,2301.94,2399.62,2502.13,2599.4,2705.96,2808.33,2915.26,3025,3136.69,3248.35,3364.72,3480.32,3599.33,3720.92,3843.4,3969.1,4096.51,4225.85,4356.69,4487.92,4624.25,4762.09,4899.73,5041.78,5181.59,5329.27,5476.02,5626.13,5775.92,5928.64,6086.4,6241.39,6400.91,6563.95,6723.49,6889.19,7056.86,7226.65,7395.31,7568.1,7744.46,7922.37,8099.55,8279.49,8463.73,8648.08,8836.08,9023.8,9213.47,9408.73,9604.17,9800.8,10001.03,-0.73,1.1,4.81,8.55,14.79,25.62,34.87,50.96,64.51,81.27,100.22,119.94,144.13,168.58,196.23,225.65,257.07,289.03,324.79,362.12,399.14,441.82,485.7,530.66,575.96,623.69,678.53,727.86,783.29,841.33,899.44,960.68,1024.53,1089.09,1155.13,1222.99,1294.38,1370.02,1444.29,1520.57,1599.88,1681.7,1763.63,1849.6,1937.07,2023.69,2114.21,2209.65,2304.7,2400.28,2501.75,2601.31,2703.36,2809.65,2914.74,3024.81,3136.53,3249.29,3365.85,3480.12,3600.82,3721.7,3843.58,3968.98,4097.63,4227.06,4355.86,4490.03,4623.33,4762.18,4898.06,5040.78,5184.86,5330.16,5477.33,5625.02,5775.79,5930.01,6082.29,6241.89,6398.8,6559.56,6724.33,6889.01,7056.51,7223.75,7396.99,7567.27,7745.01,7920.77,8099.11,8280.33,8463.38,8649.52,8836.23,9024.51,9213.9,9410.33,9603.7,9802.66,10000.5,0.1,0.76,3.41,7.49,16.22,24.76,35.23,48.71,63.33,81.06,98.1,121.93,141.13,168.43,194.91,224.8,255.67,290.96,325.05,360.95,400.4,441.2,483.87,527.67,577.35,624.71,675.36,728.41,782.87,842.94,898.41,958.36,1023.12,1089.52,1157.03,1225.53,1295.45,1367.98,1443.72,1523,1600.85,1679.69,1763.17,1848.66,1937.41,2025.52,2115.4,2210.36,2303.5,2401.3,2499.17,2600.56,2702.85,2807.33,2916.14,3024.55,3134.66,3249.05,3365.3,3481.64,3599.92,3721.8,3843.72,3969.47,4096.61,4224.26,4354.05,4488.33,4623.07,4758.69,4899.61,5039.29,5183.29,5328.94,5475.29,5624.12,5775.12,5928.96,6082.75,6241.13,6401.39,6559.51,6724.47,6888.36,7057.07,7224.5,7394.46,7569.25,7743.62,7922.61,8100.78,8279.41,8461.2,8648.39,8833.79,9025.72,9215.51,9409.78,9604.67,9801.31,9998.72,0.26,1.09,3.64,7.45,16.34,26.05,36.14,49.71,64.06,80.84,98.85,122.88,143.45,169.41,197.25,223.26,256.87,288.99,323.95,360.46,399.86,441.57,483.58,529.33,574.99,624.95,675.74,729.17,784.46,840.32,900.99,960.26,1025.13,1089.8,1155.19,1226.15,1295.49,1371.48,1445.64,1520.97,1599.52,1682.44,1765.07,1849.59,1934.25,2026.2,2115.79,2208.64,2304.93,2401.69,2500.32,2601.22,2703.51,2808.97,2914.97,3024.94,3135.91,3248.94,3364.03,3480.72,3598.73,3721.8,3845.43,3968.61,4095.57,4224.9,4355.38,4488.32,4625.4,4759.88,4899.49,5042.39,5184.3,5328.84,5477.15,5626.37,5775.27,5928.14,6084.04,6241.58,6400.66,6560.23,6725.53,6888.99,7056.44,7224.56,7396.59,7567.58,7742.16,7921.33,8100.89,8281.1,8463.77,8648.83,8838.07,9027.27,9217.31,9408.07,9603.16,9801.42,9999.91,-1.76,1.08,6.39,10.3,15.58,24.77,34.85,48.21,64.18,81.81,98.64,121.89,143.68,168.05,196.88,223.52,255.85,291.47,322.84,361.67,400.42,441.68,485.05,527.57,576.58,624.31,675.73,728.94,784.23,841.62,898.33,960.79,1025.21,1089.16,1155.98,1224.17,1294.88,1370.9,1444.19,1522.71,1597.39,1679.92,1764.08,1849.02,1936.62,2025.31,2115.21,2209.18,2303.64,2399.88,2500.87,2600.09,2702.74,2807.51,2915.9,3025.13,3134.53,3249.48,3362.58,3482.27,3600.06,3720.57,3844.47,3967.34,4096.3,4224.96,4357.02,4487.62,4624.37,4762.11,4898.86,5040.39,5185.13,5327.79,5476.12,5623.62,5776.16,5928.16,6083.4,6241.42,6397.83,6560.58,6724.83,6888.54,7057,7224.47,7394.57,7569.28,7743.35,7921.75,8099.51,8279.77,8462.92,8650.35,8836.72,9025.16,9215.83,9408.34,9604.23,9802.36,10001.21,-0.01,2.49,4.75,8.73,15.89,26.63,35.16,50.08,63.42,81.55,97.71,122.59,142.22,167.3,195.45,224.77,256.19,289.22,325.07,359.39,399.93,441.35,483.54,528.53,578.56,621.75,678.33,730.07,783.65,840.81,898.39,961.71,1024.11,1088.92,1155.02,1224.54,1296.56,1369.42,1445.43,1520.16,1600.72,1681.42,1765.2,1849.04,1937,2025.53,2117.03,2208.79,2304.44,2400.35,2499.22,2600.39,2701.65,2810.04,2915.69,3025.95,3134.04,3248.47,3362.68,3479.36,3600.96,3720.62,3842.39,3969.09,4096.15,4224.88,4356.03,4487.19,4624.66,4761.89,4899.99,5042.5,5183.85,5329.73,5473.5,5624.2,5775.81,5928.92,6084.18,6240.97,6403.14,6561.64,6723.24,6889.76,7055.33,7227.28,7395.53,7569.68,7742.34,7922.29,8101,8281.68,8461.52,8649.02,8836.4,9025.69,9216,9408.13,9604.87,9802.41,9999.2,-0.57,2.87,3.16,9.39,14.24,24.45,35.6,49.25,64.05,81.92,99.2,120.21,145.54,169.95,196,224.85,256.48,289.75,323.91,361.87,400.42,442.93,483.58,529.64,577.15,625.22,675.78,726.54,784.07,841.04,900.97,963.27,1025.25,1088.45,1154.87,1225.31,1296.04,1369.57,1443.07,1520.78,1600.32,1680.8,1763.21,1847.92,1935.97,2022.59,2114.38,2209.09,2303.93,2401.42,2500.63,2600.94,2703.9,2809.13,2915.32,3026.67,3135.45,3248.05,3363.53,3481.41,3599.11,3719.87,3843.96,3968.91,4094.95,4223.83,4356.09,4489.43,4625.7,4758.98,4900.5,5041.2,5183.62,5330.06,5477.65,5625.35,5777.06,5927.45,6083.64,6239.84,6401.4,6560.81,6723.29,6889.16,7055.27,7227.25,7397.22,7567.63,7745.73,7921.04,8101.3,8281.33,8464.32,8650.38,8836.65,9024.76,9216.06,9409.83,9603.45,9801.41,9999.88,0.9,0.88,6.1,8.18,15.19,24.97,36.26,49.37,63.08,82.41,100.39,121.23,144.65,169.43,196.76,224.8,255.86,287.9,322.46,362.33,399.81,440.79,483.19,529.86,576.43,625.41,677.31,729.62,784.48,839.39,899.64,962.47,1024.18,1090.2,1157.04,1224.28,1296.66,1367.36,1443.47,1519.48,1599.94,1679.31,1764.43,1848.78,1935.32,2024.98,2115.2,2208.49,2304.46,2401.66,2499.8,2600.93,2706.63,2808.74,2915.49,3026.46,3135.51,3252.02,3363.48,3482.75,3599.45,3720.41,3845.39,3968.47,4096.7,4225.21,4356.67,4490.1,4623.43,4760.45,4901.51,5042.75,5184.47,5327.72,5476.61,5626.79,5775.46,5928.7,6084.31,6241.67,6400.28,6562.79,6722.19,6889.26,7055.25,7224.37,7396.09,7569.78,7743.87,7919.64,8100.67,8281.59,8464.12,8648.28,8836.36,9026.71,9216.12,9408.88,9604.26,9801.17,9998.61,0.96,0.05,4.58,8.78,13.7,24.47,36.48,49.32,63.63,81.07,99.8,119.93,143.52,169.4,195.57,225.33,256.82,288.85,323.69,360.45,402.22,442.05,484.44,529.35,576.69,624.16,675.65,728.69,783.73,841.26,900.13,961.96,1024.42,1090.18,1155.52,1224.23,1297.21,1368.32,1443.13,1521.32,1599.78,1681.91,1765.25,1849.65,1936.54,2026.19,2115.37,2210.03,2304.38,2400.23,2499.88,2599.84,2704.48,2809.18,2916.89,3025.51,3134.23,3246.85,3363.61,3481.83,3600.71,3722.83,3843.84,3969.03,4097.49,4224.57,4354.83,4487.7,4622.4,4760.6,4900.93,5041.31,5182.89,5328.18,5476.58,5624.95,5776.11,5927.79,6083.15,6241.21,6400.6,6560.76,6723.98,6888.03,7056.69,7225.12,7394.77,7569.08,7744.81,7919.89,8101.77,8281.32,8463.77,8649.27,8836.19,9025.61,9215.64,9410.27,9604.92,9801.16,10000.46,1.16,2.63,3.47,10.41,16.12,26.35,36.14,49.09,65.2,82.77,100.36,118.89,145.2,168.37,197.23,224.18,255.28,289.92,322.9,361.03,399.21,440.1,483.62,529.8,576.57,627.11,675.31,728.12,784.04,842.26,900.68,962.19,1022.57,1090.21,1154.8,1226.21,1297.01,1368.74,1444.13,1521.26,1601.11,1680.12,1763.49,1849.69,1936.81,2024.26,2115.47,2210.5,2303.51,2399.95,2500.7,2601.21,2704.94,2810.28,2917.59,3024.24,3138.25,3248.26,3364.27,3481.55,3599.45,3721.18,3845.17,3968.38,4096.24,4224.77,4355.61,4490.63,4624.07,4759.41,4900.24,5040.84,5182.66,5327.6,5474.89,5624.96,5775.07,5927.19,6084.45,6242.32,6399.73,6560.97,6722.4,6889.12,7056.39,7227.33,7397.47,7568.92,7743.86,7921.52,8099.39,8281.84,8464.64,8649.41,8837.18,9025.13,9217.41,9409.53,9605.29,9801,10000.59,0.12,1.2,5.45,8.33,15.49,24.85,38.29,48.91,64.5,81.98,99.49,122.32,143.38,168.31,197.08,224.24,254.94,288.77,323.91,362.14,400.81,441.4,483.37,526.81,576.03,624.98,675.77,731.21,785.02,841.55,898.88,959.6,1024.39,1088.8,1154.03,1226.18,1296.75,1368.07,1444.15,1519.94,1601.09,1682.09,1764.5,1848.68,1935.14,2024.79,2116.5,2210.22,2305.66,2399.49,2499.49,2602.61,2703.68,2808.94,2914.62,3025.49,3136.67,3249.99,3365.03,3479.34,3599.18,3720.66,3843.47,3968.91,4097.38,4224.98,4356.25,4489.66,4623.9,4761.64,4900.52,5041.04,5184.86,5328.67,5475.21,5626.19,5777.54,5930.26,6081.34,6240.85,6400.61,6560.32,6723.81,6888.82,7054.92,7225.66,7395.89,7568.25,7744.42,7921.65,8099.95,8281.51,8462.89,8648.64,8837.33,9026.14,9218.77,9408.39,9605.48,9801.69,10001.05,0.89,2.14,3.51,8.57,14.58,25.19,34.82,48.14,64.16,81.12,100.13,121.97,144.47,169.41,195.01,224.48,255.41,290.68,325.09,361.12,400.22,440.52,482.09,527.99,575.59,624.95,676.89,727.81,783.63,843.36,900.93,960.96,1023.66,1087.9,1156.69,1226.23,1296.79,1369.27,1444.26,1520.57,1601.06,1679.86,1764.98,1849.39,1935.86,2025.69,2115.3,2210.51,2303.51,2401.63,2501.1,2601.69,2703.31,2810.41,2917.52,3025.12,3137.06,3249.21,3364.37,3480.94,3599.14,3722.74,3844.84,3968.29,4096.11,4226.49,4356.86,4489.91,4623.92,4760.06,4900.12,5041.49,5184.42,5328.83,5476.65,5625.58,5775.6,5929.01,6086.78,6240.41,6401.05,6561.08,6725.83,6888.39,7056.56,7224.61,7396.89,7568.79,7745.67,7923.03,8099.07,8280.91,8464.02,8648.21,8835.25,9023.57,9217.76,9408.83,9602.83,9800.56,9998.19,-0.93,1.35,2.04,9.38,16.91,24.8,36.43,49.4,65.34,82.6,100.18,122.3,144.16,168.82,197.68,226.61,254.88,289.37,324.94,360.88,399.56,441.77,483.58,530.25,576.84,624.06,674.47,729.94,786.06,841.66,899.95,961.03,1022.14,1088.58,1155.98,1224.97,1296.52,1368.98,1446,1519.09,1600.52,1680.59,1766.27,1847.32,1936.82,2025.65,2114.83,2208.37,2305.69,2400.82,2499.32,2601.98,2704.05,2808.97,2914.98,3024.09,3137.21,3249.6,3363.34,3480.45,3599.17,3720.86,3841.98,3969.6,4096.3,4224.81,4355.38,4488.5,4622.65,4759.09,4899.5,5041.1,5186.48,5328.56,5474.72,5625.26,5776.73,5929.61,6083.85,6240.49,6399.95,6559.89,6726.43,6889.31,7055.73,7225.8,7397.19,7567.6,7742.8,7922.61,8099.65,8281.93,8463.99,8648.13,8837.06,9024.75,9217.15,9410.12,9606.78,9800.56,9999.7,0.77,2.16,3.16,8.82,14.64,25.64,36.22,48.73,64.86,83.08,102.23,121.35,144.77,169.14,197.01,226.19,257.36,290.52,323.81,362.05,400.9,440.41,481.85,529.54,576.27,625.1,675.33,727.89,783.12,840.22,900.38,962.07,1023.87,1088.28,1158.45,1223.54,1297.26,1368.92,1443.9,1518.96,1600.71,1681.25,1763.93,1849.18,1935.14,2026.71,2115.51,2206.81,2303.5,2402.16,2499.41,2601.98,2704.1,2809.97,2915.53,3025.29,3134.46,3248.13,3363.78,3481.5,3599.33,3721,3843.85,3968.73,4096.67,4225.3,4357.95,4488.77,4625.32,4761.65,4899.44,5042.42,5185.65,5329.9,5476.76,5624.29,5775.09,5929.36,6084.18,6239.65,6400.35,6560.86,6724.7,6889.1,7054.72,7224.21,7396.04,7568.61,7744.35,7920.66,8098.77,8282.13,8465.34,8648.43,8838.06,9024.84,9218.17,9409.14,9602.76,9799.27,10001.27,0.25,0.44,3.38,9.55,14.42,24.44,35.36,47.91,65.42,81.8,100.48,122.05,143.8,167.71,196.24,224.04,255,288.85,322.55,362.13,399.1,441.73,483.22,527.2,574.87,624.46,675.49,730.22,783.47,839.78,899.05,960.78,1025.02,1090.01,1154.61,1223.7,1295.3,1368.71,1444.74,1521.3,1601.28,1679.81,1764.39,1850.35,1934.87,2024.58,2115.87,2208.9,2304.45,2402.06,2499.47,2600.77,2704.72,2808.22,2915.12,3024.34,3136.83,3249.57,3364.09,3481.37,3600.84,3721.13,3846.66,3969.38,4095.18,4224.75,4354.38,4488.65,4623.39,4760.91,4901.31,5042.13,5182.79,5329.34,5476.14,5623.88,5774.43,5929.63,6082.81,6240.32,6402.04,6560.51,6722.53,6888.38,7054.57,7224.86,7396.74,7569.49,7744.03,7923.28,8098.83,8282.84,8464.46,8648.88,8836.56,9026.66,9217,9408.24,9604.74,9799.79,9998.57,0.27,1.18,5.74,8.89,16.62,23.94,35.39,48.05,63.89,81.06,98.75,120.97,144.79,167.61,196.71,224.13,256.07,288.33,325.01,361.06,400.14,439.8,482.63,530.07,576.12,624.9,676.55,730.71,783.35,840.36,900.91,961.38,1024.12,1089.15,1155.35,1224.27,1296.82,1367.36,1444.3,1520.9,1598.11,1681.01,1765.31,1849.21,1935.54,2024.29,2115.87,2207.99,2304.55,2401.36,2499.36,2601.54,2704.36,2808.59,2915.73,3025.42,3135.4,3248.36,3363.43,3480.57,3600.11,3720.76,3843.76,3968.9,4096.53,4224.82,4355.84,4488.44,4625.38,4761.67,4901.14,5041.09,5184.31,5330.77,5474.97,5624.29,5774.9,5929.29,6084.18,6242.75,6398.63,6562.15,6724.66,6889.01,7056.04,7224.76,7399.06,7568.3,7745.84,7922.26,8101.02,8281.58,8463.5,8648.04,8836.65,9023.36,9215.56,9409.94,9604.49,9800.13,9999.76,1.43,1.79,3.8,9.07,13.69,25.34,33.96,49.67,63.26,80.44,101.29,120,143.63,170.91,194.64,223.87,255.95,289.78,323.61,360.62,400.81,440.46,484.52,529.06,575.62,624.94,675.25,728.28,785.14,840.8,899.85,959.82,1024.21,1088.39,1155.87,1224.07,1296.27,1368.28,1444.02,1520.93,1600.62,1681.9,1765.67,1849.68,1936.55,2024.14,2115.96,2209.55,2304.68,2402.55,2500.65,2601.84,2704.88,2808.33,2915.37,3022.75,3136.02,3248.31,3363.26,3480.57,3599.46,3721.23,3842.33,3969.63,4095.86,4225.57,4353.57,4489.28,4622.81,4761.44,4899.22,5040.83,5184.3,5329.41,5478.39,5623.83,5774.77,5928.59,6082.83,6240.48,6401.7,6561.44,6721.56,6889.41,7056.2,7224.72,7395.6,7568.39,7744.85,7919.55,8100.64,8279.21,8463.45,8650.43,8835.04,9025.04,9214.9,9408.21,9603,9800.83,9999.95,1.05,0.87,4.39,7.81,14.92,26.59,36.21,49.38,62.57,81.26,100.29,121.31,145.03,168.46,197.33,225.03,255.64,290.33,326.28,359.75,400.29,440.39,484.35,529.4,577.79,624.46,676.84,729.57,786.03,839.72,900.53,959.68,1022.52,1089.35,1157.61,1223.99,1296.61,1367.94,1444.08,1521.39,1600.79,1679.04,1763.32,1847.28,1935.52,2025.17,2114.34,2209.66,2303.2,2401.02,2500.23,2599.9,2702.74,2808.47,2916.06,3024.78,3135.74,3248.27,3362.22,3482,3600.77,3722.54,3842.88,3968.25,4094.56,4225.58,4356.03,4491.16,4624.11,4760.81,4898.81,5041.21,5183.05,5329.79,5475.31,5623.02,5775.81,5928.64,6083.25,6240.83,6400.7,6560.06,6723.78,6888.17,7056.58,7225.13,7396.23,7569.38,7743.1,7920.12,8100.25,8279.43,8464.15,8649.38,8836.54,9024.91,9216.21,9410.21,9603.17,9799.02,10001.6,-0.47,0.83,5.41,9.98,15.77,27.51,35.45,50.22,65.04,83.27,99.27,121.95,143.76,169.11,194.56,224.74,255.77,290.78,324.14,360.64,399.71,442.79,483.39,528.83,576.67,624.44,675.04,728.54,783.99,839.85,898.59,961.92,1023.82,1086.94,1157.52,1225.84,1295.47,1367.84,1445.59,1521.41,1600.07,1680.29,1763.51,1849.78,1935.98,2023.56,2115.25,2209.65,2304.16,2400.44,2499.53,2599.73,2703.89,2808.56,2917.52,3025.47,3134.59,3250.64,3363.37,3480.6,3601.82,3722.05,3844.18,3968.33,4093.81,4226.77,4357.56,4490.11,4626.71,4762.35,4901.95,5041.24,5182.59,5329.02,5477.35,5625.03,5776.24,5929.23,6084.39,6240.44,6399.16,6561.48,6723.99,6890.05,7055.68,7224.78,7395.27,7568.18,7744.17,7922.18,8100.08,8281.93,8463.61,8648.18,8835.15,9022.79,9216.23,9408.06,9603.56,9799.17,9999.63,0.73,1.73,2.72,9.1,16.72,23.67,34.96,48.98,63.77,82.48,102.53,120.12,142.51,167.96,197.84,224.69,254.27,288.33,326.97,360.68,399.64,442.21,483.27,530.1,575.95,625.33,676.66,729.78,785.21,840.69,900.3,959.57,1023.64,1088.95,1156.27,1226.75,1296.3,1367.46,1444.12,1522.58,1599.61,1679.97,1762.97,1849.56,1934.63,2024.97,2115.7,2209.27,2303.35,2400.84,2499.01,2601.22,2704.9,2808.97,2916.64,3026.87,3136.88,3246.86,3365.68,3479.78,3601.69,3722.28,3846.01,3971.07,4094.47,4225.87,4356.49,4487.97,4623.88,4761.22,4900.46,5040.2,5183.96,5329.77,5474.73,5624.1,5776.31,5930.69,6084.31,6239.73,6401,6561.64,6723.96,6888.54,7054.9,7226.56,7394.32,7568.85,7744.9,7921.42,8099.9,8281.97,8464.55,8649.7,8834.3,9022.78,9216.01,9408.52,9602.37,9800.17,10000.41,0.48,1.8,4.81,8.64,14.61,25.49,37.81,49.86,62.77,80.95,99.46,119.9,144.36,168.29,196.48,227.44,255.17,291.08,323.41,360.6,397.72,440.77,483.22,530.01,577.57,625.37,677.17,731.32,786.78,840.65,899.89,962.61,1023.01,1089.42,1157.8,1224.64,1295.51,1369.3,1443.95,1522.05,1597.6,1681.41,1764.28,1849.08,1936.81,2024.35,2115.38,2210.78,2303.13,2400.34,2499.78,2600.5,2703.73,2806.53,2917.75,3025.9,3134.87,3249.39,3363.87,3480.91,3599.27,3720.68,3843,3969.85,4096.08,4227,4356.4,4488.96,4622.91,4759.71,4898.78,5040.86,5185.1,5329.88,5477.22,5626.23,5777.11,5928.87,6083.68,6240.33,6402.35,6561.72,6723.21,6888.85,7055.53,7226,7395.62,7569.66,7744.78,7919.66,8100.89,8280.96,8464.82,8648.22,8834.73,9023.58,9215.48,9409.02,9604.96,9801.67,9998.88,0.6,-1.3,3.23,9.7,17.3,24.27,37.35,50.15,62.75,79.04,100.03,121.35,144.27,170.51,197.65,224.86,255.7,288.86,323.24,360.14,402.16,442.12,483.98,530.23,576.93,625.65,676.87,729.8,782.9,841.78,898.56,962.44,1024.54,1088.45,1154.66,1225.65,1295.99,1368.13,1441.72,1523.55,1599.24,1681.77,1764.34,1847.82,1933.84,2023.44,2117.02,2207.62,2303.01,2402.36,2500.17,2600.93,2703.21,2807.45,2916.56,3025.12,3136.2,3249.34,3364.92,3482.02,3600.53,3720.92,3844.25,3970.35,4095.81,4225.27,4356.13,4488.89,4623.03,4760.5,4899.46,5039.86,5185.26,5329.23,5476.69,5627.26,5775.57,5928.23,6084.38,6240.8,6401.8,6561.06,6721.78,6889.78,7056.75,7225.91,7394.52,7568.98,7745.37,7920.48,8099.86,8279.62,8464.41,8650.68,8837.02,9024.24,9216.18,9409.79,9603.05,9802.66,10000.22,0.88,0.17,4.76,9.24,16.09,22.55,35.81,50.49,63.05,80.99,99.97,120.42,144.83,168.68,196.16,225.48,256.82,288.11,325.14,360.55,399.41,441.09,484,528.04,576.42,624.32,674.88,727.63,782.91,840.55,899.22,962.45,1024.21,1088.06,1156.17,1226.03,1296.51,1368.24,1444.13,1518.43,1603.04,1681.8,1763.04,1849.14,1938.13,2023.25,2116.69,2208.8,2305.07,2399.47,2498.71,2600.14,2704.39,2810.46,2916.09,3026.71,3135.39,3246.83,3364.09,3480.15,3601.96,3719.94,3843.82,3968.38,4096.04,4225.86,4355.57,4488.66,4623.44,4762.33,4899.48,5041.12,5185.2,5328.55,5474.85,5625.46,5775.29,5929.31,6084.21,6242.3,6399.38,6562.34,6724.35,6887.76,7054.58,7225.68,7396.2,7570.75,7744.64,7921.63,8100.35,8282.07,8464.04,8649.85,8836.71,9024.15,9218,9408.83,9603.19,9799.72,9999.16]],"container":"<table class=\"display\">\n <thead>\n <tr>\n <th> <\/th>\n <th>x<\/th>\n <th>y_hat<\/th>\n <th>e<\/th>\n <th>y<\/th>\n <\/tr>\n <\/thead>\n<\/table>","options":{"pageLength":7,"columnDefs":[{"className":"dt-right","targets":[1,2,3,4]},{"orderable":false,"targets":0}],"order":[],"autoWidth":false,"orderClasses":false,"lengthMenu":[7,10,25,50,100]}},"evals":[],"jsHooks":[]}</script> --- # LogY-LogX-Regression in R ```r lm_loglog <- lm(log(y) ~ log(x), data = filter(d3, y > 0 & x > 0)) lm_loglog ``` ``` ## ## Call: ## lm(formula = log(y) ~ log(x), data = filter(d3, y > 0 & x > 0)) ## ## Coefficients: ## (Intercept) log(x) ## -0.005982 2.001501 ``` *Achtung*: Für negative Zahlen ist der Logarithmus nicht definiert. --- # Visualisierung eines LogY-LogX-Zusammenhangs .pull-left[ ```r ggplot(d3) + aes(x = x, y = y) + geom_point() + geom_smooth() ``` ] .pull-right[  ] Lineares Modell passt nicht; es liegt quadratisches Wachstum vor. Das entspricht einem Log-Log-Modell. --- # `d4`: Einfaches Zahlenbeispiel für ein Potenzgesetz ```r d4 <- tibble( x = 0:10, y = x^2, x_log = log(x, base = 2) %>% round(2), y_log = log(y, base = 2) %>% round(2) ) ``` --- # So sieht `d4` aus <div id="htmlwidget-93298a69b485e645b8e6" style="width:100%;height:auto;" class="datatables html-widget"></div> <script type="application/json" data-for="htmlwidget-93298a69b485e645b8e6">{"x":{"filter":"none","data":[["1","2","3","4","5","6","7","8","9","10","11"],[0,1,2,3,4,5,6,7,8,9,10],[0,1,4,9,16,25,36,49,64,81,100],[null,0,1,1.58,2,2.32,2.58,2.81,3,3.17,3.32],[null,0,2,3.17,4,4.64,5.17,5.61,6,6.34,6.64]],"container":"<table class=\"display\">\n <thead>\n <tr>\n <th> <\/th>\n <th>x<\/th>\n <th>y<\/th>\n <th>x_log<\/th>\n <th>y_log<\/th>\n <\/tr>\n <\/thead>\n<\/table>","options":{"pageLength":7,"columnDefs":[{"className":"dt-right","targets":[1,2,3,4]},{"orderable":false,"targets":0}],"order":[],"autoWidth":false,"orderClasses":false,"lengthMenu":[7,10,25,50,100]}},"evals":[],"jsHooks":[]}</script> --- # Verdoppelt sich X, vervierfacht sich Y <div id="htmlwidget-7e3e271a277266dbd503" style="width:100%;height:auto;" class="datatables html-widget"></div> <script type="application/json" data-for="htmlwidget-7e3e271a277266dbd503">{"x":{"filter":"none","data":[["1","2","3","4","5","6","7","8","9","10","11"],[0,1,2,3,4,5,6,7,8,9,10],[0,1,4,9,16,25,36,49,64,81,100],[null,0,1,1.58,2,2.32,2.58,2.81,3,3.17,3.32],[null,0,2,3.17,4,4.64,5.17,5.61,6,6.34,6.64]],"container":"<table class=\"display\">\n <thead>\n <tr>\n <th> <\/th>\n <th>x<\/th>\n <th>y<\/th>\n <th>x_log<\/th>\n <th>y_log<\/th>\n <\/tr>\n <\/thead>\n<\/table>","options":{"pageLength":7,"columnDefs":[{"className":"dt-right","targets":[1,2,3,4]},{"orderable":false,"targets":0}],"order":[],"autoWidth":false,"orderClasses":false,"lengthMenu":[7,10,25,50,100]}},"evals":[],"jsHooks":[]}</script> --- # Wie interpretiert man eine LogY-LogX-Regression? 💡 "Für je 100 % Unterschied in X, beträgt der vorhergesagte Unterschied in Y 200 % (allgemein: `\(k %\)`). [Herleitung einer multiplen LogY-LogX-Regression](https://www.wolframalpha.com/input/?i=log%28x%5E2+*+y%5E2%29) --- # Wann soll ich eine LogY-LogX-Regression verwenden? ## Verwenden Sie die Log-Log-Regression, wenn Sie von einem Potenzgesetz im Zusammenhang ausgehen, z.b. einem quadratischen Zusammenhang Beispiele: - Zusammenhang von Oberfläche und Volumen - Zusammenhang von Anziehungskraft und Nähe von (Himmels-)körpern - Preise von Kunstgegenständen - Umsatz nach Follower-Zahl Ändert sich Y um einen konstanten *Faktor*, wenn sich X um einen konstanten *Faktor* rändert, ist eine Log-Log-Regression sinnvoll. --- # Aber stimmt das alles wirklich? (1/2) Wie ist der Zusammenhang von X und Y in einer LogY-LogX-Regression zu verstehen? `$$\log_b y = a_0 + a_1 \log x$$` Hier sind zwei Punkte `\((x,y)\)` spezifiziert: `$$\log_b y_0 = a_0 + \log_b x_0 \\ \log_b y_1 = a_0 + \log_b y_1$$` Was ist der Wert von `\(log(y_1) - log(y_0)\)`? `$$\begin{aligned}[t] \log_b(y_1) - \log_b(y_0) &= (a_0 + a_1 \log_b x_1) - (a_0 + a_1 \log x_0) ,\\ &= a_1 (\log_b x_1 - \log x_0) , \\ \log_b \left(\frac{y_1}{y_0} \right) &= \log_b \left(\frac{x_1}{x_0} \right)^{a_1} , \\ \frac{y_1}{y_0} &= \left( \frac{x_1}{x_0} \right)^{a_1} . \end{aligned}$$` --- # LogY-LogX1-LogX2-Modell Eine LogY-LogX-Regression macht auch Sinn, um multiplikative Verknüpfungen dieser Art zu modellieren: `$$y=ab \qquad \leftrightarrow \qquad log(y) = log(a) + log(b)$$` Zahlenbeispiel: `$$100 = 10\cdot10 \qquad \leftrightarrow \qquad lg(100) = lg(10) + lg(10)$$` wobei `lg` für den Logarithmus zur Basis 10 steht. Natürlich ist auch `\(y=abc, y = abcd\)` etc. möglich. --- # Aber stimmt das alles wirklich? (2/2) Also: `$$\frac{y_1}{y_0} = \left( \frac{x_1}{x_0} \right)^{a_1}$$` Sei `\(s=y_1/y_0\)` und `\(r=x_1/x0\)`, dann `$$s=r^{a_1}$$` Steigt also `\(x\)` umd den Faktor `\(r\)`, so steigt `\(y\)` um den Faktor `\(r^{a_1}\)`. .footnote[[Quelle](https://jrnold.github.io/r4ds-exercise-solutions/model-building.html#exercise-24.2.2)] --- # Beispiel für ein LogY-LogX1-LogX2-Modell - Der Preis eines Diamanten als Produkt von Gewicht und Schliff - Der Lernerfolg als Produkt von Motivation, Konzentration und Lernzeit - Das Wachstum einer Bakterienkolonie als Produkt von Nährstoffmenge und Zeit - Der Spritverbrauch als Produkt von Gewicht und Motorgröße Es gibt viele Situationen, in denen ein LogY-LogX1-LogX2-Modell helfen kann. --- # `d5`: Einfaches Zahlenbeispiel für eine Potenzfunktion Anstelle von `\(y=x\cdot x\)` haben wir jetzt `\(y=a \cdot b\)`. ```r d5 <- tibble( a = 0:10, b = 0:10, y = a*b, log_y = log(y) %>% round(2), loga_plus_logb = (log(a) + log(b)) %>% round(2) ) ``` --- # So sieht `d5` aus <div id="htmlwidget-c43d8156f7b8f6c12cc6" style="width:100%;height:auto;" class="datatables html-widget"></div> <script type="application/json" data-for="htmlwidget-c43d8156f7b8f6c12cc6">{"x":{"filter":"none","data":[["1","2","3","4","5","6","7","8","9","10","11"],[0,1,2,3,4,5,6,7,8,9,10],[0,1,2,3,4,5,6,7,8,9,10],[0,1,4,9,16,25,36,49,64,81,100],[null,0,1.39,2.2,2.77,3.22,3.58,3.89,4.16,4.39,4.61],[null,0,1.39,2.2,2.77,3.22,3.58,3.89,4.16,4.39,4.61]],"container":"<table class=\"display\">\n <thead>\n <tr>\n <th> <\/th>\n <th>a<\/th>\n <th>b<\/th>\n <th>y<\/th>\n <th>log_y<\/th>\n <th>loga_plus_logb<\/th>\n <\/tr>\n <\/thead>\n<\/table>","options":{"pageLength":7,"columnDefs":[{"className":"dt-right","targets":[1,2,3,4,5]},{"orderable":false,"targets":0}],"order":[],"autoWidth":false,"orderClasses":false,"lengthMenu":[7,10,25,50,100]}},"evals":[],"jsHooks":[]}</script> Y ist Produkt von a und b --- name: fazit class: center, middle, inverse # Fazit --- # tl;dr (Zusammenfassung) - *Normale Regression*: Wenn sich die Effekte der Prädiktoren zu einem Effekt (auf Y) *summieren* - *LogY-Regression*: Wenn sich die Effekte der Prädiktoren zu einem Effekt (auf Y) *multiplizieren* - *LogY-LogX-Regression*: Wenn sich die *multiplikativen* Effekte der Prädiktoren zu einem Effekt (auf Y) *multiplizieren* --- # Literatur [Regression and Other Stories: Andrew Gelman, Jennifer Hill, Aki Vehtari](https://avehtari.github.io/ROS-Examples/) --- # SessionInfo .small[ - Date: 2021-06-10 - Slides built with `xaringan`, based on `rmarkdown` - Packages: assertthat 0.2.1, backports 1.2.1, broom 0.7.6, bslib 0.2.5.1, cellranger 1.1.0, cli 2.5.0, colorspace 2.0-1, crayon 1.4.1, crosstalk 1.1.1, DBI 1.1.1, dbplyr 2.1.1, digest 0.6.27, dplyr 1.0.6, DT 0.18, ellipsis 0.3.2, evaluate 0.14, fansi 0.5.0, farver 2.1.0, forcats 0.5.1, fs 1.5.0, generics 0.1.0, ggdendro 0.1.22, ggforce 0.3.3, ggformula 0.10.1, ggplot2 3.3.3, ggrepel 0.9.1, ggridges 0.5.3, ggstance 0.3.5, glue 1.4.2, gridExtra 2.3, gtable 0.3.0, haven 2.4.1, hms 1.1.0, htmltools 0.5.1.1, htmlwidgets 1.5.3, httr 1.4.2, jquerylib 0.1.4, jsonlite 1.7.2, knitr 1.33, labeling 0.4.2, labelled 2.8.0, lattice 0.20-44, leaflet 2.0.4.1, lifecycle 1.0.0, lubridate 1.7.10, magrittr 2.0.1, MASS 7.3-54, Matrix 1.3-4, mgcv 1.8-35, modelr 0.1.8, mosaic 1.8.3, mosaicCore 0.9.0, mosaicData 0.20.2, munsell 0.5.0, nlme 3.1-152, pillar 1.6.1, pkgconfig 2.0.3, plyr 1.8.6, polyclip 1.10-0, purrr 0.3.4, R6 2.5.0, Rcpp 1.0.6, readr 1.4.0, readxl 1.3.1, reprex 2.0.0, rlang 0.4.11, rmarkdown 2.8, rstudioapi 0.13, rvest 1.0.0, sass 0.4.0, scales 1.1.1, sessioninfo 1.1.1, stringi 1.6.2, stringr 1.4.0, tibble 3.1.2, tidyr 1.1.3, tidyselect 1.1.1, tidyverse 1.3.1, tweenr 1.0.2, utf8 1.2.1, vctrs 0.3.8, withr 2.4.2, xaringan 0.21, xaringanExtra 0.4.3, xfun 0.23, xml2 1.3.2, yaml 2.2.1 - For detailed `session_info()` check out this [text file](https://data-se.netlify.com/slides/papers-publizieren/session_info.txt). - Thanks for and to all open source developers. ]